AI工程学院:3Fine-tuning(大语言模型微调)

📚 资料库结构

| 模型/目录 | 描述与内容 |

|---|---|

| Axolotl | 用于微调语言模型的框架 |

| Gemma | Google 最新的大语言模型实现 |

- finetune-gemma.ipynb - gemma-sft.py - Gemma_finetuning_notebook.ipynb | 微调笔记本和脚本 |

| LLama2 | Meta 的开源大语言模型 |

- generate_response_stream.py - Llama2_finetuning_notebook.ipynb - Llama_2_Fine_Tuning_using_QLora.ipynb | 实现和微调指南 |

| Llama3 | 即将推出的 Meta 大语言模型实验 |

- Llama3_finetuning_notebook.ipynb | 初始微调实验 |

| LlamaFactory | 大语言模型的训练和部署框架 |

| LLMArchitecture/ParameterCount | 模型架构的技术细节 |

| Mistral-7b | Mistral AI 的 70 亿参数模型 |

- LLM_evaluation_harness_for_Arc_Easy_and_SST.ipynb - Mistral_Colab_Finetune_ipynb_Colab_Final.ipynb - notebooks_chatml_inference.ipynb - notebooks_DPO_fine_tuning.ipynb - notebooks_SFTTrainer TRL.ipynb - SFT.py | 用于评估、微调和推理的综合笔记本 |

| Mixtral | Mixtral 的专家混合模型 |

- Mixtral_fine_tuning.ipynb | 微调实现 |

| VLM | 视觉语言模型 |

- Florence2_finetuning_notebook.ipynb - PaliGemma_finetuning_notebook.ipynb | 视觉语言模型的实现 |

🎯 模块概览

1. LLM 架构

- 探索以下模型的实现:

- Llama2(Meta 的开源模型)

- Mistral-7b(高效的 70 亿参数模型)

- Mixtral(专家混合架构)

- Gemma(Google 的最新贡献)

- Llama3(即将推出的实验)

2. 🛠️ 微调技术

- 实现策略

- LoRA(低秩适配)方法

- 高级优化方法

3. 🏗️ 模型架构分析

- 模型结构的深入研究

- 参数计算方法

- 扩展性考虑

4. 🔧 专业实现

- Code Llama 用于编程任务

- 视觉语言模型:

- Florence2

- PaliGemma

5. 💻 实践应用

- 综合 Jupyter 笔记本

- 响应生成流水线

- 推理实现指南

6. 🚀 高级主题

- DPO(直接偏好优化)

- SFT(监督微调)

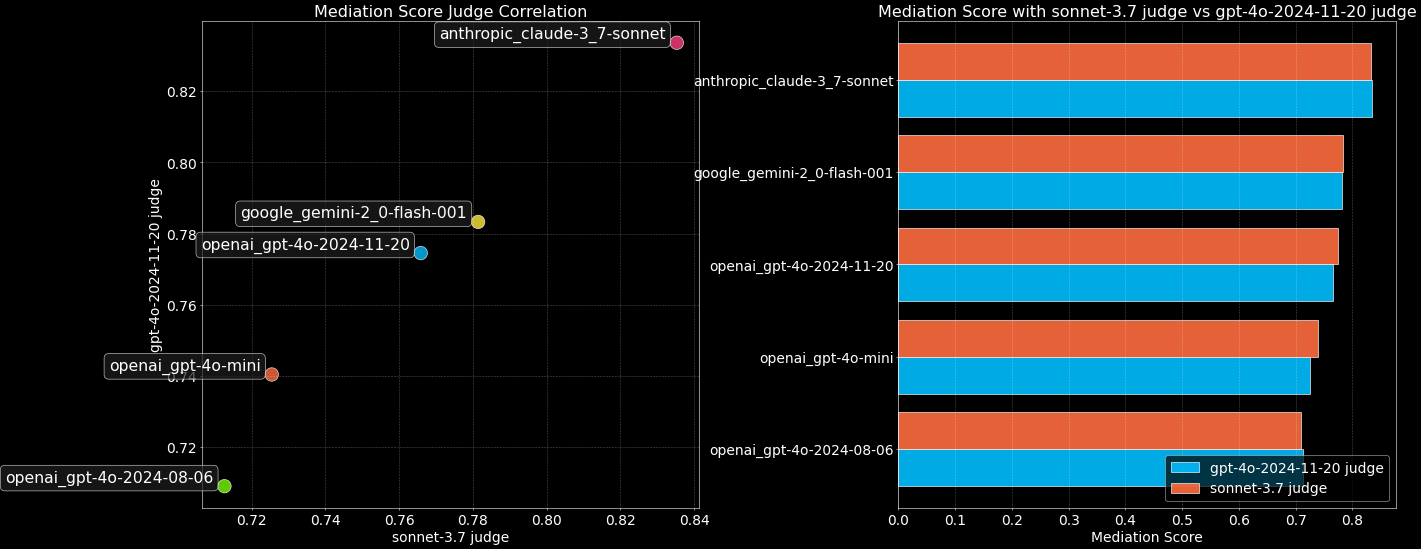

- 评估方法论

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...