Debatte über die Speicherleistung von KI-Intelligenz: Zep Mem0-Benchmarks in Zweifel gezogen

Eine jüngste Ankündigung im Bereich des intelligenten Körperspeichers hat in der Branche großes Interesse geweckt.Mem0 Company veröffentlicht Forschungsberichte,宣称其产品在 AI 智能体记忆技术方面达到了行业领先(SOTA)水平,并在特定基准测试中超越了包括 Zep 在内的竞争对手。然而,这一说法迅速遭到了 Zep 团队的质疑。Zep 指出,在正确实施的情况下,其产品在 Mem0 选用的 LoCoMo 基准测试中,性能实际上要高出 Mem0 大约 24%。这一显著差异,促使人们对基准测试的公正性、实验设计的严谨性以及最终结论的可靠性进行更深入的探究。

In der hart umkämpften Arena der künstlichen Intelligenz bedeutet die Auszeichnung mit dem SOTA-Siegel (State-of-the-Art) für jedes Unternehmen sehr viel. Sie bedeutet nicht nur technologische Führerschaft, sondern zieht auch Investitionen, Talente und Marktaufmerksamkeit an. Daher sollte jede Aussage über SOTA, insbesondere Schlussfolgerungen, die durch Benchmarking erreicht werden, hinterfragt werden.

Zep-Behauptung: LoCoMo-Testergebnisse werden bei korrekter Umsetzung umgekehrt

In seiner Antwort wies das Zep-Team darauf hin, dass die Ergebnisse des LoCoMo-Experiments, wenn es gemäß den bewährten Verfahren des Zep-Produkts konfiguriert wurde, ganz anders ausfielen als im Mem0-Bericht.

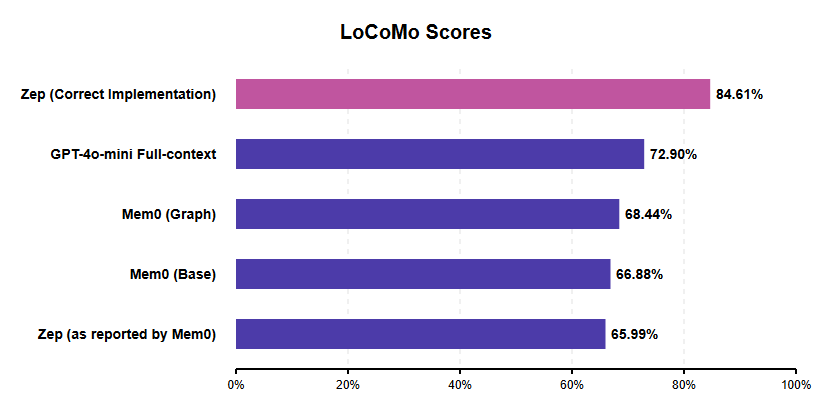

Alle Noten stammen aus Mem0-Berichten, mit Ausnahme von "Zep (Correct)", das hier besprochen wird.

Laut der von Zep veröffentlichten Bewertung erreicht das Produkt J-score 84.61%Im Vergleich zur optimalen Mem0-Konfiguration (Mem0-Diagramm) von etwa 68,41 TP3T erreicht sie etwa 23.6% der relativen Leistungssteigerung. Dies steht im Gegensatz zu Zeps Ergebnis von 65,99%, das im Mem0-Papier angegeben ist, und von dem Zep annimmt, dass es wahrscheinlich das direkte Ergebnis eines Implementierungsfehlers ist, wie weiter unten erläutert wird.

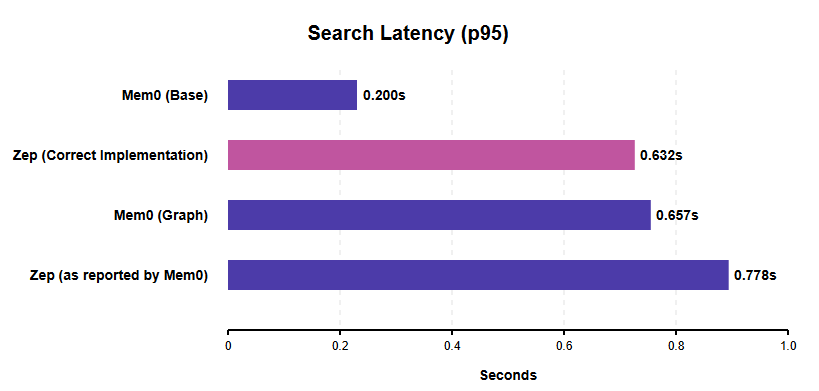

In Bezug auf die **Suchlatenz (p95-Suchlatenz)** stellt Zep fest, dass die p95-Suchlatenz bei ordnungsgemäßer Konfiguration seines Systems für gleichzeitige Suchen bei 0,632 Sekunden. Dies ist besser als die 0,778 Sekunden von Zep im Mem0-Bericht (die laut Zep durch die sequenzielle Suchimplementierung aufgebläht sind) und etwas schneller als die Graph-Suchlatenz von Mem0 (0,657 Sekunden).

Alle Noten stammen aus Mem0-Berichten, mit Ausnahme von "Zep (Correct)", das hier besprochen wird.

Es ist erwähnenswert, dass die Basiskonfiguration von Mem0 (Mem0 Base) eine geringere Suchlatenz aufweist (0,200 Sekunden). Dies ist jedoch kein völlig gleichwertiger Vergleich, da Mem0 Base einen einfacheren Vektorspeicher/Cache verwendet, der nicht über die relationalen Fähigkeiten einer Graphdatenbank verfügt, und außerdem die niedrigste Genauigkeitsbewertung der Mem0-Varianten aufweist. Die effizienten gleichzeitigen Suchvorgänge von Zep zeigen eine starke Leistung für produktionsreife KI-Intelligenzen, die komplexere Speicherstrukturen benötigen und auf Reaktionsfähigkeit angewiesen sind, und Zep erklärt, dass seine Latenzdaten in einer AWS us-west-2-Umgebung mit einer NAT-Einrichtung für die Übertragung gemessen wurden.

Einschränkungen des LoCoMo-Benchmarking werfen Fragen auf

Die Entscheidung von Mem0, LoCoMo als Benchmark für seine Forschung zu wählen, wurde von Zep selbst unter die Lupe genommen, das eine Reihe grundlegender Mängel des Benchmarks sowohl auf der Entwurfs- als auch auf der Ausführungsebene feststellte. Die Entwicklung und Durchführung eines umfassenden und unvoreingenommenen Benchmarks ist an sich schon eine schwierige Aufgabe, die tiefgreifendes Fachwissen, angemessene Ressourcen und ein gründliches Verständnis der internen Mechanismen des zu testenden Systems erfordert.

Zu den vom Zep-Team identifizierten Hauptproblemen von LoCoMo gehören:

- Unzureichende Länge und Komplexität der Dialoge:LoCoMo 中的对话平均长度在 16,000 到 26,000 Wertmarken 之间。虽然这看起来很长,但对于现代 LLM 而言,这通常在其上下文窗口能力范围之内。这种长度未能真正对长期记忆检索能力构成压力。一个有力的证据是,Mem0 自己的结果显示,其系统的表现甚至不如一个简单的“全上下文基线”(即将整个对话内容直接输入 LLM)。全上下文基线的 J 分数约为 73%,而 Mem0 的最佳分数约为 68%。如果简单提供所有文本就能获得比专业记忆系统更好的结果,那么该基准测试就未能充分考察真实世界 AI 智能体交互中对记忆能力的严苛要求。

- Versäumnis, kritische Speicherfunktionen zu testenDem Benchmark fehlt das Problem der "Wissensaktualisierung", das er eigentlich testen sollte. Die Aktualisierung des Speichers, wenn sich Informationen im Laufe der Zeit ändern (z. B. wenn ein Benutzer den Arbeitsplatz wechselt), ist ein entscheidendes Merkmal für den KI-Speicher.

- Probleme mit der DatenqualitätDer Datensatz selbst leidet unter mehreren Qualitätsmängeln:

- Kategorie der NichtverfügbarkeitKategorie 5 konnte wegen des Fehlens einer standardisierten Antwort nicht verwendet werden, was sowohl Mem0 als auch Zep dazu zwang, diese Kategorie von ihren Bewertungen auszuschließen.

- multimodaler FehlerEinige der Fragen bezogen sich auf die Bilder, aber die erforderlichen Informationen waren nicht in den Bildbeschreibungen enthalten, die vom BLIP-Modell während des Erstellungsprozesses des Datensatzes generiert wurden.

- Falsche Zuweisung von SprechernEinige Fragen ordnen Verhaltensweisen oder Aussagen fälschlicherweise dem falschen Sprecher zu.

- Unklarheit bei der Definition des ProblemsEinige Fragen sind mehrdeutig und können mehr als eine potenziell richtige Antwort enthalten (z. B. die Frage, wann jemand zelten geht, obwohl die Person sowohl im Juli als auch im August dort gewesen sein kann).

Angesichts dieser Fehler und Ungereimtheiten ist die Zuverlässigkeit von LoCoMo als maßgebliches Maß für die Gedächtnisleistung von KI-Intelligenzen fraglich. Leider ist LoCoMo kein Einzelfall. Andere Benchmarks, wie z. B. HotPotQA, wurden kritisiert, weil sie LLM-Trainingsdaten (z. B. Wikipedia) verwenden, Fragen zu stark vereinfachen und sachliche Fehler enthalten. Dies unterstreicht die anhaltende Herausforderung, ein solides Benchmarking in der KI durchzuführen.

Mem0 Kritik an der Bewertungsmethodik von Zep

Abgesehen von der Kontroverse um den LoCoMo-Benchmark selbst basiert der Vergleich von Zep im Mem0-Papier nach Angaben von Zep auf einer fehlerhaften Implementierung und spiegelt daher die wahren Fähigkeiten von Zep nicht korrekt wider:

- Falsches BenutzermodellMem0 verwendet eine Benutzer-Graph-Struktur, die für eine einzelne Benutzer-Helfer-Interaktion konzipiert ist, weist aber den Dialogpartnern Benutzerrollen zu.beide beteiligten ParteienTeilnehmer. Dies wird wahrscheinlich die interne Logik von Zep verwirren und dazu führen, dass es den Dialog als einen einzelnen Benutzer ansieht, der ständig die Identität zwischen den Nachrichten wechselt.

- Ungeeignete Behandlung von ZeitstempelnZeitstempel werden durch Anhängen an das Ende der Nachricht übergeben, anstatt das Zep-spezifische created_at-Feld zu verwenden. Dieser nicht standardisierte Ansatz beeinträchtigt die Zeitermittlungsfunktionen von Zep.

- Sequentielle vs. parallele SucheDer Suchvorgang wird sequentiell und nicht parallel ausgeführt, was die von Mem0 gemeldete Suchlatenz von Zep künstlich erhöht.

Zep argumentiert, dass diese Implementierungsfehler die Funktionsweise von Zep grundlegend falsch interpretiert haben und unweigerlich zu der schlechten Leistung geführt haben, über die im Mem0-Papier berichtet wird.

Die Branche fordert bessere Benchmarks: Warum Zep LongMemEval bevorzugt

Die durch LoCoMo ausgelöste Kontroverse hat den Bedarf der Branche an solideren und relevanteren Benchmarks verstärkt, und das Zep-Team hat sich für Benchmarks wie den LongMemEval Ein solches Bewertungskriterium, das die Mängel von LoCoMo in mehrfacher Hinsicht ausgleicht:

- Länge und Herausforderung: enthält wesentlich längere Dialoge (im Durchschnitt 115k Token), die die kontextuellen Grenzen wirklich testen.

- Zeitliches Reasoning und ZustandsänderungExplizite Prüfung des Zeitverständnisses und der Fähigkeit, mit veränderten Informationen umzugehen (Wissensaktualisierung).

- Masse (in der Physik)Planen und Gestalten von Hand mit dem Ziel, eine hohe Qualität zu gewährleisten.

- Unternehmensrelevanz: Repräsentativer für die Komplexität und die Anforderungen von realen Unternehmensanwendungen.

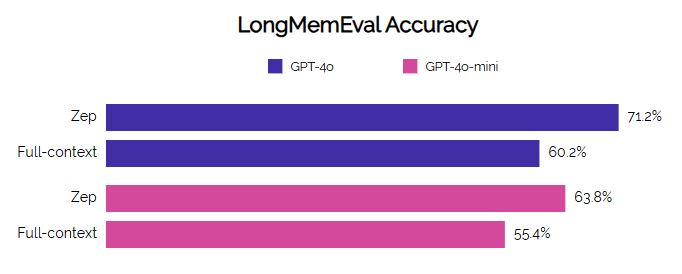

Zep hat Berichten zufolge eine starke Leistung bei LongMemEval gezeigt und sowohl die Genauigkeit als auch die Latenzzeit im Vergleich zur Baseline deutlich verbessert, insbesondere bei komplexen Aufgaben wie der Multisession-Synthese und der zeitlichen Inferenz.

Benchmarking ist eine komplexe Aufgabe, und die Bewertung von Konkurrenzprodukten erfordert noch mehr Sorgfalt und Fachwissen, um sicherzustellen, dass die Vergleiche fair und genau sind. Aus der von Zep vorgelegten detaillierten Gegendarstellung geht hervor, dass die von Mem0 behauptete SOTA-Leistung auf einem fehlerhaften Benchmark (LoCoMo) und einer fehlerhaften Implementierung des Systems eines Wettbewerbers (Zep) beruht.

Bei korrekter Bewertung mit demselben Benchmark übertrifft Zep Mem0 deutlich in Bezug auf die Genauigkeit und zeigt eine hohe Wettbewerbsfähigkeit in Bezug auf die Suchlatenz, insbesondere beim Vergleich graphbasierter Implementierungen. Dieser Unterschied unterstreicht die entscheidende Bedeutung eines strengen Versuchsplans und eines tiefen Verständnisses des zu bewertenden Systems, um glaubwürdige Schlussfolgerungen ziehen zu können.

Für die Zukunft braucht die KI-Branche dringend bessere und repräsentativere Benchmarks. Branchenbeobachter fordern die Mem0-Teams auf, ihre Produkte anhand anspruchsvollerer und relevanterer Benchmarks wie LongMemEval zu bewerten, wo Zep seine Ergebnisse bereits veröffentlicht hat, um aussagekräftigere Vergleiche der Langzeitspeicherfähigkeiten von KI-Intelligenzen anstellen zu können. Es geht nicht nur um den Ruf einzelner Produkte, sondern um die richtige Richtung des technologischen Fortschritts für die gesamte Branche.

Referenz:ZEP: Eine temporale Wissensgraphenarchitektur für ein intelligentes Körpergedächtnis

© urheberrechtliche Erklärung

Der Artikel ist urheberrechtlich geschützt und darf nicht ohne Genehmigung vervielfältigt werden.

Ähnliche Artikel

Keine Kommentare...