Geräteübergreifendes generatives KI-Multimodal-Benchmarking auf der Endgeräteseite mit Nexa Compressed Inference

Zusammenfassung

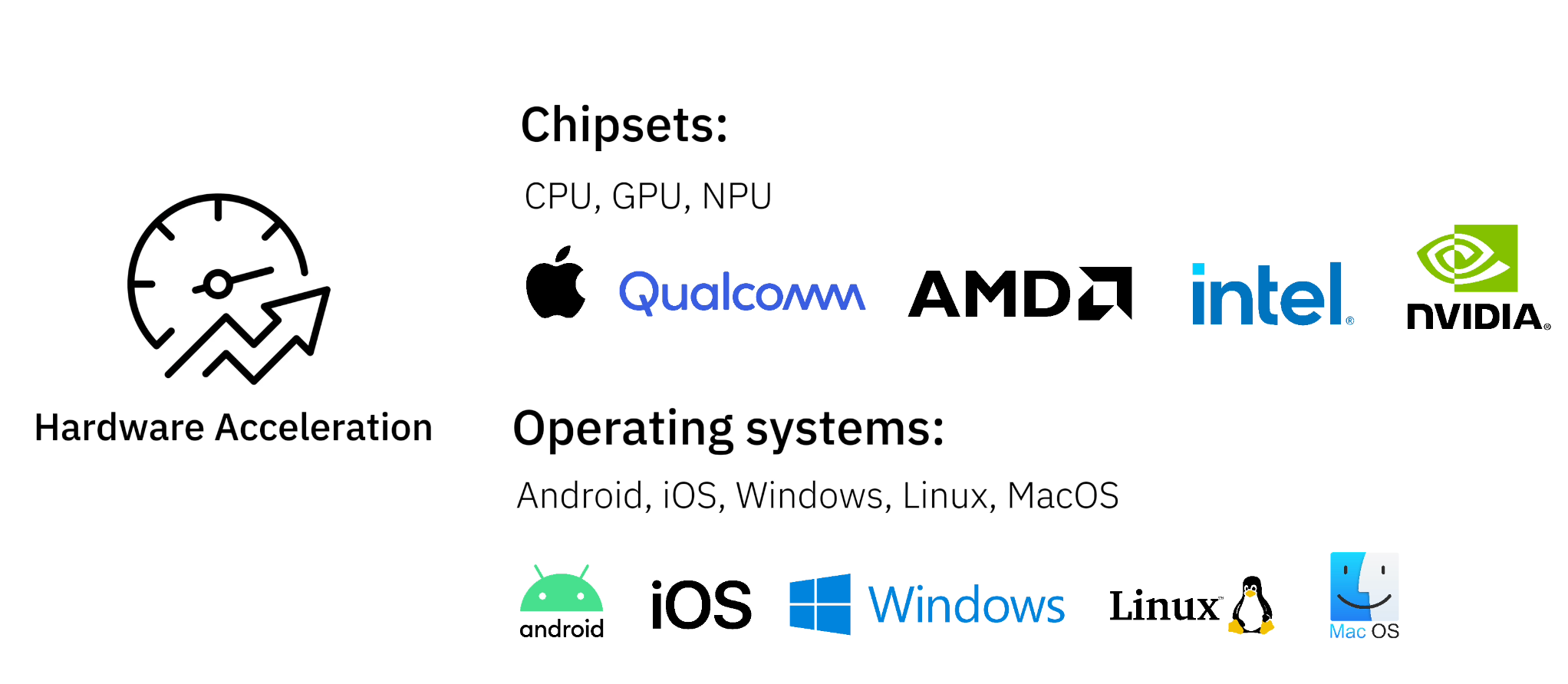

Nexa Das Native Inference Framework macht die Bereitstellung generativer KI-Modelle auf der Geräteseite nahtlos und effizient. Die Technologie unterstützt eine breite Palette von Chipsätzen, darunter AMD, Qualcomm, Intel, NVIDIA und selbst entwickelte Chips, und ist mit allen wichtigen Betriebssystemen kompatibel. Wir stellen Benchmark-Daten für generative KI-Modelle für eine Vielzahl gängiger Aufgaben zur Verfügung, die jeweils auf TOPS-Leistungsebene auf verschiedenen Gerätetypen getestet wurden.

Zentrale Stärken:

- multimodale Fähigkeit - RückendeckungText, Audio, Video und BildmaterialGenerative KI-ähnliche Aufgaben

- Große Bandbreite an Hardware-Kompatibilität - Ausführen von KI-Modellen auf PCs, Laptops, mobilen Geräten und eingebetteten Systemen

- führende Leistung - Mit unserem Edge Inference Framework NexaQuant laufen die Modelle 2,5 Mal schneller und haben einen 4 Mal geringeren Speicherbedarf bei gleichbleibend hoher Genauigkeit.

Warum KI auf der Endseite?

Die Bereitstellung von KI-Modellen direkt auf dem Gerät hat mehrere Vorteile gegenüber der Nutzung von Cloud-APIs:

- Datenschutz und Sicherheit - Datenspeicherung auf der Geräteseite gewährleistet Vertraulichkeit

- Kosten senken - Keine Notwendigkeit, für teure Cloud-basierte Lösungen zu bezahlen

- Geschwindigkeit und Reaktion - Schlussfolgerungen mit geringer Latenz, ohne sich auf das Netz zu verlassen

- Offlinefähigkeit - KI-Anwendungen können auch in Gebieten mit geringer Konnektivität genutzt werden

Mit der Nexa Edge Inference Technologie können Entwickler generative KI-Modelle auf einer Vielzahl von Geräten mit minimalem Ressourcenverbrauch effizient ausführen.

Neue Trends bei multimodalen KI-Anwendungen

Nexa AI Unterstützung der Bereitstellung auf der EndseiteMultimodale KIund ermöglicht es Anwendungen, mehrere Datentypen zu verarbeiten und zu integrieren:

- Text AI - Chatbots, Dokumentenzusammenfassungen, Programmierassistenten

- Sprache zu Sprache AI - Sprachübersetzung in Echtzeit, AI-Sprachassistent

- Vision AI - Zielerkennung, Bildbeschreibung, OCR-Verarbeitung von Dokumenten

Dies wird erreicht durch den Einsatz vonNexaQuantUnsere multimodalen Modelle erreichen eine hervorragende Komprimierung und Beschleunigung bei gleichzeitig hoher Leistung.

Geräteübergreifende Leistungsvergleiche für generative KI-Aufgaben

Wir stellen Benchmarking-Daten für generative KI-Modelle für eine Vielzahl gängiger Aufgaben zur Verfügung, die jeweils auf der TOPS-Leistungsebene auf verschiedenen Gerätetypen getestet wurden. Wenn Sie ein bestimmtes Gerät und einen bestimmten Anwendungsfall haben, können Sie sich auf Geräte mit ähnlicher Leistung beziehen, um die Verarbeitungsleistung abzuschätzen:

Generative KI-Aufgaben abgedeckt:

- Von Stimme zu Stimme

- Text zu Text

- Bild zu Text

Deckt die Art der Ausrüstung ab:

- Moderne Notebook-Chips - Optimiert für native KI-Verarbeitung auf Desktop und Laptop

- Flaggschiff-Mobilfunkchip - KI-Modelle, die auf Smartphones und Tablets laufen

- eingebettetes System (~4 TOPS) - Stromsparende Geräte für Edge-Computing-Anwendungen

Sprache-zu-Sprache-Benchmarking

Evaluierung von Echtzeit-Sprachinteraktionsfähigkeiten mit Sprachmodellen - VerarbeitungAudioeingang erzeugt Audioausgang

| Art der Ausrüstung | Chips & Geräte | Verzögerung (TTFT) | Dekodiergeschwindigkeit | Durchschnittlicher Spitzenspeicher |

|---|---|---|---|---|

| Moderne Notebook-Chips (GPU) | Apple M3 Pro GPU | 0,67 Sekunden | 20,46 Token/Sekunde | ~990MB |

| Moderne Notebook-Chips (iGPU) | AMD Ryzen AI 9 HX 370 iGPU (Radeon 890M) | 1,01 Sekunden | 19,28 Token/Sekunde | ~990MB |

| Moderne Notebook-Chips (CPU) | Intel Core Ultra 7 268V | 1,89 Sekunden | 11,88 Token/Sekunde | ~990MB |

| Flaggschiff-CPU für Mobilgeräte | Qualcomm Snapdragon 8 Gen 3 (Samsung S24) | 1,45 Sekunden | 9,13 Token/Sekunde | ~990MB |

| Eingebettetes IoT-System CPU | Raspberry Pi 4 Modell B | 6,9 Sekunden. | 4,5 Token/Sekunde | ~990MB |

Sprache-zu-Sprache-Benchmarking mit Moshi und NexaQuant

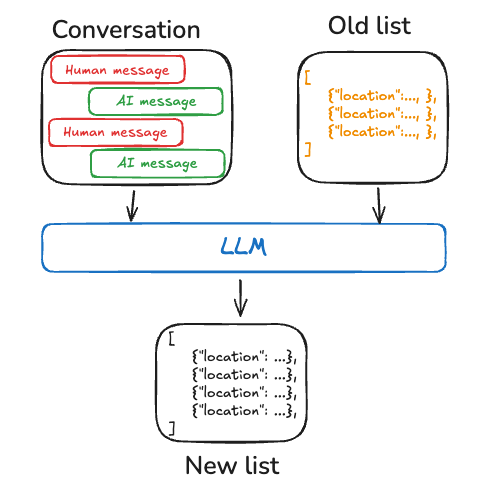

Text-zu-Text-Benchmarking

BewertungErzeugen von Text auf der Grundlage von TexteingabenLeistung des AI-Modells

| Art der Ausrüstung | Chips & Geräte | Anfängliche Verzögerung (TTFT) | Dekodiergeschwindigkeit | Durchschnittlicher Spitzenspeicher |

|---|---|---|---|---|

| Moderne Notebook-Chips (GPU) | Apple M3 Pro GPU | 0,12 Sekunden | 49,01 Token/Sekunde | ~2580MB |

| Moderne Notebook-Chips (iGPU) | AMD Ryzen AI 9 HX 370 iGPU (Radeon 890M) | 0,19 Sekunden | 30,54 Token/Sekunde | ~2580MB |

| Moderne Notebook-Chips (CPU) | Intel Core Ultra 7 268V | 0,63 Sekunden | 14,35 Token/Sekunde | ~2580MB |

| Flaggschiff-CPU für Mobilgeräte | Qualcomm Snapdragon 8 Gen 3 (Samsung S24) | 0,27 Sekunden | 10,89 Token/Sekunde | ~2580MB |

| Eingebettetes IoT-System CPU | Raspberry Pi 4 Modell B | 1,27 Sekunden | 5,31 Token/Sekunde | ~2580MB |

Text-zu-Text-Benchmarking mit Lama-3.2 und NexaQuant

Benchmarking von Bild zu Text

Bewertung von AI Visuelle Eingaben analysierenDie Fähigkeit, Antworten zu generieren, wichtige visuelle Informationen zu extrahieren und dynamische Führungsinstrumente -Visuelle Eingabe, Textausgabe

| Art der Ausrüstung | Chips & Geräte | Anfängliche Verzögerung (TTFT) | Dekodiergeschwindigkeit | Durchschnittlicher Spitzenspeicher |

|---|---|---|---|---|

| Moderne Notebook-Chips (GPU) | Apple M3 Pro GPU | 2,62 Sekunden | 86,77 Token/Sekunde | ~1093MB |

| Moderne Notebook-Chips (iGPU) | AMD Ryzen AI 9 HX 370 iGPU (Radeon 890M) | 2,14 Sekunden | 83,41 Token/Sekunde | ~1093MB |

| Moderne Notebook-Chips (CPU) | Intel Core Ultra 7 268V | 9,43 Sekunden | 45,65 Token/Sekunde | ~1093MB |

| Flaggschiff-CPU für Mobilgeräte | Qualcomm Snapdragon 8 Gen 3 (Samsung S24) | 7,26 Sekunden. | 27,66 Token/Sekunde | ~1093MB |

| Eingebettetes IoT-System CPU | Raspberry Pi 4 Modell B | 22,32 Sekunden | 6,15 Token/Sekunde | ~1093MB |

Bild-Text-Benchmarking mit OmniVLM und NexaQuant

© urheberrechtliche Erklärung

Der Artikel ist urheberrechtlich geschützt und darf nicht ohne Genehmigung vervielfältigt werden.

Ähnliche Artikel

Keine Kommentare...