Ollama Installation und Konfiguration - Docker-Artikel

kurz

In diesem Abschnitt erfahren Sie, wie Sie die Docker Ollama Die Installation und Konfiguration des

Docker ist eine virtualisierte Containertechnologie, die auf Images basiert und verschiedene Container in Sekundenschnelle starten kann. Jeder dieser Container ist eine vollständige Laufzeitumgebung, die eine Isolierung zwischen den Containern ermöglicht.

Ollama Herunterladen: https://ollama.com/download

Die offizielle Homepage von Ollama: https://ollama.com

Ollama offizielles GitHub Quellcode-Repository: https://github.com/ollama/ollama/

Offizielle Anleitung zur Installation von Docker: https://hub.docker.com/r/ollama/ollama

I. Ziehen des Ollama-Spiegels

Der Autor hat Docker vorher auf Windows heruntergeladen 👉.docker installation download offizielle website

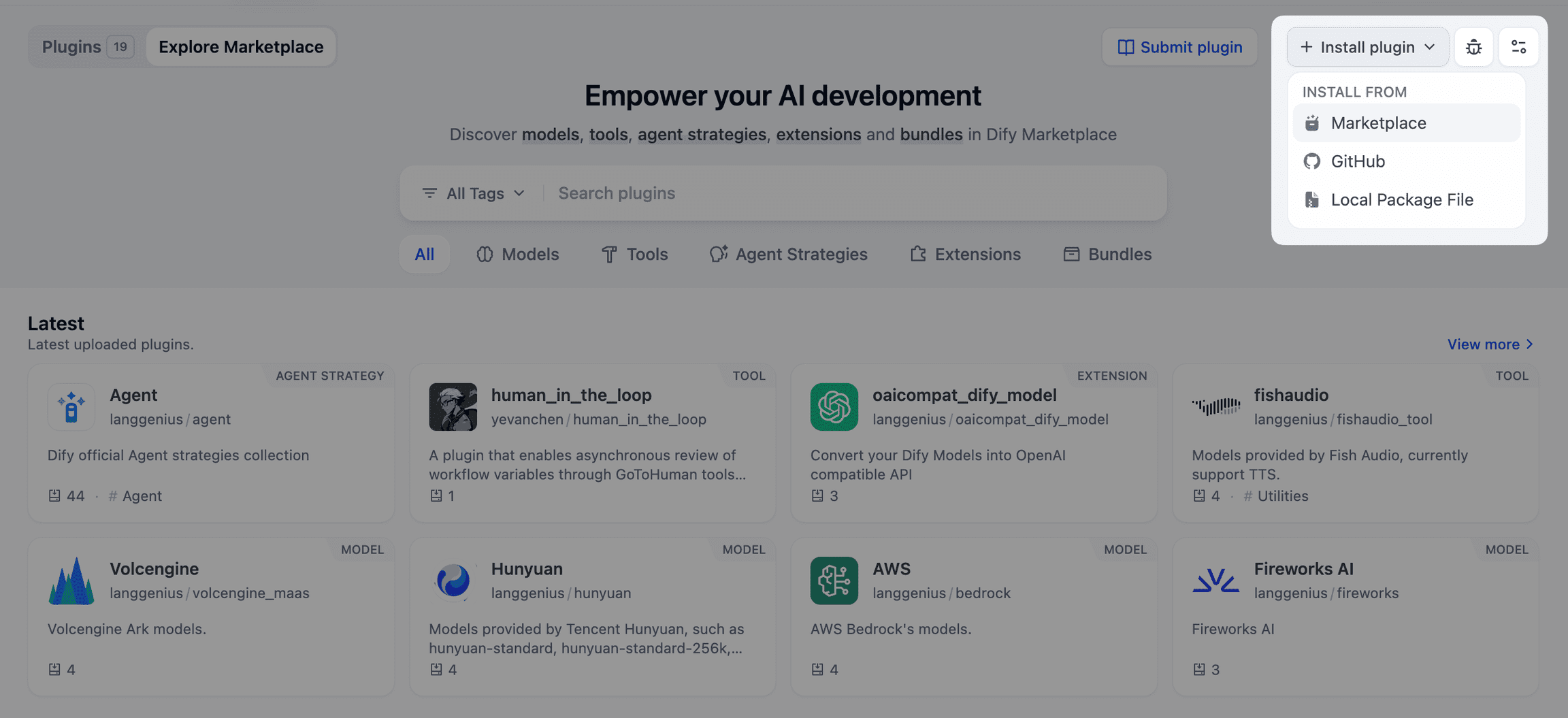

Weg 1: Suche und Download von Docker-Software in der Visualisierungsoberfläche

Weg 2: Die offizielle Website empfiehlt die direkte Verwendung des folgenden Befehls, um das Download-Image zu ziehen, dieses Projekt kann nur auf der CPU ausgeführt werden.

# CPU 或者 Nvidia GPU

docker pull ollama/ollama

# AMD GPU

docker pull ollama/ollama:rocm

Hinweis: Wenn der Leser eine bestimmte Version des Abbilds verwenden möchte, die die Laufzeitumgebung angibt, kann der folgende Befehl verwendet werden.

# CPU 或 Nvidia GPU下载ollama 0.3.0

docker pull ollama/ollama:0.3.0

# AMD GPU下载ollama 0.3.0

docker pull ollama/ollama:0.3.0-rocm

II. Ausführen des Ollama-Images

Weg 1: Docker führt das Image über eine visuelle Schnittstelle aus

- Sobald der Download abgeschlossen ist, finden Sie ihn im Bereich

Imagesden Nagel auf den Kopf treffenOllamaSpiegeln, klickenrunBeachten Sie, dass Sie vor der Ausführung eine Portnummer (z. B. 8089) im Popup-Fenster mit den optionalen Einstellungen auswählen.

- existieren

ContainersFinden Sie den Spiegel in derOLLMZugang zur Ollama-Schnittstelle

- Überprüfen Sie, ob die Installation abgeschlossen ist, im

ExecEingabe unter:

ollama -h

Die Ausgabe sieht wie folgt aus: Das bedeutet, dass die Installation erfolgreich ist🎉.

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

- Terminal Verwendung Ollama.

Die folgenden Befehle werden von Ollama häufig verwendet:

ollama serve #启动ollama

ollama create #从模型文件创建模型

ollama show #显示模型信息

ollama run #运行模型

ollama pull #从注册表中拉取模型

ollama push #将模型推送到注册表

ollama list #列出模型

ollama cp #复制模型

ollama rm #删除模型

ollama help #获取有关任何命令的帮助信息

Bibliothek (ollama.com) Hier ist die Modellbibliothek von Ollama, suchen Sie das gewünschte Modell und starten Sie es direkt!

ollama run llama3

Die Download-Geschwindigkeit hängt von Ihrer Bandbreite ab und ist einsatzbereit ✌Denken Sie daran, die

control + DChat beenden

Weg 2: Start über die Befehlszeile

- CPU-Version:

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama© urheberrechtliche Erklärung

Der Artikel ist urheberrechtlich geschützt und darf nicht ohne Genehmigung vervielfältigt werden.

Ähnliche Artikel

Keine Kommentare...