Was sind die Mindestanforderungen an die Hardware, wenn das Deepseek-Modell lokal eingesetzt wird?

Analyse der Hardwareanforderungen für den lokalen Einsatz von DeepSeek-Modellen

- Analyse der Hardware-Kernelemente

Die Hardware-Anforderungen für den Einsatz von Modellen hängen von drei wesentlichen Aspekten ab:

- ParameterebeneDer Speicherbedarf für verschiedene Modelle wie 7B/67B ist sehr unterschiedlich, wobei die größten DeepSeek R1 671B Tutorial zum lokalen Einsatz: Basierend auf Ollama und dynamischer Quantisierung

- Inferenz-ModusFP16/INT8-Quantisierung reduziert den Platzbedarf für den Grafikspeicher 40-60%

- VerwendungsszenarienUnterschied im Ressourcenverbrauch zwischen Conversational und Batch Reasoning kann 5-10x betragen

2. typisches Konfigurationsbeispiel (in Bezug auf die FP16-Genauigkeit)

Für diejenigen, die FP16 nicht verstehen, können lesen:Was ist Modellquantisierung: Erklärung der Datentypen FP32, FP16, INT8, INT4So gibt es z. B. relativ viele optimierte Versionen:Benötigt nur 14GB RAM, um DeepSeek-Coder V3/R1 (Q4_K_M quantisiert) lokal auszuführen.

| Modellgröße | Mindestanforderungen an den Videospeicher | Empfohlene Grafikkarten | CPU-Alternative |

|---|---|---|---|

| 7B | 14GB | RTX3090 | 64GB DDR4 + AVX512 Befehlssatz |

| 20B | 40GB | A100-40G | Es werden verteilte Rahmenwerke für Schlussfolgerungen benötigt |

| 67B | 134GB | 8 x A100 | Reine CPU-Lösungen werden nicht empfohlen |

💡 Berechnungsformel für den Anzeigespeicher: Anzahl der Parameter × 2 Byte (FP16) × 1,2 (Sicherheitsfaktor)

3. wichtige Optimierungstechniken

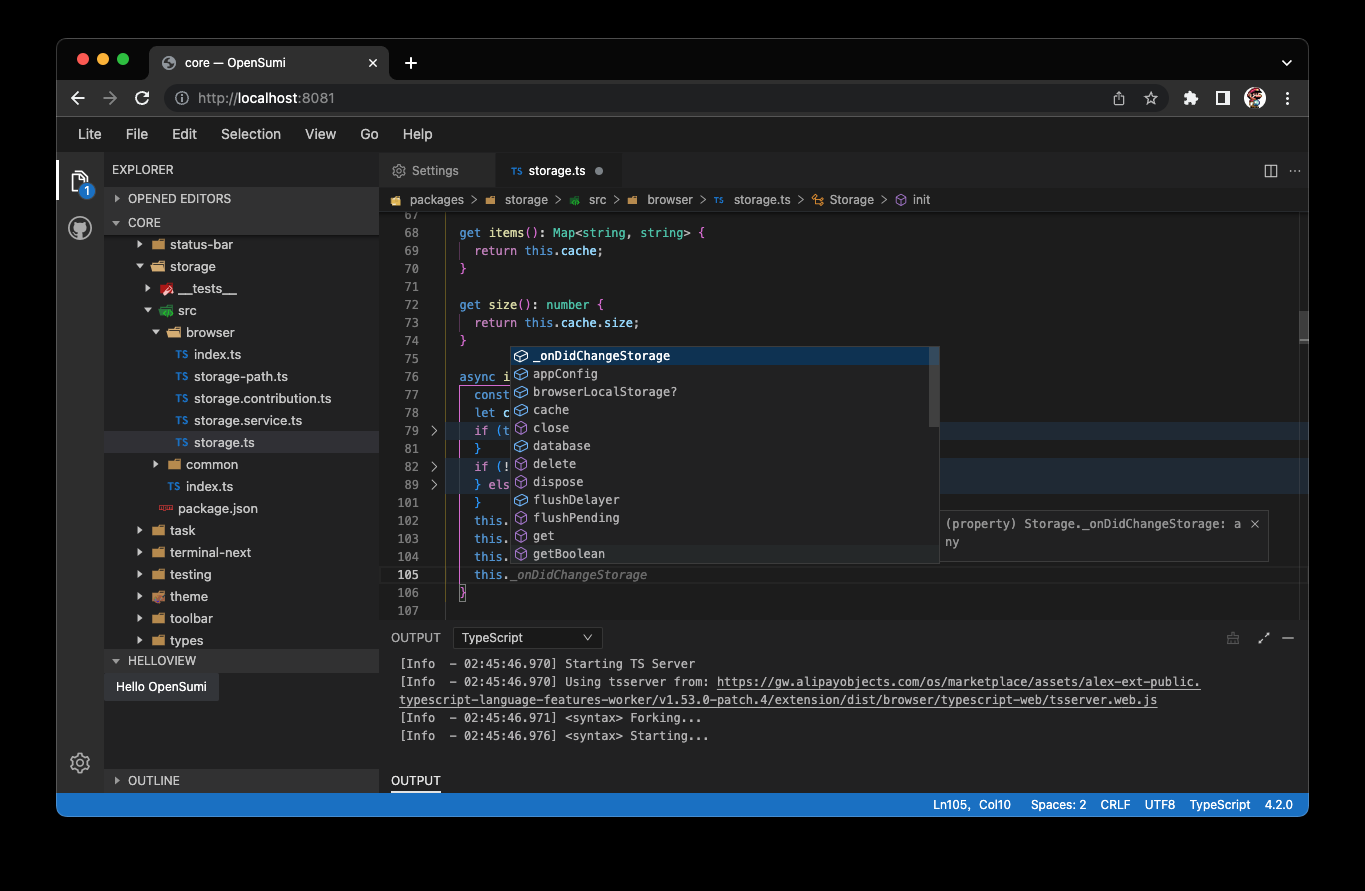

# 量化技术示例(伪代码)

model = load_model("deepseek-7b")

quantized_model = apply_quantization(model, precision='int8') # 显存降低40%

- VGA-Speicherkomprimierungstechnologie::

- vLLM-Rahmen20%: Steigerung des Durchsatzes durch den PageAttention-Mechanismus

- FlashAttention-2Verkleinerung des 30%-Videospeicherplatzes

- AWQ-Quantifizierung50% reduzierter Speicher bei gleichbleibender 97% Genauigkeit

4) Vergleich von realen Einsatzfällen

| Sportereignis | RTX3060(12G) | RTX4090(24G) | A100 (80G) |

|---|---|---|---|

| DeepSeek-7B | Notwendigkeit, den Einsatz zu quantifizieren | native Unterstützung | Unterstützung mehrerer Instanzen |

| Inferenzgeschwindigkeit | 8 Token/s | 24 Token/s | 50+ Token/s |

| Maximaler Kontext | 2K Token | 8K-Münzen | 32K Token |

5 Lagerung und Systemanforderungen

- Scheibenraum::

- Basismodell: Anzahl der Parameter × 2 (z. B. 7B erfordert 14 GB)

- Vollständiges Bereitstellungspaket: 50 GB Speicherplatz werden empfohlen

- Betriebssystem::

- Ubuntu 20.04+ (empfohlen)

- Windows erfordert WSL2-Unterstützung

- Software-Abhängigkeit::

- CUDA 11.7+

- PyTorch 2.0+

Empfohlene Lektüre

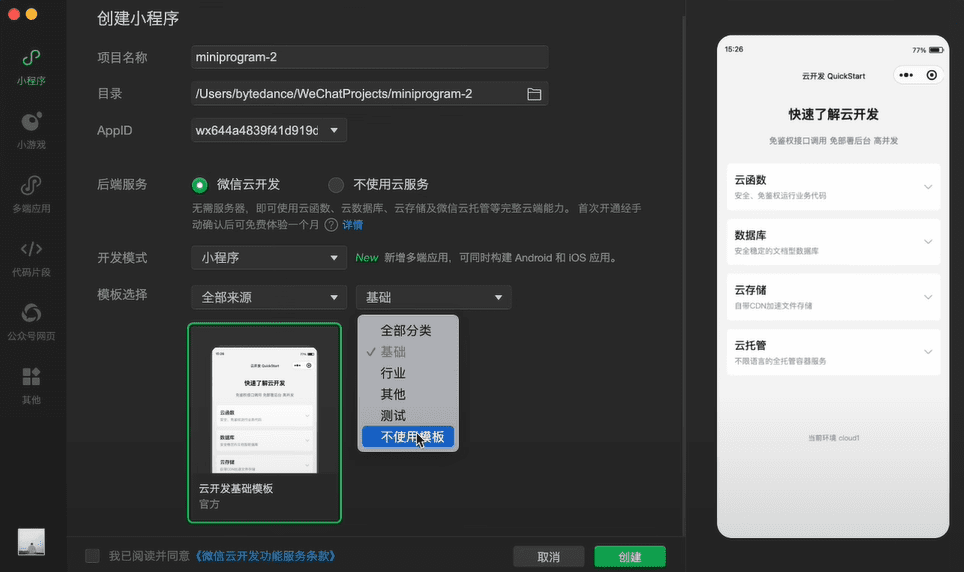

Privater Einsatz ohne lokale GPUs DeepSeek-R1 32B

Empfehlungen für die PraxisFür einzelne Entwickler kann die Konfiguration RTX3090 + 64 GB Speicher das 7B-Modell reibungslos ausführen. Für den Einsatz auf Unternehmensebene wird die Verwendung eines A100/H100-Clusters mit Optimierungsframeworks wie vLLM empfohlen, um eine effiziente Inferenz zu erreichen. Beim quantitativen Einsatz sollten die Auswirkungen von Präzisionsverlusten auf das Geschäft berücksichtigt werden, und es wird eine strenge Prüfung und Validierung empfohlen.

© urheberrechtliche Erklärung

Der Artikel ist urheberrechtlich geschützt und darf nicht ohne Genehmigung vervielfältigt werden.

Ähnliche Artikel

Keine Kommentare...