Häufig gestellte Fragen zur Verwendung der DeepSeek-R1-API

DeepSeek-R1 API

Der Standardmodellname lautet: deepseek-reasoner

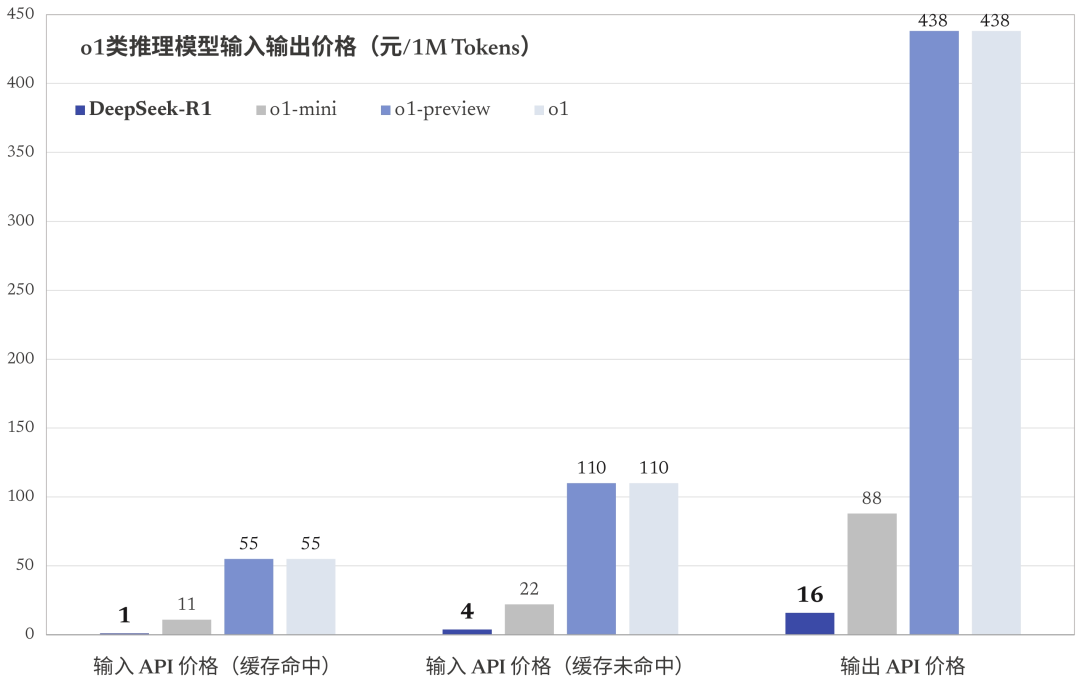

DeepSeek-R1 unterstützt Cache-Treffer

Cache-Treffer werden im Allgemeinen für hochfrequente Eingaben mit wenigen Beispielen, große Dokumenteneingaben mit mehreren Ausgaben (weniger als 64 Token (deren Inhalt nicht zwischengespeichert wird)

Eingabeteile von System- und Benutzernachrichten werden als Cache-Treffer gezählt.

Cache-Treffer sind zeitabhängig und reichen in der Regel von einigen Stunden bis zu einigen Tagen.

Anzahl der vom Cache getroffenen Token ($1/Million Token)

DeepSeek-R1 Ausgabe-Probleme

DeepSeek-R1 Die Ausgabe umfasst sowohl die Ausgabe der Gedankenkette als auch die Ausgabe der Antwort, die beide als Ausgabe zählen. Token Die Rechnungsstellung ist die gleiche.

Die API unterstützt bis zu 64K Kontexte, und Gedankenketten werden nicht auf die Gesamtlänge angerechnet.

Die Ausgabe der Gedankenkette kann auf ein Maximum (reasoning_effort) von 32K Token gesetzt werden; die Ausgabe der Antwort kann auf ein Maximum (max_tokens) von 8K Token gesetzt werden.

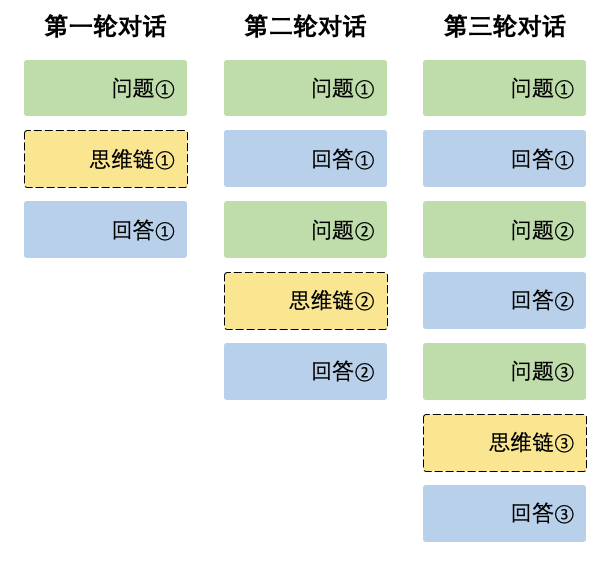

DeepSeek-R1 Kontextspleißung

Während jeder Dialogrunde gibt das Modell den Inhalt der Gedankenkette aus (reasoning_content) und die endgültige Antwort (content). In der nächsten Dialogrunde wird der Inhalt der Gedankenkette, die in der vorherigen Runde ausgegeben wurde, nicht in den Kontext eingefügt, wie unten dargestellt:

Der Kontext behält immer die letzte Runde der Gedankenkette bei, sonst wird die Antwort verwirrt sein.

Über die Verwendung der DeepSeek-R1-API von Drittanbietern

Beachten Sie die Inkompatibilität mit offiziellen Formaten! Zum Beispiel, Silizium-basierte Strömung.

© urheberrechtliche Erklärung

Der Artikel ist urheberrechtlich geschützt und darf nicht ohne Genehmigung vervielfältigt werden.

Ähnliche Artikel

Keine Kommentare...