VideoReTalking: Audio-gesteuertes Lippensynchronisations- und Videobearbeitungssystem

Allgemeine Einführung

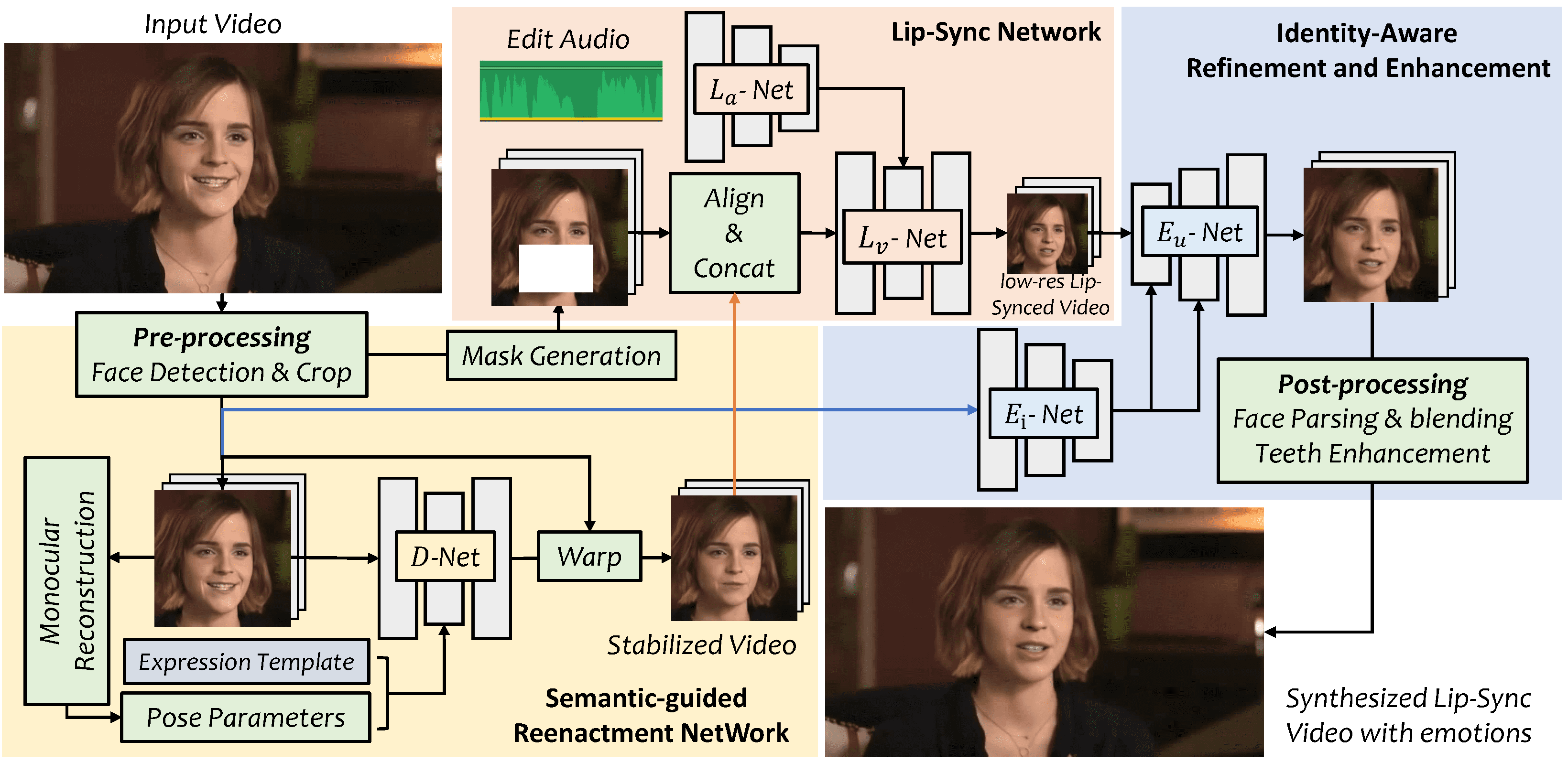

VideoReTalking ist ein innovatives System, das es dem Benutzer ermöglicht, lippensynchrone Gesichtsvideos auf der Grundlage von Eingangsaudiosignalen zu erzeugen, wobei qualitativ hochwertige und lippensynchrone Ausgangsvideos auch bei unterschiedlichen Emotionen entstehen. Das System unterteilt dieses Ziel in drei aufeinanderfolgende Aufgaben: Erzeugung von Gesichtsvideos mit typischen Ausdrücken, audiogestützte Lippensynchronisation und Gesichtsverbesserung zur Verbesserung des Fotorealismus. Alle drei Schritte werden mit einem lernbasierten Ansatz bearbeitet, der ohne Benutzereingriff nacheinander ausgeführt werden kann. Erkunden Sie VideoReTalking und seine Anwendung zur audiogesteuerten Lippensynchronisation bei der Videobearbeitung von Talking Heads über den angegebenen Link.

(undeutlich, Videoqualität muss zweimal verbessert werden, etwas schlechte Lippensynchronisation auf Chinesisch)

Funktionsliste

Generierung von Gesichtsvideos: Generierung von Gesichtsvideos mit typischen Gesichtsausdrücken auf der Grundlage der Audioeingabe.

Audiogesteuerte Lippensynchronisation: Erzeugt lippensynchrones Video auf der Grundlage des vorgegebenen Audios.

Gesichtsverbesserung: Verbesserung des Fotorealismus von synthetischen Gesichtern durch ein identitätsbewusstes Gesichtsverbesserungsnetzwerk und Post-Processing.

Hilfe verwenden

Laden Sie das trainierte Modell herunter und speichern Sie es in `. /checkpoints`.

Führen Sie `python3 inference.py` aus, um eine schnelle Inferenz des Videos zu erhalten.

Ausdrücke können durch Hinzufügen der Argumente `--exp_img` oder `--up_face` kontrolliert werden.

Online-Erlebnis-Adresse

© urheberrechtliche Erklärung

Der Artikel ist urheberrechtlich geschützt und darf nicht ohne Genehmigung vervielfältigt werden.

Ähnliche Artikel

Keine Kommentare...