AppAgent: manejo automatizado de smartphones mediante inteligencias multimodales

Introducción general

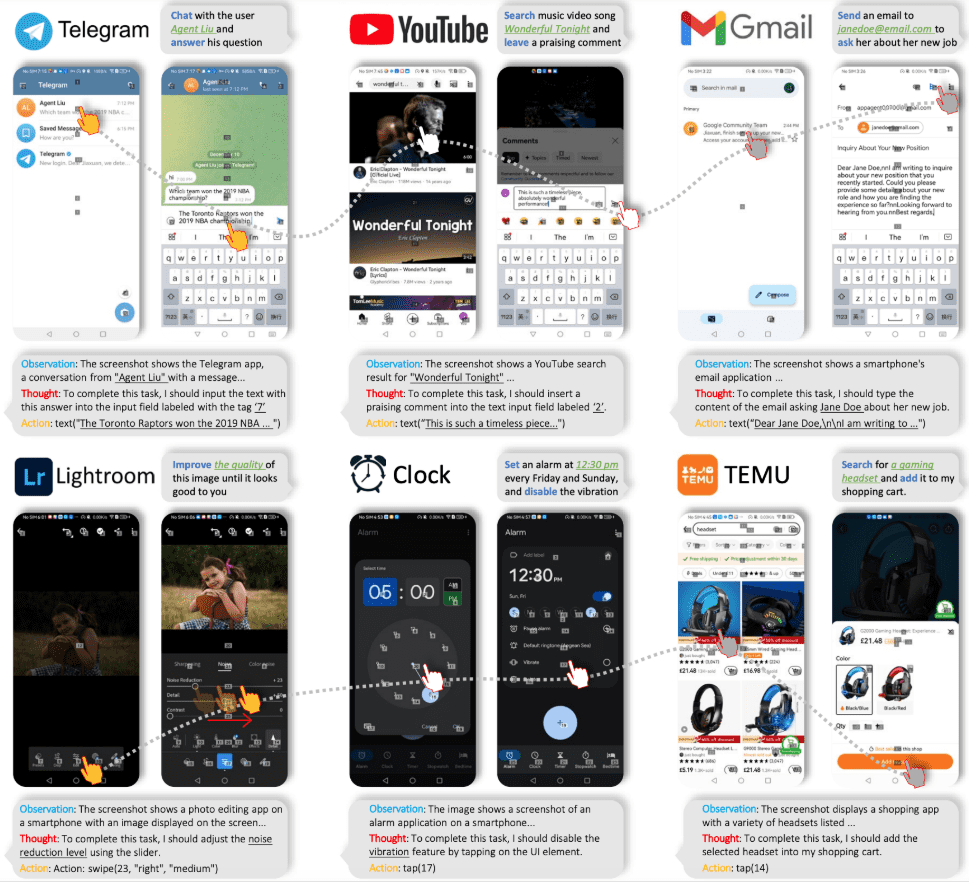

AppAgent es un marco de agentes multimodales basado en el Large Language Model (LLM) diseñado para manejar aplicaciones de teléfonos inteligentes. El marco amplía su aplicabilidad a distintas aplicaciones mediante un espacio de manipulación simplificado que imita las interacciones humanas, como los toques y los deslizamientos, eliminando así la necesidad de acceder al back-end del sistema.El AppAgent aprende a utilizar nuevas aplicaciones explorando u observando de forma autónoma demostraciones humanas, y genera una base de conocimientos para realizar tareas complejas.

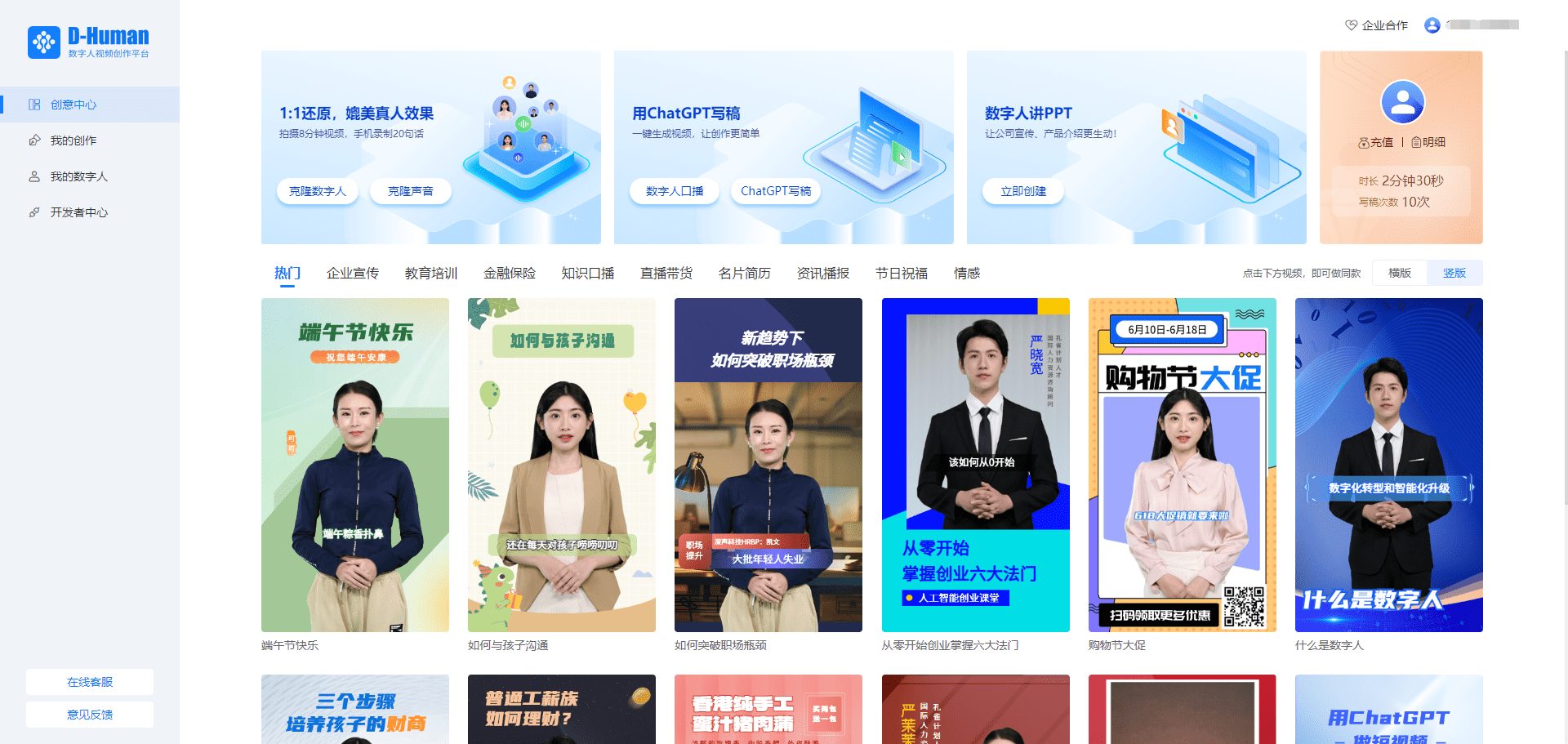

Tencent lanzó AppAgent, un cuerpo inteligente multimodal que puede manejar directamente la interfaz del teléfono móvil reconociendo la interfaz actual del teléfono móvil y los comandos del usuario, ¡y puede manejar el teléfono móvil como un usuario real! Por ejemplo, puede manejar programas de edición de fotos para editar imágenes, abrir aplicaciones de mapas para navegar, ir de compras, etc.

Página de inicio del proyecto: https://appagent-official.github.io

Enlace al documento: https://arxiv.org/abs/2312.13771

resumen de tesis

Con los recientes avances en los modelos de lenguaje de gran tamaño (LLM), se han creado cuerpos inteligentes que pueden realizar tareas complejas. En este artículo, presentamos un novedoso marco multimodal para cuerpos inteligentes basado en Large Language Models, diseñado para manipular aplicaciones de smartphones. Nuestro marco permite a los cuerpos inteligentes manipular aplicaciones de teléfonos inteligentes a través de un espacio de manipulación simplificado, de tal manera que es como si un humano estuviera realizando operaciones de clic y deslizamiento. Este enfoque innovador evita la necesidad de acceder directamente al back-end del sistema, lo que lo hace adecuado para una amplia gama de aplicaciones diferentes. En el corazón de la funcionalidad de nuestras inteligencias se encuentra su innovador enfoque del aprendizaje. El Cuerpo Inteligente aprende a navegar y utilizar nuevas aplicaciones mediante la autoexploración o la observación de demostraciones humanas. En el proceso, construye una base de conocimientos en la que se apoya para realizar tareas complejas en distintas aplicaciones. Para demostrar la utilidad de nuestra inteligencia, la probamos a fondo en 50 tareas de 10 aplicaciones distintas, entre ellas redes sociales, correo electrónico, mapas, compras y herramientas complejas de edición de imágenes. Los resultados de las pruebas demuestran la eficiente capacidad de nuestra inteligencia para manejar una amplia gama de tareas avanzadas.

Lista de funciones

- exploración autodirigida: Los agentes pueden explorar aplicaciones de forma autónoma, registrar elementos interactivos y generar documentación.

- Aprendizaje por Demostración HumanaEl agente aprende la tarea observando una demostración humana y genera la documentación adecuada.

- aplicación del mandatoDurante la fase de despliegue, el agente realiza tareas complejas basándose en los documentos generados.

- Entradas multimodales: Admite entradas textuales y visuales, utilizando los modelos GPT-4V o Qwen-VL-Max.

- Tratamiento de CAPTCHAPuede autenticarse mediante CAPTCHA.

- Reconocimiento de elementos de interfaz de usuario: Utiliza superposiciones de cuadrícula para posicionar elementos de interfaz de usuario no etiquetados.

Utilizar la ayuda

Instalación y configuración

- Descarga e instalaciónDescarga los archivos del proyecto de la página de GitHub e instala las dependencias necesarias.

- archivo de configuraciónModifica el directorio raíz

config.yamlpara configurar la clave API para el modelo GPT-4V o Qwen-VL-Max. - dispositivo conectadoConecta tu dispositivo Android mediante USB y activa la depuración USB en Opciones de desarrollador.

Modelo de autoexploración

- iniciar una exploración: Ejecutar

learn.pyseleccione Modo de exploración autónoma e introduzca el nombre de la aplicación y la descripción de la tarea. - Registrar interaccionesEl agente explorará automáticamente la aplicación, registrará los elementos de interacción y generará documentación.

Modo de demostración humana

- Demostración: Ejecutar

learn.pyseleccione el modo de demostración humana e introduzca el nombre de la aplicación y la descripción de la tarea. - Demostración ejecutivaSiga las instrucciones y el agente registrará todas las interacciones y generará la documentación.

aplicación del mandato

- Iniciar tareas: Ejecutar

run.pyintroduzca el nombre de la aplicación y la descripción de la tarea, y seleccione la biblioteca de documentos adecuada. - operarEl agente realizará tareas para completar operaciones complejas basándose en la documentación.

Procedimiento de funcionamiento detallado

- Descargar proyectoVisita la página de GitHub, descarga los archivos del proyecto y extráelos.

- Instalación de dependenciasEjecutar en un terminal

pip install -r requirements.txtInstale todas las dependencias. - modelo de configuraciónModifíquese en caso necesario

config.yamlpara configurar la clave API para el modelo GPT-4V o Qwen-VL-Max. - dispositivo conectadoConecta tu dispositivo Android mediante USB y activa el modo de depuración USB en el dispositivo.

- Iniciar una exploración o demostración: Ejecutar

learn.pyseleccione el modo Exploración Autónoma o Demostración Humana e introduzca el nombre de la aplicación y la descripción de la tarea. - Generar documentaciónEl agente registrará todas las interacciones y generará documentación para la posterior ejecución de tareas.

- operar: Ejecutar

run.pyintroduzca el nombre de la aplicación y la descripción de la tarea, seleccione la biblioteca de documentos adecuada y el agente realizará la tarea basándose en el documento.

© declaración de copyright

El artículo está protegido por derechos de autor y no debe reproducirse sin autorización.

Artículos relacionados

Sin comentarios...