CogVLM2:开源多模态模型,支持视频理解与多轮对话

Introducción general

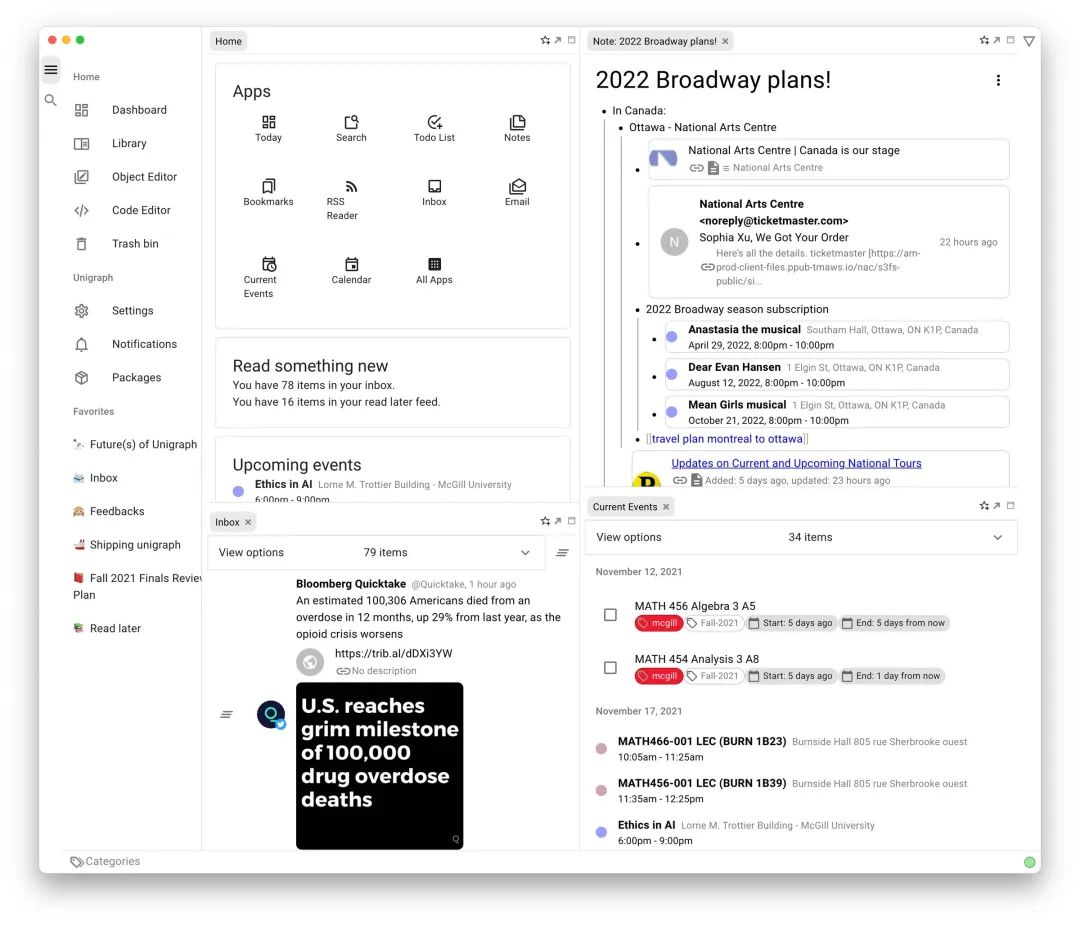

CogVLM2 是由清华大学数据挖掘研究组(THUDM)开发的开源多模态模型,基于 Llama3-8B 架构,旨在提供与 GPT-4V 相当甚至更优的性能。该模型支持图像理解、多轮对话以及视频理解,能够处理长达 8K 的内容,并支持高达 1344x1344 的图像分辨率。CogVLM2 系列包括多个子模型,分别针对不同任务进行了优化,如文本问答、文档问答和视频问答等。该模型不仅支持中英文双语,还提供了多种在线体验和部署方式,方便用户进行测试和应用。

相关信息:大模型能理解多长的视频?智谱 GLM-4V-Plus:2小时

Lista de funciones

- 图像理解:支持高分辨率图像的理解与处理。

- 多轮对话:能够进行多轮对话,适用于复杂的交互场景。

- 视频理解:通过提取关键帧,支持最长 1 分钟的视频内容理解。

- Soporte multilingüe:支持中英文双语,适应不同语言环境。

- 开放源码:提供完整的源码和模型权重,方便用户进行二次开发。

- Experiencia en línea:提供在线演示平台,用户可以直接体验模型功能。

- 多种部署方式:支持 Huggingface、ModelScope 等多种平台的部署。

Utilizar la ayuda

Instalación y despliegue

- almacén de clones::

git clone https://github.com/THUDM/CogVLM2.git

cd CogVLM2

- Instalación de dependencias::

pip install -r requirements.txt

- Descargar modelos de pesos: 根据需要下载相应的模型权重,并放置在指定目录。

使用示例

图像理解

- Modelos de carga::

from cogvlm2 import CogVLM2

model = CogVLM2.load('path_to_model_weights')

- 处理图像::

image = load_image('path_to_image')

result = model.predict(image)

print(result)

多轮对话

- 初始化对话::

conversation = model.start_conversation()

- 进行对话::

response = conversation.ask('你的问题')

print(response)

视频理解

- 加载视频::

video = load_video('path_to_video')

result = model.predict(video)

print(result)

Experiencia en línea

用户可以访问 CogVLM2 在线演示平台 进行模型功能的在线体验,无需本地部署。

© declaración de copyright

El artículo está protegido por derechos de autor y no debe reproducirse sin autorización.

Artículos relacionados

Sin comentarios...