DeepGemini: orquestación multimodelo de tareas y encapsulación en una interfaz API

Introducción general

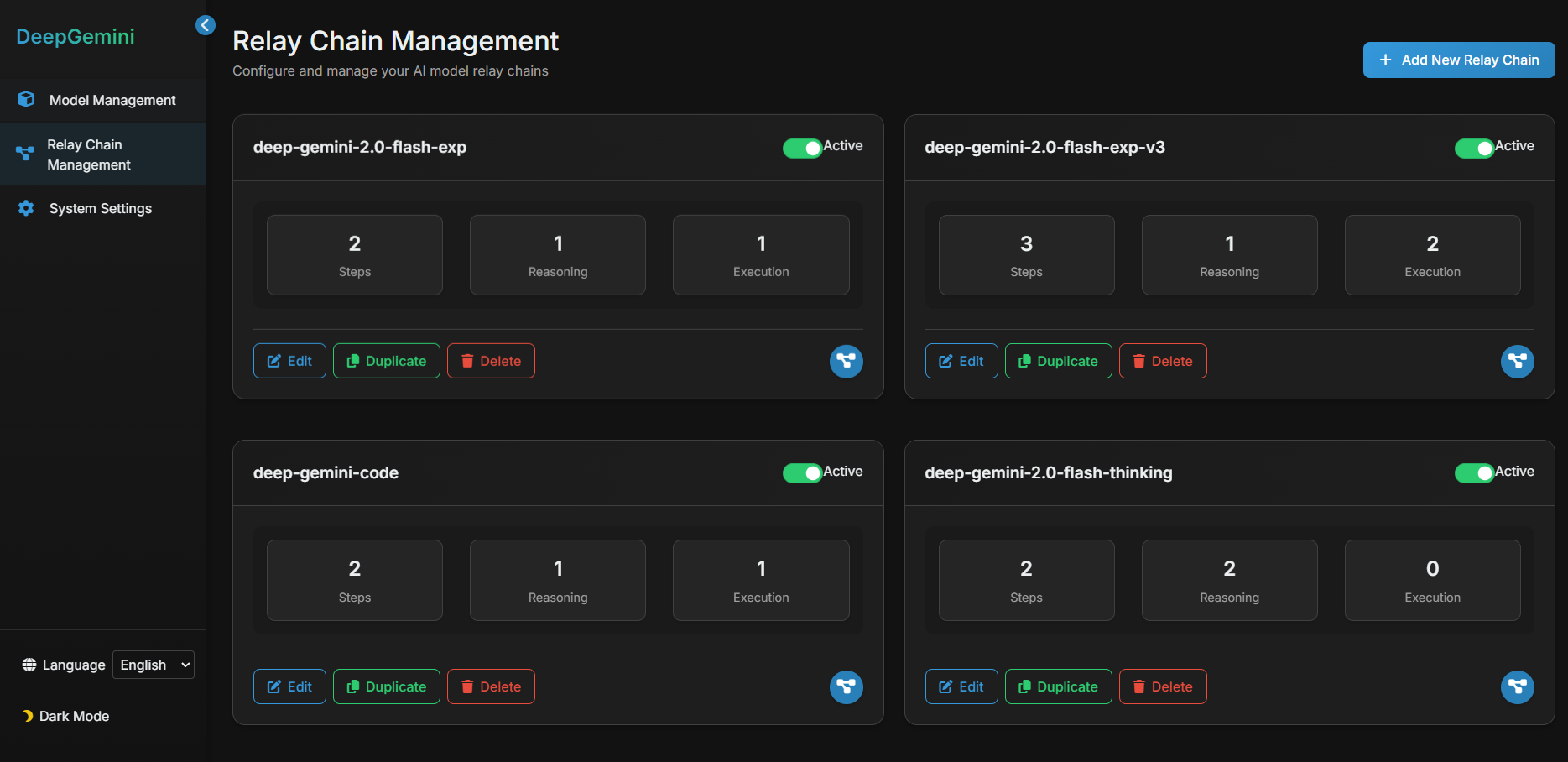

DeepGemini es un proyecto de código abierto creado por el desarrollador Thomas Sligter. Es una herramienta de gestión de IA que soporta orquestación multi-modelo , la característica principal es la capacidad de combinar de forma flexible una variedad de modelos de IA , y llamado a través de la interfaz API compatible con OpenAI . El proyecto se basa en Python 3.11 y FastAPI, soporta la configuración de almacenamiento de base de datos SQLite, y proporciona una interfaz de gestión web y despliegue Docker. Es adecuado para desarrolladores, entusiastas de la tecnología y usuarios empresariales, y la licencia MIT permite el uso y la modificación libres.DeepGemini admite interfaces en chino e inglés, y es rico en funciones y fácil de usar.

En el proyecto se configuraron flujos de trabajo multimodelo y grupos de tareas de debate multimodelo en la interfaz, que no podían utilizarse directamente en la interfaz y debían configurarse en otras herramientas de chat para utilizar la API. Esta herramienta es más sencilla y práctica que la habitual herramienta inteligente de programación de tareas corporales, el único inconveniente es que consume más cuota de API.

Lista de funciones

- Admite la orquestación multimodelo, lo que permite personalizar la combinación de varios modelos de IA para completar una tarea.

- Proporciona gestión de personajes y la posibilidad de establecer diferentes personalidades y habilidades para la IA.

- Admite grupos de discusión, en los que varios personajes de la IA pueden colaborar en las discusiones.

- Se han incorporado diversos modos de debate, como lluvia de ideas, debate y análisis DAFO.

- Compatible con múltiples proveedores de IA como DeepSeek, Claude, Gemini, Grok3 y más.

- Proporciona una interfaz API compatible con OpenAI que sustituye directamente a la interfaz OpenAI en las aplicaciones existentes.

- Admite respuesta de streaming en tiempo real para mejorar la experiencia del usuario.

- Interfaz de gestión web integrada para facilitar la configuración del modelo y comprobar su estado.

- Admite la base de datos SQLite y la migración Alembic para una configuración de gestión más estable.

Utilizar la ayuda

La instalación y uso de DeepGemini se divide en dos formas: operación local y despliegue Docker. A continuación se describen detalladamente los pasos de instalación y los procedimientos de operación funcional para ayudar a los usuarios a empezar rápidamente.

Proceso de instalación: ejecución local

- Clonación del código del proyecto

Introduzca el siguiente comando en el terminal para descargar el proyecto:

git clone https://github.com/sligter/DeepGemini.git

A continuación, vaya al directorio del proyecto:

cd DeepGemini

- Instalación de dependencias

Recomendado para proyectosuvLa herramienta instala las dependencias y se ejecuta:

uv sync

En caso contrario uvPuede utilizar la función pip install -r requirements.txt Alternativa. Asegúrese de que la versión de Python es 3.11 o superior.

- Configuración de variables de entorno

Copie el archivo de configuración de ejemplo:

cp .env.example .env

Abrir con un editor de texto .envConfigure los siguientes campos obligatorios:

ALLOW_API_KEYSu clave API, defínala usted mismo.ALLOW_ORIGINS: la fuente del nombre de dominio permitido, rellene el campo*Indica que todos están permitidos, o se utilizan comas para separar dominios específicos.

Las configuraciones opcionales incluyen claves y parámetros de la API del modelo (como elDEEPSEEK_API_KEY).

- Inicio de los servicios

Introduzca el siguiente comando para empezar:

uv run uvicorn app.main:app --host 0.0.0.0 --port 8000

Una vez iniciado, abra el navegador y visite http://localhost:8000/dashboardSi desea acceder a la interfaz de gestión web, puede hacerlo pulsando el siguiente enlace.

Proceso de instalación - Despliegue Docker

- Extracción de una imagen Docker

Se ejecuta en el terminal:

docker pull bradleylzh/deepgemini:latest

- Preparación de archivos de configuración y bases de datos

Crea un archivo en el directorio actual:

- Linux/Mac:

cp .env.example .env touch deepgemini.db echo "" > deepgemini.db - Windows PowerShell:

cp .env.example .env echo "" > deepgemini.db

compilador .envAjustes ALLOW_API_KEY responder cantando ALLOW_ORIGINS.

- Ejecución de contenedores Docker

Introduce el comando para empezar:

- Linux/Mac:

docker run -d -p 8000:8000 -v $(pwd)/.env:/app/.env -v $(pwd)/deepgemini.db:/app/deepgemini.db --name deepgemini bradleylzh/deepgemini:latest - Windows PowerShell:

docker run -d -p 8000:8000 -v ${PWD}\.env:/app/.env -v ${PWD}\deepgemini.db:/app/deepgemini.db --name deepgemini bradleylzh/deepgemini:latest

Después de ejecutarlo, acceda a http://localhost:8000/dashboard.

Uso de Docker Compose (recomendado)

- intente

.envy archivos de base de datos, como se ha descrito anteriormente. - Corriendo:

docker-compose up -d

entrevistas http://localhost:8000/dashboard.

Funciones principales

1. Funcionamiento de la interfaz de gestión web

- Abra su navegador y visite

http://localhost:8000/dashboard. - La interfaz muestra el estado del modelo y las opciones de configuración. Haga clic en "Añadir modelo", introduzca el nombre del modelo (por ejemplo, DeepSeek), la clave API y los parámetros (temperatura, top_p, etc.), y guarde.

- En Gestión de roles, cree un rol de IA y defina la personalidad (por ejemplo, "Rigor lógico") y las habilidades (por ejemplo, "Generación de texto").

2. Configuración de la orquestación multimodelo

- En la pantalla Flujo de trabajo, haga clic en Nuevo flujo de trabajo.

- Ejemplo de configuración:

{

"name": "reason_and_execute",

"steps": [

{"model_id": "deepseek", "step_type": "reasoning", "step_order": 1},

{"model_id": "claude", "step_type": "execution", "step_order": 2}

]

}

- Una vez guardado, el flujo de trabajo razonará con DeepSeek antes de generar resultados con Claude.

3. Llamada a la interfaz API

- utilizar

curlPruebe la API:

curl -X POST "http://localhost:8000/v1/chat/completions" -H "Authorization: Bearer YOUR_API_KEY" -H "Content-Type: application/json" -d '{"model": "reason_and_execute", "messages": [{"role": "user", "content": "分析并回答:1+1等于几?"}]}'

- intercambiabilidad

YOUR_API_KEYdebido a.enven la clave. El resultado devuelto es una respuesta streaming.

4. Creación de grupos de debate

- En la página Grupos de debate, añada varios roles (como Analista y Creador).

- Seleccione un modo de debate (por ejemplo, "Lluvia de ideas"), introduzca una pregunta y haga clic en "Iniciar debate". El sistema mostrará el diálogo entre los personajes.

advertencia

- Asegúrese de que la conexión de red funciona correctamente, algunos modelos requieren acceso a API externas.

- Los archivos de registro se encuentran en

<项目目录>/logs/que puede utilizarse para solucionar problemas. - Si se produce un conflicto de puertos durante la implementación de Docker, puede modificar la directiva

-p 8000:8000El primer número de puerto del

escenario de aplicación

- Experimentos de desarrollo de IA

Los desarrolladores pueden probar la colaboración multimodelo con DeepGemini. Por ejemplo, empezar con Géminis Analiza la pregunta y luego utiliza a Claude para generar una respuesta detallada. - Simulación de trabajo en equipo

Simule reuniones de equipo mediante la función de grupo de debate. Establece distintos roles para debatir estrategias de producto y aportar sugerencias diversas. - Educación y formación

Los alumnos pueden utilizarlo para conocer las propiedades de los modelos de IA y experimentar con distintos modos de discusión para observar los resultados.

CONTROL DE CALIDAD

- ¿Qué proveedores de IA son compatibles?

Compatibilidad con DeepSeek, Claude, Gemini, Grok3, OpenAI, etc., con acceso personalizado a otros proveedores. - ¿Para qué sirve un grupo de debate?

Los grupos de debate permiten que varias personas de IA colaboren en problemas complejos, como lluvias de ideas o debates, proporcionando múltiples perspectivas sobre las respuestas. - ¿Cómo se depura un problema?

Compruebe los archivos de registro o envíe una incidencia a GitHub para obtener ayuda.

© declaración de copyright

El artículo está protegido por derechos de autor y no debe reproducirse sin autorización.

Artículos relacionados

Sin comentarios...