Infinity: modelización autorregresiva por bits de la generación de imágenes de alta resolución para una generación ilimitada de imágenes de alta resolución

Introducción general

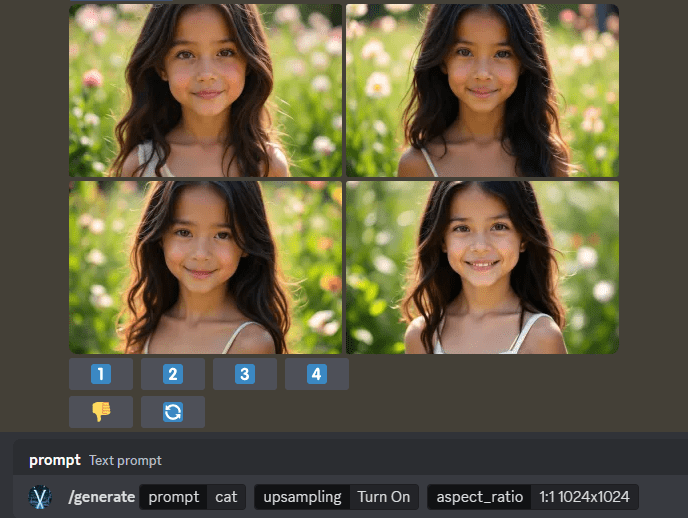

Infinity es un marco pionero de generación de imágenes de alta resolución desarrollado por el equipo de FoundationVision. La característica principal de Infinity es el uso de un vocabulario ilimitado de desambiguadores y clasificadores que, junto con el mecanismo de autocorrelación a nivel de bits, es capaz de generar imágenes realistas de altísima calidad. El proyecto es totalmente de código abierto y ofrece una selección de tamaños de modelo de 2B a 20B escalas de parámetros, lo que permite generar imágenes con resoluciones de hasta 1024x1024. Como proyecto de investigación de vanguardia, Infinity no sólo impulsa el progreso tecnológico en el campo de la visión por ordenador, sino que también aporta nuevas soluciones para las tareas de generación de imágenes.

¡Únete al canal de discordia para experimentar el modelo de generación de imágenes Infinity!

Lista de funciones

- El modelo paramétrico 2B admite la generación de imágenes de alta calidad con una resolución de hasta 1024x1024

- Proporciona un léxico visual con un vocabulario ilimitado para facilitar la extracción de características más precisas de las imágenes.

- Aplicación de un mecanismo de autocorrección a nivel de bits para mejorar la calidad y precisión de las imágenes generadas.

- Admite la selección flexible de varios tamaños de modelo (parámetros 125M, 1B, 2B, 20B)

- Proporcionar una interfaz de inferencia interactiva para facilitar a los usuarios la realización de experimentos de generación de imágenes.

- Integrado con un marco completo de formación y evaluación

- Admite la evaluación multidimensional del rendimiento del modelo (GenEval, DPG, HPSv2.1 y otras métricas)

- Ofrece una plataforma de demostración en línea que permite a los usuarios experimentar directamente la generación de imágenes.

Utilizar la ayuda

1. Configuración medioambiental

1.1 Requisitos básicos:

- Entorno Python

- PyTorch >= 2.5.1 (requiere compatibilidad con FlexAttention)

- Instale otras dependencias mediante pip:

pip3 install -r requirements.txt

2. Utilización de modelos

2.1 Inicio rápido:

- Descarga el modelo preentrenado de HuggingFace: infinity_2b_reg.pth

- Descargar Segmentador visual: infinity_vae_d32_reg.pth

- Generación interactiva de imágenes mediante interactive_infer.ipynb

2.2 Configuración de la formación:

# 使用单条命令启动训练

bash scripts/train.sh

# 不同规模模型的训练命令

# 125M模型(256x256分辨率)

torchrun --nproc_per_node=8 train.py --model=layer12c4 --pn 0.06M

# 2B模型(1024x1024分辨率)

torchrun --nproc_per_node=8 train.py --model=2bc8 --pn 1M

2.3 Preparación de los datos:

- Los datos de formación deben prepararse en formato JSONL

- Cada dato contiene: ruta de la imagen, descripción breve y larga, relación de aspecto de la imagen y otra información.

- El proyecto proporciona conjuntos de datos de muestra como referencia.

2.4 Evaluación del modelo:

- Soporte para múltiples indicadores de evaluación:

- ImageReward: evaluación de las preferencias humanas por las imágenes generadas

- HPS v2.1: Métricas de evaluación basadas en 798.000 clasificaciones manuales

- GenEval: evaluación de la alineación texto-imagen

- FID: evaluación de la calidad y la diversidad de las imágenes generadas

2.5 Presentación en línea:

- Visite la plataforma de demostración oficial: https://opensource.bytedance.com/gmpt/t2i/invite

- Introduzca una descripción de texto para generar la correspondiente imagen de alta calidad

- Admite el ajuste de múltiples resoluciones de imagen y parámetros de generación

3. Funciones avanzadas

3.1 Mecanismos de autocorrección a nivel de bit:

- Reconocimiento y corrección automáticos de errores en el proceso de generación

- Mejorar la calidad y la precisión de las imágenes generadas

3.2 Ampliaciones del modelo:

- Admite la ampliación flexible del tamaño de los modelos

- Múltiples modelos disponibles desde parámetros 125M a 20B

- Adaptarse a diferentes entornos de hardware y requisitos de aplicación

4. Precauciones

- Garantizar que los recursos de hardware cumplen los requisitos del modelo

- Los modelos a gran escala requieren suficiente memoria en la GPU

- Recomendado para la formación con equipos HPC

- Puntos de control periódicos de la formación de refuerzo

- Observe la adhesión al protocolo de código abierto del MIT

© declaración de copyright

El artículo está protegido por derechos de autor y no debe reproducirse sin autorización.

Artículos relacionados

Sin comentarios...