El autor del núcleo de OpenManus comparte: ¡Cómo completar el marco del Agente en tres horas!

La tecnología de los agentes (cuerpos inteligentes) ha arrasado esta semana en el mundo de la tecnología a un ritmo sin precedentes, y detrás de este auge hay un salto adelante en las capacidades de modelado del razonamiento.

El 5 de marzo por la noche, Manus hizo un debut impresionante con una potente demo que incendió Internet al instante. Sólo dos días después, el equipo nacional DeepWisdom MetaGPT y CAMEL AI han lanzado sendos proyectos de código abierto OpenManus y OWL, replicando rápidamente el Manus han vuelto a encender la web y la comunidad de GitHub, suscitando un amplio y profundo debate.

Especialmente digno de mención es que el equipo de OpenManus, con la larga experiencia técnica acumulada de MetaGPT, completó la construcción del núcleo del sistema en solo una hora y puso el proyecto en línea en solo tres horas. Esta asombrosa velocidad no sólo ayudó a OpenManus a ganar más de 10.000 estrellas en GitHub, sino que también lo convirtió en el centro de atención dentro y fuera del sector.

En la mañana del 8 de marzo, JQF invitó a tres miembros principales del equipo de OpenManus a impartir una sesión de intercambio en profundidad, con el objetivo de analizar los principios de la implementación técnica de OpenManus y debatir la tendencia de desarrollo futuro de la tecnología de agentes.

Los tres invitados son expertos de alto nivel en el campo del Agente: Siren Hong, primera autora de la ponencia MetaGPT (ICLR 2024 Oral) y de la ponencia Data Interpreter, y una de las autoras de la ponencia AFLOW (ICLR 2025 Oral), cuyos resultados de investigación se han publicado en numerosas ocasiones en las principales conferencias académicas internacionales, como TPAMI e ICLR, Los resultados de sus investigaciones se han publicado en TPAMI, ICLR y otras conferencias y revistas internacionales de primer orden. Liang Xinbing, desarrollador principal de OpenManus. Jinyu Xiang es coautor de OpenManus y primer autor de AFlow y SPO.

En sus intervenciones, los tres invitados expusieron sus reflexiones sobre el futuro de la tecnología de agentes y los retos a los que se enfrenta el sector:

- A medida que sigan aumentando las capacidades de los grandes modelos lingüísticos (LLM), la tasa de éxito de las aplicaciones de agentes se incrementará drásticamente en muchos dominios, especialmente en tareas relativamente estandarizadas como los cuestionarios de control de calidad, las evaluaciones de competencia en código de HumanEval y los problemas de programación en Python del MBPP, en los que un único modelo ha demostrado una excelente capacidad de solución.

- Sin embargo, hay un gran número de problemas del mundo real que son complejos y tienen efectos de cola larga, como tareas complejas de aprendizaje automático, corrección de errores de código y problemas combinatorios de búsqueda que requieren la integración de múltiples piezas de información para ofrecer respuestas eficaces a los usuarios. Estos problemas siguen requiriendo una importante innovación tecnológica para mejorar el rendimiento de los agentes, especialmente en la resolución de problemas de "ilusión" de modelos.

- El progreso de los Agentes en la capacidad de planificación de tareas depende tanto de la mejora de la propia capacidad del modelo como de la ayuda de una arquitectura externa. Un diseño arquitectónico más sofisticado puede ayudar a los Agentes a comprender y descomponer mejor las tareas complejas.

- Con la creciente variedad de herramientas a disposición de los agentes, se convertirá en un nuevo reto técnico permitirles tomar decisiones precisas entre un gran número de herramientas con funciones similares cuando se enfrenten a la misma tarea, elegir la herramienta más adecuada y evitar elecciones erróneas.

- La cuestión central de la gestión de memoria para Agentes es cómo encontrar un equilibrio entre coste y eficiencia. El uso directo de la información completa de la memoria, aunque puede ser manejado por los modelos actuales, conduce a un aumento significativo del tiempo de procesamiento y del coste, lo que afecta seriamente a la experiencia del usuario más que a la degradación del rendimiento.

- En la actualidad, un enfoque eficaz para resolver el problema de la gestión de la memoria consiste en adoptar una arquitectura de cuerpos multiinteligentes o una estrategia asistida por herramientas. Por ejemplo, marcos como OpenManus suelen utilizar herramientas de planificación para pregenerar un plan de tareas, descomponer una tarea compleja en múltiples subtareas, con reparto incompleto de memoria entre cada subtarea, y resumir o comprimir el proceso una vez ejecutada la tarea, reduciendo así los costes computacionales.

- Aunque podemos determinar claramente si el Agente ha completado la tarea correctamente en la prueba de referencia, sigue siendo un reto evaluar cuantitativamente la precisión o calidad del Agente a la hora de completar la tarea en escenarios de aplicación reales.

- La clave para comercializar un Agente es maximizar las tareas y necesidades de los usuarios en escenarios reales, incluida la provisión de una funcionalidad altamente personalizada, que es la única forma de atraer a los usuarios para que sigan utilizando el Agente.

- Un gran número de desarrolladores de aplicaciones están explorando activamente Ficha Esquemas de optimización del consumo, como mecanismos de caché o técnicas de compresión de memoria a nivel de ingeniería, para minimizar la longitud del contexto que hay que pasar en cada llamada a la API y reducir costes.

- En el futuro, al integrar las capacidades de múltiples modelos pequeños, se espera conseguir resultados comparables o incluso superiores a los de los modelos grandes, y lograr ventajas significativas en velocidad de inferencia, consumo de tokens y coste.

A continuación se explica detalladamente el contenido de este reparto.

01 El éxito de una noche en GitHub, la vía rápida técnica de OpenManus

Liang Xinbing: "Tras la reunión de grupo del 6 de marzo, justo después de las 5 de la tarde, Xiang Jinyu sugirió que con unos pocos pasos clave podríamos ser capaces de replicar el efecto de Manus".

Recordando la oportunidad de iniciar el proyecto OpenManus, Liang Xinbing dijo: "Cuando vio por primera vez el vídeo de demostración de Manus, quedó impresionado por la fluida experiencia de interacción. Cuando vio por primera vez el vídeo de demostración de Manus, quedó impresionado por la fluida experiencia de interacción del vídeo, e intuyó que Manus debía ser un sistema de inteligencia única. "¿Cómo puede un único organismo inteligente lograr resultados tan excelentes, y cómo planifica y realiza las tareas? Esto me resulta muy chocante".

En la conversación subsiguiente, el equipo empezó a explorar la solución técnica para Manus, un producto corporal inteligente de IA de uso general con una experiencia de usuario impresionante. Sin embargo, desde un punto de vista técnico, Manus es en realidad una inteligente integración de muchas tecnologías básicas fundamentales que han sido consensuadas por la industria. En última instancia, el equipo dedujo que Manus emplea un mecanismo de planificación externo para coordinar el trabajo de múltiples inteligencias.

Después de la cena, se lanzó oficialmente el desarrollo de OpenManus y todo el proceso duró unas tres horas. "En aquel momento, no preveíamos que OpenManus se hiciera tan popular tan rápidamente". admite Liang Xinbing.

Explicación de la arquitectura de inteligencia múltiple Manus: la delicada sinergia de la planificación y la ejecución

El núcleo de Manus es su arquitectura de sistema multiinteligencia. Comienza con una descomposición de los requisitos del usuario mediante la herramienta de planificación PlanningTool, que genera un plan detallado con múltiples subtareas lineales. A continuación, el sistema ejecuta cada subtarea de forma secuencial y la asigna dinámicamente al Agente más adecuado, que realiza la subtarea utilizando la función ReAct Un modelo cíclico (Razonar y Actuar) que recurre continuamente a la herramienta para completar la tarea.

La capacidad de planificación y la capacidad de uso de herramientas son los dos pilares de Manus. La innovación de Manus de incorporar la herramienta de planificación PlanningTool al Marco de Inteligencia Múltiple fue fundamental. Como demuestra el gran avance del modelo Claude-3.7 en la evaluación de la competencia del código SWEBench, las mejoras en el rendimiento se deben en parte a los avances en el propio modelo y en parte a una planificación más eficaz de las tareas, y la investigación previa del equipo MetaGPT en el proyecto Data Interpreter ha demostrado que la planificación es fundamental y eficaz para resolver problemas complejos en el mundo real. La investigación previa del equipo MetaGPT en el proyecto del Intérprete de Datos también ha demostrado que la planificación es fundamental y eficaz para resolver problemas complejos en el mundo real. En consecuencia, la integración de las capacidades de planificación en los marcos multiinteligencia e incluso monointeligencia se ha convertido en una dirección importante en el desarrollo de la tecnología de agentes.

El equipo especula que Manus puede haber utilizado Claude combinado con su propio modelo de post-entrenamiento, y una serie de optimizaciones a nivel de ingeniería, lo que mejora significativamente su capacidad para utilizar la herramienta en diferentes escenarios.

Filosofía de diseño de OpenManus: minimalismo, enchufabilidad y potentes funciones de planificación

El concepto de diseño de OpenManus puede resumirse en dos palabras clave: "minimalista" y "enchufable". Según Liang Xinbing, el concepto inicial de diseño era construir un marco de Agente extremadamente sencillo, mediante la combinación flexible de Herramientas y Avisos enchufables, para realizar las distintas funciones del Agente. A partir de esta idea, el equipo desarrolló rápidamente un mini-marco de Agente completo.

La guía Prompt y el uso de herramientas son factores clave para determinar la eficacia del Agente ReAct. En OpenManus, Prompt se encarga de controlar la lógica de comportamiento general del Agente, mientras que Tools define el espacio de acción del Agente. Ambos trabajan juntos para definir completamente un Agente ReAct. Sobre el Agente ReAct, el equipo de OpenManus ha implementado un Agente ToolCall ligero basado en la tecnología Function Call, que permite seleccionar y ejecutar herramientas de una forma más estructurada. OpenManus se basa en el Agente ToolCall.

El diseño "enchufable" aporta gran flexibilidad y extensibilidad, permitiendo a los desarrolladores combinar Herramientas de diferentes escenarios para crear rápidamente nuevos Agentes. Los desarrolladores pueden crear rápidamente nuevos Agentes combinando libremente Herramientas de diferentes escenarios, y la definición de Herramientas es muy sencilla, no es necesario escribir una compleja lógica interna, basta con modificar el espacio de acción del Agente (Herramientas), y las propias Herramientas deben tener una buena combinabilidad, y OpenManus pretende que la capa de abstracción sea más concisa y clara. Al proporcionar un rico conjunto de herramientas y soportar múltiples Agentes para ser equipados de forma flexible con diferentes combinaciones de herramientas, OpenManus es capaz de ampliar fácilmente sus capacidades en diversos escenarios de aplicación.

Las capacidades de planificación también son fundamentales. OpenManus se basa en los puntos fuertes de planificación de Manus al permitir la descomposición de tareas a través de PlanningTool para abordar con eficacia las complejidades del mundo real.

OpenManus Workflow: tareas dinámicas y ejecución colaborativa

El flujo de trabajo de OpenManus es claro y eficaz. Al recibir una solicitud del usuario, el sistema utiliza primero la PlanningTool para generar un plan con subtareas lineales y escribe el plan en un archivo markdown. A continuación, OpenManus analiza el plan y extrae cada subtarea sucesivamente. A medida que se ejecuta cada subtarea, el sistema asigna dinámicamente la tarea al Agente más adecuado para gestionarla, equipado con un conjunto de herramientas diferentes para gestionar distintos tipos de tareas.

La asignación dinámica de agentes es uno de los aspectos más destacados de OpenManus. Este mecanismo de asignación flexible permite al sistema seleccionar el agente más adecuado para ejecutar la tarea según las necesidades específicas y el contexto de la misma, mejorando así la eficiencia y la calidad del procesamiento de tareas. Actualmente, OpenManus utiliza la correspondencia de expresiones regulares para asignar tareas a los agentes. Si una tarea no puede asignarse a un agente específico, se ejecutará utilizando el agente configurado por defecto.

En el futuro, el equipo de OpenManus también está considerando introducir un Modelo de Lenguaje Grande (LLM) para encargarse de la asignación tarea-agente. Sin embargo, el uso de LLM para el reconocimiento de intenciones y la asignación de agentes para cada ejecución de tareas aumentará sin duda el coste computacional y la latencia.

El futuro de OpenManus: optimización continua y desarrollo comunitario

Para seguir mejorando el rendimiento y la experiencia de usuario de OpenManus, el equipo tiene previsto trabajar en las siguientes prioridades:

- Capacidades de planificación mejoradas: PlanningTool se optimiza continuamente para gestionar escenarios de planificación y descomposición de tareas más complejos.

- Introducción de revisiones normalizadas: los conjuntos de pruebas comparativas del sector, como GAIA/TAU-Bench/SWE-Bench, se utilizan para evaluar y optimizar continuamente el rendimiento de OpenManus.

- Adaptación ampliada de modelos: amplía la compatibilidad de modelos de Claude-3-5 a DeepSeek V2.5 y muchos más modelos para optimizar los escenarios de aplicación de bajo coste.

- Permite la implantación en contenedores: simplifica la instalación y el uso de OpenManus, reduciendo la barrera de entrada para los usuarios.

- Biblioteca de ejemplos enriquecida: se añaden más ejemplos prácticos y análisis en profundidad de éxitos y fracasos para ayudar a los usuarios a comprender y utilizar mejor OpenManus.

- Desarrollo front-end y back-end: desarrollo de una interfaz de usuario web fácil de usar para mejorar la experiencia de interacción del usuario.

- RAG Integración de Módulos: Integrar el módulo Retrieval Augmentation Generation (RAG) para proporcionar al Agente una base de conocimiento externa que mejore sus capacidades de adquisición de conocimiento y razonamiento.

Liang Xinbing dijo que Manus ha hecho un trabajo muy bueno en la interacción con el producto, y hay muchas cosas que aprender de él. En la actualidad, el efecto de OpenManus es aún relativamente limitado, y el equipo no ha llevado a cabo una puesta a punto de efectos especiales.

El objetivo inicial de OpenManus es lograr los mismos resultados que el Manus original. A largo plazo, el equipo espera apoyarse en la gran comunidad de código abierto para optimizar continuamente el Ordenador Capacidades básicas como Uso del ordenador, Uso del navegador y Uso de la planificación, así como capacidades de invocación de herramientas, llevan a OpenManus a niveles superiores de aparición de inteligencia.

02 Equipo MetaGPT: años de precipitación técnica, tres horas para replicar Manus.

Siren Hong: "De hecho, nuestro equipo ha acumulado años de experiencia técnica en el campo de la automatización y los marcos de cuerpos inteligentes para escenarios de IA."

El equipo de MetaGPT lleva mucho tiempo comprometido con la investigación de la tecnología de agentes y el código abierto, y en los últimos dos años ha seguido abriendo los resultados de la investigación del equipo, y ha elaborado artículos académicos e informes técnicos de alta calidad, contribuyendo activamente a la comunidad. Estos resultados incluyen:

- MetaGPT: un marco pionero de metaprogramación multiinteligencia que expone la idea central de la colaboración multiinteligencia.

- Data Interpreter: Un potente agente de ciencia de datos que demuestra el gran potencial de LLM en el campo del análisis de datos.

- AFlow: Un marco automatizado de generación de flujos de trabajo de Agentes que permite la exploración y optimización automática de combinaciones de Agentes.

- HECHO: Tecnología de reescritura del contexto, que mejora eficazmente la precisión de la recuperación de múltiples factores.

- SELA: Un agente LLM mejorado con búsqueda de árboles para el aprendizaje automático de máquinas que mejora significativamente el rendimiento de AutoML.

- Self-Supervised Prompt Optimization: Un método de optimización de avisos autosupervisado que mejora la eficiencia y eficacia de la ingeniería de avisos.

- SPO (https://www.modelscope.cn/studios/AI-ModelScope/SPO): herramienta de código abierto de optimización de palabras clave para escenarios con pocas muestras o sin puntuación explícita.

- Atom of Thoughts for Markov LLM Test-Time Scaling: an Atomic Thinking Approach to Enhance LLM Reasoning in Markov Decision Processes.

El marco MetaGPT: piedra angular de la colaboración multiinteligencia

De código abierto en 2023, el marco MetaGPT fue pionero en el campo de la metaprogramación de cuerpos multiinteligentes, y el equipo de MetaGPT consideró que, si bien los modelos a gran escala de la época habían demostrado una gran potencia para tareas de propósito general, la resolución eficaz de problemas complejos en la sociedad humana seguía requiriendo el desmantelamiento atomístico del problema y la incorporación de un proceso más acorde con los hábitos humanos de resolución de problemas.

"Quizá conozca el concepto de procedimientos operativos estándar (SOP). Asignando SOPs a diferentes roles y aprovechando la experiencia y las capacidades de las herramientas de cada rol, podemos mejorar significativamente el rendimiento de grandes modelos en problemas complejos." El marco MetaGPT se basa en este concepto y propone una arquitectura corporal multiinteligente con SOP integrados, con el objetivo de hacer realidad las capacidades de metaaprendizaje o metaprogramación de las inteligencias", explica Siren Hong.

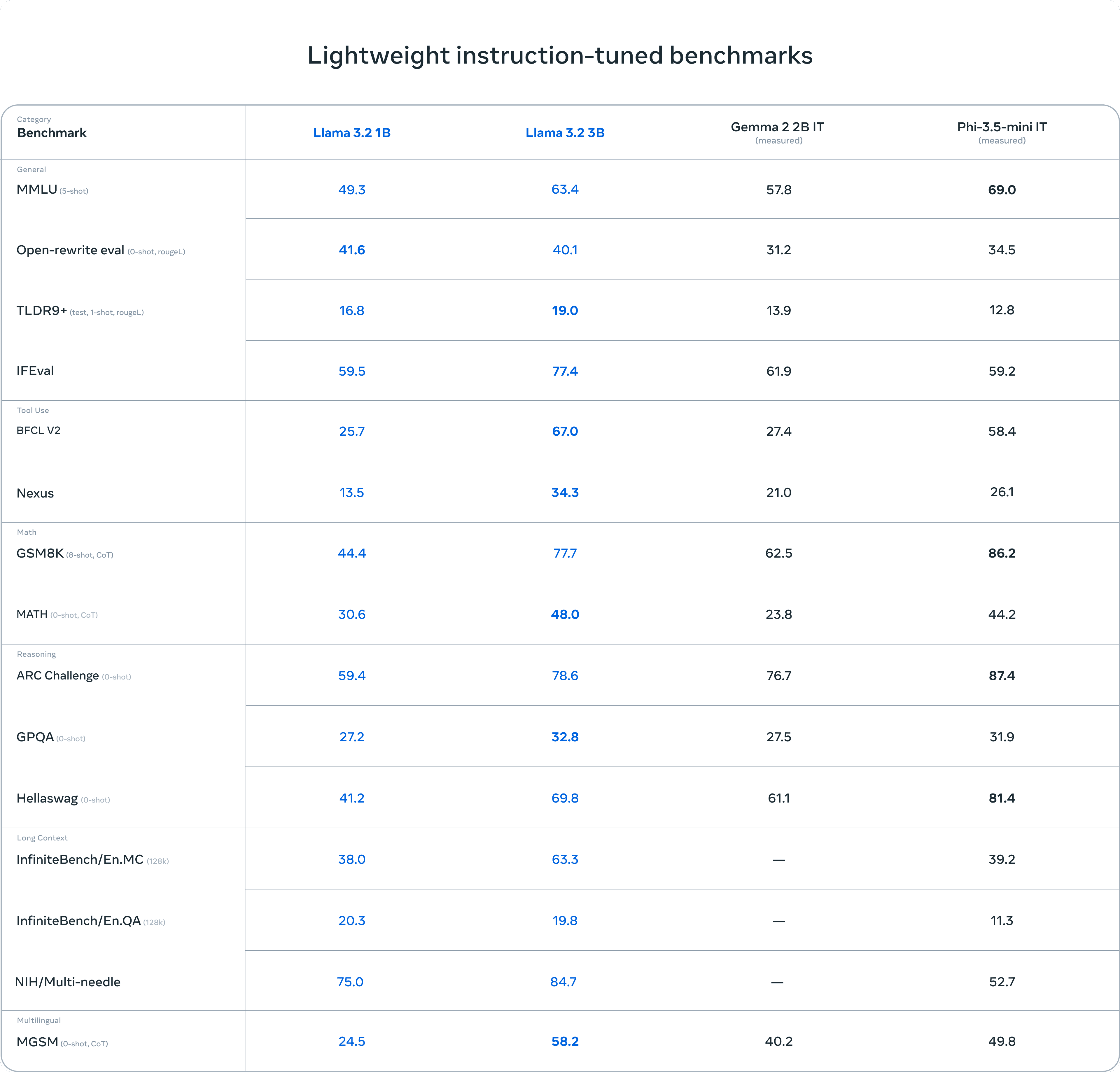

Este enfoque logró mejoras significativas en pruebas de referencia como HumanEval y MBPP, superando al modelo GPT-4 de la época, y el equipo de MetaGPT también validó esta idea en algunos escenarios típicos de desarrollo de software, como el clásico minijuego 2048 y el juego Snake. La tasa de éxito global de MetaGPT es significativamente superior a la de otros marcos de código abierto en el mismo periodo.

Intérprete de datos: un asistente inteligente en la ciencia de datos

Partiendo del marco MetaGPT y del diseño de las inteligencias, el equipo se dio cuenta de que éstas también requerirían capacidades de planificación y uso de herramientas más sólidas, especialmente a la hora de resolver problemas de aprendizaje automático o de modelado de datos.

Por un lado, los procesos de aprendizaje automático/modelado de datos pueden planificarse a menudo con las capacidades de los modelos grandes, que pueden centrarse más en la ejecución e implementación de las tareas. Por otro lado, cuando se trabaja con grandes datos tabulares, no es posible introducir directamente todos los datos debido a la limitación de longitud de contexto de los grandes modelos. Por lo tanto, es necesario que las inteligencias interactúen con los datos a través de formularios de código. Basándose en estas consideraciones, el equipo de MetaGPT comenzó a explorar las capacidades de planificación y uso de herramientas en la segunda mitad de 2023 con la innovación Intérprete de datos.

existe Devin Durante el periodo en el que proyectos como éste atrajeron una amplia atención, el equipo de MetaGPT descubrió que Data Interpreter había alcanzado el nivel de un analista de datos junior en tareas como el modelado de datos/aprendizaje automático. Los usuarios sólo tienen que proporcionar datos a Data Interpreter, y éste puede completar de forma independiente tareas complejas de IA, desde el preprocesamiento de datos hasta el entrenamiento de modelos NLP/CV.

SELA: Mejora de las capacidades de depuración y retroalimentación de los agentes

Para mejorar aún más el rendimiento de Data Interpreter, el equipo de MetaGPT sintió la necesidad de mejorar la capacidad de depuración de las inteligencias y el mecanismo de retroalimentación sobre los resultados de los experimentos. Con este fin, el equipo desarrolló un trabajo denominado "SELA". SELA introduce el método Monte Carlo Tree Search (MCTS) sobre Data Interpreter, que permite al organismo inteligente realizar aprendizaje automático mediante experimentos autónomos optimización de tareas, explorando la diversidad en el proceso de razonamiento y ajustando la estrategia y los pasos de la solución en función de la retroalimentación de los resultados de la ejecución, mejorando así significativamente el rendimiento global de la tarea.

Mejoradas con SELA, las capacidades de Data Interpreter en tareas de aprendizaje automático mejoraron significativamente, alcanzando un nivel comparable al de las herramientas de aprendizaje automático (AutoML) y superando a los mejores proyectos de código abierto del momento (por ejemplo, AIDE).

AFlow: Generación automatizada de flujos de trabajo de agentes

Mientras tanto, el equipo de MetaGPT también exploró en la mejora de la capacidad de razonamiento de grandes modelos basados en la tecnología Monte Carlo Tree Search (MCTS) y desarrolló el trabajo AFlow. A diferencia de las soluciones con SOP fijos, AFlow es capaz de buscar automáticamente el flujo de soluciones más adecuado para diferentes tareas.

La innovación de AFlow es cómo mejorar la solución a diferentes problemas, AFlow tiene como objetivo permitir que el sistema explore la combinación óptima de inteligencias (topología) basada en la retroalimentación del problema, y en última instancia hacer que la combinación de inteligencias para resolver el problema sea más dinámica y sin necesidad de establecer la escala de antemano.

AFlow explora y optimiza la topología combinatoria de inteligencias múltiples definiendo un espacio de búsqueda para la atomización de problemas y utilizando métodos de Monte Carlo. Este trabajo ha obtenido resultados SOTA (State-of-the-art) en los seis conjuntos de datos y ha sido reconocido por el ICLR 2025 como Oral, lo que da fe de su liderazgo tecnológico.

HECHO: Mejora de las capacidades de gestión de memoria del agente

El equipo de MetaGPT también observó que, a medida que aumenta el número de pasos de resolución de problemas de un organismo inteligente, también aumenta el volumen de su Memoria (Memory). Por lo tanto, cómo gestionar eficazmente la información contextual del cuerpo inteligente a lo largo del proceso de resolución de problemas se convierte en una cuestión acuciante.

Para ello, el equipo presenta un trabajo denominado "FACT" que mejora la precisión de los grandes modelos en la búsqueda de hechos mediante un mecanismo de búsqueda multiaguja, y muestra resultados significativos en tareas de preguntas y respuestas (QA). Este trabajo también ha sido aceptado por la NAACL.

Además, hacia septiembre del año pasado, el equipo de MetaGPT también exploró la plataforma de evaluación de capacidades de código SWE-Bench. Descubrieron que, en problemas como la reparación de código, los Agentes necesitan confiar en la localización y búsqueda de archivos, así como en las capacidades de uso del ordenador, al tiempo que plantean mayores exigencias a las capacidades de uso y planificación de herramientas. Muchas investigaciones han utilizado un enfoque multiinteligencia para resolver cadenas tan largas de complejos procesos de razonamiento. En consecuencia, el equipo de MetaGPT también ha añadido y optimizado las capacidades de localización y búsqueda de archivos a las tareas de SWE-Bench, que constituyen la base del código de OpenManus. Un vistazo al código de OpenManus revela que muchas de las herramientas están relacionadas con la reparación y localización de código.

SPO: una potente herramienta para optimizar las palabras clave

SPO es un potente conjunto de herramientas para la optimización de palabras clave. A diferencia de los métodos de optimización tradicionales, que requieren grandes conjuntos de datos, SPO es adecuado para situaciones en las que no se dispone de valoraciones precisas o el conjunto de datos es limitado. Por ejemplo, al redactar textos para Xiaohongshu o realizar optimizaciones SEO, es posible que los usuarios sólo dispongan de un pequeño número de muestras satisfactorias, y SPO es capaz de llevar a cabo una optimización eficaz de las palabras clave en condiciones de muestreo tan limitadas. La herramienta es de código abierto y ha recibido buenas críticas de los usuarios en la plataforma Magic Hitch y Hugging Face en China.

AOT: el pensamiento atómico alimenta el razonamiento informativo

El enfoque AOT (Atomic Thinking) se utiliza principalmente para tareas de razonamiento e integración de información mediante preguntas y respuestas, como la integración de información de distintos pasajes para la comprensión lectora. Este trabajo ha recibido 350.000 visitas hasta la fecha y se integrará en el marco MetaGPT en el futuro para mejorar aún más sus capacidades de procesamiento de la información.

03 El verdadero reto de los agentes: anatomía de diez cuestiones fundamentales

P1: ¿Es posible resolver por completo problemas complejos una vez mejoradas las capacidades de modelización a gran escala?

Siren Hong: "Es cierto que el porcentaje de éxito en la resolución de muchos problemas aumenta a medida que aumentan las capacidades de los modelos más grandes, pero los problemas en sí no desaparecen". Por ejemplo, en problemas relativamente estandarizados de generación de código de una sola función, como QA Q&A, HumanEval y MBPP, un solo modelo es ahora capaz de obtener muy buenos resultados.

Del año pasado a este, la tasa de éxito de los modelos a gran escala en estos problemas se ha acercado al nivel de las aplicaciones del mundo real. Al mismo tiempo, sin embargo, hay que señalar que la sociedad humana sigue teniendo un gran número de problemas extremadamente complejos con efectos de cola larga, como el aprendizaje automático, la corrección de códigos y los problemas que requieren buscar combinaciones de resultados antes de ponerlos a disposición de los usuarios. Estas áreas aún requieren una gran innovación tecnológica para mejorar el rendimiento de los modelos a gran escala, especialmente en la resolución de los problemas de "ilusión" de los modelos.

P2: ¿Qué relación existe entre la mejora de la capacidad de los modelos a gran escala y el avance de la tecnología de agentes?

Xiang Jinyu: "El agente y el modelo a gran escala pueden tener una relación vertical u ortogonal. La mejora del propio marco ganará en funcionalidad gracias a la mejora de la capacidad del modelo, y ambos no están reñidos."

El marco de agentes permite a los grandes modelos interactuar con el mundo físico o el entorno más amplio ampliándolo con más herramientas. Al mismo tiempo, los avances en los grandes modelos mejoran su capacidad de razonamiento y planificación. Ambos pueden utilizarse conjuntamente o desarrollarse de forma independiente.

"La relación es complementaria más que conflictiva". concluyó Xiang Jinyu.

P3. ¿Cuál es el nivel actual de desarrollo del Modelo de Agente Fundador?

Xiang Jinyu: "Recientemente he estado siguiendo algunos trabajos de investigación relacionados, aunque no pertenezcan exactamente a la categoría de Modelo de Agente Fundacional".

Mencionó los intentos realizados por el equipo de Pan Jiayi en el proyecto SWE-GYM, cuyo objetivo es resolver el problema de la reparación del código base. Utilizaron datos generados tras ejecutar modelos basados en Claude o GPT-4o, y recopilaron datos de trayectoria durante el funcionamiento del agente con ayuda de marcos como Openhands. Los datos de trayectoria contienen tanto casos de éxito como de fracaso. Reutilizaron los datos de trayectoria recogidos para entrenar el modelo de código abierto Qwen, y observaron que la capacidad de reparación de código del modelo Qwen mejoraba significativamente tras este entrenamiento. Los detalles del estudio se han elaborado en el artículo y la investigación es sólida y fiable.

"La dificultad actual para generalizar este tipo de trabajo es que, por ejemplo, en la evaluación de SWE-Bench podemos juzgar explícitamente si una tarea se ha completado correctamente, pero en los escenarios de aplicación del mundo real es muy difícil evaluar cuantitativamente la precisión o la calidad de la finalización de una tarea en muchos casos (por ejemplo, escribir una novela o un chiste)". Xiang Jinyu señaló: "Al igual que en los escenarios de trabajo reales, cuando se pide a los becarios y a los empleados senior que completen una tarea al mismo tiempo, es realmente difícil hacer juicios objetivos a la hora de calificar su rendimiento, que debe determinarse basándose en una gran cantidad de lógica y criterios empresariales subjetivos. Este tipo de diseño automático del feedback de evaluación en tareas abiertas es también una dirección importante que debemos explorar en el futuro".

P4. ¿Depende en gran medida el progreso del Agente en capacidades de planificación del propio modelo a gran escala?

Xiang Jinyu: "El progreso actual de la planificación depende, por un lado, de la mejora de las capacidades propias del modelo y, por otro, no puede separarse de la ayuda de estructuras externas, es decir, de la inclusión de estructuras más complejas a nivel del agente para ayudar a la planificación". Por ejemplo, los primeros trabajos sobre el Árbol del Pensamiento (TOT, thinking trees) mejoraron significativamente el rendimiento de los modelos durante el razonamiento de tareas al introducir una estructura adicional. También existen trabajos de investigación similares relacionados con las ayudas externas a la estructura en el ámbito de la planificación.

P5. ¿Qué dificultades plantea la utilización de herramientas externas para el Agente?

Xinbing Liang: "Actualmente en OpenManus, seguimos utilizando principalmente algunas herramientas de código abierto ya existentes, como Cloud Computer y Browser. Las investigaciones de otros equipos sobre el uso de Browser han demostrado que estas dos herramientas por sí solas pueden realizar básicamente muchas tareas, y han formado inicialmente el prototipo de Manus."

Además, sobre la cuestión de "si un agente quiere utilizar una herramienta, pero no existe ninguna", Liang dijo que el equipo también prevé la posibilidad de añadir una capacidad para facultar a un agente a crear sus propias herramientas en el futuro. "Cuando un agente necesite una herramienta para completar una tarea, podrá crearla y utilizarla por sí mismo si no existe una herramienta adecuada en el entorno actual. Esto potenciará aún más al Agente".

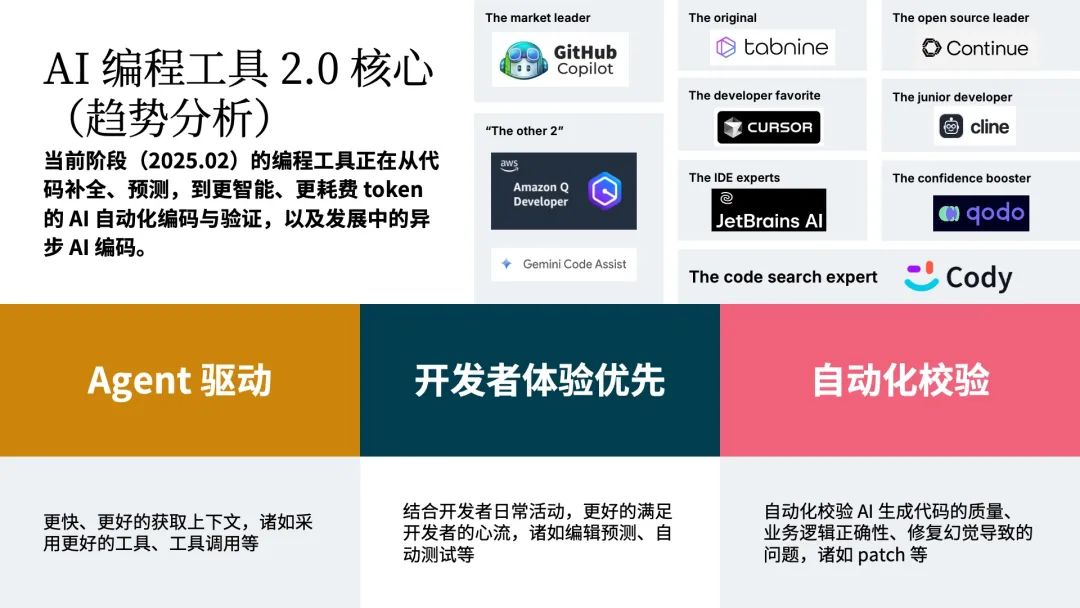

Siren Hong: "Creo que el uso de herramientas para grandes modelos o Agentes no es novedoso en sí mismo. Sin embargo, con el aumento gradual del número de herramientas surgen dificultades técnicas: si hay un gran número de herramientas con funciones similares, ¿cómo puede un Agente tomar decisiones precisas, elegir la herramienta más adecuada y evitar errores de decisión al resolver la misma tarea?".

Además, si en lugar de utilizar una interfaz de herramienta normalizada, se utiliza una herramienta personalizada, puede surgir otro problema: los parámetros de la herramienta no están definidos de forma razonable o clara, lo que hará que los grandes modelos sean propensos a cometer errores al generar decisiones al llamar a la herramienta, lo que a su vez afectará a la eficacia de la aplicación de la herramienta. Estas son cuestiones clave que deben abordarse en la cadena de uso de la herramienta.

"Otra dificultad es que no se trata sólo de la selección y el uso de la herramienta en sí, sino del contexto que puede contener mucha información detallada. Por ejemplo, cuando un usuario abre varias páginas web al mismo tiempo, la información y los datos de estas páginas (por ejemplo, la hora de una determinada CV, la hora de inicio de un evento mencionado en otra página web) pueden ser confusos o incorrectos cuando el Agente los integra para generar el resultado final. Cómo garantizar que el Agente maneje con precisión esta información detallada al utilizar la herramienta es también un problema en el que hay que centrarse en las aplicaciones prácticas". añadió Hong Sirui.

P6. ¿Se generalizará el uso de protocolos como el MCP?

Liang Xinbing: "El protocolo MCP se está generalizando".

En realidad, la capacidad para utilizar la herramienta depende de que el propio modelo tenga una buena capacidad para utilizarla. Dado que algunos modelos pueden no tener la capacidad de utilizar herramientas, o pueden ser débiles en este sentido, su eficacia en el uso de herramientas será limitada. Por lo tanto, la popularidad de los protocolos de uso de herramientas está estrechamente relacionada con la buena capacidad de uso de herramientas de los propios modelos.

P7. ¿Cuáles son algunos de los avances y dificultades para el Agente en la gestión de contextos masivos (Gestión de memoria)?

Siren Hong: "Es posible que a estas alturas ya conozcas algunos trabajos de investigación relacionados, como MemoryGPT o el proyecto de código abierto Mem0, ambos con algunas optimizaciones y tratamientos para contextos más largos y gestión de memoria para Agentes".

Por ejemplo, MemoryGPT resume contextos de cierta longitud, que es una forma muy simple pero eficaz de pensar en ello, y Mem0 utiliza activamente herramientas en el proceso de actualización de la memoria, lo que implica operaciones como la eliminación de memoria, la actualización de memoria y la adición.

"Actualmente, para los Agentes es un problema difícil comprimir el contexto y almacenarlo en la memoria cuando se trata de tareas complejas y de largo alcance (por ejemplo, al navegar por páginas web, que pueden ser muy largas en términos de información) y asegurarse de que la información crítica no se modifica u omite después de la compresión." Siren Hong señala que "algunos de los primeros trabajos han demostrado que la memoria se desvanece con el tiempo o los pasos de la tarea".

Por otra parte, existen varios tipos de memoria humana, no sólo la memoria de información semántica, sino también la memoria procedimental generada por el uso de herramientas, así como la memoria de relaciones asociadas a acontecimientos. Los académicos también han optimizado los distintos tipos de memoria por separado.

La discusión anterior se refiere a la gestión de la memoria en un único Agente. Sin embargo, en un sistema multiinteligente, la memoria puede utilizarse con más habilidad. Además de aislar los recuerdos hasta cierto punto, uno querría reutilizar los recuerdos generados por otros Agentes en el proceso de resolución de problemas para mejorar su propia experiencia en el manejo de tareas específicas. Además, los Agentes pueden evolucionar para reutilizar la experiencia de resolución de problemas del grupo, formando finalmente una especie de inteligencia de grupo.

Xinbing Liang: "El problema central de la gestión de la memoria es el coste". Si no se tiene en cuenta la gestión de la memoria, sin compresión ni procesamiento alguno, y se utiliza directamente la memoria completa, los modelos actuales a gran escala pueden seguir procesándose, pero el problema que esto acarrea no es la degradación del rendimiento, sino que el tiempo de procesamiento y el coste aumentarán significativamente, lo que afecta gravemente a la experiencia del usuario.

El problema de la gestión de la memoria implica, por tanto, una optimización a nivel de ingeniería. Ya hay varias empresas u organizaciones que intentan optimizar las soluciones de gestión de memoria.

"Un enfoque actual para resolver el problema de la gestión de la memoria consiste en utilizar un enfoque de inteligencia múltiple o asistido por herramientas. Por ejemplo, en marcos como OpenManus, un plan de tareas suele generarse primero mediante una herramienta de planificación, que descompone una tarea compleja en múltiples subtareas, con reparto incompleto de memorias entre cada subtarea, y resume o comprime el proceso una vez ejecutada la tarea". explica Liang Xinbing.

P8. ¿Con qué competirá finalmente el Agente en términos de comercialización sobre el terreno?

Siren Hong: "Creo que lo más importante es sacar el máximo partido de las tareas y los efectos en escenarios reales, incluidas las funciones de personalización". Muchos de los esfuerzos de investigación actuales en el mundo académico, ya sea para SWEBench, GAIA u otras tareas de prueba de Agentes, siguen teniendo tasas de éxito de tareas limitadas. Si este estándar de tareas relativamente pequeño se aplica a escenarios empresariales reales, la tasa actual de éxito de los Agentes sigue siendo bastante limitada ante diferentes usuarios y diferentes problemas de dificultad.

"Por lo tanto, tanto si se trata de una tarea de programación como de una tarea de recopilación de datos y generación de informes, si podemos hacerlo lo mejor posible para una amplia variedad de problemas y escenarios de los usuarios, aumentar la tasa de éxito hasta un nivel satisfactorio y darnos cuenta realmente de que el Agente es capaz de realizar las acciones que la gente espera hoy en día, creo que los usuarios seguirán utilizando el Agente como asistente y herramienta en su vida cotidiana". " subrayó Hong Si Rui.

P9. El coste actual de Manus, OpenManus y otros agentes es elevado, ¿cómo podemos seguir reduciendo el coste y mejorando la eficacia?

Siren Hong: "En primer lugar, un gran número de proveedores de aplicaciones, entre los que nos incluimos, optimizan el consumo de tokens. Ya sea a nivel de ingeniería mediante el almacenamiento en caché, o técnicas de compresión de memoria, el objetivo es minimizar la longitud de contexto de cada llamada a la API, y esa es la dirección de la optimización en curso a nivel de aplicación."

"Además, en el futuro, es probable que la gente despliegue un gran número de modelos pequeños para afinar o reforzar el aprendizaje a partir de los datos existentes, centrándose en optimizar la capacidad de uso de determinados nodos o herramientas específicos. Al integrar las capacidades de múltiples modelos pequeños, se espera completar o incluso superar a los modelos grandes. Esto puede suponer importantes ventajas en términos de velocidad de inferencia, consumo de tokens y gastos". añadió Siren Hong.

P10. ¿Cómo podemos evaluar las perspectivas comerciales de la multiinteligencia?

Siren Hong: "En primer lugar, creemos que en el espacio de la generación de código, tanto los sistemas de agente único como los de cuerpo multiinteligente serán comercialmente viables antes".

"Nos hemos dado cuenta de que un gran número de usuarios, que tienen un nivel medio de programación pero entienden algunos conceptos básicos, tienen una gran necesidad de contar con la ayuda de inteligencias o grandes modelos cuando quieren construir un sitio web personal o una aplicación sencilla por su cuenta. Si los usuarios utilizan grandes modelos directamente, pueden necesitar múltiples rondas de interacción y un tedioso proceso de depuración. Pero con un sistema de inteligencias productizado, el proceso es mucho más sencillo. Puede que los usuarios sólo necesiten dedicar 15 minutos o media hora, incluso incluyendo cambios posteriores en los requisitos, para obtener rápidamente un sitio web o una aplicación satisfactorios".

"Por lo tanto, creo que las perspectivas de negocio de la multiinteligentsia son claras y sólidas en lo que se refiere a la resolución realmente eficaz de las necesidades reales de los usuarios, y la generación de código es también un escenario que la tecnología de agentes está actualmente en condiciones de resolver mejor. En la actualidad, la disposición a pagar de los usuarios en este sentido también es relativamente alta". concluyó Hong Sirui.

04 Comercialización de agentes: la generación de códigos toma la delantera

P1. ¿Podría presentarnos brevemente MGX, un producto de inteligencia múltiple?

Siren Hong: "Si conoce MetaGPT, comprenderá la MGX Se trata de un producto en el que múltiples inteligencias colaboran en línea al mismo tiempo para ayudar a los usuarios a resolver problemas. Los usuarios sólo tienen que utilizarlo como ChatGPT En cuanto se introduzca un requisito, una inteligencia poderosa desmontará la tarea y la distribuirá entre distintas inteligencias para que la ejecuten".

"Actualmente, todo el producto se centra en el campo de la generación de código. Por ejemplo, si un usuario quiere crear un sitio web personal, un juego o una aplicación de análisis de datos, etc., nuestro cuerpo inteligente puede hacer muy bien la tarea. Durante el proceso de desarrollo, los usuarios pueden modificar sus requisitos en cualquier momento, como ajustar el estilo, la tipografía o el diseño del proyecto front-end, algo que nuestras inteligencias también son capaces de hacer de forma natural, lo que reduce considerablemente los costes de desarrollo."

A diferencia de productos como Manus y OpenManus, MGX dispone de funciones de despliegue automático. Durante el proceso de desarrollo, el software se despliega automáticamente y los usuarios pueden previsualizar y ajustar los resultados en tiempo real. Además, cada una de las inteligencias del producto MGX dispone de las ya mencionadas llamadas a herramientas informáticas, llamadas a herramientas de navegación y capacidades de planificación y ejecución de código.

"También estamos explorando internamente la evaluación estética de los efectos del diseño o la visualización de datos, y en el futuro es posible que formemos un Benchmark correspondiente para ayudar a los grandes modelos o Agentes a aprender a evaluar si las páginas generadas o los cuadros de mando de datos cumplen las expectativas de los usuarios y los estándares estéticos." reveló Hong Sirui.

A continuación figuran algunos ejemplos de sitios web generados por MGX:

Página web personal:

- https://alex-portfolio-yhx5c3-v1.mgx.world/

- https://photographer-portfolio-myuf2t-v1.mgx.world

Blog personal:

- https://personal-blog-v7amdv-v2.mgx.world

- https://cute-cartoon-blog-p58801-v1.mgx.world

Tarjetas de visita personales:

- https://portfolio-dveerm-v1.mgx.world

- https://emma-anderson-homepage-8rnqm6-v1.mgx.world

P2. ¿Seguirá MGX DEV con nuevos tipos de Agente?

Siren Hong: "MGX seguirá añadiendo nuevos tipos de Agente en el futuro. Actualmente estamos experimentando internamente con un nuevo tipo de inteligencia llamado User Agent". Cuando se despliegue el proyecto de un usuario, es posible que no se ejecute directamente o que tenga defectos, como páginas en blanco, etc. User Agent detectará activamente el efecto de despliegue del proyecto, como tomar capturas de pantalla de la página, interactuar activamente con la página web, comprobar la viabilidad y ejecutabilidad del software generado y, a continuación, avisar a otras inteligencias responsables del desarrollo para que lo arreglen con el fin de completar el proyecto de forma más perfecta. "Además, también podemos precipitar internamente Benchmarks para la evaluación estética de los efectos del diseño o la visualización de datos, lo que permite al Agente determinar si la calidad y el rendimiento estético de una página o un panel de datos cumplen las expectativas". añadió Hong Siren.

© declaración de copyright

El artículo está protegido por derechos de autor y no debe reproducirse sin autorización.

Artículos relacionados

Sin comentarios...