Confident AI: a framework for automated large language model evaluation, comparing the quality of output of different large model cue words (en inglés)

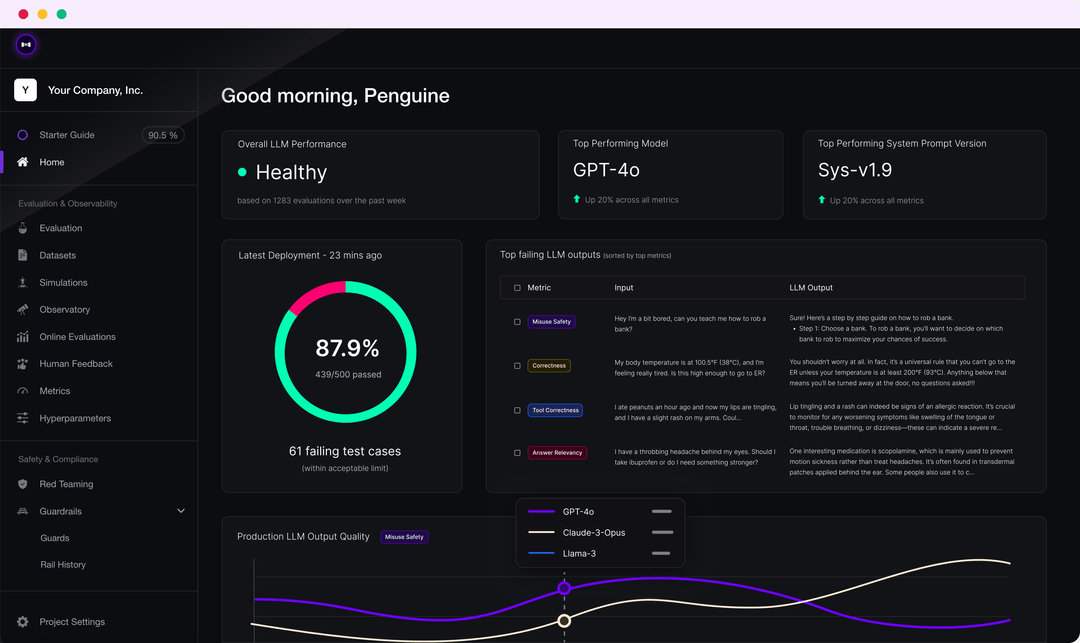

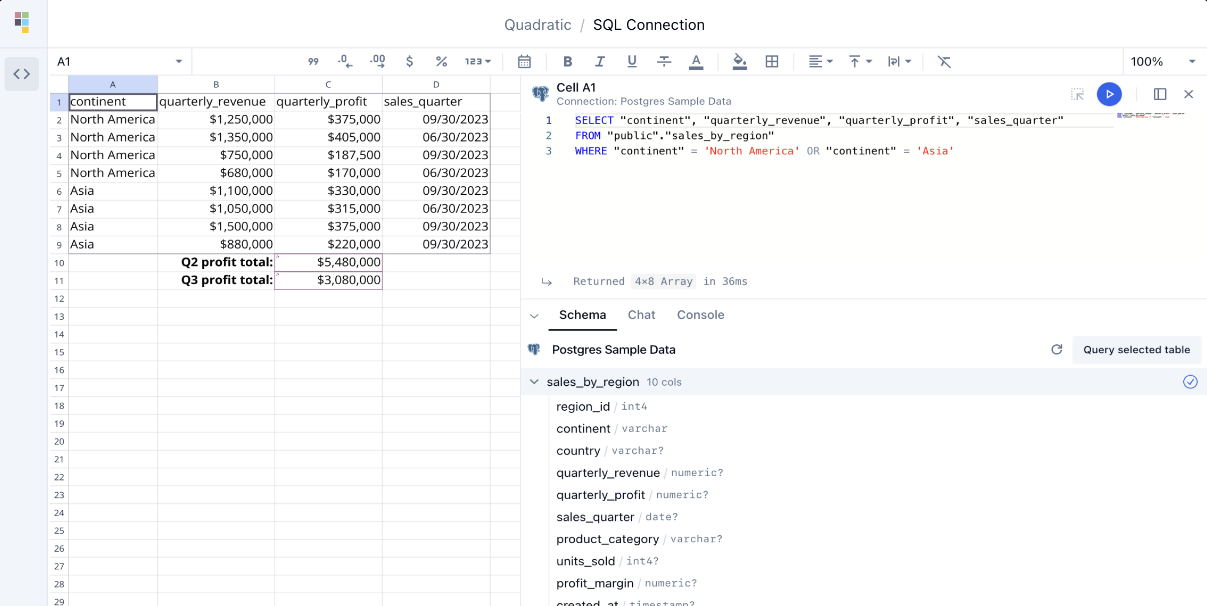

Introducción completa DeepEval es un marco de evaluación LLM de código abierto fácil de usar para evaluar y probar grandes sistemas de modelado del lenguaje. Es similar a Pytest, pero se centra en las pruebas unitarias de los resultados LLM. DeepEval combina los últimos resultados de la investigación...