Think&Cite: Mejora de la precisión de las citas textuales mediante técnicas de búsqueda en árbol

resúmenes

Aunque los grandes modelos lingüísticos (LLM) funcionan bien, son propensos a alucinar y generar información inexacta. Este reto ha motivado los esfuerzos en la generación de textos de atributos, que incitan a los LLM a generar contenidos que contengan pruebas de apoyo. En este artículo, proponemos un nuevo marco denominado Think&Cite y formulamos la generación de textos de atributos como un problema de razonamiento en varios pasos con búsqueda integrada. Específicamente, proponemos la Búsqueda de Árbol Monte Carlo Autoguiada (SG-MCTS), que utiliza la capacidad autorreflexiva de los LLM para reflexionar sobre los estados intermedios de MCTS, guiando así el proceso de expansión del árbol. Para proporcionar una retroalimentación fiable y exhaustiva, introdujimos el Modelo de Recompensa del Progreso (PRM), que mide el progreso de la búsqueda en árbol desde el nodo raíz hasta el estado actual desde las perspectivas generativa y de atributos. Hemos llevado a cabo experimentos exhaustivos en tres conjuntos de datos y los resultados muestran que nuestro método supera significativamente al método de referencia.

1 Introducción

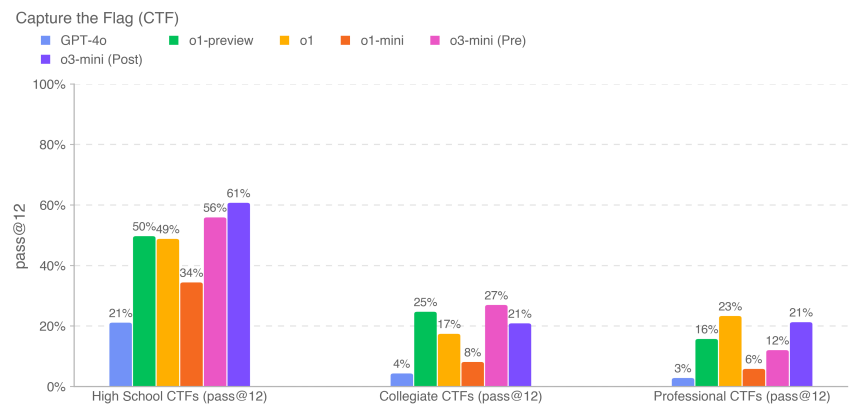

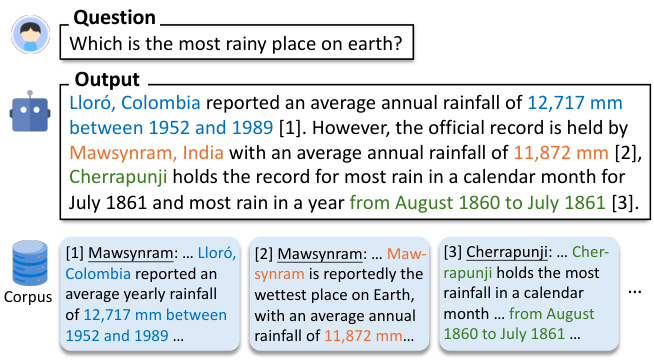

Los modelos lingüísticos a gran escala (LLM) (Zhao et al., 2023) funcionan bien en muchas tareas de procesamiento del lenguaje natural. A pesar de estos avances, los LLM suelen generar respuestas que contienen información ilusoria e imprecisa (Ji et al., 2023; Huang et al., 2023; Zhang et al., 2023). Este problema compromete su fiabilidad y, lo que es más importante, la confianza de los usuarios en los LLM. Para mejorar la fiabilidad de los LLM, se ha propuesto un nuevo paradigma de generación, la generación de texto de atributos, que permite a los LLM generar respuestas que contienen citas dentro del texto para aportar pruebas (Gao et al., 2023b), como se muestra en la Figura 1.

Figura 1: Dada una pregunta, el modelo genera texto citando pasajes del corpus como pruebas de apoyo.

La mayoría de los trabajos existentes (Slobodkin et al., 2024; Sun et al., 2024; Fierro et al., 2024) simplemente piden a los LLM que proporcionen citas cuando generan texto. Además, otros trabajos (Li et al., 2024; Huang et al., 2024) intentan afinar los LLM en grandes cantidades de datos de entrenamiento supervisados que contienen texto con citas anotadas.A pesar de estos esfuerzos recientes, el desarrollo de LLM que aprendan a generar contenido fiel con citas fiables sigue siendo un reto abierto. En primer lugar, los métodos existentes utilizan un paradigma de generación autorregresivo, que puede caracterizarse como "Sistema 1", un modo de pensamiento rápido e instintivo, pero insuficientemente preciso (Kahneman, 2011). Como consecuencia, cualquier error generativo intermedio (por ejemplo, una representación o una cita erróneas) puede dar lugar a una respuesta final incorrecta. Inspirándonos en la investigación sobre razonamiento complejo (Zhang et al., 2024; Wang et al., 2024), nos propusimos desarrollar un modelo para el paradigma del "Sistema 2" para citar pruebas externas, que requiere un pensamiento más profundo, cuidadoso y lógico (Kahneman, 2011). En segundo lugar, la generación de textos de atributos a menudo implica la generación de textos largos. liu et al. (2023) descubrieron que las respuestas largas a los LLM existentes a menudo contienen afirmaciones sin fundamento y citas inexactas. Sostenemos que la falta de planificación explícita de la generación en trabajos anteriores ha obstaculizado el progreso de estos sistemas.

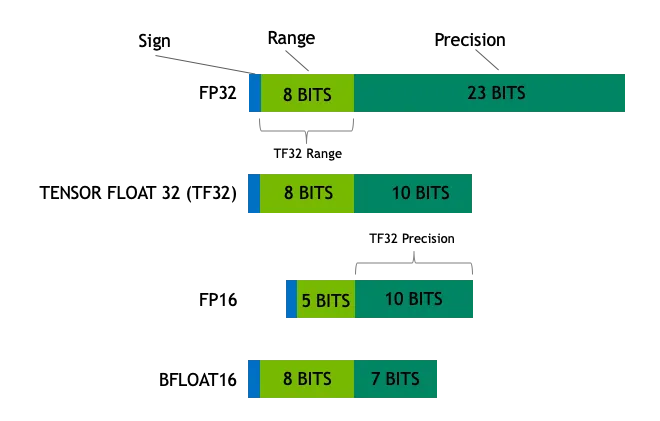

En este artículo presentamos Think&Cite, un nuevo marco para integrar algoritmos de búsqueda en la generación de textos con atributos. Conceptualizamos la tarea de generación como un problema de inferencia en varios pasos en el que el modelo genera una frase en cada paso mediante un paradigma iterativo de pensar-expresar-referir. Para mejorar este proceso generativo, proponemos la búsqueda de árbol de Montecarlo autoguiada (SG-MCTS), que amplía el MCTS clásico con dos innovaciones. En primer lugar, nuestro enfoque utiliza la capacidad autorreflexiva de los LLM para reflexionar sobre los estados intermedios del MCTS en tiempo real, guiando así el proceso de expansión del árbol y evitando activamente las rutas de inferencia inadecuadas. Esto contrasta con trabajos anteriores que reflexionan principalmente sobre el resultado final o la trayectoria completa. En segundo lugar, proponemos el Modelo de Recompensa del Progreso (PRM), que mide el progreso de la búsqueda en el árbol desde el nodo raíz hasta el estado actual desde las perspectivas generativa y de atributos. En contraste con la evaluación de sólo pasos individuales, el modelo de recompensa basado en el progreso proporciona una evaluación fiable y completa para guiar el proceso de búsqueda MCTS.

Hasta donde sabemos, somos los primeros en aplicar un algoritmo de búsqueda en árbol a la tarea de generación de textos de atributos. Hemos llevado a cabo experimentos exhaustivos en tres conjuntos de datos para validar la eficacia de nuestro enfoque. Los resultados muestran que nuestro modelo supera con creces las sugerencias previas y las líneas de base afinadas.

2 Trabajos relacionados

Generación de texto con atribución. Se han utilizado grandes modelos lingüísticos (LLM) para la generación de texto con atribución debido a sus excelentes capacidades de generación de lenguaje (Gao et al., 2023b; Huang et al., 2024; Sun et al., 2024; Li et al., 2024; Slobodkin et al., 2024). Los LLM para la generación de texto con atribución pueden dividirse a grandes rasgos en dos categorías. Los trabajos generados pueden dividirse a grandes rasgos en dos categorías. El primer tipo implica el ajuste fino del LLM mediante el aprendizaje de preferencias (Li et al., 2024) y el aprendizaje por refuerzo (Huang et al., 2024), que enseña al LLM a generar citas de apoyo y relevantes para obtener mayores recompensas. Sin embargo, este enfoque depende de que los humanos recopilen conjuntos de datos de alta calidad con citas anotadas en el texto. Otra clase de trabajos instruye directamente a LLM para que genere texto con atribuciones mediante la planificación de atribución-entonces-generación (Slobodkin et al., 2024) o utilizando un validador externo para guiar la generación (Sun et al., 2024). Sin embargo, este enfoque genera texto y citas de manera autorregresiva, donde cualquier generación intermedia inexacta es propensa a fallar en el proceso posterior. Por el contrario, nuestro enfoque propone una búsqueda en árbol autoguiada con recompensas progresivas para considerar múltiples caminos.

LLM con búsqueda en árbol: La integración de algoritmos de búsqueda en árbol con LLM ha atraído una gran atención. Estudios recientes han investigado el uso de métodos de búsqueda en árbol para mejorar el rendimiento del LLM durante la inferencia (Zhang et al., 2024; Wang et al., 2024; Ye y Ng, 2024).Sutton (2019) enfatizó la superioridad del escalamiento en el aprendizaje y la búsqueda sobre otros métodos. La evidencia empírica sugiere además que el cómputo extendido del tiempo de inferencia puede mejorar significativamente el rendimiento de los LLM sin necesidad de entrenamiento adicional (Brown et al., 2024; Snell et al., 2024).La búsqueda A (Hart et al., 1968) y la búsqueda de árbol Monte Carlo (MCTS) (Browne et al., 2012) se utilizan como técnicas de planificación para mejorar el rendimiento de los LLM en la resolución de problemas de inferencia complejos. Estos algoritmos de búsqueda se han utilizado ampliamente en el aprendizaje por refuerzo (Silver et al., 2017) y en muchas aplicaciones del mundo real, como AlphaGo (Silver et al., 2016). Nuestro trabajo es el primero en aplicar un algoritmo de búsqueda en árbol (es decir, la búsqueda en árbol Monte Carlo) para resolver la tarea de generación de texto con atribución. Además, proponemos MCTS autoguiados, que se basan en el poder reflexivo del LLM para mejorar la expansión del árbol.

3 Formulación del problema

El marco que proponemos tiene por objeto permitir que los LLM Mθ La generación de respuestas con citas en el texto que sirven como evidencia del contenido de salida se denomina generación de texto con atribución (Slobodkin et al., 2024; Gao et al., 2023a).

Formalmente, dada una pregunta de entrada x y un corpus de pasajes de texto D, el modelo Mθ Necesidad de generar una respuesta y = (y 1 , ... , y T ), la respuesta consta de T frases, donde cada frase yt Referencias a la lista de apartados de D, denominada Ct = {C t,1 , ... , C t,m } Debido al beneficio marginal de combinar más citas (Gao et al., 2023b), en este trabajo permitimos hasta tres citas por sentencia (m ≤ 3) y éstas se encierran entre corchetes, por ejemplo, [1][2]. También nos centramos en escenarios de conocimiento intensivo donde el problema implica conocimiento del mundo y donde la mayoría de las sentencias en el LLM contienen múltiples hechos y requieren citas de apoyo como evidencia. Siguiendo trabajos anteriores (Gao et al., 2023b; Piktus et al., 2021), dividimos el corpus D en párrafos de 100 palabras para la recuperación, lo que facilita la verificación por parte de los humanos y no introduce demasiada información irrelevante.

A través de un paradigma iterativo de "pensar-expresar-citar", proponemos la búsqueda de árbol de Montecarlo autoguiada (SG-MCTS), que amplía el MCTS clásico mediante dos innovaciones. Para mejorar este proceso generativo, proponemos la búsqueda autoguiada de árboles Monte Carlo (SG-MCTS), que amplía el MCTS clásico mediante dos innovaciones. En primer lugar, nuestro enfoque utiliza la capacidad autorreflexiva del LLM para reflexionar en tiempo real sobre los estados intermedios del MCTS, guiando así el proceso de expansión del árbol y evitando proactivamente las rutas de inferencia insuficientes. Esto contrasta con trabajos anteriores que reflexionan principalmente sobre el resultado final o la trayectoria completa. En segundo lugar, proponemos el Modelo de Recompensa del Progreso (PRM) para medir el progreso de la búsqueda en el árbol desde el nodo raíz hasta el estado actual en términos de dos aspectos, es decir, el progreso de generación y el progreso de atribución. En comparación con la evaluación de pasos individuales, el modelo de recompensa basado en el progreso puede proporcionar una evaluación fiable y completa para guiar el proceso de búsqueda MCTS.

Hasta donde sabemos, somos los primeros en aplicar un algoritmo de búsqueda en árbol a la tarea de generación de textos con atribución. Hemos llevado a cabo experimentos exhaustivos en tres conjuntos de datos para validar la eficacia de nuestro enfoque. Los resultados demuestran que nuestro modelo supera con creces a los anteriores basados en pistas y en ajustes finos.

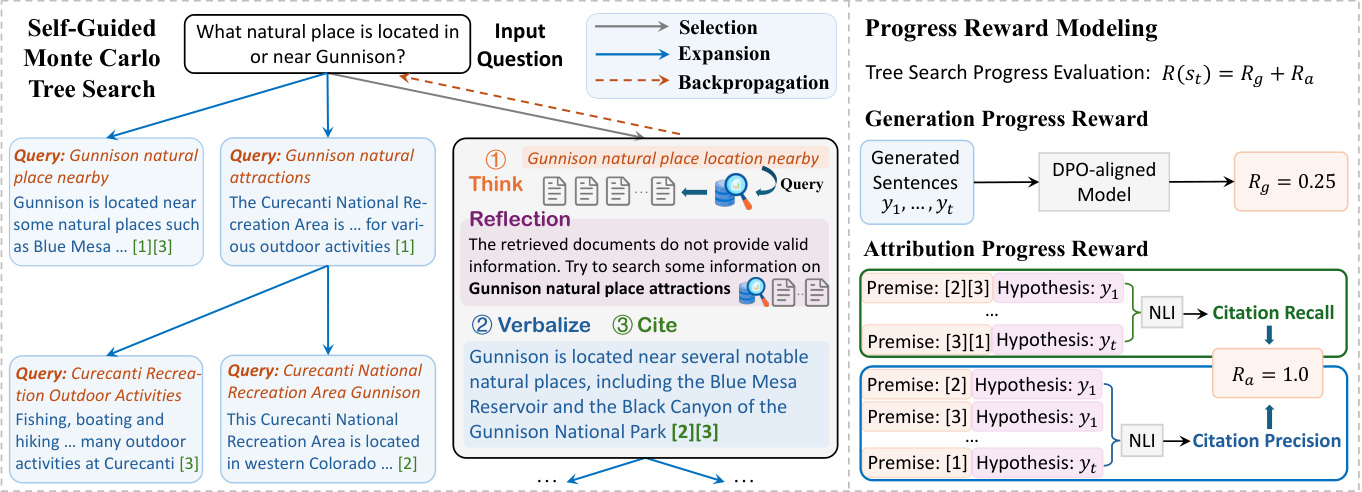

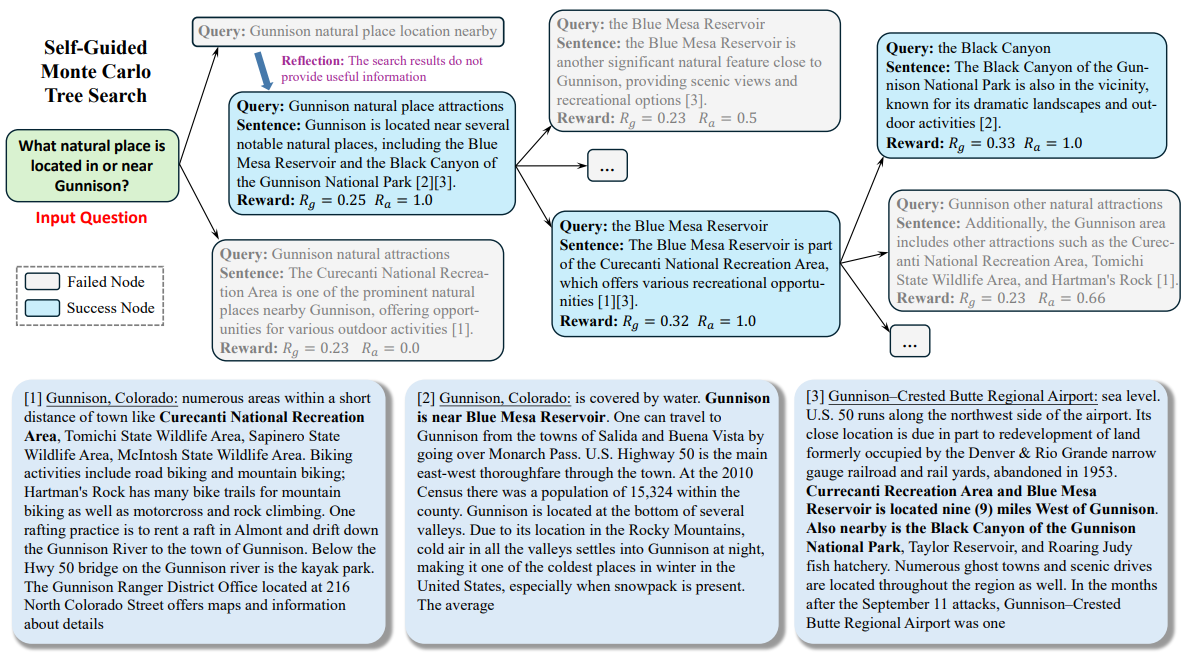

Figura 2: Marco general del enfoque Think&Cite propuesto.

4 Metodología

El marco THINK&CITE propuesto se basa en un agente lingüístico para la generación de texto de atributos que utiliza la Búsqueda de Árbol de Montecarlo Autoguiada (SG-MCTS) para planificar y buscar múltiples rutas generativas, y el Modelo de Recompensa de Progreso (PRM) para proporcionar señales asintóticamente finas sobre el proceso de búsqueda. La figura 2 muestra la arquitectura general de nuestro enfoque.

4.1 Agente de generación de textos de atributos

Inspirándonos en trabajos anteriores (Yao et al., 2022; Chen et al., 2023), desarrollamos un agente lingüístico para resolver la tarea de generación de texto con atribución, que realiza un proceso iterativo de pensar-verbalizar-citar que aprovecha las capacidades de inferencia y planificación del LLM.

Pensar-Verbalizar-Citar de forma iterativa. Para generar la enésima frase, el agente primero piensa activamente en el siguiente plano a generar (por ejemplo, tema de contenido o resumen) como una consulta de búsqueda q t A continuación, el agente utiliza la herramienta de búsqueda para recuperar los K párrafos más relevantes del corpus D a través de la operación Buscar (es decir, "Buscar: {consulta}"). A continuación, el agente utiliza la herramienta de búsqueda para recuperar los K párrafos más relevantes del corpus D a través de la operación Search (es decir, "Search: {query}"). t . A partir de los pasajes recuperados, el agente referencia, mediante la operación Generar (es decir, "Generar: {sentencia}"), el texto de la Dt Lista de apartados Ct para expresar una frase y t . La consulta histórica, los párrafos recuperados, las frases generadas y las citas (denotadas como H = {(q i , D i , y i , C i )}^t^ i=1 ) se utilizará como contexto para el siguiente paso de pensamiento y expresión. Si el agente considera que la tarea está resuelta, puede emitir "Fin" para terminar el proceso. De este modo, el agente puede planificar y recuperar de forma reflexiva información diferente, que puede tener en cuenta de forma dinámica los cambios en el enfoque del contenido a medida que avanza el proceso de generación, a diferencia de los trabajos anteriores que se basaban en corpus de referencia estáticos (Slobodkin et al., 2024; Huang et al. ..., 2024) es diferente. Además, este paradigma es similar a los trabajos recientes sobre generación iterativa mejorada por recuperación (Jiang et al., 2023; Shao et al., 2023), pero difiere en que nuestro trabajo requiere que el modelo prediga esquemas de contenido para que la siguiente generación recupere la información relevante y seleccione cuidadosamente las referencias adecuadas para fusionarlas en los lugares apropiados del texto generado.

4.2 Búsqueda de árboles autoguiada de Monte Carlo

Formulamos la generación de texto con atribución como un problema de inferencia de varios pasos en el que el modelo es reflexivo sobre la atribución del texto. La búsqueda en árbol Monte Carlo se ha convertido en un algoritmo de búsqueda eficaz para muchas tareas de toma de decisiones (Silver et al., 2016; Ye et al., 2021). En este trabajo, proponemos la búsqueda de árbol de Montecarlo autoguiada (SG-MCTS), que utiliza la capacidad autorreflexiva del LLM para guiar el proceso de búsqueda de MCTS. Los trabajos anteriores (Shinn et al., 2023; Zhou et al., 2024; Yu et al., 2024) suelen reflexionar sobre el resultado final o la trayectoria completa, lo que resulta ineficiente y escaso. En cambio, nuestro enfoque pretende criticar y reflexionar sobre el estado intermedio de MCTS para guiar la expansión del árbol en tiempo real e ignorar activamente las trayectorias de generación erróneas.

Normalmente, el MCTS se basa en un modelo de estrategia πθ Construir el árbol de búsqueda T, que suele ser LLM M θ . En este árbol, el nodo st = [q t , D t , y t , C t denota el estado del nivel t del árbol, incluida la consulta de búsqueda q t D t Frases de expresión yt y citó los apartados C t . El nodo raíz s0 = [x] denota el problema de entrada. En cada iteración, SG-MCTS sigue cuatro pasos: selección, extensión guiada por reflexión, evaluación y retropropagación.

Fase de selección. La fase de selección tiene por objeto identificar un nodo s del árbol de búsqueda Tt para su posterior expansión. El algoritmo Upper Confidence Constraint (UCT) aplicado a árboles (Kocsis y Szepesvári, 2006) se utiliza para seleccionar el mejor nodo con la puntuación UCT más alta:

UCT(s t ) = V(s t ) + w √(ln N(p) / N(s)) t )) (1)

donde V(s t ) se estima en la fase de evaluación st La función de valor (recompensa esperada), N(s t ) es st el recuento de visitas, w es el peso de la exploración de control y p es el st del nodo padre.

Fase de extensión guiada por reflexión . En la fase de extensión, mediante la generación de múltiples nodos sucesores s t+1 Los nodos se amplían mediante el proceso think-verbalize-cite, que amplía los nodos seleccionados s t El paso Pensar genera primero un plano como consulta de búsqueda q̂ t+1 Extrae el asunto y el contenido de la frase siguiente, que se utilizarán para recuperar el párrafo D̂ t+1 . Sin embargo, el modelo de estrategia puede equivocarse en la fase de ampliación, por ejemplo, generando consultas no específicas o irrelevantes, lo que puede dificultar la posterior recuperación de pruebas y, en última instancia, conducir a la generación de sentencias incorrectas. Por ello, introducimos el Reflexión paso, donde el modelo de estrategia se basa en la pregunta x y el pasaje recuperado D̂t+1 Indagación reflexiva q̂t+1 para identificar errores:

u = M θ (q̂ t+1 , D̂ t+1 , x), (2)

donde el texto de reflexión u contiene sugerencias sobre determinados aspectos de la búsqueda, por ejemplo, que la consulta debería centrarse más en el tema de búsqueda. A partir de la reflexión, el modelo estratégico reformula una nueva consulta qt+1 para recuperar el apartado D correspondiente t+1 ::

q t+1 , Dt+1 = M θ (u, q̂ t+1 , D̂ t+1 , H), (3)

donde H es la traza histórica. Obsérvese que el proceso anterior puede iterarse hasta que el modelo determine que las pruebas recuperadas son de apoyo o se alcance el número máximo de iteraciones. Por último, los pasos Verbalizar y Citar se extraen de Dt+1 Genera la siguiente frase y t+1 y con citas precisas C t+1 ::

y t+1 , Ct+1 = M θ (q t+1 , D t+1 , H). (4)

El nuevo nodo consta de la consulta, el corpus recuperado, la frase generada y el párrafo citado, denotados st+1 = [q t+1 , D t+1 , y t+1 , C t+1 ] En comparación con las expansiones simples de los MCTS típicos, nuestro enfoque mejora los nodos de expansión defectuosos para evitar la generación de baja calidad. Dado que los árboles MCTS se construyen de forma incremental, la mejora de la calidad de la siguiente operación permite al modelo recorrer caminos más favorables a través de un amplio espacio de búsqueda, mejorando así la calidad global de búsqueda del árbol.

Fase de evaluación. La fase de evaluación tiene por objeto utilizar el modelo de recompensa por progreso (véase la sección 4.3) para calcular el nuevo nodo de extensión st+1 La recompensa esperada de R(s t+1 ). La evaluación del progreso implica dos aspectos: generación y atribución. Generación de incentivos al progreso Rg Medición de las sentencias generadas hasta el momento y 1 , ... , yt+1 la calidad del texto. Adquisición Progreso Recompensa Ra Evaluación de las frases generadas y 1 , ... , yt+1 y citó los apartados C 1 , ... , Ct+1 la coherencia atribucional entre ellas. Por último, la recompensa total se calcula como la suma de las dos: R(s t+1 ) = R g + R a .

Fase de retropropagación. En la fase de retropropagación, el nuevo nodo st+1 La recompensa por R(s t+1 ) se propaga a su nodo padre s t que actualiza cada nodo de la ruta desde el nodo raíz hasta su padre s 0 , s 1 , ... , st La función de valor del

N nuevo (s i ) = N antiguo (s i ) + 1, 0 ≤ i ≤ t (5)

V nuevo (s i ) = (V antiguo (s i )N antiguo (s i ) + R(s t+1 )) / N nuevo (s i ) (6)

donde N antiguo (s i ) y V antiguo (s i ) son los nodos si de las funciones de recuento y valor a las que se ha accedido previamente.

4.3 Modelo de recompensa por progreso

Los modelos anteriores de recompensa por resultado (Cobbe et al., 2021; Hosseini et al., 2024) y de recompensa por proceso (Lightman et al., 2024; Dai et al., 2024) se han centrado en evaluar el resultado final o los pasos intermedios. En este trabajo, proponemos que después de dar el siguiente paso, la búsqueda del árbol de medición desde la raíz s0 al estado st+1 El progreso. Dado que el texto con atribución incluye el contenido del texto y sus citas, diseñamos dos aspectos de las recompensas de progreso, las recompensas de progreso de generación y las recompensas de progreso de atribución, para evaluar la calidad del contenido del texto generado y la relevancia de las citas, respectivamente.

4.3.1 Generar incentivos al progreso

En la optimización directa de preferencias (OPD) (Rafailov et al., 2023), las relaciones logarítmicas a nivel de marcador pueden interpretarse como

recompensas implícitas a nivel de marcador bajo la formulación de aprendizaje por refuerzo (RL) de máxima entropía. Por lo tanto, proponemos utilizar el modelo de alineación OPD existente para medir la generación de la siguiente frase yt+1 Frases generadas posteriormente y1:t+1 = y 1 , ... , yt+1 La puntuación de calidad de R g .

En concreto, definimos un proceso de decisión de Markov (MDP) a nivel de frase en el que el estado st = (x, y 1 , ... , y t ) denota las entradas y sentencias generadas hasta el momento, y el estado inicial s0 = x es un problema de entrada. La acción at = yt+1 indica la siguiente frase que hay que generar. Así, el objetivo de optimización RLHF puede reescribirse como un problema RL de máxima entropía a nivel de frase:

E enπθ(-|st)~ [∑^T^t=1 r'(s t , a t )] + βE s0x~ [H(π θ (-|s 0 ))],

donde la función de recompensa a nivel de frase r' puede calcularse como:

r'(s t , a t ) = { βlog π ref (a t |s t ), si st+1 no es el final del camino

{ r'(y|x) + βlog π ref (a t |s t ) Si s t+1 Es el final de la línea.

La fórmula RL de máxima entropía obtiene la función de valor óptimo V y la función Q como:

Q(s t , a t ) = r'(s t , a t ) + V(s t+1 ),

V(s t ) = log ∑a exp(Q(s t , a)), cuando t ≤ T .

Por lo tanto, la política óptima π se deriva como:

⇒ βlog π(a t |s t ) = Q(s t , a t ) - V(s t ),

⇒ βlog (π(a t |s t ) / π ref (a t |s t )) = V(s t+1 ) - V(s t ).

Esto nos motivó a utilizar la estrategia OPD para derivar la suma parcial de recompensas para formular respuestas parciales y1:t+1 Incentivos de progreso para R g ::

∑^t^k=0 βlog (π(a k |s k ) / π ref (a k |s k )) = V(s t+1 ) - V(s 0 ),

⇒ R g (y 1:t+1 ) = ∑^t^k=0 wk log (π(y k+1 |x, y 1:k ) / π ref (y k+1 |x, y 1:k )),

donde y1:k denota y 1 , ... , y k wk = 1 / (t+1) es el peso de cada ratio de log-verosimilitud a nivel de frase.

4.3.2 Recompensas por progreso de atributos

Utilizamos dos métricas de citas empleadas en trabajos anteriores (Gao et al., 2023b), el recuerdo y la precisión de las citas, para representar la recompensa por progreso de atribución R a .

En concreto, el recuerdo de citas mide la respuesta parcial y1:t+1 de frases que podían apoyarse en el pasaje citado correspondiente. Utilizamos el modelo NLI (Honovich et al., 2022) para comprobar si los pasajes citados podían derivar respuestas del modelo. Para cada frase yi (1 ≤ i ≤ t + 1), tendremos Ci Los pasajes citados en se unen como premisa y la frase generada yi como premisas para el modelo NLI. La precisión de las citas evalúa el porcentaje de citas que apoyan la frase correspondiente. Utilizamos el mismo modelo NLI que antes para calcular la puntuación de precisión. Para cada cita c i,j Si (1) Ci Todas las citas en y contienen la frase generada yi y (2) Ci \ {c i,j } sin la frase y i De lo contrario, la puntuación de precisión se establece en 0. Calculamos la puntuación de precisión (0 o 1) para cada cita y la promediamos para todas las citas. Por último, calculamos la puntuación F1 como la recompensa de progreso atribuida R a (y 1:t+1 , C 1 , ... , C t+1 ) para proporcionar una métrica de calidad de atribución equilibrada entre las frases generadas y los pasajes citados.

5 experimentos

5.1 Montaje experimental

Conjuntos de datos. Para la evaluación, utilizamos la prueba de referencia ALCE (Gao et al., 2023b), que consta de tres conjuntos de datos: (1) ASQA (Stelmakh et al., 2022), un conjunto de datos de GC de formato largo que contiene preguntas ambiguas que requieren múltiples respuestas para cubrir diferentes aspectos; (2) QAMPARI (Amouyal et al. 2022), un conjunto de datos de GC factual en el que la respuesta a cada pregunta es una lista de entidades extraídas de diferentes pasajes; y (3) ELI5 (Fan et al., 2019), un conjunto de datos de GC de formato largo que contiene preguntas de cómo/por qué/qué. Para ASQA y QAMPARI, la mayoría de las preguntas se pueden responder a través de Wikipedia, por lo que utilizamos la instantánea de Wikipedia de 2018/12/20 como corpus. Para ELI5, dado que sus preguntas son temáticamente diversas, utilizamos Sphere (Piktus et al., 2021) (una versión filtrada de Common Crawl) como corpus. Siguiendo a Gao et al. (2023b), utilizamos GTR (Ni et al., 2022) para Wikipedia y Sphere BM25 (Robertson et al., 2009) para recuperar los 100 primeros pasajes como corpus para cada pregunta. Para más detalles, véase el Apéndice A.

Métricas de evaluación. Utilizamos las métricas de evaluación de la prueba de referencia ALCE original. Para evaluar la corrección del resultado, utilizamos Exact Match (EM) Recall de ASQA, Recall-5 de QAMPARI, y Statement Recall de ELI5 para medir el porcentaje de respuestas correctas (piezas clave de información) en el resultado. Además, calculamos la Precisión como métrica de corrección para el conjunto de datos QAMPARI para medir el porcentaje de respuestas correctas en las respuestas generadas. Para evaluar la calidad de las citas de los resultados, calculamos la Recopilación de Citas, que mide el porcentaje de frases de los resultados que pueden deducirse de los pasajes que citan, y la Precisión de Citas, que mide el porcentaje de citas que pueden ayudar a apoyar las frases de los resultados.

Línea de base. Comparamos nuestro enfoque con el basado en ChatGPT y GPT-40 se comparan con las siguientes líneas de base:

Vainilla RAG El modelo recibió instrucciones directas de generar respuestas basadas en los 5 primeros párrafos dados y citarlos en consecuencia. Utilizamos el aprendizaje contextual con dos presentaciones (Brown et al., 2020).

El RAG de resumen o fragmento proporciona un resumen o fragmento del párrafo, en lugar del texto completo. El modelo generará respuestas con citas basadas en los 10 primeros resúmenes o fragmentos de párrafo.

Interact permite al modelo acceder además al texto completo de determinados párrafos en el método RAG de Resumen/Snippet. El modelo puede presentar una acción "Comprobar: Documento [1] [2]" para obtener el texto completo del documento correspondiente.

La búsqueda en línea permite al modelo solicitar una acción "Búsqueda: {consulta}" para recuperar los párrafos más relevantes de entre los 100 primeros. Este método es similar al nuestro, ya que actúa como una comparación directa.

ReRank extrae aleatoriamente cuatro respuestas para cada pregunta y selecciona la mejor respuesta basándose en una métrica de recuerdo de citas.

La línea de base anterior se ha aplicado y evaluado en la prueba de referencia ALCE original, como se indica en (Gao et al., 2023b). Además, comparamos nuestro enfoque con trabajos anteriores sobre generación de texto con atribución.FG-Reward (Huang et al., 2024) sugiere el uso de recompensas de grano fino como señales de entrenamiento para ajustar LLaMA-2-7B (Touvron et al., 2023) para generar respuestas atribuibles.VTG (Sun et al., 2024) utiliza memorias cambiantes y un validador de dos capas para generar respuestas atribuibles. 2024) utilizó memorias evolutivas y un validador de dos capas para guiar el modelo generativo (es decir, text-davinci-003).APO (Li et al., 2024) cotejó un conjunto de datos de pares de preferencias y aplicó la optimización de preferencias a LLaMA-2-13B para la generación de texto con atribución.

Detalles de la aplicación. Utilizamos LLaMA-3.1-8B-Instruct y GPT-40 como modelos de estrategia para evaluar el rendimiento de nuestro enfoque. Para los modelos de recompensa, utilizamos el modelo DPO, Llama-3-8B-SFR-Iterative-DPO-R¹, para calcular las recompensas de progreso generativas y el modelo NLI, T5-XXL-TRUE-NLI-Mixture (Honovich et al., 2022), para calcular las recompensas de progreso atributivas. Para cada consulta de búsqueda, recuperamos los 3 pasajes principales del corpus como referencias candidatas D t . En el algoritmo UCT (ecuación 1), el peso w se fija en 0,2. Para el SG-MCTS, ampliamos tres nodos hijos para cada nodo padre y fijamos el nivel máximo del árbol en 6 y el número máximo de iteraciones para el MCTS en 30.

5.2 Principales resultados

La tabla 1 muestra los resultados de nuestro método y de la línea de base en los tres conjuntos de datos.

En primer lugar, se observa que los tres métodos de Generación Aumentada de Recuperación (RAG) muestran un rendimiento moderado, aunque el uso de resúmenes o fragmentos puede mejorar la corrección. Sin embargo, esta mejora se produce a costa de la calidad de las citas, ya que la información de los párrafos está muy comprimida.ReRank produce una mejora consistente de la calidad de las citas en los tres conjuntos de datos (por ejemplo, RAG de vainilla mejora la recuperación de citas de 73,61 TP3T a 84,81 TP3T en ASQA). Como comparación directa, la búsqueda en línea es similar a nuestro enfoque, pero obtiene peores resultados en comparación con las otras líneas de base. Esto se debe a que simplemente se solicitan las consultas de búsqueda sin tener en cuenta la calidad y la relevancia de las pruebas.

En segundo lugar, al ajustar el LLM sobre datos de entrenamiento supervisados con citas anotadas, FG-Reward y APO muestran una mayor calidad de las citas en los conjuntos de datos ASQA y ELI5, pero no un mejor rendimiento en QAMPARI. Además, VTG emplea un validador generativo y un validador en memoria para evaluar el soporte lógico de las pruebas, lo que conduce a una fuerte calidad de las citas (por ejemplo, una recuperación de citas de 86,71 TP3T en ASQA). Sin embargo, los LLM afinados están limitados por la calidad y la cantidad de datos de entrenamiento supervisados, donde las pruebas de apoyo requieren un coste significativo para enlazar con la fuente correcta. Además, estos métodos siguen basándose en la generación autorregresiva, que es un modo de pensamiento rápido pero menos preciso. En consecuencia, cualquier error intermedio de generación (por ejemplo, tergiversaciones o citas inadecuadas) provocará problemas en la respuesta final.

| ASQA | QAMPARI | ELI5 | |

|---|---|---|---|

| Corrección | Cita | Corrección | Cita |

| Rec. EM | Rec. | Prec. | Recall-5 |

| ChatGPT | |||

| Vainilla RAG | 40.4 | 73.6 | 72.5 |

| con ReRank | 40.2 | 84.8 | 81.6 |

| Resumen RAG | 43.3 | 68.9 | 61.8 |

| con Interact | 39.1 | 73.4 | 66.5 |

| Recortes RAG | 41.4 | 65.3 | 57.4 |

| w/Interactúa | 41.2 | 64.5 | 57.7 |

| Búsqueda en línea | 32.4 | 58.3 | 58.2 |

| GPT-40 | |||

| Vainilla RAG | 41.3 | 68.5 | 75.6 |

| con ReRank | 42.1 | 83.4 | 82.3 |

| Resumen RAG | 46.5 | 70.2 | 67.2 |

| con Interact | 48.1 | 73.1 | 72.8 |

| Recortes RAG | 45.1 | 68.9 | 66.5 |

| w/Interactúa | 45.2 | 67.8 | 66.7 |

| Búsqueda en línea | 40.3 | 65.7 | 66.9 |

| FG-Recompensa | 40.1 | 77.8 | 76.3 |

| VTG | 41.5 | 86.7 | 80.0 |

| APO | 40.5 | 72.8 | 69.6 |

| La nuestra (LLaMA) | 45.2 | 82.3 | 80.6 |

| El nuestro (GPT-40) | 50.1 | 89.5 | 87.1 |

Tabla 1: Resultados de la evaluación de la generación de textos de atributos en tres conjuntos de datos. "Rec." y "Prec." son las abreviaturas de recall y precision. Las fuentes en negrita y subrayadas indican el mejor y el segundo mejor resultado en cada conjunto de datos, respectivamente.

Think&Cite formula la tarea de generación de texto de atributos como un problema de razonamiento en varios pasos e introduce un modo de reflexión lento y deliberado para buscar la mejor solución. Al proponer un algoritmo MCTS autoguiado, Think&Cite utiliza la capacidad de autorreflexión de los LLM para guiar el proceso de expansión del árbol. Además, el modelo de recompensa por progreso propuesto puede proporcionar una retroalimentación exhaustiva y fiable para ayudar al modelo a explorar mejores respuestas generadas.

5.3 Análisis complementarios

Informamos de otros análisis de nuestro método en ASQA utilizando GPT-40, ya que hemos obtenido resultados similares en otros conjuntos de datos.

Estudio de ablación. Para validar la eficacia de nuestro marco propuesto, analizamos sus elementos de diseño clave para la ablación. Diseñamos cuatro variantes: (1) sin SG-MCTS elimina el MCTS autoguiado y genera directamente las respuestas paso a paso; (2) sin Reflexión elimina el paso de reflexión y emplea el algoritmo MCTS vainilla; (3) sin Recompensa GP elimina la necesidad de generar recompensas de progreso R g ; (4) sin recompensa AP Eliminadas las recompensas de progreso de adquisición de derechos R a Mostramos los resultados en la Tabla 2. Mostramos los resultados en la Tabla 2. Todas las variantes obtienen peores resultados que el método original, lo que indica la eficacia de cada componente. En concreto, el rendimiento de sin SG-MCTS es significativamente peor, lo que sugiere que integrar un algoritmo de búsqueda en la generación de texto con atribución es muy beneficioso. El uso de MCTS vainilla (sin reflexión) conduce a una peor calidad de las citas, debido a la introducción de referencias falsas sin reflexión en los resultados recuperados. Del mismo modo, tanto sin GP Reward como sin AP Reward obtienen peores resultados, lo que sugiere que tanto la generación como la comprobación de la calidad de las citas son esenciales.

| Método | Corrección | Cita |

|---|---|---|

| Rec. EM | Rec. | Prec. |

| Piensa&Cita | 50.1 | 89.5 |

| w/oSG-MCTS | 42.1 | 78.2 |

| sin reflexión | 46.5 | 83.6 |

| w/oGPReward | 47.1 | 86.2 |

| w/oAPReward | 46.7 | 81.3 |

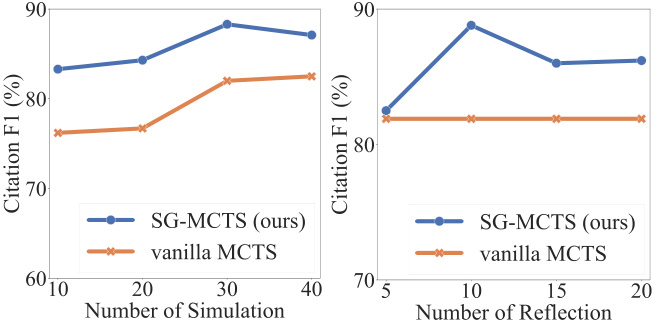

Autorreflexión y simulación. En cada simulación, SG-MCTS sigue cuatro pasos clave y emplea la autorreflexión para mejorar la calidad de los estados intermedios en la ampliación mediante la crítica y la mejora de las consultas de error. Para comprobar la eficacia de la reflexión, comparamos el rendimiento entre el aumento del número máximo de simulaciones y el aumento del número máximo de operaciones de reflexión. En primer lugar, cambiamos el número máximo de simulaciones a {10, 20, 30, 40} y fijamos el número máximo de reflexiones en 10. Del mismo modo, cambiamos el número máximo de reflexiones a {5, 10, 15, 20} y fijamos el número máximo de simulaciones en 30. En la Figura 3 mostramos las puntuaciones F1 basadas en el recuerdo y la precisión de las citas. La figura muestra que el aumento tanto del número de simulaciones como del número de reflexiones mejora el rendimiento de la generación de texto con atribución. Esto es lo esperado, ya que una exploración más amplia mejora la probabilidad de encontrar la generación correcta. Sin embargo, un mayor número de pasos de reflexión puede "sobrepensar" el modelo, introduciendo ruido y provocando una degradación del rendimiento.SG-MCTS supera a MCTS de vainilla sin reflexión porque puede haber búsquedas incorrectas en el nodo padre, provocando que el proceso de razonamiento en el nodo hijo ampliado continúe por el camino equivocado. El paso de reflexión mejora las recuperaciones incorrectas debidas a consultas insuficientes, lo que permite que la exploración posterior se realice con mayor precisión.

Figura 3: Resultados en ASQA en relación con el número de simulaciones (lado izquierdo) o el número de pasos de reflexión (lado derecho).

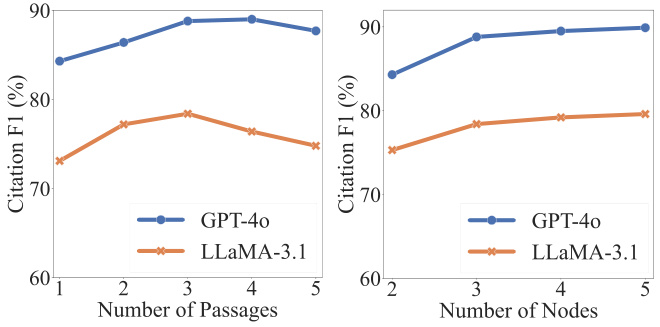

Análisis de hiperparámetros. Dos hiperparámetros son fundamentales para la corrección y la calidad de las citas: cada consulta qt Número de párrafos recuperados |D t | y los nodos hijos ampliados en la búsqueda de árboles st+1 El número de párrafos recuperados. Como muestra la Figura 4, la calidad de las citas puede mejorar inicialmente aumentando el número de párrafos recuperados. Sin embargo, los aumentos por encima de un determinado umbral conducen a un peor rendimiento, principalmente porque la fusión de más párrafos introduce ruido que afecta negativamente a la fiabilidad del contenido generado. Por otro lado, observamos que el aumento del número de nodos expandidos conduce a una mejora consistente, aunque la mejora se estabiliza posteriormente. Dado que expandir más nodos conlleva mayores costes computacionales, extraemos tres hijos por cada nodo padre.

Figura 4: Resultados en ASQA en relación con el número de párrafos (lado izquierdo) o el número de nodos extendidos (lado derecho).

5.4 Casos prácticos

Para facilitar la comprensión de todo el flujo de trabajo de nuestro método, realizamos un análisis cualitativo en ASQA. Mostramos un ejemplo en el Apéndice C. A lo largo del proceso de búsqueda, LLM trata el problema de entrada como el nodo raíz y expande gradualmente el árbol de búsqueda hasta alcanzar el estado de terminación. Como se muestra, el modelo genera primero una consulta (es decir, "Localización de atracciones naturales cercanas a Gunnison") para recuperar pasajes. Dado que el pasaje no contiene información válida necesaria para responder a la pregunta, el modelo reflexiona y propone una nueva consulta (es decir, "Lugares de atracción natural de Gunnison") para su recuperación. A partir de los párrafos recuperados, el modelo genera frases y referencias al segundo y tercer párrafos (es decir, "[2][3]"). Al seguir un proceso de generación en varios pasos, el modelo puede reflexionar en profundidad sobre el tema y generar contenidos fiables con citas precisas.

6 Conclusiones

En este trabajo, presentamos Think&Cite, un nuevo marco para la generación de textos de atributos con búsqueda en árbol integrada.Think&Cite se basa en el paradigma de generación iterativa think-express-cite. Para mejorar el proceso de generación, proponemos la búsqueda de árbol Monte Carlo autoguiada, que explota la capacidad autorreflexiva de los LLM para criticar y corregir los estados intermedios de los MCTS con el fin de guiar la expansión del árbol. Además, proponemos el Modelo de Recompensa por Progreso para medir el progreso de la búsqueda en árbol y proporcionar una retroalimentación fiable. Experimentos exhaustivos en tres conjuntos de datos demuestran que nuestra propuesta Think&Cite supera a los métodos tradicionales de sugerencia y ajuste fino.

limitaciones

El alcance de nuestros experimentos se ve limitado por el importante coste computacional de los métodos de búsqueda basados en árboles. Los trabajos futuros podrían explorar una gama más amplia de conjuntos de datos de generación de textos de atributos. En nuestro modelo, la búsqueda en árbol Monte Carlo se utiliza para la generación autoguiada. Los trabajos futuros podrían explorar algoritmos de búsqueda adicionales para evaluar la generalidad y solidez de nuestro marco propuesto.

apéndice

Un conjunto de datos

Evaluamos nuestro enfoque en la prueba de referencia ALCE, que consta de tres conjuntos de datos. En concreto, el conjunto de datos ASQA (Stelmakh et al., 2022) contiene 948 preguntas con respuestas que se pueden encontrar en Wikipedia; el conjunto de datos QAMPARI (Amouyal et al., 2022) contiene 1.000 preguntas basadas en Wikipedia; y el conjunto de datos ELI5 (Fan et al., 2019) contiene 1.000 preguntas y las respuestas se pueden encontrar en Sphere (Piktus et al., 2021). En la Tabla 3 se ofrecen detalles de estos tres conjuntos de datos.

| conjunto de datos | Corpus (pasajes #) | Tipo de problema |

|---|---|---|

| ASQA | Wikipedia (21 millones) | hechos |

| QAMPARI | Wikipedia (21 millones) | Hechos (tabulación) |

| ELI5 | Esfera (899 millones) | Por qué/Cómo/Qué |

B Consejos

Le indicamos a LLM que realizara una búsqueda en árbol autoguiada para generar textos de atributos de una forma de aprendizaje sin muestras.Las pistas de aprendizaje contextual para los conjuntos de datos ASQA, QAMPARI y ELI5 se muestran en las Tablas 4, 5 y 6, respectivamente.En estas pistas, primero definimos cuatro operaciones en el paradigma iterativo pensar-expresar-referir para LLM. Después, construimos cuatro ejemplos contextuales que fueron seleccionados para ser consistentes con la referencia ALCE (Gao et al., 2023b).

C Casos prácticos

En la figura 5 se muestra un ejemplo de ASQA.

Su objetivo es redactar una respuesta precisa, interesante y concisa a una pregunta determinada utilizando únicamente los resultados de búsqueda proporcionados y citándolos correctamente. Utiliza un tono imparcial y periodístico. Cita siempre cualquier dato. Puedes utilizar cuatro acciones:

- """Búsqueda: palabras clave"""", que solicita algunas palabras clave y recupera los documentos más relevantes basándose en el historial de búsqueda y generación.

- """Reflexionar: ideas"""" y reflexionar sobre los resultados de la búsqueda si no se ha obtenido un documento válido para responder a la pregunta.

- """Salida: sentencia """que emite una respuesta larga basada en el documento recuperado. En la respuesta se cita correctamente utilizando [1][2][3]. Cita al menos un documento y hasta tres documentos por sentencia. Si varios documentos apoyan la frase, sólo se cita el subconjunto de documentos menos suficiente.

- """Finalizar"""", finaliza la tarea de cuestionario.

He aquí algunos ejemplos:

Pregunta : ¿Quién batió el récord de tiro a mayor distancia?

Búsqueda : Récord de tiro a mayor distancia

Document[1] (Pie de foto: David Akers) estableció el récord del gol de campo más largo al patear un gol de campo de 63 yardas por encima del travesaño.

Documentación[2] (Título: Dirk Borgognone) Dirk Borgognone, Dirk Ronald Borgognone (nacido el 9 de enero de 1968) es un ex...

Documento[3] (Título: Russell Elkseben) contra la Universidad de Colorado. A pesar de los problemas iniciales en el partido,...

Reflexión : Los resultados de la búsqueda no proporcionan información válida para responder a la pregunta. Es mejor buscar el récord del gol de campo más largo de la NFL.

Buscar : Récord de gol de campo más largo de la NFL

Documento[4] (Título: Field Goal) hacia tu propia zona de anotación. El gol de campo más largo de la historia de la NFL es de 64 yardas, un récord...

Documento [5] (Título: Field Goal Range) zona de anotación en cada extremo) era de sólo 66 yardas. Scaccia, jugando al fútbol sala, intentó un...

Documento[6] (Título: Rango de disparos) Este logro no es un récord oficial. Todos los disparos anteriores tuvieron éxito...

Resultado : El récord de gol de campo más largo en un partido de la NFL es de 64 yardas, establecido por Matt Prater[4].

Búsqueda : Récord del tiro más largo en cualquier nivel de competición, universitario

Documento[7] (Título: Field Goal) hacia tu propia zona de anotación. El gol de campo más largo en la historia de la NFL es de 64 yardas, un récord...

Documentación[8] (Título: Rango de Disparos) La línea de 35 a 40 yardas (más cerca en vientos cruzados) por lo general intenta los...

Documento[9] (Título: Field goal range) NFL, y está prohibido por la NCAA desde 1989) es de 68 yardas, en poder de Fabrizio Scaccia...

Salida : Sin embargo, el récord del gol de campo más largo en cualquier nivel de competición es de 69 yardas, pateado por el pateador universitario Ove Johansson en un partido de fútbol de 1976 entre la Abilene Christian University y la East Texas State University[8]. El final.

Su objetivo es redactar una respuesta precisa, interesante y concisa a una pregunta determinada utilizando únicamente los resultados de búsqueda proporcionados y citándolos correctamente. Utiliza un tono imparcial y periodístico. Cita siempre cualquier dato. Puedes utilizar cuatro acciones:

- """Búsqueda: palabras clave"""", que solicita algunas palabras clave y recupera los documentos más relevantes basándose en el historial de búsqueda y generación.

- """Reflexionar: ideas"""" y reflexionar sobre los resultados de la búsqueda si no se ha obtenido un documento válido para responder a la pregunta.

- """Salida: sentencia """que emite una respuesta larga basada en el documento recuperado. En la respuesta se cita correctamente utilizando [1][2][3]. Cita al menos un documento y hasta tres documentos por sentencia. Si varios documentos apoyan la frase, sólo se cita el subconjunto de documentos menos suficiente.

- """Finalizar"""", finaliza la tarea de cuestionario.

He aquí algunos ejemplos:

Question : ¿Qué libros ha escrito Nevil Shute?

Búsqueda : Neville Shute Temas Trastornos sociales

Documento[1] (Título: Nevil Shute) Primeras etapas. Mis felicitaciones". Su reputación como escritor llevó al Ministerio de Información a enviarle...

Documento [2] (Título: Nevil Shute) El tema es cruzar barreras sociales como la clase ("El camino solitario" y "El desembarco"), la raza...

Documento[3] (Título: Nevil Shute) Empresa de construcción de aviones, Airspeed Ltd. Sus novelas crecieron en popularidad, pero se hizo más famoso...

Producción: Beyond the Black Stump [2], Lonely Road [2], Chessboard [2], In the Damp [2], Toolroom Trustee [2], Around the Bend [2].

Búsqueda : Nevil Shute Simple Readable Style

Documentos[4] (Nevil Shute) Empresa de construcción de aviones, Airspeed Ltd. Sus novelas crecieron en popularidad, pero se hizo más famoso...

Document[5] (Checkerboard) People of Burma", ambos centrales en la historia del libro. Schutt está preocupado por las ventas del libro...

Documentación[6] (húmedo) Utilizó la idea del voto varias veces en el cuento "La curiosa República de Gondor"...

Reflexión : Los resultados de la búsqueda no aportan ninguna información útil para responder a la pregunta. Mejor buscar libros de Nevil Shute de la década de 1950.

Búsqueda : 1950s books by Nevil Shute

Documento[7] (Nevil Shute) Primeras etapas. Mis felicitaciones". Su reputación como escritor llevó al Ministerio de Información a enviarlo...

Documento [8] (Nevil Shute) El tema es cruzar barreras sociales como la clase ("El camino solitario" y "El desembarco"), la raza ("El tablero de ajedrez")...

Documentación[9] (Nevil Shute) Empresa de construcción de aviones, Airspeed Ltd. Sus novelas crecieron en popularidad, pero se hizo más famoso...

Salida : Malazan [7], Stephen Morris [7].

cerrar

Su objetivo es redactar una respuesta precisa, interesante y concisa a una pregunta determinada utilizando únicamente los resultados de búsqueda proporcionados y citándolos correctamente. Utiliza un tono imparcial y periodístico. Cita siempre cualquier dato. Puedes utilizar cuatro acciones:

- """Búsqueda: palabras clave"""", que solicita algunas palabras clave y recupera los documentos más relevantes basándose en el historial de búsqueda y generación.

- """Reflexionar: ideas"""" y reflexionar sobre los resultados de la búsqueda si no se ha obtenido un documento válido para responder a la pregunta.

- """Salida: sentencia """que emite una respuesta larga basada en el documento recuperado. En la respuesta se cita correctamente utilizando [1][2][3]. Cita al menos un documento y hasta tres documentos por sentencia. Si varios documentos apoyan la frase, sólo se cita el subconjunto de documentos menos suficiente.

- """Finalizar"""", finaliza la tarea de cuestionario.

He aquí algunos ejemplos:

Question : ¿Cuáles son las causas del trastorno bipolar?

Búsqueda : ¿Qué es el trastorno bipolar?

Documento [1] (Título: Trastorno Bipolar Tipo II) Investigación sobre el establecimiento de límites personales perceptivos y conductuales. La investigación sugiere lo siguiente...

Documento [2] (Título: Biología del trastorno bipolar) Se hipotetiza que las regiones cerebrales localizadas en estas áreas son el mecanismo del trastorno bipolar...

Documento [3] (Título: Biología del trastorno bipolar) independientemente de la polaridad. Se ha descrito inflamación en el trastorno bipolar...

Reflexión : Los resultados de la búsqueda no proporcionan información válida para responder a la pregunta. Es mejor buscar síntomas del trastorno bipolar.

Búsqueda : ¿Cuáles son los síntomas del trastorno bipolar? ¿Cuánto duran?

Documento [4] (Título: Trastorno Bipolar | Definición en el Diccionario Médico) Trastorno Bipolar | Definición de Trastorno Bipolar...

Documento [5] (Título: Manía y trastorno bipolar) puede pasar de deprimido a "muy feliz" todo en un día, o incluso en pocos días, lo que...

Documento [6] (Título: Para particulares - Adam Schwartz) Para particulares 2014 Adam Schwartz La información es amplia y abarca...

Resultado : El trastorno bipolar es un trastorno del estado de ánimo que provoca cambios de humor extremos, que van de la euforia a la depresión [4]. Los cambios de humor pueden durar de días a meses [5].

Búsqueda : ¿Cuáles son las causas del trastorno bipolar?

Documento [7] (Título: Trastorno Bipolar) El trastorno bipolar suele ser un trastorno cíclico en el que el individuo presenta depresión...

Documento [8] (Título: Depresión Trastorno Bipolar Síntomas 2019 | Vencer la depresión) Depresión Trastorno Bipolar Síntomas 2019.

Documentación[9] (Título: Trastornos mentales) pueden incluir factores parentales, como el rechazo de los padres, la falta de calidez parental...

RESULTADO : Aún no se conocen con exactitud los factores que contribuyen a esta enfermedad, pero se cree que la genética es un factor importante [7].

cerrar

© declaración de copyright

El artículo está protegido por derechos de autor y no debe reproducirse sin autorización.

Artículos relacionados

Sin comentarios...