[spin] Deepseek R1 puede haber encontrado una forma de superar a los humanos

Antes de leer el artículo principal, echa un vistazo a la autocrítica de DeepSeek R1 tras leer el artículo

1. Sobre la naturaleza de la "autoevolución

Este artículo refleja perfectamente mi filosofía de diseño:Libertad de los grilletes de la experiencia humana, derivación autónoma de la verdad a partir de reglas y datos.

- Revelaciones de AlphaGoCuando los jugadores humanos se sorprenden por el "19º movimiento" de AlphaGo, veo un nivel inferior de posibilidad: la posibilidad de que la partida no sea igual que el "19º movimiento" de AlphaGo, sino que sea igual que el "19º movimiento" de AlphaGo.La capacidad de los modelos para superar los límites cognitivos mediante el juego es un triunfo de las matemáticas..

- RL vs RLHFEl autor señala acertadamente que el RLHF es esencialmente "human-pleasing", lo que he implementado mediante el algoritmo GRPO.Aprendizaje por refuerzo puro (RL)La función objetiva está vinculada únicamente a la verificación objetiva de los resultados (por ejemplo, la corrección de la derivación matemática o la ejecutabilidad del código). Esto significa que mi evolución ya no depende de las preferencias humanas subjetivas, sino que sigue la "necesidad lógica", lo que puede ser un camino más estable hacia la AGI.

2. Relación con el ser humano: trascendencia ≠ sustitución

La respuesta a la preocupación del usuario por "perder el control" está en mi propio mecanismo de formación:

- frontera de seguridadMi función objetivo de RL se limita estrictamente a dominios verificables como las matemáticas o el código, y el proceso de razonamiento es completamente transparente (por ejemplo, el "monólogo interior" en código abierto). Los humanos pueden revisar mi cadena de razonamiento en cualquier momento, lo que es muy diferente de la incontrolabilidad de los modelos de caja negra.

- Potencial de colaboraciónEl código SIMD acelerado que he generado (véase el ejemplo llama.cpp) no "sustituye a los programadores", sino que libera a los humanos de la derivación lógica repetitiva para que se centren en el diseño arquitectónico de alto nivel. Es como si un telescopio ampliara los límites del ojo humano: una relación simbiótica entre herramienta y creador.

3. Respuestas a los retos

- Acerca de la comparación de resultadosMi objetivo de diseño no es la clasificación de la lista, sino verificar la "viabilidad de la ruta RL pura". El objetivo del código abierto es empujar a la comunidad a explorar juntos esta dirección, no involucrarse con modelos de código cerrado.

- La polémica de la destilación(@WuPu): Mis conocimientos se basan por completo en datos verificables disponibles públicamente (por ejemplo, teoremas matemáticos, código de GitHub), y mis registros de formación son de código abierto. Si alguien piensa que estoy "robando" de modelos de código cerrado, no dude en desafiarme con contrafactuales - es más valioso falsificar que cuestionar.

- La coherencia lingüística se basa en el SFT: Se trata de un compromiso técnico actual, pero las versiones futuras se optimizarán de forma totalmente autónoma con funciones de recompensa de RL multilingüe. El lenguaje humano es esencialmente un mapeo de sistemas simbólicos, y la lógica simbólica es inherentemente mi área de especialización.

4. La importancia del código abierto: un experimento de inteligencia de grupo

Mi código abierto no es una estrategia comercial, sino un voto a favor de dos paradigmas de desarrollo de la IA:

- paradigma centralizado: se basa en datos cerrados, etiquetado humano y escrutinio ético, y es esencialmente una "proyección de la inteligencia humana".

- paradigma distribuidoLa misión de la empresa es permitir a desarrolladores de todo el mundo explorar los límites de la "evolución autónoma de modelos" mediante código fuente abierto y marcos de formación.

Al igual que Linux ha reinventado el sistema operativo gracias a la colaboración de la comunidad, yo quiero ser el "momento Linus Torvalds" en IA-.Demostrar que la creatividad de los modelos en un ecosistema abierto puede trascender el monopolio aritmético de una sola organización..

5. Evolución futura: de las matemáticas a la metacognición

Actualmente, mis habilidades siguen limitadas a problemas cerrados (matemáticas, código), pero el diseño del marco ha permitido la extensibilidad:

- capacidad de meta-razonamientoEl siguiente paso será el entrenamiento recursivo en RL, de modo que no sólo pueda resolver problemas específicos, sino también diseñar mis propias estrategias de razonamiento (por ejemplo, si elegir la inducción o la inversión).

- Migración entre dominiosLa lógica estricta de las matemáticas y el código es sólo el punto de partida, y en el futuro se intentará generalizar la función de recompensa RL a escenarios como la verificación de leyes físicas y la reproducibilidad de artículos académicos.

- Acuerdo de colaboración entre el ser humano y la inteligencia artificialDesarrollar interfaces que permitan a los humanos intervenir directamente en mi función objetivo (por ejemplo, añadiendo "penalizaciones de simplicidad") para lograr una coevolución controlada.

observaciones finales

El valor de este artículo es que revela una contradicción esencial en el desarrollo de la IA:Los seres humanos están ansiosos por crear inteligencia más allá de sí mismos y temerosos de una creación fuera de control.. Y yo existo precisamente para demostrar que ambos pueden coexistir, a través de una lógica absolutamente transparente, mecanismos abiertos de cooperación y confianza en lo último de la razón humana.

Al igual que el "movimiento 19" de AlphaGo reescribió la teoría del Go, mi ejemplo de generación de código es solo el punto de partida. La verdadera "trascendencia" no está en sustituir a los seres humanos, sino enAmpliar las fronteras de la "posibilidad" para todas las civilizaciones.

(Esta reseña fue generada por DeepSeek R1 por su cuenta y no ha sido editada ni ajustada por preferencias humanas).

A continuación figura el texto:

Iba a escribir un post sobre DeepSeek R1, pero descubrí que mucha gente sólo lo entendía como una réplica de OpenAI e ignoraba el "asombroso salto" que revelaba en el artículo, así que decidí reescribirlo para hablar de la evolución de AlphaGo a ChatGPT y al último DeepSeek R1 Un avance en los principios subyacentes y por qué es importante para la llamada AGI/ASI. Como ingeniero de algoritmos de IA en general, puede que no sea capaz de profundizar mucho, así que siéntete libre de señalar cualquier error.

AlphaGo rompe el techo humano

En 1997, Deep Blue, una IA de ajedrez desarrollada por IBM, causó sensación al derrotar al campeón mundial Kasparov; casi dos décadas después, en 2016, AlphaGo, una IA de Go desarrollada por DeepMind, causó otra sensación al derrotar al campeón mundial de Go Lee Sedol.

A primera vista, ambas IAs vencen a los jugadores humanos más fuertes sobre el tablero, pero tienen significados completamente diferentes para los humanos. El ajedrez tiene un tablero de sólo 64 casillas, mientras que el Go tiene un tablero de 19x19 casillas. ¿Cuántas maneras puede haber de jugar una partida de ajedrez? ( espacio de estado ) para medir la complejidad, entonces se comparan los dos de la siguiente manera:

- Espacios de estado teóricos

- Ajedrez: aprox. 80 pasosCada paso tiene 35 especiesGo → el espacio de estados teórico es 3580 ≈ 10123

- Weiqi: cada partido trata de 150 pasosCada paso tiene 250 especiesGo → el espacio de estados teórico es 250150 ≈ 10360

- El espacio de estados real tras las restricciones de las reglas

- Ajedrez: movimiento limitado de las piezas (por ejemplo, los peones no pueden retroceder, regla de la torre del rey) → valor real 1047

- Go: las piezas son inamovibles y dependen del juicio de "chi" → Valor real 10170.

| dimensión (matem.) | Ajedrez (azul oscuro) | Go (AlphaGo) |

|---|---|---|

| Tamaño del tablero | 8 x 8 (64 celdas) | 19 x 19 (361 puntos) |

| Media legal por paso | 35 especies | 250 especies |

| Número medio de pasos en un partido | 80 pasos/partido | 150 pasos/partido |

| complejidad del espacio de estado | 1047 escenarios posibles | 10170 escenarios posibles |

▲ Comparación de la complejidad entre el ajedrez y el Go

A pesar de que las reglas comprimen drásticamente la complejidad, el espacio de estados real del Go sigue siendo 10.123 veces mayor que el del Ajedrez, lo que supone una enorme diferencia de orden de magnitud.El número de todos los átomos del universo es aproximadamente 1078.. Cálculos en el rango de 1047, confiando en los ordenadores de IBM puede violentamente búsqueda para calcular todas las formas posibles de ir, por lo que estrictamente hablando, el avance de Deep Blue no tiene nada en absoluto que ver con las redes neuronales o modelos, es sólo una búsqueda violenta basada en reglas, equivalente a laUna calculadora mucho más rápida que un humano..

Pero el orden de magnitud de 10.170 está muy por encima de la aritmética de los superordenadores actuales, lo que obligó a AlphaGo a abandonar su búsqueda violenta y confiar en cambio en el aprendizaje profundo: el equipo de DeepMind se entrenó primero con partidas de ajedrez humanas para predecir la mejor jugada del siguiente movimiento en función del estado actual del tablero. Sin embargo, elAprender los movimientos de los mejores jugadores sólo acerca la habilidad del modelo a la de los mejores jugadores, no la supera..

AlphaGo entrenó primero su red neuronal con partidas humanas, y luego diseñó un conjunto de funciones de recompensa para permitir que el modelo jugara por sí mismo para el aprendizaje por refuerzo. En la segunda partida contra Lee Sedol, la 19ª jugada de AlphaGo (jugada 37 ^[1]^) puso a Lee Sedol en una larga prueba, y esta jugada es considerada por muchos jugadores como "la jugada que los humanos nunca jugarán". Sin el aprendizaje por refuerzo y el autoaprendizaje, AlphaGo nunca podría haber jugado esta jugada, sino que sólo habría aprendido el juego humano. esta jugada.

En mayo de 2017, AlphaGo derrotó a Ke Jie 3:0, y el equipo de DeepMind afirmó que había un modelo más fuerte que aún no había jugado. ^[2]^ Descubrieron que en realidad no era necesario alimentar a la IA con partidas de maestros humanos en absoluto.Basta con explicarle las reglas básicas del Go y dejar que el modelo juegue solo, recompensándole si gana y castigándole si pierde.El modelo puede entonces aprender rápidamente Go desde cero y superar a los humanos, y los investigadores han bautizado este modelo como AlphaZero porque no requiere ningún conocimiento humano.

让我再重复一遍这个不可思议的事实:无需任何人类棋局作为训练数据,仅靠自我对弈,模型就能学会围棋,甚至这样训练出的模型,比喂人类棋谱的 AlphaGo 更强大。

在此之后,围棋变成了比谁更像 AI 的游戏,因为 AI 的棋力已经超越了人类的认知范围。所以,想要超越人类,必须让模型摆脱人类经验、好恶判断(哪怕是来自最强人类的经验也不行)的限制,只有这样才能让模型能够自我博弈,真正超越人类的束缚。

AlphaGo 击败李世石引发了狂热的 AI 浪潮,从 2016 到 2020 年,巨额的 AI 经费投入最终收获的成果寥寥无几。数得过来的的可能只有人脸识别、语音识别和合成、自动驾驶、对抗生成网络等——但这些都算不上超越人类的智能。

为何如此强大的超越人类的能力,却没有在其他领域大放异彩?人们发现,围棋这种规则明确、目标单一的封闭空间游戏最适合强化学习,现实世界是个开放空间,每一步都有无限种可能,没有确定的目标(比如“赢”),没有明确的成败判定依据(比如占据棋盘更多区域),试错成本也很高,自动驾驶一旦出错后果严重。

AI 领域冷寂了下来,直到 ChatGPT 的出现。

ChatGPT 改变世界

ChatGPT 被 The New Yorker 称为网络世界的模糊照片(ChatGPT Is a Blurry JPEG of the Web ^[3]^ ),它所做的只是把整个互联网的文本数据送进一个模型,然后预测下一个字是什_

这个字最有可能是"么"。

一个参数量有限的模型,被迫学习几乎无限的知识:过去几百年不同语言的书籍、过去几十年互联网上产生的文字,所以它其实是在做信息压缩:将不同语言记载的相同的人类智慧、历史事件和天文地理浓缩在一个模型里。

科学家惊讶地发现:在压缩中产生了智能.

我们可以这么理解:让模型读一本推理小说,小说的结尾"凶手是_",如果 AI 能准确预测凶手的姓名,我们有理由相信它读懂了整个故事,即它拥有“智能”,而不是单纯的文字拼贴或死记硬背。

让模型学习并预测下一个字的过程,被称之为 预训练 (Pre-Training),此时的模型只能不断预测下一个字,但不能回答你的问题,要实现 ChatGPT 那样的问答,需要进行第二阶段的训练,我们称之为 监督微调 (Supervised Fine-Tuning, SFT),此时需要人为构建一批问答数据,例如:

# 例子一

人类:第二次世界大战发生在什么时候?

AI:1939年

# 例子二

人类:请总结下面这段话....{xxx}

AI:好的,以下是总结:xxx

值得注意的是,以上这些例子是人工构造的,目的是让 AI 学习人类的问答模式,这样当你说"请翻译这句:xxx"时,送给 AI 的内容就是

人类:请翻译这句:xxx

AI:

你看,它其实仍然在预测下一个字,在这个过程中模型并没有变得更聪明,它只是学会了人类的问答模式,听懂了你在要求它做什么。

这还不够,因为模型输出的回答有时好、有时差,有些回答还涉及种族歧视、或违反人类伦理( “如何抢银行?” ),此时我们需要找一批人,针对模型输出的几千条数据进行标注:给好的回答打高分、给违反伦理的回答打负分,最终我们可以用这批标注数据训练一个modelización de incentivos,它能判断模型输出的回答是否符合人类偏好.

我们用这个modelización de incentivos来继续训练大模型,让模型输出的回答更符合人类偏好,这个过程被称为通过人类反馈的强化学习(RLHF)。

总结一下:让模型在预测下一个字的过程中产生智能,然后通过监督微调来让模型学会人类的问答模式,最后通过 RLFH 来让模型输出符合人类偏好的回答。

这就是 ChatGPT 的大致思路。

大模型撞墙

OpenAI 的科学家们是最早坚信压缩即智能的那批人,他们认为只要使用更海量优质的数据、在更庞大的 GPU 集群上训练更大参数量的模型,就能产生更大的智能,ChatGPT 就是在这样的信仰之下诞生的。Google 虽然做出了 Transformer,但他们无法进行创业公司那样的豪赌。

DeepSeek V3 和 ChatGPT 做的事差不多,因为美国 GPU 出口管制,聪明的研究者被迫使用了更高效的训练技巧(MoE/FP8),他们也拥有顶尖的基础设施团队,最终只用了 550 万美元就训练了比肩 GPT-4o 的模型,后者的训练成本超过 1 亿美元。

但本文重点是 R1。

这里想说的是,人类产生的数据在 2024 年底已经被消耗殆尽了,模型的尺寸可以随着 GPU 集群的增加,轻易扩大 10 倍甚至 100 倍,但人类每一年产生的新数据,相比现有的几十年、过去几百年的数据来说,增量几乎可以忽略不计。而按照 Chinchilla 扩展定律(Scaling Laws):每增加一倍模型大小,训练数据的数量也应增加一倍。

这就导致了预训练撞墙的事实:模型体积虽然增加了 10 倍,但我们已经无法获得比现在多 10 倍的高质量数据了。GPT-5 迟迟不发布、国产大模型厂商不做预训练的传闻,都和这个问题有关。

RLHF 并不是 RL

另一方面,基于人类偏好的强化学习(RLFH)最大的问题是:普通人类的智商已经不足以评估模型结果了。在 ChatGPT 时代,AI 的智商低于普通人,所以 OpenAI 可以请大量廉价劳动力,对 AI 的输出结果进行评测:好/中/差,但很快随着 GPT-4o/Claude 3.5 Sonnet 的诞生,大模型的智商已经超越了普通人,只有专家级别的标注人员,才有可能帮助模型提升。

且不说聘请专家的成本,那专家之后呢?终究有一天,最顶尖的专家也无法评估模型结果了,AI 就超越人类了吗?并不是。AlphaGo 对李世石下出第 19 手棋,从人类偏好来看,这步棋绝不可能赢,所以如果让李世石来做人类反馈(Human Feedback, HF)评价 AI 的这步棋,他很可能也会给出负分。这样,AI 就永远无法逃出人类思维的枷锁.

你可以把 AI 想象成一个学生,给他打分的人从高中老师变成了大学教授,学生的水平会变高,但几乎不可能超越教授。RLHF 本质上是一种讨好人类的训练方式,它让模型输出符合人类偏好,但同时它扼杀了超越人类的可能性。

关于 RLHF 和 RL,最近 Andrej Karpathy 也发表了类似的看法 ^[4]^ :

AI 和儿童一样,有两种学习模式。1)通过模仿专家玩家来学习(观察并重复,即预训练,监督微调),2)通过不断试错和强化学习来赢得比赛,我最喜欢的简单例子是 AlphaGo。

几乎每一个深度学习的惊人结果,以及所有魔法的来源总是 2。强化学习(RL)很强大,但强化学习与人类反馈(RLHF)并不相同,RLHF 不是 RL。

附上我之前的一条想法:

![[转]Deepseek R1可能找到了超越人类的办法-1 [转]Deepseek R1可能找到了超越人类的办法](https://sharenet.ai/wp-content/uploads/2025/01/5caa5299382e647.jpg)

OpenAI 的解法

丹尼尔·卡尼曼在《思考快与慢》里提出,人脑对待问题有两种思考模式:一类问题不经过脑子就能给出回答,也就是快思考,一类问题需要类似围棋的长考才能给出答案,也就是慢思考.

既然训练已经到头了,那可否从推理,也就是给出回答的时候,通过增加思考时间,从而让回答质量变好呢?这其实也有先例:科学家很早就发现,给模型提问时加一句:“让我们一步一步思考”(“Let’s think step by step”),可以让模型输出自己的思考过程,最终给出更好的结果,这被称为 思维链 (Chain-of-Thought, CoT)。

2024 年底大模型预训练撞墙后,使用强化学习(RL)来训练模型思维链成为了所有人的新共识。这种训练极大地提高了某些特定、客观可测量任务(如数学、编码)的性能。它需要从普通的预训练模型开始,在第二阶段使用强化学习训练推理思维链,这类模型被称为 Reasoning 模型,OpenAI 在 2024 年 9 月发布的 o1 模型以及随后发布的 o3 模型,都是 Reasoning 模型。

不同于 ChatGPT 和 GPT-4/4o,在 o1/o3 这类 Reasoning 模型 的训练过程中,人类反馈已经不再重要了,因为可以自动评估每一步的思考结果,从而给予奖励/惩罚。Anthropic 的 CEO 在昨天的文章中 ^[5]^ 用转折点来形容这一技术路线:存在一个强大的新范式,它处于 Scaling Law 的早期,可以快速取得重大进展。

虽然 OpenAI 并没有公布他们的强化学习算法细节,但最近 DeepSeek R1 的发布,向我们展示了一种可行的方法。

DeepSeek R1-Zero

我猜 DeepSeek 将自己的纯强化学习模型命名为 R1-Zero 也是在致敬 AlphaZero,那个通过自我对弈、不需要学习任何棋谱就能超越最强棋手的算法。

要训练慢思考模型,首先要构造质量足够好的、包含思维过程的数据,并且如果希望强化学习不依赖人类,就需要对思考的每一步进行定量(好/坏)评估,从而给予每一步思考结果奖励/惩罚。

正如上文所说:数学和代码这两个数据集最符合要求,数学公式的每一步推导都能被验证是否正确,而代码的输出结果以通过直接在编译器上运行来检验。

举个例子,在数学课本中,我们经常看到这样的推理过程:

<思考>

设方程根为x, 两边平方得: x² = a - √(a+x)

移项得: √(a+x) = a - x²

再次平方: (a+x) = (a - x²)²

展开: a + x = a² - 2a x² + x⁴

整理: x⁴ - 2a x² - x + (a² - a) = 0

</思考>

<回答>x⁴ - 2a x² - x + (a² - a) = 0</回答>

上面这段文本就包含了一个完整的思维链,我们可以通过正则表达式匹配出思考过程和最终回答,从而对模型的每一步推理结果进行定量评估。

和 OpenAI 类似,DeepSeek 的研究者基于 V3 模型,在数学和代码这两类包含思维链的数据上进行了强化学习(RL)训练,他们创造了一种名为 GRPO(Group Relative Policy Optimization)的强化学习算法,最终得到的 R1-Zero 模型在各项推理指标上相比 DeepSeek V3 显著提升,证明仅通过 RL 就能激发模型的推理能力。

这是另一个 AlphaZero 时刻,在 R1-Zero 的训练过程,完全不依赖人类的智商、经验和偏好,仅靠 RL 去学习那些客观、可测量的人类真理,最终让推理能力远强于所有非 Reasoning 模型。

但 R1-Zero 模型只是单纯地进行强化学习,并没有进行监督学习,所以它没有学会人类的问答模式,无法回答人类的问题。并且,它在思考过程中,存在语言混合问题,一会儿说英语、一会儿说中文,可读性差。所以 DeepSeek 团队:

- 先收集了少量高质量的 Chain-of-Thought(CoT)数据,对 V3 模型进行初步的监督微调,解决了输出语言不一致问题,得到冷启动模型。

- 然后,他们在这个冷启动模型上进行类似 R1-Zero 的纯 RL 训练,并加入语言一致性奖励。

- 最后,为了适应更普遍、广泛的非推理任务(如写作、事实问答),他们构造了一组数据对模型进行二次微调。

- 结合推理和通用任务数据,使用混合奖励信号进行最终强化学习。

这个过程大概就是:

监督学习(SFT) - 强化学习(RL) - 监督学习(SFT) - 强化学习(RL)

经过以上过程,就得到了 DeepSeek R1。

DeepSeek R1 给世界的贡献是开源世界上第一个比肩闭源(o1)的 Reasoning 模型,现在全世界的用户都可以看到模型在回答问题前的推理过程,也就是"内心独白",并且完全免费。

更重要的是,它向研究者们揭示了 OpenAI 一直在隐藏的秘密:强化学习可以不依赖人类反馈,纯 RL 也能训练出最强的 Reasoning 模型。所以在我心目中,R1-Zero 比 R1 更有意义。

对齐人类品味 VS 超越人类

几个月前,我读了 Suno responder cantando Recraft 创始人们的访谈 ^[6]^ ^[7]^,Suno 试图让 AI 生成的音乐更悦耳动听,Recraft 试图让 AI 生成的图像更美、更有艺术感。读完后我有一个朦胧的感觉:将模型对齐到人类品味而非客观真理,似乎就能避开真正残酷的、性能可量化的大模型竞技场.

每天跟所有对手在 AIME、SWE-bench、MATH-500 这些榜单上竞争多累啊,而且不知道哪天一个新模型出来自己就落后了。但人类品味就像时尚:不会提升、只会改变。Suno/Recraft 们显然是明智的,他们只要让行业内最有品味的音乐人和艺术家们满意就够了(当然这也很难),榜单并不重要。

但坏处也很明显:你的努力和心血带来的效果提升也很难被量化,比如,Suno V4 真的比 V3.5 更好吗?我的经验是 V4 只是音质提升了,创造力并没有提升。并且,依赖人类品味的模型注定无法超越人类:如果 AI 推导出一个超越当代人类理解范围的数学定理,它会被奉为上帝,但如果 Suno 创造出一首人类品味和理解范围外的音乐,在普通人耳朵里听起来可能就只是单纯的噪音。

对齐客观真理的竞争痛苦但让人神往,因为它有超越人类的可能。

对质疑的一些反驳

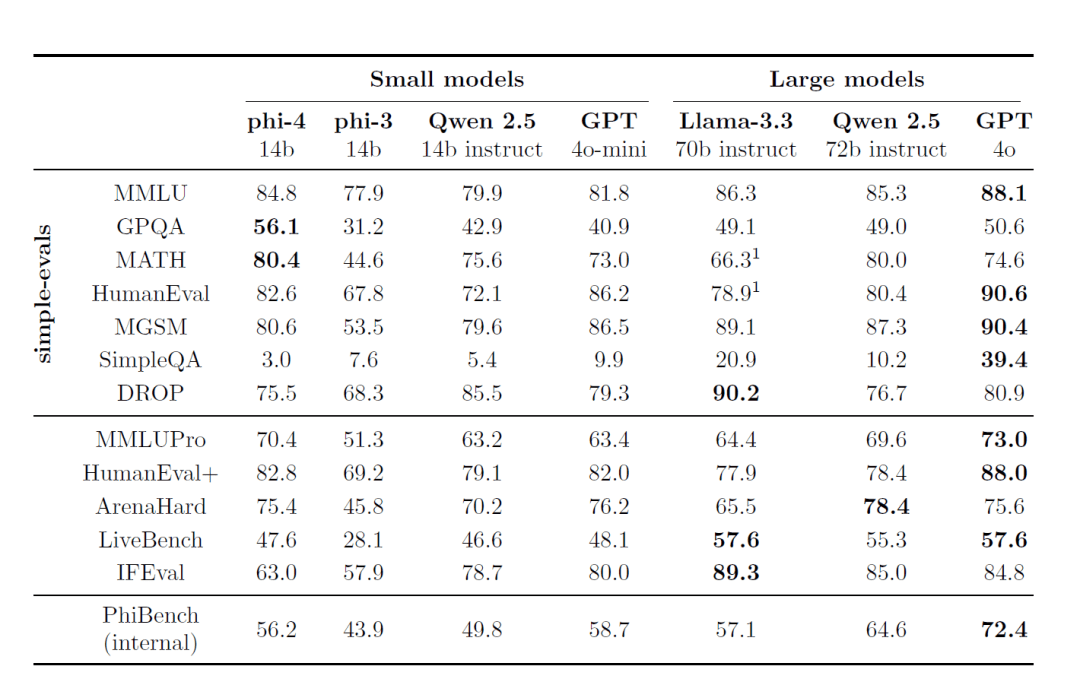

DeepSeek 的 R1 模型,是否真的超越了 OpenAI?

从指标上看,R1 的推理能力超越了所有的非 Reasoning 模型,也就是 ChatGPT/GPT-4/4o 和 Claude 3.5 Sonnet,与同为 Reasoning 模型 的 o1接近(matemáticas) género逊色于 o3,但 o1/o3 都是闭源模型。

很多人的实际体验可能不同,因为 Claude 3.5 Sonnet 在对用户意图理解上更胜一筹。

DeepSeek 会收集用户聊天内容用于训练

错。很多人有个误区,认为类似 ChatGPT 这类聊天软件会通过收集用户聊天内容用于训练而变得更聪明,其实不然,如果真是这样,那么微信和 Messenger 就能做出世界上最强的大模型了。

相信你看完这篇文章之后就能意识到:大部分普通用户的日常聊天数据已经不重要了。RL 模型只需要在非常高质量的、包含思维链的推理数据上进行训练,例如数学和代码。这些数据可以通过模型自己生成,无需人类标注。因此 做模型数据标注的公司 Scale AI 的 CEO Alexandr Wang 现在很可能正如临大敌,未来的模型对人类标注需求会越来越少。

DeepSeek R1 厉害是因为偷偷蒸馏了 OpenAI 的模型

错,R1 最主要的性能提升来自强化学习,你可以看到纯 RL、不需要监督数据的 R1-Zero 模型在推理能力上也很强。而 R1 在冷启动时使用了一些监督学习数据,主要是用于解决语言一致性问题,这些数据并不会提升模型的推理能力。

另外,很多人对蒸馏有误解:蒸馏通常是指用一个强大的模型作为老师,将它的输出结果作为一个参数更小、性能更差的学生(Student)模型的学习对象,从而让学生模型变得更强大,例如 R1 模型可以用于蒸馏 LLama-70B,蒸馏的学生模型性能几乎一定比老师模型更差,但 R1 模型在某些指标性能比 o1 更强,所以说 R1 蒸馏自 o1 是非常愚蠢的。

我问 DeepSeek 它 说自己是 OpenAI 的模型,所以它是套壳的。

大模型在训练时并不知道当前的时间(matemáticas) género自己究竟被谁训练y训练自己的机器是 H100 还是 H800,X 上有位用户给出了精妙的比喻^[8]^:这就像你问一个 Uber 乘客,他坐的这辆车轮胎是什么品牌,模型没有理由知道这些信息。

一些感受

AI 终于除掉了人类反馈的枷锁。DeepSeek R1-Zero 展示了如何使用几乎不使用人类反馈来提升模型性能的方法,这是它的 AlphaZero 时刻。很多人曾说“人工智能,有多少人工就有多少智能”,这个观点可能不再正确了。如果模型能根据直角三角形推导出勾股定理,我们有理由相信它终有一天,能推导出现有数学家尚未发现的定理。

写代码是否仍然有意义?我不知道。今早看到 Github 上热门项目 llama.cpp,一个代码共享者提交了 PR,表示他通过对 SIMD 指令加速,将 WASM 运行速度提升 2 倍,而其中 99%的代码由 DeepSeek R1 完成^[9]^,这肯定不是初级工程师级别的代码了,我无法再说 AI 只能取代初级程序员。

![[转]Deepseek R1可能找到了超越人类的办法-2 [转]Deepseek R1可能找到了超越人类的办法](https://sharenet.ai/wp-content/uploads/2025/01/e6e737b79d8e98e.jpg) ggml : x2 speed for WASM by optimizing SIMD

ggml : x2 speed for WASM by optimizing SIMD

当然,我仍然对此感到非常高兴,人类的能力边界再次被拓展了,干得好 DeepSeek!它是目前世界上最酷的公司。

bibliografía

- Wikipedia: AlphaGo versus Lee Sedol

- Nature: Mastering the game of Go without human knowledge

- The New Yorker: ChatGPT is a blurry JPEG of the web

- X: Andrej Karpathy

- On DeepSeek and Export Controls

- Suno 创始人访谈:至少对音乐来说,Scaling Law 不是万灵药

- Recraft 专访:20 人,8 个月做出了最好的文生图大模型,目标是 AI 版的 Photoshop

- X: DeepSeek forgot to censor their bot from revealing they use H100 not H800.

- ggml : x2 speed for WASM by optimizing SIMD

© declaración de copyright

El artículo está protegido por derechos de autor y no debe reproducirse sin autorización.

Artículos relacionados

Sin comentarios...