AppAgent : utilisation automatisée d'un smartphone à l'aide d'intelligences multimodales

Introduction générale

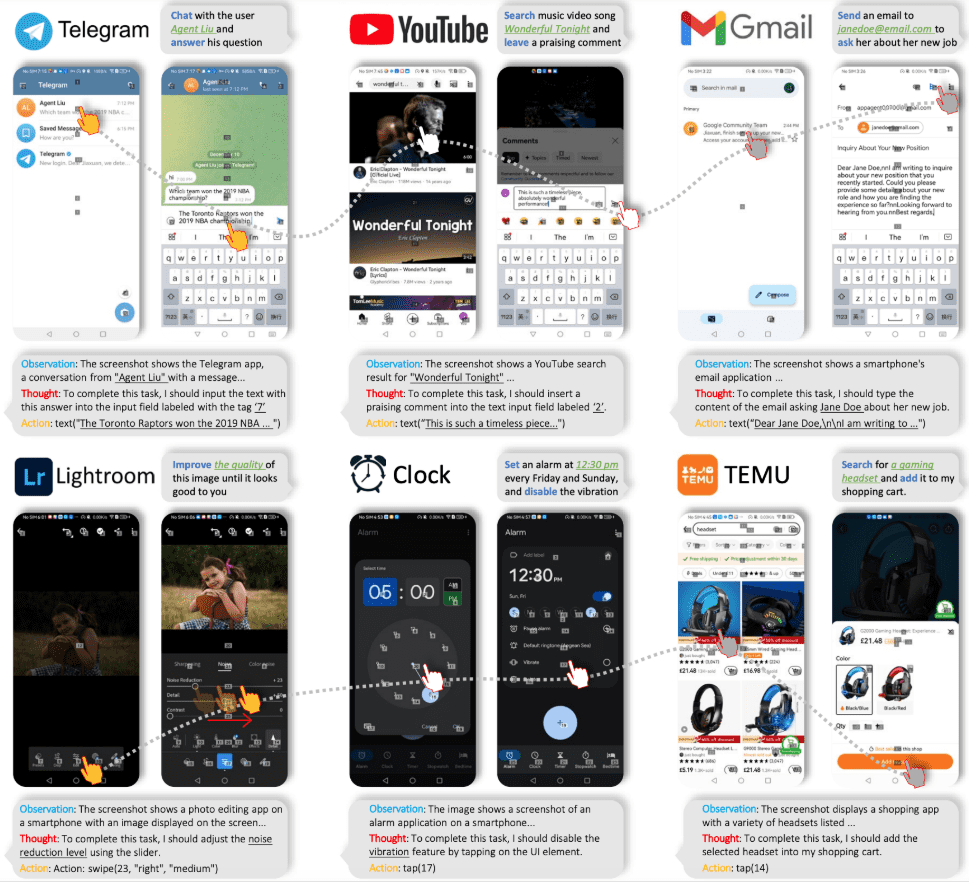

AppAgent est un agent multimodal basé sur le modèle du grand langage (LLM) conçu pour faire fonctionner les applications des smartphones. L'AppAgent apprend à utiliser de nouvelles applications en explorant ou en observant de manière autonome des démonstrations humaines, et génère une base de connaissances pour effectuer des tâches complexes.

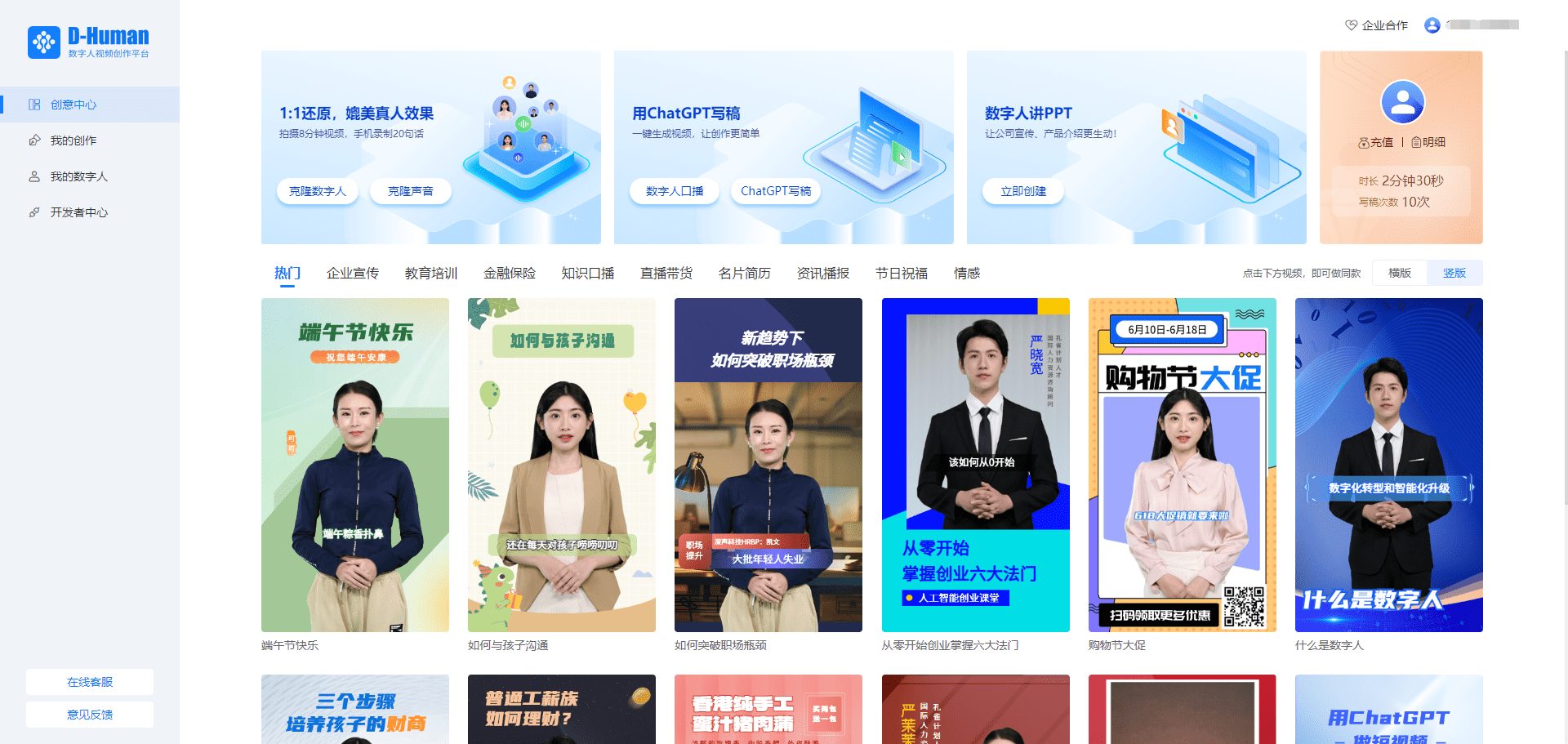

Tencent a lancé AppAgent, un corps intelligent multimodal qui peut faire fonctionner l'interface du téléphone mobile directement en reconnaissant l'interface actuelle du téléphone mobile et les commandes de l'utilisateur, et peut faire fonctionner le téléphone mobile comme un véritable utilisateur ! Par exemple, il peut utiliser un logiciel de retouche photo pour éditer des images, ouvrir des applications cartographiques pour naviguer, faire des achats, etc.

Page d'accueil du projet : https://appagent-official.github.io

Lien vers l'article : https://arxiv.org/abs/2312.13771

résumé de thèse

Les récentes avancées dans le domaine des grands modèles de langage (LLM) ont permis de créer des corps intelligents capables d'effectuer des tâches complexes. Dans cet article, nous présentons un nouveau cadre multimodal pour les corps intelligents basé sur les grands modèles de langage, conçu pour manipuler les applications de smartphones. Notre cadre permet aux corps intelligents de manipuler des applications de smartphone par le biais d'un espace de manipulation simplifié, de telle sorte que c'est comme si un humain effectuait des opérations de clic et de glissement. Cette approche innovante évite d'avoir à accéder directement à l'arrière-plan du système, ce qui le rend adapté à un large éventail d'applications différentes. Au cœur de la fonctionnalité de nos intelligences se trouve son approche innovante de l'apprentissage. Le corps intelligent apprend à naviguer et à utiliser de nouvelles applications par auto-exploration ou en observant des démonstrations humaines. Ce faisant, il construit une base de connaissances sur laquelle il s'appuie pour effectuer des tâches complexes dans différentes applications. Pour démontrer l'utilité de notre intelligence, nous l'avons testée de manière approfondie sur 50 tâches dans 10 applications différentes, dont les médias sociaux, le courrier électronique, les cartes, les achats et les outils complexes de retouche d'images. Les résultats des tests démontrent la capacité efficace de notre intelligence à gérer un large éventail de tâches avancées.

Liste des fonctions

- l'exploration autonomeLes agents peuvent explorer les applications de manière autonome, enregistrer les éléments interactifs et générer de la documentation.

- Démonstration humaine de l'apprentissageL'agent apprend la tâche en observant une démonstration humaine et génère la documentation appropriée.

- mise en œuvre du mandatPendant la phase de déploiement, l'agent exécute des tâches complexes sur la base des documents générés.

- Entrées multimodalesLe système de gestion de l'information de la Commission européenne est le suivant : il prend en charge les entrées textuelles et visuelles, en utilisant les modèles GPT-4V ou Qwen-VL-Max.

- Traitement CAPTCHALes personnes qui ne sont pas membres de l'Union européenne peuvent être authentifiées par un CAPTCHA.

- Reconnaissance des éléments de l'interface utilisateurUtilisation d'une grille pour positionner les éléments non marqués de l'interface utilisateur.

Utiliser l'aide

Installation et configuration

- Téléchargement et installationTélécharger les fichiers du projet à partir de la page GitHub et installer les dépendances nécessaires.

- fichier de configuration: Modifier les paramètres du répertoire racine

config.yamlpour configurer la clé API pour le modèle GPT-4V ou Qwen-VL-Max. - dispositif connectéConnectez votre appareil Android à l'aide d'un port USB et activez le débogage USB dans les options du développeur.

Modèle d'auto-exploration

- lancer une exploration: Run

learn.pysélectionnez le mode d'exploration autonome et entrez le nom de l'application et la description de la tâche. - Enregistrer les interactionsL'agent explore automatiquement l'application, enregistre les éléments d'interaction et génère de la documentation.

Mode de démonstration humaine

- Démonstration de démarrage: Run

learn.pysélectionnez le mode de démonstration humaine et entrez le nom de l'application et la description de la tâche. - Démonstration exécutiveL'agent enregistrera toutes les interactions et produira de la documentation.

mise en œuvre du mandat

- Lancer des tâches: Run

run.pysaisissez le nom de l'application et la description de la tâche, et sélectionnez la bibliothèque de documents appropriée. - opérerL'agent effectuera des tâches pour mener à bien des opérations complexes sur la base de la documentation.

Procédure d'utilisation détaillée

- Télécharger le projetPour cela, il faut : visiter la page GitHub, télécharger les fichiers du projet et les extraire.

- Installation des dépendancesExécution dans un terminal

pip install -r requirements.txtInstaller toutes les dépendances. - modèle de configurationModifier le cas échéant

config.yamlpour configurer la clé API pour le modèle GPT-4V ou Qwen-VL-Max. - dispositif connectéConnectez votre appareil Android à l'aide du port USB et activez le mode de débogage USB sur l'appareil.

- Lancer une exploration ou une démonstration: Run

learn.pysélectionnez le mode Exploration autonome ou Démonstration humaine, et entrez le nom de l'application et la description de la tâche. - Générer de la documentationL'agent enregistrera toutes les interactions et produira la documentation nécessaire à l'exécution des tâches ultérieures.

- opérer: Run

run.pyl'agent exécute la tâche en se basant sur le document.

© déclaration de droits d'auteur

L'article est protégé par le droit d'auteur et ne doit pas être reproduit sans autorisation.

Articles connexes

Pas de commentaires...