CAG : Une méthode de génération améliorée par le cache qui est 40 fois plus rapide que RAG

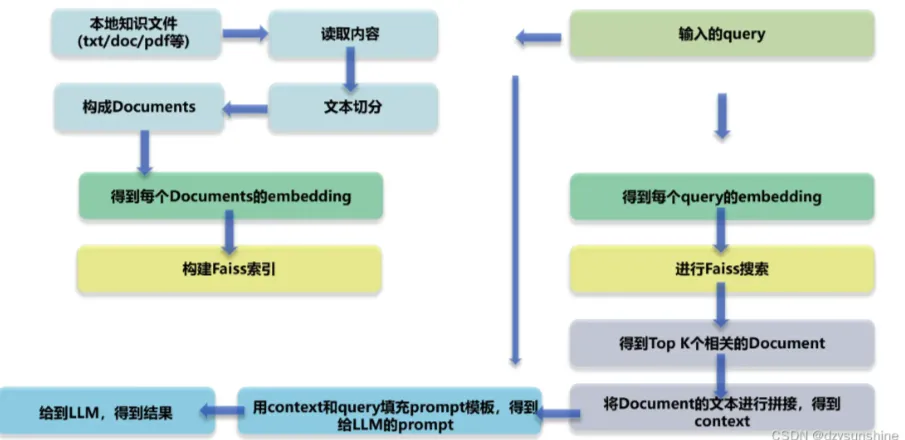

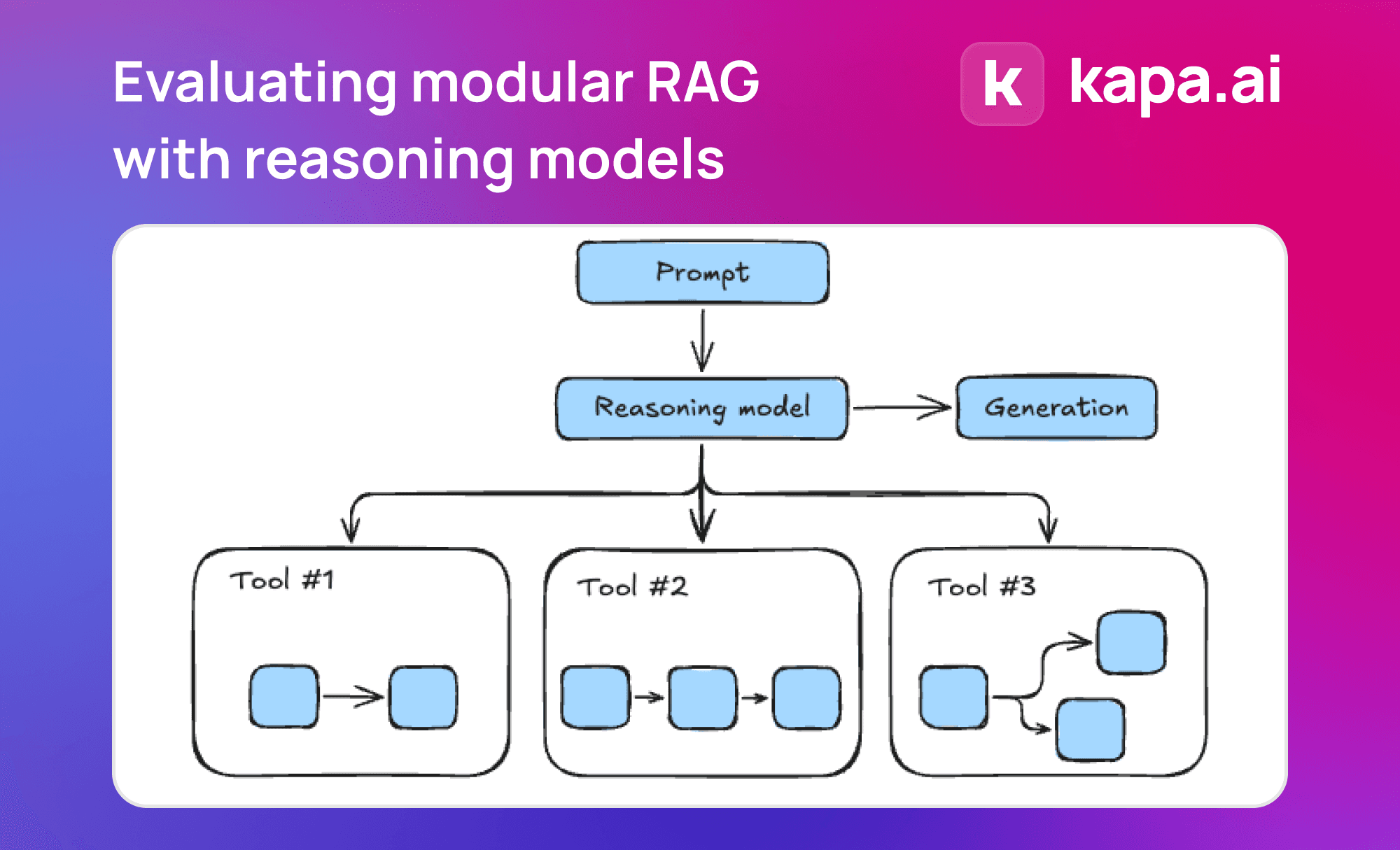

CAG (Cache Augmented Generation), qui est 40 fois plus rapide que RAG (Retrieval Augmented Generation), révolutionne l'acquisition des connaissances : au lieu de récupérer des données externes en temps réel, toutes les connaissances sont préchargées dans le contexte du modèle. C'est comme si l'on condensait une énorme bibliothèque en une boîte à outils que l'on peut feuilleter quand on en a besoin, et la mise en œuvre de CAG est élégante :

- Le document est d'abord prétraité pour s'assurer qu'il s'intègre dans la fenêtre de contexte LLM.

- Le contenu traité est ensuite encodé dans le cache clé-valeur

- Enfin, ce cache est stocké en mémoire ou sur le disque dur pour être rappelé à tout moment.

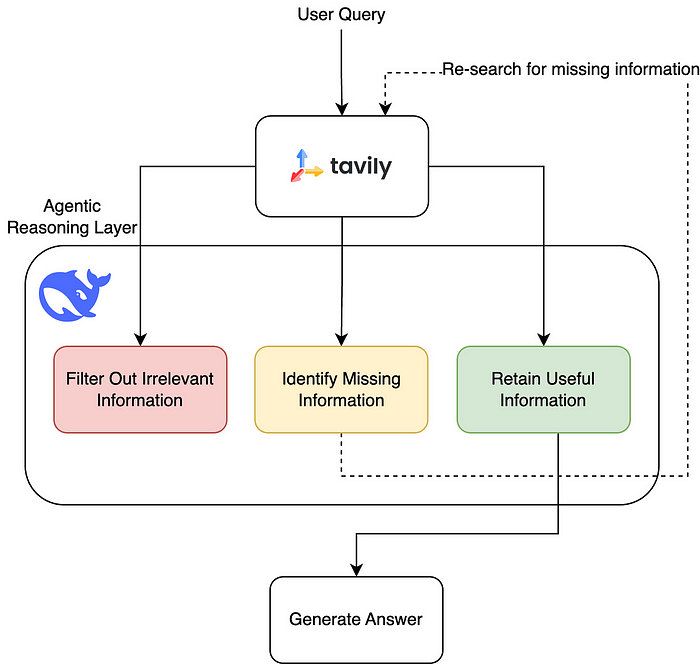

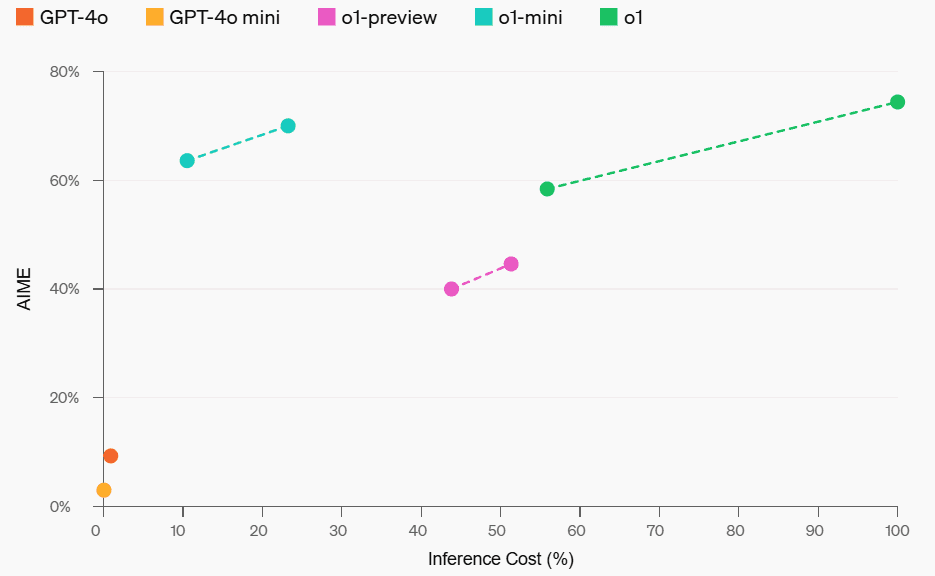

Les résultats sont convaincants : sur des ensembles de données de référence tels que HotPotQA et SQuAD, l'ACG est non seulement 40 fois plus rapide, mais aussi nettement plus précis et cohérent. Ceci est dû à sa capacité à capturer le contexte de manière globale, sans le problème des erreurs de récupération ou des données incomplètes.

En termes d'applications pratiques, cette technologie est prometteuse dans des domaines tels que le diagnostic médical, l'analyse financière et le service à la clientèle. Elle permet aux systèmes d'IA de maintenir des performances élevées tout en évitant le fardeau de la maintenance d'architectures complexes.

En fin de compte, l'innovation de l'ACG réside dans le fait qu'elle transforme le "take-as-you-go" en "carry-it-around", ce qui non seulement améliore l'efficacité, mais ouvre également de nouvelles possibilités pour le déploiement de l'IA. Il pourrait s'agir de la norme pour la prochaine génération d'architectures d'IA.

Références :

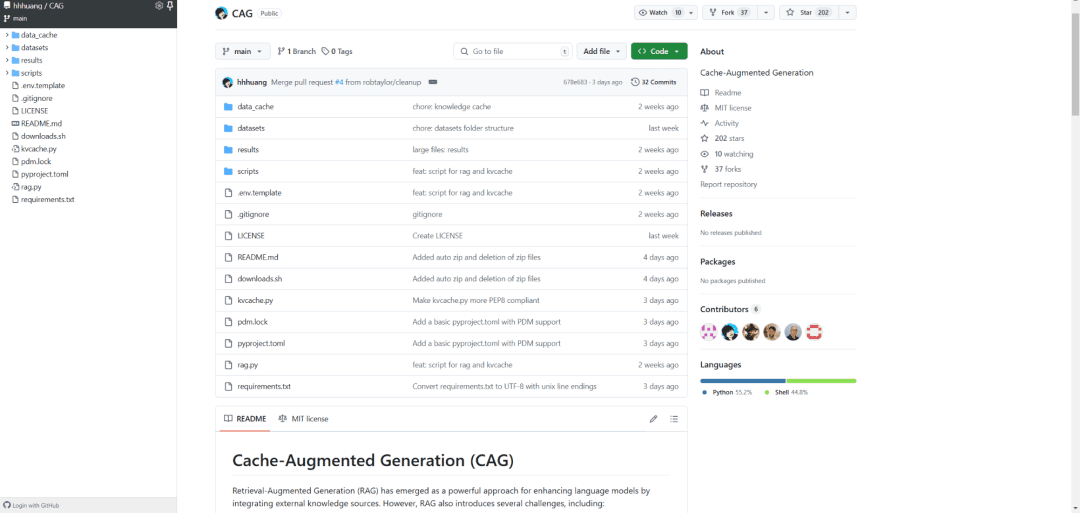

[1] https://github.com/hhhuang/CAG

[2] https://arxiv.org/abs/2412.15605

[3] Les LLM à contexte long luttent contre l'apprentissage à contexte long : https://arxiv.org/pdf/2404.02060v2

© déclaration de droits d'auteur

L'article est protégé par le droit d'auteur et ne doit pas être reproduit sans autorisation.

Articles connexes

Pas de commentaires...