ChatAnyone : un outil pour générer des vidéos de portraits humains numériques à mi-corps à partir de photographies

Introduction générale

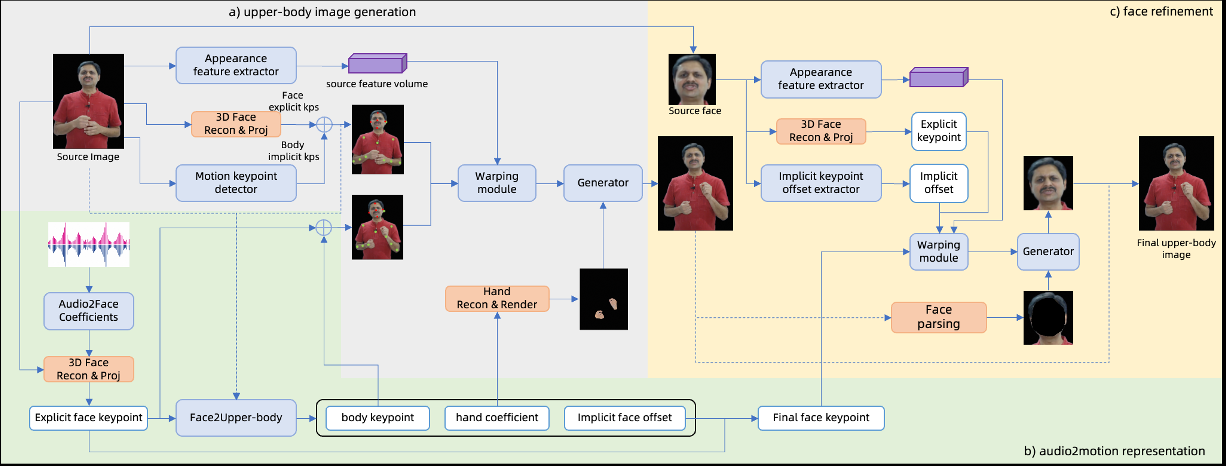

ChatAnyone est un projet innovant développé par l'équipe HumanAIGC. Il utilise une technologie d'intelligence artificielle pour générer une vidéo de portrait humain numérique avec des mouvements du haut du corps à partir d'une simple photo et d'une entrée audio. Basé sur un modèle hiérarchique de diffusion du mouvement, le projet génère des mouvements de tête, des gestes et des expressions adaptés à la présentation d'avatars ou à l'animation de personnes numériques. ChatAnyone se caractérise par une génération efficace, prenant en charge une résolution de 512×768 et une sortie vidéo de 30 images par seconde. Le projet est actuellement sur GitHub avec des détails techniques, mais n'est pas encore totalement open source, attirant l'attention de nombreux utilisateurs intéressés par la technologie de génération d'humains numériques.

Liste des fonctions

- Génération Photo VidéoLa vidéo humaine numérique : générer des vidéos humaines numériques avec des mouvements du haut du corps à partir d'une seule photo et d'une entrée audio.

- contrôle des mouvementsLes fonctions d'aide à la création de mouvements naturels de la tête, de gestes et d'expressions : elles permettent de générer des mouvements naturels de la tête, des gestes et des expressions.

- synchronisation audioLes mouvements des lèvres sont adaptés à l'audio pour plus de réalisme.

- Haute performanceLe GPU 4090 prend en charge la résolution 512×768 à raison de 30 images par seconde.

- Vitrine technologiqueLes résultats seront partagés sur une page GitHub pour que les utilisateurs puissent apprendre et explorer.

Utiliser l'aide

ChatAnyone est actuellement un projet de démonstration technologique et n'est pas entièrement open source, il ne peut donc pas être téléchargé ou installé directement. Le contenu suivant est basé sur des informations officielles et décrit en détail ses fonctionnalités et sa logique de fonctionnement afin d'aider les utilisateurs à comprendre le projet et à envisager une éventuelle utilisation ouverte à l'avenir.

Principales fonctions

1. générer des vidéos à partir de photos

- logique de fonctionnementLe système génère une vidéo de la personne numérique avec des mouvements du haut du corps. Le système génère une vidéo de la personne numérique avec des mouvements du haut du corps. La vidéo comprend des mouvements tels que des tours de tête et des gestes.

- effetRésolution vidéo de sortie jusqu'à 512 x 768 avec une fréquence d'images de 30 images par seconde. Les mouvements humains numériques sont adaptés au tempo audio, ce qui convient à l'affichage d'images virtuelles.

- UtilisationLa fonctionnalité est actuellement connue grâce à des vidéos de démonstration officielles ou à la documentation, et une version bêta pourrait être ouverte à l'avenir.

2. le contrôle des mouvements

- logique de fonctionnementLe système génère des mouvements naturels de la partie supérieure du corps à partir de données audio, y compris la dynamique de la tête et des mains. Les utilisateurs peuvent découvrir la gamme de mouvements à l'aide d'exemples.

- effetLa personne numérique générée peut présenter différents styles de mouvements, tels que des hochements de tête et des changements de gestes, afin d'améliorer l'expressivité.

- UtilisationCette fonctionnalité est en phase de démonstration, et les utilisateurs peuvent voir comment elle fonctionne via la page GitHub.

3. la synchronisation audio

- logique de fonctionnementLe système génère des mouvements de lèvres qui correspondent au rythme du son.

- effetLes lèvres sont hautement synchronisées avec l'audio pour les présentateurs virtuels ou les présentations animées.

- Utilisation: Actuellement expérimenté par le biais d'un échantillon vidéo officiel, des essais par les utilisateurs pourront être réalisés à l'avenir.

Comment obtenir plus d'informations

- Visitez la page officielle: Aller à

https://github.com/HumanAIGC/chat-anyonePour plus d'informations, consultez la description du projet et la vidéo de présentation. - Suivre les mises à jourLe projet n'est pas encore open source, mais l'équipe pourrait publier du code ou des outils à l'avenir. Il est recommandé de consulter régulièrement le dépôt GitHub.

- Contacter l'équipePour plus d'informations, veuillez laisser un message sur GitHub ou trouver les coordonnées officielles.

mise en garde

- ChatAnyone est actuellement un projet de démonstration technologique et ne peut pas être utilisé directement.

- La génération nécessite du matériel de haute performance (par exemple, 4090 GPU), ce qui est difficile à expérimenter localement pour l'utilisateur moyen.

- Il est possible que le projet soit ouvert à l'avenir et qu'un guide plus détaillé soit disponible à ce moment-là.

scénario d'application

- Présentation d'une image virtuelle

Les utilisateurs peuvent créer des vidéos de personnes numériques avec des photos pour montrer des images virtuelles personnalisées. - Production de contenu d'animation

Les créateurs peuvent utiliser la vidéo générée par une personne numérique à demi-figure pour créer des courts métrages ou des contenus de présentation. - Études techniques

Grâce à ce projet, les chercheurs peuvent se familiariser avec les techniques de génération de personnages numériques à partir de données audio.

QA

- ChatAnyone peut-il chatter en temps réel ?

Pas actuellement. Il se concentre sur la génération de vidéos à partir de photos et d'audio, et non sur un outil de chat en direct. - Quels sont les types de photos pris en charge ?

La présentation officielle est basée sur des photographies de portrait, et les exigences spécifiques peuvent être trouvées dans les documents à venir. - La vidéo est-elle disponible dans le commerce ?

Actuellement, il n'y a pas de licence explicite, il faut attendre l'open source pour voir l'accord.

© déclaration de droits d'auteur

L'article est protégé par le droit d'auteur et ne doit pas être reproduit sans autorisation.

Articles connexes

Pas de commentaires...