CogVLM2 : un modèle multimodal open source pour soutenir la compréhension vidéo et les dialogues multiples

Introduction générale

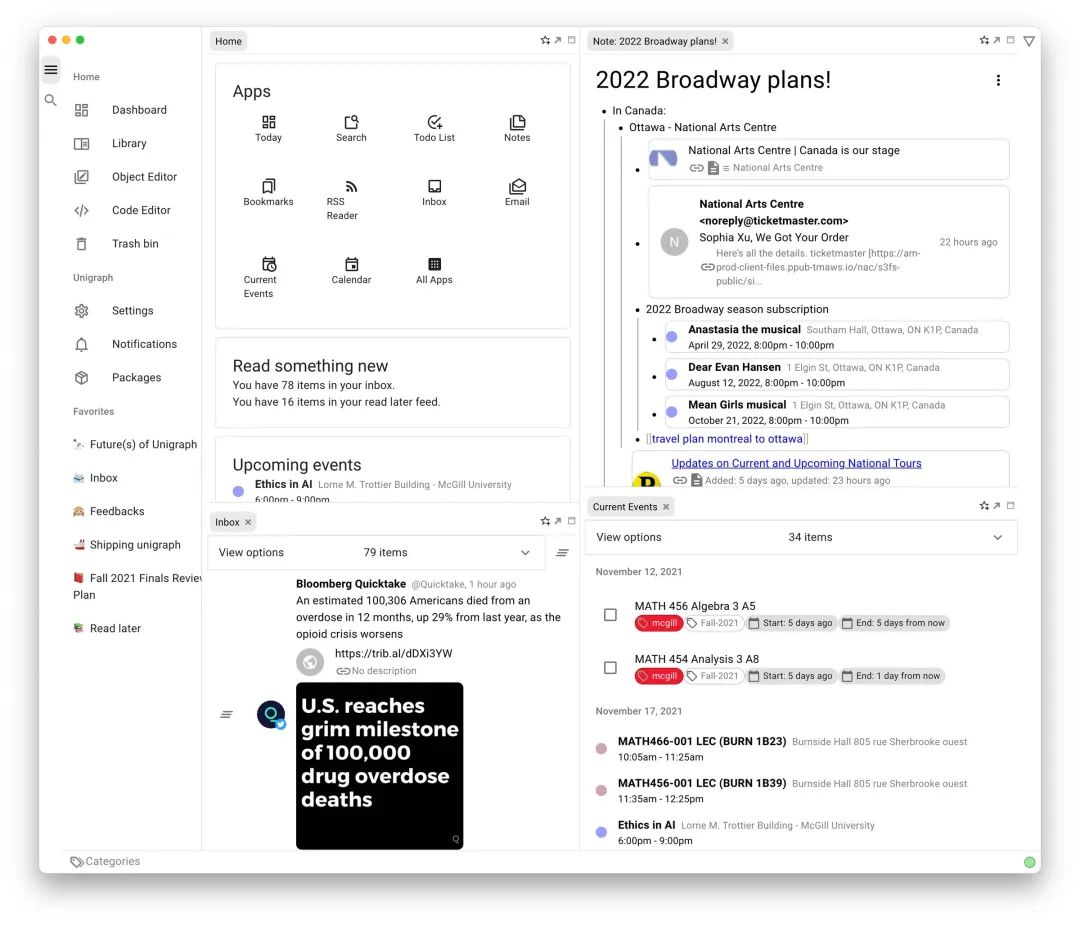

CogVLM2 est un modèle multimodal open source développé par le Tsinghua University Data Mining Research Group (THUDM), basé sur l'architecture Llama3-8B et conçu pour offrir des performances comparables, voire supérieures, à celles de GPT-4V. Le modèle prend en charge la compréhension d'images, le dialogue à plusieurs tours et la compréhension de vidéos, et est capable de traiter des contenus d'une longueur maximale de 8K et de prendre en charge des résolutions d'images allant jusqu'à 1344x1344. La famille CogVLM2 se compose de plusieurs sous-modèles optimisés pour différentes tâches, telles que les questions-réponses textuelles, les questions-réponses documentaires et les questions-réponses vidéo. Les modèles sont non seulement bilingues, mais ils offrent également une variété d'expériences en ligne et de méthodes de déploiement que les utilisateurs peuvent tester et appliquer.

Informations connexes :Combien de temps un grand modèle peut-il comprendre une vidéo ? Smart Spectrum GLM-4V-Plus : 2 heures

Liste des fonctions

- compréhension graphiqueLe logiciel de gestion de l'image : Il permet de comprendre et de traiter les images à haute résolution.

- un dialogue à plusieurs niveauxLes services d'aide à la décision : capables d'organiser plusieurs cycles de dialogue, ils conviennent aux scénarios d'interaction complexes.

- Compréhension vidéoLa technologie de l'image : permet de comprendre un contenu vidéo d'une durée maximale d'une minute en extrayant les images clés.

- Prise en charge multilingueLes langues : soutenir le bilinguisme chinois et anglais afin de s'adapter à des environnements linguistiques différents.

- open source (informatique)Le code source complet et les poids des modèles sont fournis pour faciliter le développement secondaire.

- Expérience en ligneLe modèle d'évaluation de la qualité de l'eau : fournit une plateforme de démonstration en ligne où les utilisateurs peuvent directement expérimenter les fonctionnalités du modèle.

- Options de déploiement multiplesSupport de Huggingface, ModelScope et d'autres plates-formes.

Utiliser l'aide

Installation et déploiement

- entrepôt de clones: :

git clone https://github.com/THUDM/CogVLM2.git

cd CogVLM2

- Installation des dépendances: :

pip install -r requirements.txt

- Télécharger le modèle de poidsTélécharger les poids de modèle appropriés et les placer dans le répertoire spécifié.

exemple d'utilisation

compréhension graphique

- Modèles de chargement: :

from cogvlm2 import CogVLM2

model = CogVLM2.load('path_to_model_weights')

- image de processus: :

image = load_image('path_to_image')

result = model.predict(image)

print(result)

un dialogue à plusieurs niveaux

- Initialisation du dialogue: :

conversation = model.start_conversation()

- organiser un dialogue: :

response = conversation.ask('你的问题')

print(response)

Compréhension vidéo

- Charger la vidéo: :

video = load_video('path_to_video')

result = model.predict(video)

print(result)

Expérience en ligne

Les utilisateurs peuvent accéder à la plateforme de démonstration en ligne CogVLM2 pour expérimenter les fonctionnalités du modèle en ligne sans avoir besoin d'un déploiement local.

© déclaration de droits d'auteur

L'article est protégé par le droit d'auteur et ne doit pas être reproduit sans autorisation.

Articles connexes

Pas de commentaires...