DeepGemini : orchestration multi-modèle des tâches et encapsulation dans une interface API

Introduction générale

DeepGemini est un projet open source créé par le développeur Thomas Sligter. Il s'agit d'un outil de gestion de l'IA qui prend en charge l'orchestration multi-modèle, la principale caractéristique étant la capacité de combiner de manière flexible une variété de modèles d'IA, et appelé par l'interface API compatible avec OpenAI. Le projet est basé sur Python 3.11 et FastAPI, prend en charge la configuration du stockage de la base de données SQLite, et fournit une interface de gestion Web et un déploiement Docker. Il convient aux développeurs, aux passionnés de technologie et aux utilisateurs en entreprise, et la licence MIT permet une utilisation et une modification libres.DeepGemini prend en charge les interfaces chinoises et anglaises, et est riche en fonctionnalités et facile à utiliser.

Le projet a configuré des flux de travail multi-modèles et des groupes de discussion multi-modèles dans l'interface, qui ne pouvaient pas être utilisés directement dans l'interface et devaient être configurés dans d'autres outils de chat pour utiliser l'API. Cet outil est plus simple et plus pratique que les outils habituels de planification des tâches pour les intelligences, le seul inconvénient étant qu'il consomme plus de quota API.

Liste des fonctions

- Prise en charge de l'orchestration multimodèle, ce qui vous permet de personnaliser la combinaison de plusieurs modèles d'IA pour accomplir une tâche.

- Permet de gérer les personnages et de définir différentes personnalités et compétences pour l'IA.

- Prise en charge des groupes de discussion, où plusieurs personnages IA peuvent collaborer à des discussions.

- Divers modes de discussion sont intégrés, notamment le brainstorming, le débat et l'analyse SWOT.

- Compatible avec de nombreux fournisseurs d'IA tels que DeepSeek, Claude, Gemini, Grok3 et bien d'autres.

- Fournit une interface API compatible avec l'OpenAI qui remplace directement l'interface OpenAI dans les applications existantes.

- Prise en charge de la réponse en continu en temps réel pour améliorer l'expérience de l'utilisateur.

- Interface de gestion web intégrée pour faciliter la configuration du modèle et la vérification de l'état.

- Prise en charge de la base de données SQLite et de la migration Alembic pour une configuration de gestion plus stable.

Utiliser l'aide

L'installation et l'utilisation de DeepGemini sont divisées en deux façons : l'opération locale et le déploiement Docker. Voici une description détaillée des étapes d'installation et des procédures d'exploitation fonctionnelle pour aider les utilisateurs à démarrer rapidement.

Processus d'installation - exécution locale

- Clonage du code du projet

Entrez la commande suivante dans le terminal pour télécharger le projet :

git clone https://github.com/sligter/DeepGemini.git

Allez ensuite dans le répertoire du projet :

cd DeepGemini

- Installation des dépendances

Recommandé pour les projetsuvL'outil installe les dépendances et s'exécute :

uv sync

Si ce n'est pas le cas uvVous pouvez utiliser le pip install -r requirements.txt Autre solution. Assurez-vous que la version de Python est 3.11 ou supérieure.

- Configuration des variables d'environnement

Copiez le fichier de configuration de l'exemple :

cp .env.example .env

Ouvrir avec un éditeur de texte .env, définissez les champs obligatoires suivants :

ALLOW_API_KEYVotre clé API, il suffit de la définir vous-même.ALLOW_ORIGINS: la source du nom de domaine autorisé, remplissez le champ*Indique que tous sont autorisés ou que des virgules sont utilisées pour séparer des domaines spécifiques.

Les configurations optionnelles comprennent les clés et les paramètres de l'API du modèle (tels que l'optionDEEPSEEK_API_KEY).

- Démarrage des services

Entrez la commande suivante pour démarrer :

uv run uvicorn app.main:app --host 0.0.0.0 --port 8000

Une fois le lancement réussi, ouvrez votre navigateur et visitez http://localhost:8000/dashboardSi vous souhaitez accéder à l'interface de gestion web, vous pouvez le faire en cliquant sur le lien suivant.

Processus d'installation - Déploiement Docker

- Extraction d'une image Docker

S'exécute dans le terminal :

docker pull bradleylzh/deepgemini:latest

- Préparation des fichiers de configuration et des bases de données

Crée un fichier dans le répertoire actuel :

- Linux/Mac :

cp .env.example .env touch deepgemini.db echo "" > deepgemini.db - Windows PowerShell :

cp .env.example .env echo "" > deepgemini.db

compilateur .envParamètres ALLOW_API_KEY répondre en chantant ALLOW_ORIGINS.

- Exécution des conteneurs Docker

Saisissez la commande de démarrage :

- Linux/Mac :

docker run -d -p 8000:8000 -v $(pwd)/.env:/app/.env -v $(pwd)/deepgemini.db:/app/deepgemini.db --name deepgemini bradleylzh/deepgemini:latest - Windows PowerShell :

docker run -d -p 8000:8000 -v ${PWD}\.env:/app/.env -v ${PWD}\deepgemini.db:/app/deepgemini.db --name deepgemini bradleylzh/deepgemini:latest

Après l'exécution, accédez à la page http://localhost:8000/dashboard.

Utiliser Docker Compose (recommandé)

- vouloir

.envet les fichiers de base de données, comme décrit ci-dessus. - La course à pied :

docker-compose up -d

entretiens http://localhost:8000/dashboard.

Principales fonctions

1. fonctionnement de l'interface de gestion Web

- Ouvrez votre navigateur et visitez

http://localhost:8000/dashboard. - L'interface affiche l'état du modèle et les options de configuration. Cliquez sur "Ajouter un modèle", entrez le nom du modèle (par exemple, DeepSeek), la clé API et les paramètres (température, top_p, etc.), puis enregistrez.

- Dans la Gestion des rôles, créez un rôle d'IA et définissez la personnalité (par exemple, "Rigueur logique") et les compétences (par exemple, "Génération de texte").

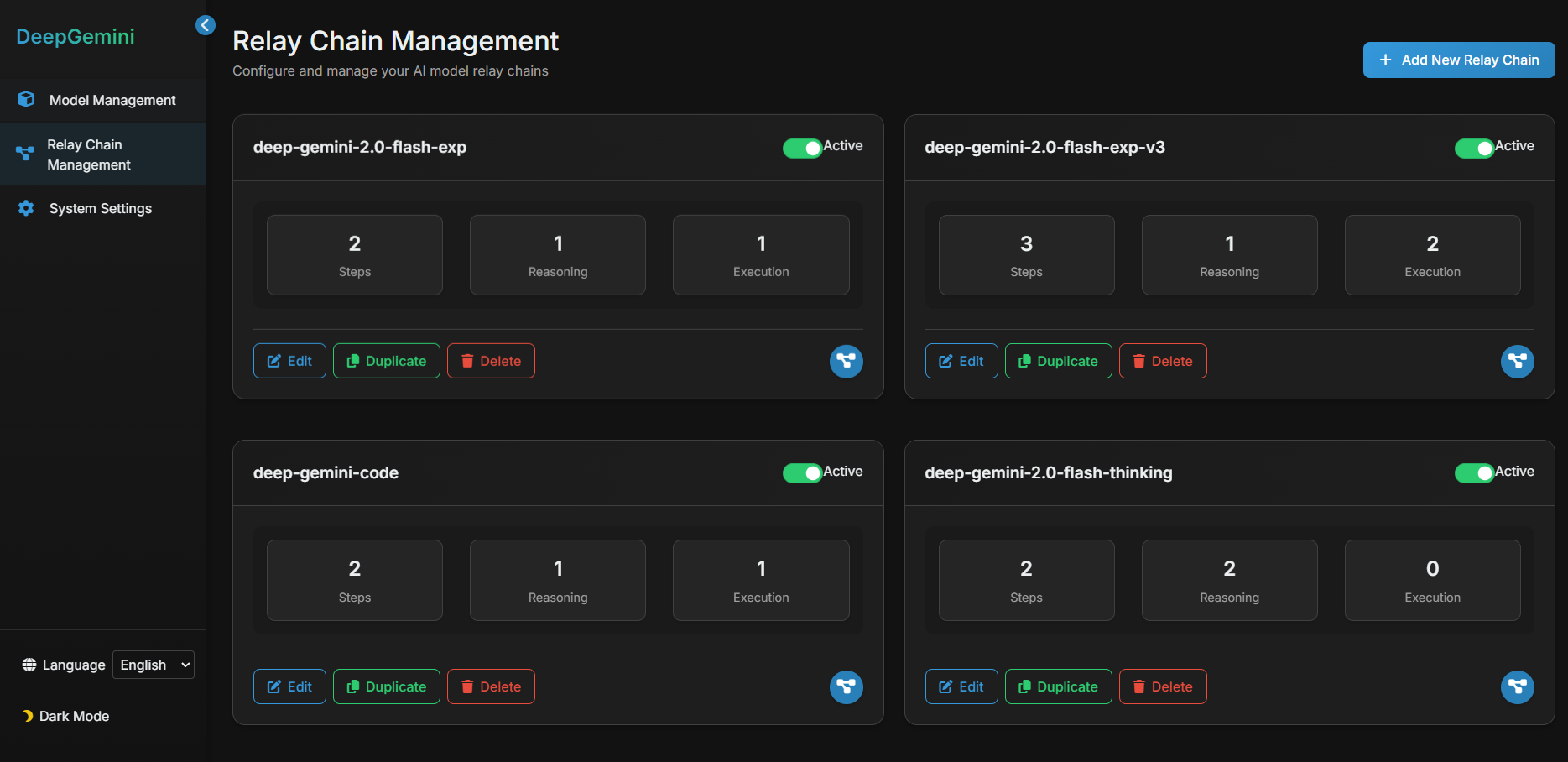

2. configurer l'orchestration multi-modèle

- Dans l'écran Flux de travail, cliquez sur Nouveau flux de travail.

- Exemple de configuration :

{

"name": "reason_and_execute",

"steps": [

{"model_id": "deepseek", "step_type": "reasoning", "step_order": 1},

{"model_id": "claude", "step_type": "execution", "step_order": 2}

]

}

- Une fois sauvegardé, le flux de travail sera raisonné avec DeepSeek avant de générer des résultats avec Claude.

3. appeler l'interface API

- utiliser

curlTester l'API :

curl -X POST "http://localhost:8000/v1/chat/completions" -H "Authorization: Bearer YOUR_API_KEY" -H "Content-Type: application/json" -d '{"model": "reason_and_execute", "messages": [{"role": "user", "content": "分析并回答:1+1等于几?"}]}'

- l'interchangeabilité

YOUR_API_KEYen raison de.envdans la clé. Le résultat est une réponse en continu.

4. création de groupes de discussion

- Sur la page Groupes de discussion, ajoutez plusieurs rôles (tels qu'analyste et créateur).

- Sélectionnez un mode de discussion (par exemple, "Remue-méninges"), saisissez une question et cliquez sur "Commencer la discussion". Le système affiche le dialogue entre les personnages.

mise en garde

- Assurez-vous que la connexion réseau fonctionne correctement, car certains modèles nécessitent l'accès à des API externes.

- Les fichiers journaux se trouvent dans le répertoire

<项目目录>/logs/qui peut être utilisé pour résoudre les problèmes. - S'il y a un conflit de port pendant le déploiement de Docker, vous pouvez modifier le paramètre

-p 8000:8000Le premier numéro de port dans le

scénario d'application

- Expériences de développement de l'IA

Les développeurs peuvent tester la collaboration multi-modèle avec DeepGemini. Par exemple, commencez avec Gémeaux Analyser la question et utiliser Claude pour élaborer une réponse détaillée. - Simulation de travail en équipe

Simulez des réunions d'équipe grâce à la fonction de groupe de discussion. Définissez différents rôles pour discuter des stratégies de produits et émettre diverses suggestions. - Éducation et formation

Les élèves peuvent l'utiliser pour se familiariser avec les propriétés des modèles d'IA et expérimenter différents modes de discussion pour observer les résultats.

QA

- Quels sont les fournisseurs d'IA pris en charge ?

Prise en charge de DeepSeek, Claude, Gemini, Grok3, OpenAI, etc., avec un accès personnalisé à d'autres fournisseurs. - Quel est l'intérêt d'un groupe de discussion ?

Les groupes de discussion permettent à plusieurs personas d'IA de collaborer sur des problèmes complexes, tels que le brainstorming ou le débat, en fournissant des perspectives multiples sur les réponses. - Comment déboguer un problème ?

Consultez les fichiers journaux ou déposez un problème sur GitHub pour obtenir de l'aide.

© déclaration de droits d'auteur

L'article est protégé par le droit d'auteur et ne doit pas être reproduit sans autorisation.

Articles connexes

Pas de commentaires...