FramePack : 6G de mémoire graphique faible croissance rapide de la vidéo longue projet open source

Introduction générale

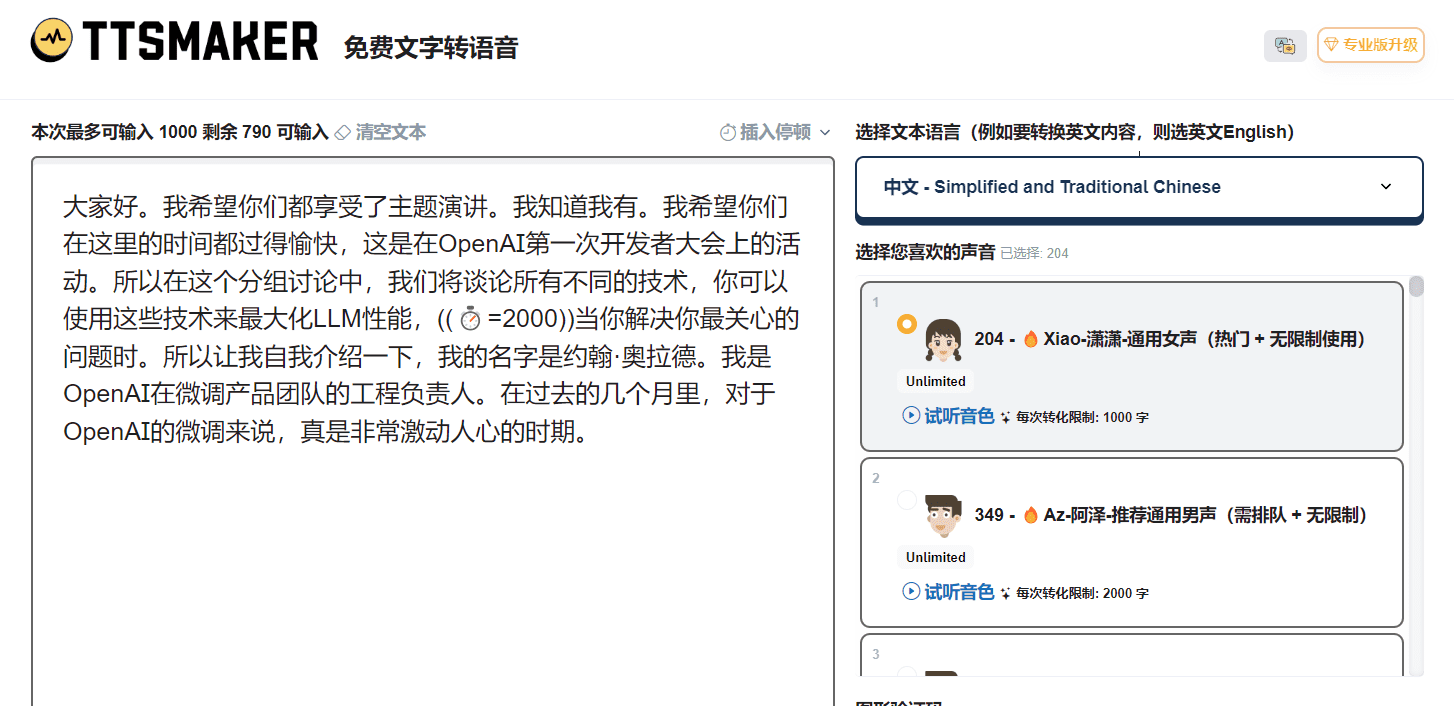

FramePack est un outil de génération vidéo open source qui vise à rendre les techniques de diffusion vidéo plus pratiques. Il découple l'effort de génération de la longueur de la vidéo en compressant les images d'entrée à une longueur fixe par le biais d'un réseau neuronal unique de prédiction de l'image suivante. FramePack peut générer des milliers d'images à 30 images par seconde avec seulement 6 Go de mémoire graphique, ce qui le rend adapté au GPU grand public moyen. Le projet a été développé par Lvmin Zhang et est basé sur le modèle vidéo Hunyuan optimisé pour seulement 1,3 milliard de paramètres de modèle, combinant l'efficacité et la légèreté. framePack FramePack fournit une interface Gradio facile à utiliser qui prend en charge la génération d'image à vidéo à une vitesse optimisée allant jusqu'à 1,5 seconde par image. Il convient aux créateurs de contenu, aux développeurs et aux utilisateurs généraux intéressés par la génération de vidéos.

Liste des fonctions

- Génération d'images et de vidéos : générez des vidéos animées à partir d'une seule image, avec prise en charge des extensions vidéo longues.

- Optimisation de la mémoire vive : 60 secondes de vidéo à 30 images par seconde peuvent être générées avec seulement 6 Go de mémoire vive.

- Prédiction de l'image suivante : générer une charge de travail indépendante de la durée de la vidéo en compressant le contexte.

- Interface utilisateur Gradio : elle offre des fonctions intuitives pour le téléchargement d'images, la saisie d'invites et la prévisualisation des vidéos générées.

- Prise en charge de mécanismes d'attention multiples : PyTorch, xformers, flash-attn et sage-attention sont pris en charge.

- Compatibilité multiplateforme : prend en charge Linux et Windows et est compatible avec les GPU NVIDIA RTX 30XX/40XX/50XX.

- Vitesse de génération optimisée : optimisée avec teacache pour atteindre 1,5 seconde par image.

- Prise en charge de l'entraînement par lots : prise en charge de l'entraînement par lots de très grande taille, similaire à la diffusion d'images.

Utiliser l'aide

Processus d'installation

L'installation de FramePack est plus technique et convient aux utilisateurs ayant une certaine expérience de la configuration des environnements Python et GPU. Vous trouverez ci-dessous les étapes détaillées de l'installation pour les systèmes Windows et Linux, ainsi que des références à la page officielle GitHub et à des ressources web.

Exigences environnementales

- système d'exploitation: Linux ou Windows.

- GPUNVIDIA RTX 30XX/40XX/50XX avec support fp16 et bf16 (GTX 10XX/20XX non testé).

- mémoireLa capacité de stockage est de : 6 Go minimum (pour 60 secondes de vidéo à 30 images/seconde).

- Version PythonPython 3.10 est recommandé (note : les versions de Python doivent être strictement identiques, sous peine d'incompatibilités entre les bibliothèques).

- CUDALes versions de CUDA compatibles avec les GPU (par exemple CUDA 12.6) doivent être installées.

Étapes de l'installation

- Clone FramePack Warehouse

Ouvrez un terminal ou une invite de commande et exécutez la commande suivante pour cloner le projet :git clone https://github.com/lllyasviel/FramePack.git cd FramePack - Créer un environnement virtuel

Pour éviter les conflits de dépendances, il est recommandé de créer un environnement virtuel Python :python -m venv venvActiver l'environnement virtuel :

- Fenêtres :

venv\Scripts\activate.bat - Linux :

source venv/bin/activate

- Fenêtres :

- Installation de PyTorch et de ses dépendances

Installez PyTorch en fonction de la version CUDA (CUDA 12.6 par exemple) :pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu126Installer les dépendances du projet :

pip install -r requirements.txt - (Facultatif) Installation de Sage Attention ou de Flash Attention

Pour améliorer les performances, vous pouvez installer Sage Attention (vous devez choisir le bon fichier de roue pour votre version CUDA et Python) :pip install https://github.com/woct0rdho/SageAttention/releases/download/v2.1.1-windows/sageattention-2.1.1+cu126torch2.6.0-cp312-cp312-win_amd64.whlNote : Sage Attention peut légèrement affecter la qualité de la génération, qui peut être ignorée pour les utilisateurs débutants.

- Lancement de l'interface Gradio

Une fois l'installation terminée, exécutez la commande suivante pour lancer l'interface :python demo_gradio.pyAprès le démarrage, le terminal affiche quelque chose comme

http://127.0.0.1:7860/Vous pouvez accéder à l'interface Gradio de FramePack en visitant l'URL dans votre navigateur.

Problèmes d'installation courants

- Inadéquation de la version de PythonSi l'installation des dépendances échoue, vérifiez que la version de Python est bien la 3.10. Utilisez la commande

python --versionVoir la version actuelle. - Conflit de dépendanceSi

requirements.txtest incompatible, vous pouvez supprimer la version de la bibliothèqueav,numpy,scipyla désignation de la version, réinstallez la dernière version :pip install av numpy scipy - mémoire vidéo insuffisanteSi la mémoire vidéo est inférieure à 6 Go, la génération peut échouer. Il est recommandé d'utiliser un GPU avec une mémoire plus importante ou de réduire la durée de la vidéo.

Utilisation

La fonction principale de FramePack est de générer de la vidéo à partir d'une seule image et de prendre en charge le contrôle du contenu vidéo à l'aide de mots clés. La procédure d'utilisation détaillée est décrite ci-dessous.

1. accès à l'interface Gradio

activer (un plan) demo_gradio.py Le navigateur affiche ensuite l'interface utilisateur de FramePack. L'interface est divisée en sections gauche et droite :

- À gauche : téléchargez des images et saisissez des mots d'incitation.

- À droite : affiche la vidéo générée et un aperçu latent (aperçu latent).

2. téléchargement d'images

Cliquez sur la zone de téléchargement d'images à gauche et sélectionnez une image locale (résolution recommandée 544x704 ou taille similaire). FramePack génère un contenu vidéo basé sur cette image.

3. les invites de saisie

Saisissez une courte phrase décrivant l'action de la vidéo dans la zone de texte Mot clé. Il est recommandé d'utiliser des mots-clés succincts et orientés vers l'action, par exemple :

The girl dances gracefully, with clear movements, full of charm.A robot jumps energetically, spinning in a futuristic city.

FramePack recommande officiellement de générer le repère d'action via GPT au format :

Vous êtes un assistant qui rédige des messages courts, axés sur le mouvement, pour animer des images. Lorsque l'utilisateur envoie une image, répondez par un message unique et concis décrivant le mouvement visuel. décrivant le mouvement visuel.

4. génération de vidéos

Cliquez sur le bouton Générer dans l'interface et FramePack lancera le processus. Le processus de génération se déroule par segments, chaque segment générant environ 1 seconde de vidéo, qui est progressivement assemblée pour former une vidéo complète. La progression de la génération est indiquée par une barre de progression et une prévisualisation potentielle. Le fichier généré est enregistré dans le dossier ./outputs/ dossier.

5. visualisation et ajustement

Il se peut que vous n'obteniez qu'une courte vidéo (par exemple, 1 seconde) au début de la génération. C'est normal et vous devrez attendre que d'autres clips soient générés pour obtenir une vidéo complète. Si vous n'êtes pas satisfait du résultat, vous pouvez ajuster le mot de repère ou modifier l'image d'entrée pour la régénérer.

Optimiser la vitesse de génération

- commencer à utiliser teacache: L'activation du teacache dans les paramètres de génération fait passer la vitesse de 2,5 à 1,5 sec/image.

- Génération plus rapide avec des GPU haute performance : par exemple NVIDIA 4090.

- Désactiver sage-attention : si sage-attention est installé, il peut être désactivé pour le premier test afin de garantir la qualité de la génération.

Fonction en vedette Fonctionnement

Génération de faible mémoire

L'atout principal de FramePack est sa faible consommation de mémoire vidéo. En compressant le contexte d'entrée, seuls 6 Go de mémoire vidéo sont nécessaires pour générer 60 secondes de vidéo à 30 images par seconde. Aucune configuration supplémentaire n'est nécessaire et le système optimise automatiquement l'allocation de la mémoire graphique.

Prédiction de la trame suivante

FramePack génère des vidéos image par image en utilisant un réseau neuronal de prédiction de l'image suivante. Les utilisateurs peuvent visualiser des aperçus potentiels de chaque segment généré en temps réel dans l'interface Gradio pour s'assurer que le contenu vidéo est conforme aux attentes.

Interface Gradio

L'interface de Gradio est simple et intuitive et permet des téléchargements et des prévisualisations rapides. Les utilisateurs peuvent utiliser la fonction --share pour partager l'interface avec le réseau public, ou via le paramètre --port répondre en chantant --server Paramètres port personnalisé et adresse du serveur :

python demo_gradio.py --share --port 7861 --server 0.0.0.0

scénario d'application

- création de contenu

FramePack convient aux créateurs de vidéos pour générer de courtes vidéos dynamiques. Par exemple, générer une vidéo de danse à partir d'une image de personnage pour la production de contenu pour les médias sociaux. La faible quantité de mémoire vidéo requise permet à l'utilisateur moyen de démarrer facilement. - développement de jeux

Les développeurs peuvent utiliser FramePack pour générer des animations de scènes dynamiques telles que les mouvements des personnages ou les changements d'environnement, ce qui permet de gagner du temps sur la modélisation manuelle. Les modèles légers offrent des possibilités de rendu en temps réel. - Éducation et démonstration

Les enseignants ou les formateurs peuvent générer des vidéos pédagogiques à partir d'images fixes pour démontrer des processus dynamiques (par exemple, des simulations d'expériences scientifiques). L'interface de Gradio est facile à utiliser et convient aux utilisateurs non techniques. - informatique de pointe

Le modèle de 1,3 milliard de paramètres de FramePack est adapté au déploiement d'appareils périphériques tels que les appareils mobiles ou les systèmes intégrés pour la génération de vidéos localisées.

QA

- Quels sont les GPU pris en charge par FramePack ?

Prend en charge les GPU NVIDIA RTX 30XX, 40XX, 50XX avec un minimum de 6 Go de RAM. Les GTX 10XX/20XX n'ont pas été testées et peuvent ne pas être compatibles. - Combien de temps faut-il pour produire une vidéo ?

Sur le NVIDIA 4090, il est de 2,5 secondes/image sans optimisation et de 1,5 seconde/image avec le teacache activé. Il faut environ 3 à 4 minutes pour générer 5 secondes de vidéo. - Comment améliorer la qualité de la génération ?

Utilisez des images d'entrée de haute qualité, écrivez des indices d'action clairs, désactivez l'attention sage et désactivez le teacache pour une génération finale de haute qualité. - Est-il possible de générer des vidéos extra-longues ?

Oui, FramePack permet de générer des milliers d'images vidéo (par exemple, 60 secondes à 30 images par seconde). Les besoins en mémoire vidéo sont fixes et n'augmentent pas en fonction de la longueur de la vidéo.

© déclaration de droits d'auteur

L'article est protégé par le droit d'auteur et ne doit pas être reproduit sans autorisation.

Articles connexes

Pas de commentaires...