FunClip : montage intelligent de contenus vidéo en courts métrages, facilité d'extraction et de découpage précis de clips vidéo

Introduction générale

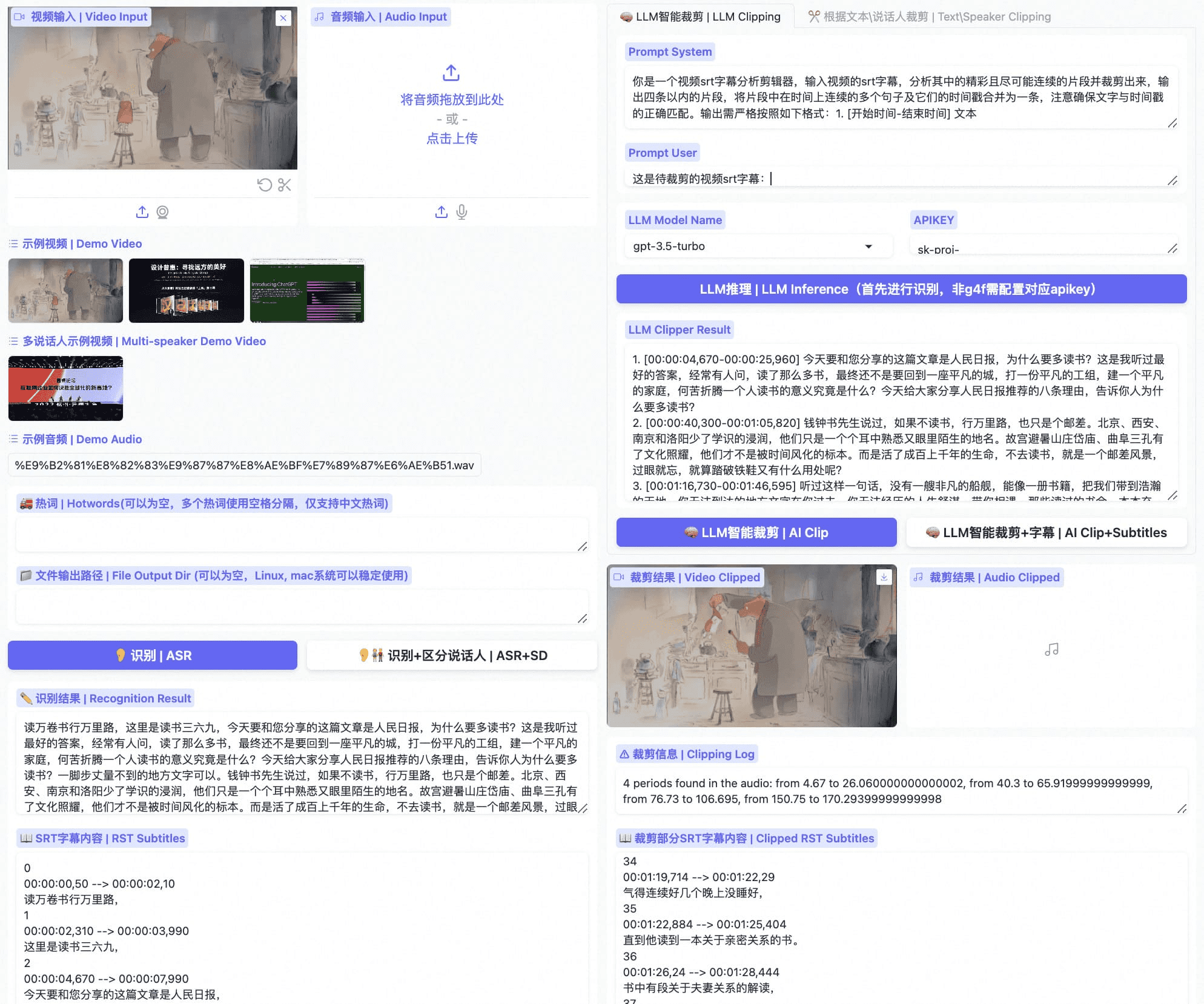

FunClip est un outil d'édition vidéo automatisé et localisé, entièrement open source, développé par le TONGYI Speech Lab de l'Alibaba Dharma Institute. L'outil intègre le modèle de reconnaissance vocale Paraformer-Large de qualité industrielle, qui peut identifier avec précision le contenu vocal de la vidéo et le convertir en texte. La particularité de FunClip est qu'il prend en charge l'édition intelligente grâce à la modélisation du langage large (LLM) et qu'il intègre la reconnaissance du locuteur afin d'identifier automatiquement les différents locuteurs. Les utilisateurs peuvent sélectionner les séquences de texte qui les intéressent et exporter les séquences vidéo correspondantes en un seul clic grâce à une interface simple. L'outil prend en charge l'édition libre de plusieurs segments et peut générer automatiquement des fichiers de sous-titres SRT complets et des sous-titres pour les segments cibles, offrant ainsi aux utilisateurs une expérience de traitement vidéo simple et pratique. La dernière version prend en charge la reconnaissance bilingue et fournit de riches fonctions d'intégration et d'exportation de sous-titres, ce qui en fait un outil de traitement vidéo open source puissant et facile à utiliser.

FunClip Optimisé - Private-ASR

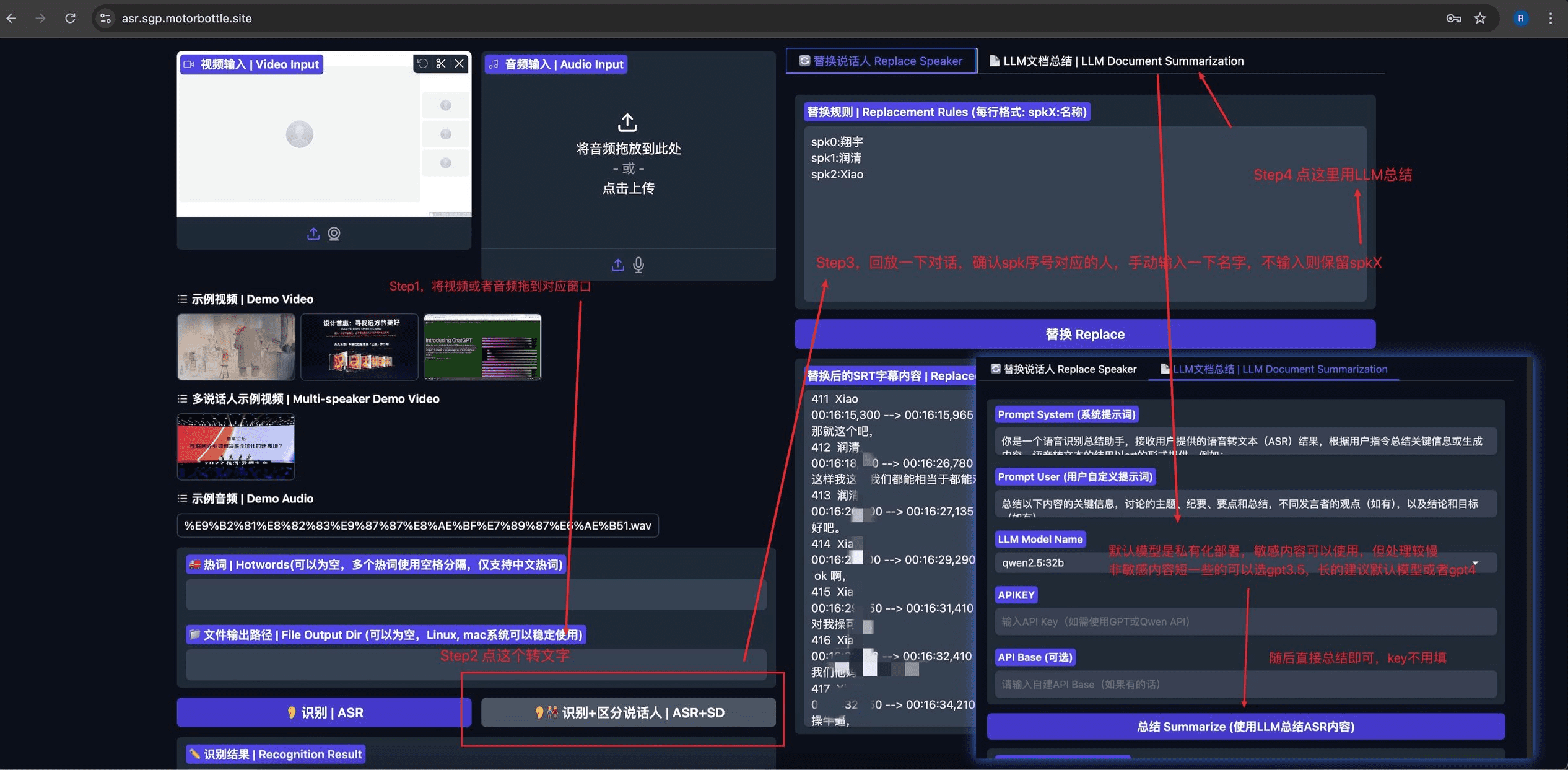

Privé-ASR Basé sur des projets open source FunClip Modifié pour intégrer la reconnaissance automatique de la parole (ASR), la séparation du locuteur, l'édition de sous-titres SRT et le résumé basé sur LLM. Le projet utilise Gradio Fournit une interface utilisateur intuitive et facile à utiliser.

Liste des fonctions

- Reconnaissance vocale précise : intégration du modèle Open Source Paraformer-Large d'Alibaba, prenant en charge la reconnaissance vocale en chinois et en anglais.

- LLM Intelligent Clip : analyse intelligente du contenu et détermination automatique des points d'accroche à l'aide d'un vaste modèle linguistique.

- Reconnaissance des locuteurs : intégration du modèle de reconnaissance des locuteurs CAM++, qui permet de reconnaître automatiquement l'identité des différents locuteurs.

- Personnalisation des mots chauds : la fonction de personnalisation des mots chauds de SeACo-Paraformer permet d'améliorer la précision de la reconnaissance de mots spécifiques.

- Édition multi-segments : sélection libre de plusieurs segments de texte pour l'édition par lots

- Génération de sous-titres : génère automatiquement des sous-titres SRT pour la vidéo complète et des sous-titres pour les clips cibles.

- Prise en charge bilingue : prise en charge de la reconnaissance et de l'édition vidéo en chinois et en anglais

- Déploiement local : source entièrement ouverte, soutien au déploiement local, protection de la vie privée et de la sécurité des données

- Interface conviviale : basée sur le développement du cadre Gradio, elle offre une interface web simple et intuitive.

Utiliser l'aide

1. installation et déploiement

Installation de l'environnement de base

- Cloner le dépôt de code :

git clone https://github.com/alibaba-damo-academy/FunClip.git

cd FunClip

- Installer les dépendances de Python :

pip install -r ./requirements.txt

Installation d'une fonctionnalité optionnelle (pour les sous-titres intégrés)

Pour utiliser la fonction d'intégration des sous-titres, vous devez installer ffmpeg et imagemagick :

- Ubuntu :

apt-get -y update && apt-get -y install ffmpeg imagemagick

sed -i 's/none/read,write/g' /etc/ImageMagick-6/policy.xml

- MacOS :

brew install imagemagick

sed -i 's/none/read,write/g' /usr/local/Cellar/imagemagick/7.1.1-8_1/etc/ImageMagick-7/policy.xml

- Fenêtres :

- Téléchargez et installez imagemagick depuis le site officiel : https://imagemagick.org/script/download.php#windows

- Recherchez le chemin d'installation de Python et modifiez le fichier

site-packages\moviepy\config_defaults.pya fait moucheIMAGEMAGICK_BINARYChemin d'installation pour imagemagick - Télécharger le fichier de police :

wget https://isv-data.oss-cn-hangzhou.aliyuncs.com/ics/MaaS/ClipVideo/STHeitiMedium.ttc -O font/STHeitiMedium.ttc

2. les méthodes d'utilisation

A. Utilisation du service Gradio local

- Démarrer le service :

python funclip/launch.py

# 使用 -l en 参数支持英文识别

# 使用 -p xxx 设置端口号

# 使用 -s True 开启公共访问

- entretiens

localhost:7860, suivez les étapes ci-dessous :

- Étape 1 : Chargement des fichiers vidéo

- Étape 2 : Copiez le clip de texte souhaité dans la zone "Text to Clip".

- Étape 3 : Ajustez les paramètres des sous-titres si nécessaire

- Étape 4 : Cliquez sur "Clip" ou "Clip et génération de sous-titres" pour éditer.

B. LLM Smart Clips

- Une fois la reconnaissance terminée, sélectionnez le modèle linguistique le plus large et configurez apikey

- Cliquez sur le bouton "LLM Inference" et le système combinera automatiquement les sous-titres vidéo avec les repères prédéfinis.

- Cliquez sur le bouton "AI Clip" pour extraire automatiquement les horodatages pour l'édition sur la base de la sortie du grand modèle linguistique.

- Le résultat d'un grand modèle linguistique peut être optimisé en modifiant les mots repères.

C. Utilisation de la ligne de commande

- Reconnaissance de la parole :

python funclip/videoclipper.py --stage 1 \

--file examples/video.mp4 \

--output_dir ./output

- Clip vidéo :

python funclip/videoclipper.py --stage 2 \

--file examples/video.mp4 \

--output_dir ./output \

--dest_text '待剪辑文本' \

--start_ost 0 \

--end_ost 100 \

--output_file './output/res.mp4'

En outre, les utilisateurs peuvent découvrir FunClip sur les plateformes en ligne suivantes :

- Espace ModelScope :FunClip@Modelscope Space

- HuggingFace空间:FunClip@HuggingFace Space

如遇到使用问题,可以通过项目提供的钉钉群或微信群获取社区支持。

© déclaration de droits d'auteur

L'article est protégé par le droit d'auteur et ne doit pas être reproduit sans autorisation.

Articles connexes

Pas de commentaires...