Configuration du MCP et tutoriels pratiques : connexion de l'IA et des applications communes

Dans un avenir proche.MCP(Model Context Protocol) attire l'attention des passionnés de technologie et des communautés de développeurs. Cette technologie vise à simplifier la façon dont les grands modèles de langage (LLM) interagissent avec une variété d'outils et de services externes, promettant de remodeler la façon dont nous utilisons l'IA pour traiter l'information et accomplir des tâches. Toutefois, comme c'est le cas pour de nombreuses technologies émergentes, laMCP a encore une courbe d'apprentissage pour les utilisateurs non experts.

Cet article se penche sur les MCP Il présente les concepts de base, fournit un guide de configuration complet et démontre, à l'aide d'une série d'exemples pratiques, comment utiliser le système de gestion de l'information. MCP Le fait de relier les modèles d'IA aux applications couramment utilisées (notes, recherche, outils de conception, etc.) a pour but d'aider les utilisateurs à comprendre et à appliquer plus facilement cette technologie prometteuse. L'article se concentrera sur la démonstration de l'utilisation de modèles d'IA dans un client de chat à usage général Chatwise Les opérations dans l'IDE de programmation de l'IA seront également couvertes. Windsurf Les étapes de la configuration dans le

Comprendre les valeurs fondamentales de MCP

Avant de se plonger dans les détails de la configuration, il est nécessaire de comprendre le concept de MCP Il s'agit d'une question d'intérêt général, qui doit être prise en compte dans la définition du problème qu'elle tente de résoudre et de ses valeurs fondamentales. Dans le passé, lorsque la nécessité de faire LLM L'utilisation d'outils spécifiques (par exemple, l'accès au courrier, l'interrogation de bases de données, le contrôle de logiciels) nécessite souvent une adaptation distincte pour chaque modèle et chaque outil. En effet, les différents outils API(Application Programming Interface), les formats de données varient, ce qui rend l'intégration complexe, longue et l'ajout de nouvelles fonctionnalités relativement lent.

MCP L'émergence du protocole vise à changer cette situation en créant un ensemble unifié de normes pour l'échange de données. Il définit la manière dont les applications doivent envoyer des données aux LLM Fournit des informations contextuelles et des spécifications sur les outils disponibles. Tout outil compatible MCP accord général LLM ou les applications d'intelligence artificielle peuvent, en principe, être utilisées avec toutes les applications d'intelligence artificielle prises en charge. MCP de l'outil d'interaction.

Cette normalisation réduit l'effort d'adaptation bidirectionnelle, autrement complexe (le modèle est adapté à l'outil, et l'outil doit envisager de s'adapter à un modèle différent), à une adaptation unidirectionnelle (principalement l'outil ou l'application qui suit le modèle). MCP (Normes). Plus important encore, pour ceux qui disposent déjà d'un service public d'information et d'éducation, il s'agit d'un service d'information. API d'applications existantes, les développeurs tiers peuvent également s'appuyer sur leurs API établir MCP afin de le rendre compatible avec les MCP sans avoir à attendre le soutien officiel des autochtones.

On peut se référer au concept illustré dans la figure ci-dessous, qui démontre graphiquement que MCP Comment agir en tant que couche intermédiaire pour unifier LLM Communication avec les outils de la diversité.

Pré-configuration

Au début de la configuration MCP Avant le service, les utilisateurs doivent comprendre et préparer un environnement de base. Il est important de noter que les différents systèmes d'exploitation (en particulier le système Windows avec macOS) Il peut y avoir des différences et des complexités potentielles dans la configuration de l'environnement et des paramètres du réseau. Les utilisateurs qui n'ont pas d'expérience en programmation peuvent avoir besoin d'une assistance technique supplémentaire s'ils rencontrent des problèmes insurmontables lors de la configuration.

MCP Il existe actuellement deux modes de fonctionnement principaux :

Stdio(Entrée/sortie standard): Principalement utilisé pour les services locaux. Dans ce mode.LLMInteragit avec des programmes ou des scripts exécutés localement via des flux d'entrée et de sortie standard, ce qui permet de manipuler des fichiers locaux et de contrôler des logiciels locaux (par exemple, un logiciel de modélisation 3D).Blender(et d'autres scénarios où il n'y a pas d'API en ligne).SSE(Événements envoyés par le serveur)Les services à distance : Principalement utilisés pour les services à distance. Lorsque l'outil lui-même fournit des services en ligneAPI(par exemple, lors de l'accès à l'applicationGooglemail, calendriers et autres services en nuage), généralement à l'aide de l'applicationSSEMode.LLMCommuniquer avec le serveur distant via un flux d'événements HTTP standard.

SSE La configuration du schéma est généralement plus simple, il suffit généralement de fournir un lien de service (URL), le processus de configuration est relativement simple, le présent document ne s'y attardera pas. Actuellement, la communauté est inondée de MCP Le service utilise principalement Stdio dont la configuration est un peu plus complexe et nécessite une certaine préparation.

configurer Stdio modal MCP qui s'appuient généralement sur des outils de ligne de commande spécifiques pour démarrer et gérer les services de la MCP de l'entreprise. Les commandes de démarrage les plus courantes sont les suivantes uvx répondre en chantant npx.

- montage

uv(fournir)uvxcommande): :uvIl s'agit d'une de ces choses qui sont composées deAstralL'installateur et l'analyseur de paquets Python, développés par l'entreprise, sont censés être extrêmement rapides, et certains des logiciels d'installation et d'analyse de paquets de Python ont été développés par l'entreprise.MCPL'outil l'utilise pour fonctionner.- Utilisateur Windows: Presse

WinAppuyez sur le bouton "PowerShell", recherchez "PowerShell", faites un clic droit et sélectionnez "Exécuter en tant qu'administrateur", collez et exécutez la commande suivante. Il est recommandé de redémarrer l'ordinateur une fois l'opération terminée.powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex" - Utilisateurs de macOSPour cela, ouvrez le Launchpad, recherchez et lancez l'application Terminal, collez et exécutez la commande suivante.

curl -LsSf https://astral.sh/uv/install.sh | sh

- Utilisateur Windows: Presse

- montage

Node.js(fournir)npxcommande): :npxêtreNode.jsqui permet à l'utilisateur d'exécuternpmsans avoir à installer ces paquets globalement. L'accès à l'interfaceNode.jsSite officiel (https://nodejs.org/), téléchargez la version LTS (Long Term Support) pour votre système d'exploitation et suivez la procédure standard pour terminer l'installation.

Une fois que vous avez terminé la préparation de l'environnement ci-dessus, vous pouvez commencer à obtenir et à configurer les éléments suivants MCP Servi.

Obtenir des informations sur la configuration du service MCP

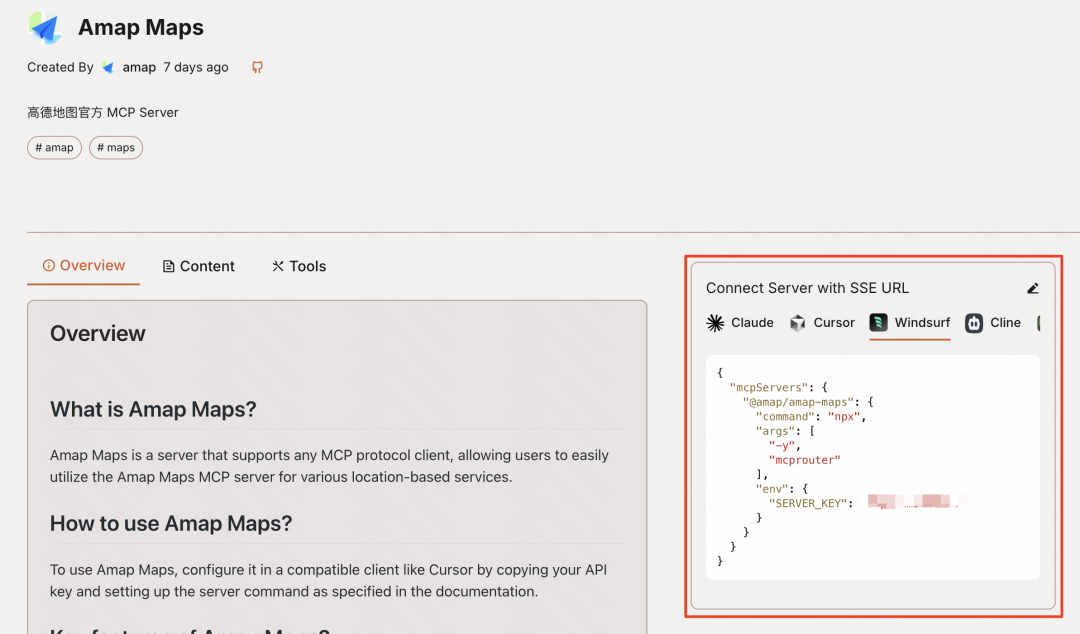

dans le sillage de MCP La popularité croissante de l'entreprise a donné lieu à l'émergence d'un certain nombre d'entreprises. MCP Sites d'agrégation de services tels que MCP.so répondre en chantant Smithery.ai (https://smithery.ai/), etc. Ces plateformes collectent et affichent une variété d'informations fournies par la communauté ou les développeurs. MCP Services.

Ces sites agrégateurs sont généralement utilisés de la même manière : les utilisateurs peuvent parcourir le site ou y effectuer des recherches pour obtenir les informations souhaitées. MCP Services. Pour ceux qui ont besoin API avec des clés ou d'autres informations d'identification, le site explique généralement comment obtenir ces informations dans la zone d'introduction (la section sur les cas ci-dessous fournit également quelques services courants). API (Lignes directrices d'accès). L'utilisateur saisit les API Une fois la clé ou le paramètre généré, le site génère automatiquement la clé utilisée pour l'importation dans différents clients (par exemple, l'application Windsurf peut-être Chatwise(souligné par l'auteur) JSON Code de configuration ou arguments de ligne de commande correspondants.

Les sections suivantes sur la configuration décriront chacune la manière dont le Windsurf répondre en chantant Chatwise Ces deux clients ajoutent et configurent MCP Service. Les utilisateurs peuvent sélectionner le guide approprié en fonction du client qu'ils utilisent.

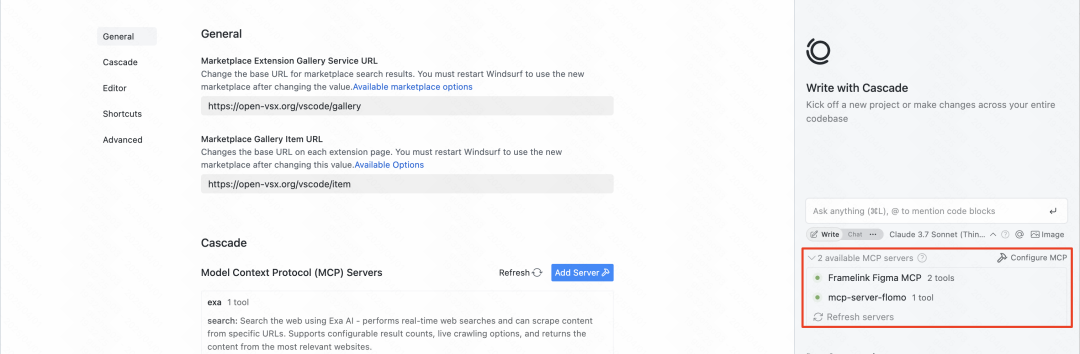

Configuration des services MCP : Guide de la planche à voile

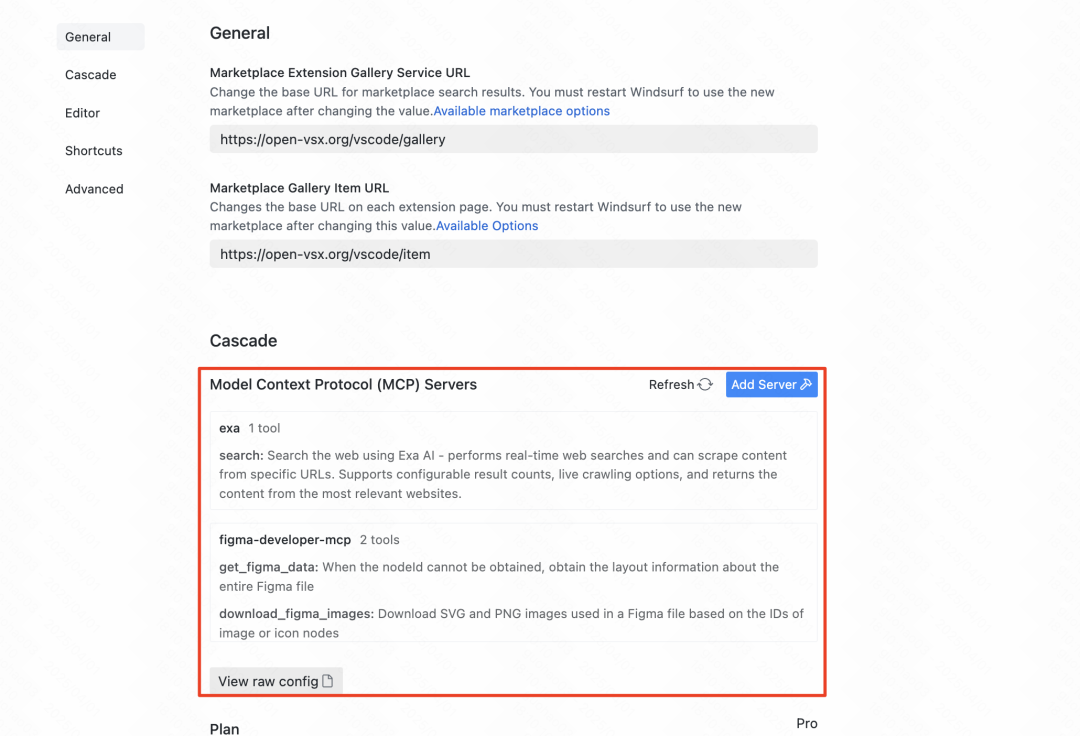

Pour l'utilisation de Windsurf Les utilisateurs de cet IDE de programmation de l'IA configurent le système de gestion de l'information de l'entreprise. MCP Les services sont relativement intégrés.

- Ouvrir les paramètresCliquez sur l'avatar de l'utilisateur dans le coin supérieur droit de l'interface et sélectionnez "Windsurf Settings".

- Recherche de la configuration MCPPour cela, il faut trouver l'option "Serveurs MCP" dans le menu "Paramètres".

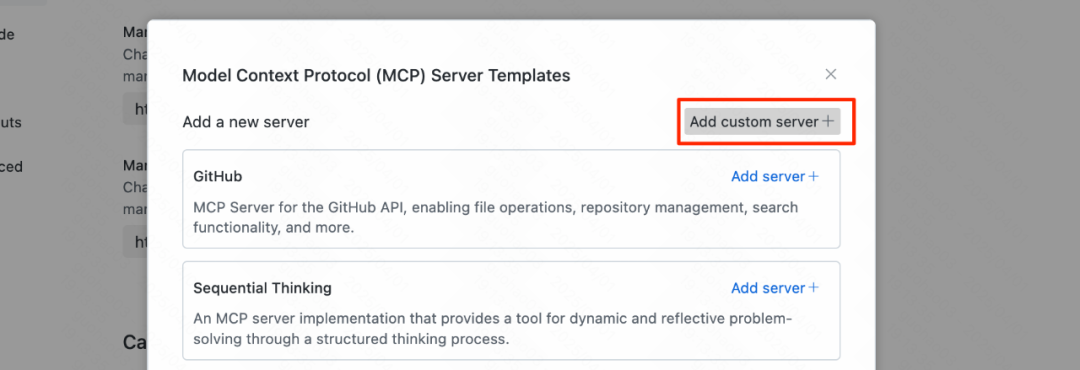

- Ajouter un serviceCliquez sur le bouton "Ajouter un serveur" à droite.

Windsurf L'un des avantages de ce système est qu'il comporte des éléments intégrés couramment utilisés. MCP les utilisateurs peuvent l'activer directement. En même temps, étant donné que le Windsurf est un IDE populaire que de nombreux MCP Les sites agrégateurs fourniront des adaptations directes Windsurf (utilisé comme expression nominale) JSON Code de configuration.

Si vous avez besoin d'ajouter une liste autre que la liste intégrée de MCP vous pouvez cliquer sur le bouton "Ajouter un serveur personnalisé".

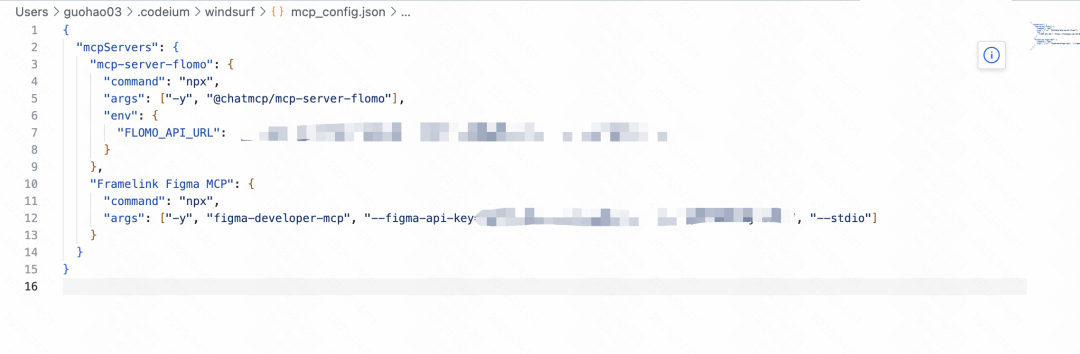

Après avoir cliqué sur le boutonWindsurf ouvrira un JSON Fichier de configuration (mcp_servers.json). Les utilisateurs devront copier à partir du site de l'agrégateur le fichier MCP service JSON Le code de configuration est collé dans ce fichier.

prendre noteLorsque l'on modifie ce fichier pour ajouter plusieurs serveurs personnalisés, le nom de l'utilisateur du nouveau serveur est remplacé par le nom de l'utilisateur du serveur. JSON (en général, la clé est l'identifiant du service et l'objet contient l'élément command, env et d'autres attributs de l'objet) est ajouté à l'élément mcpServers en interne, avec d'autres objets de service préexistants, et s'assurer que l'ensemble de l'objet JSON La syntaxe du fichier est structurée correctement (par exemple, les objets sont séparés par des virgules). Les éléments suivants mcp_servers.json La structure de base de la

{

"mcpServers": {

"server_id_1": {

// Server 1 configuration details

},

"server_id_2": {

// Server 2 configuration details

}

// Add more servers here, separated by commas

}

}

S'il est nécessaire de JSON Si la syntaxe ne vous est pas familière, vous pouvez copier tout le contenu du fichier de configuration et demander à un assistant IA (tel que Claude peut-être Deepseek) Vérifiez les erreurs de syntaxe et corrigez-les. Collez la correction dans le fichier et veillez à enregistrer les modifications.

Lorsque la configuration est terminée, revenez à l'écran Windsurf (utilisé comme expression nominale) MCP Servers Écran des paramètres. Si la configuration est correcte, vous devriez voir dans la liste les éléments suivants ajoutés MCP et son indicateur d'état est vert. Un indicateur rouge signifie qu'il y a un problème de configuration et qu'il faut vérifier la configuration du service. JSON ou les commandes correspondantes, ou encore les variables d'environnement.

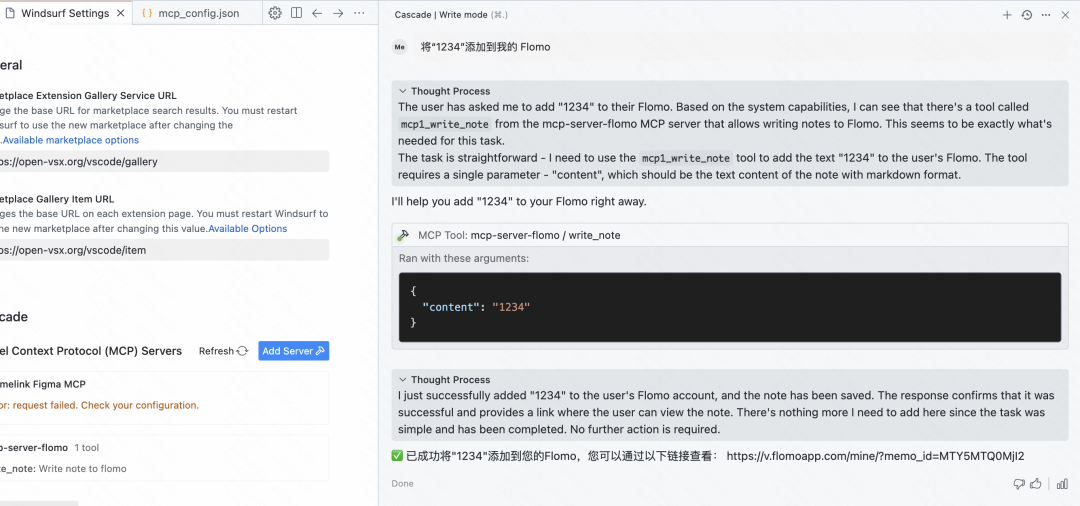

Ajout et activation réussis MCP Après le service, les utilisateurs peuvent directement Windsurf dans une interface de discussion ou d'édition de code, et adresser à l'IA, en langage naturel, des demandes nécessitant l'utilisation de l'outil. Par exemple, l'IA pourrait être chargée d'ajouter un élément de contenu directement sur le site Web de l'utilisateur. Flomo Dans les notes.

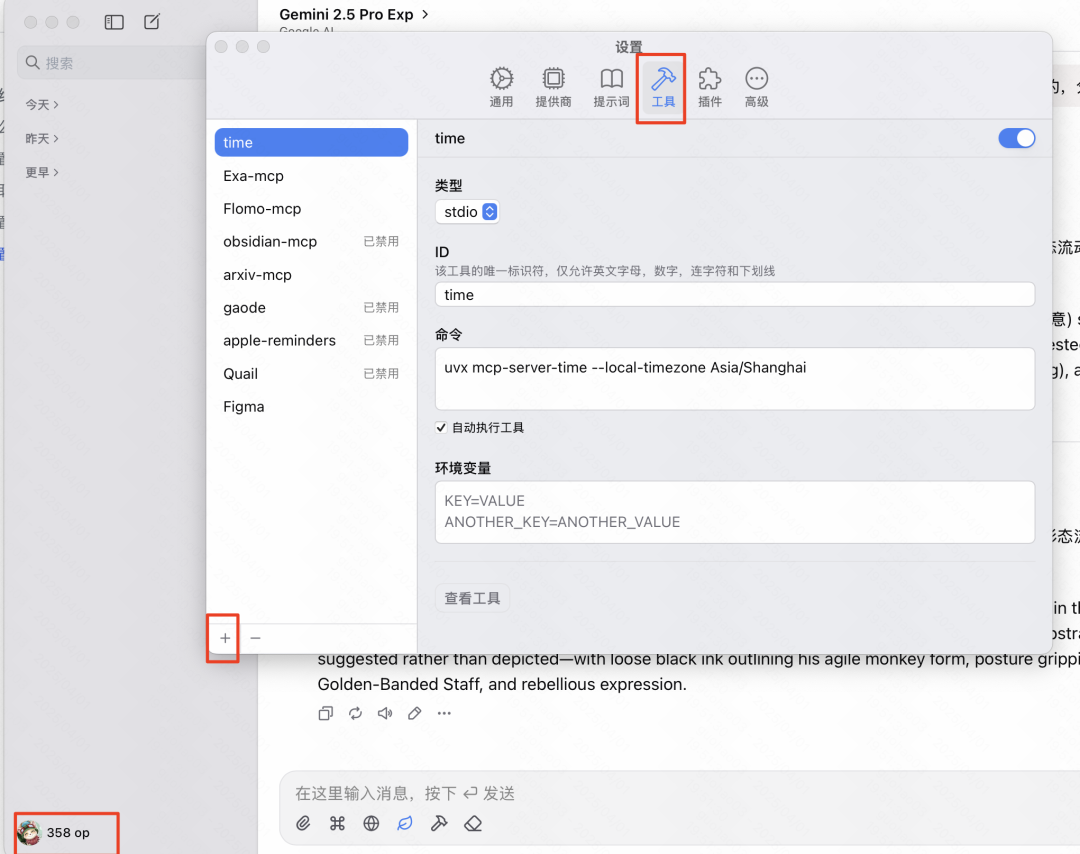

Configuration des services MCP : Guide du chat

Pour la communauté plus large des utilisateurs non-développeurs, l'applicationChatwise Un tel client de chat IA pourrait être un outil plus couramment utilisé.Chatwise (utilisé comme expression nominale) MCP L'interface de configuration est relativement intuitive, mais il est essentiel de définir correctement la ligne de commande et les variables d'environnement.

Importation pratique de JSON :

Heureusement.Chatwise Les dernières mises à jour ont permis d'importer directement à partir du presse-papiers ! JSON ce qui simplifie grandement le processus de configuration.

- existent

ChatwiseCliquez sur l'icône "+" dans le coin inférieur gauche pour ajouter. - Sélectionnez l'option Importer Json depuis le presse-papiers.

- Si le presse-papiers contient déjà un fichier de la rubrique

MCPSites d'agrégation ouWindsurfValable pour la réplication dans les configurationsJSONCode.Chatwisetentera d'analyser et de remplir automatiquement les informations de configuration.

Configurer manuellement le processus :

S'il n'est pas possible d'utiliser le JSON Pour l'importation ou si vous avez besoin de faire des ajustements manuels, vous pouvez suivre les étapes ci-dessous :

- Ouvrir les paramètres: Cliquez

ChatwiseAvatar de l'utilisateur dans le coin inférieur gauche pour accéder au menu des paramètres. - Trouver la gestion des outilsPour cela, il faut trouver le portail de gestion "Outils" ou un portail similaire dans les paramètres.

- Ajouter de nouveaux outilsCliquez sur l'icône "+" dans le coin inférieur gauche de l'interface pour commencer à ajouter un nouvel élément.

MCPServices.

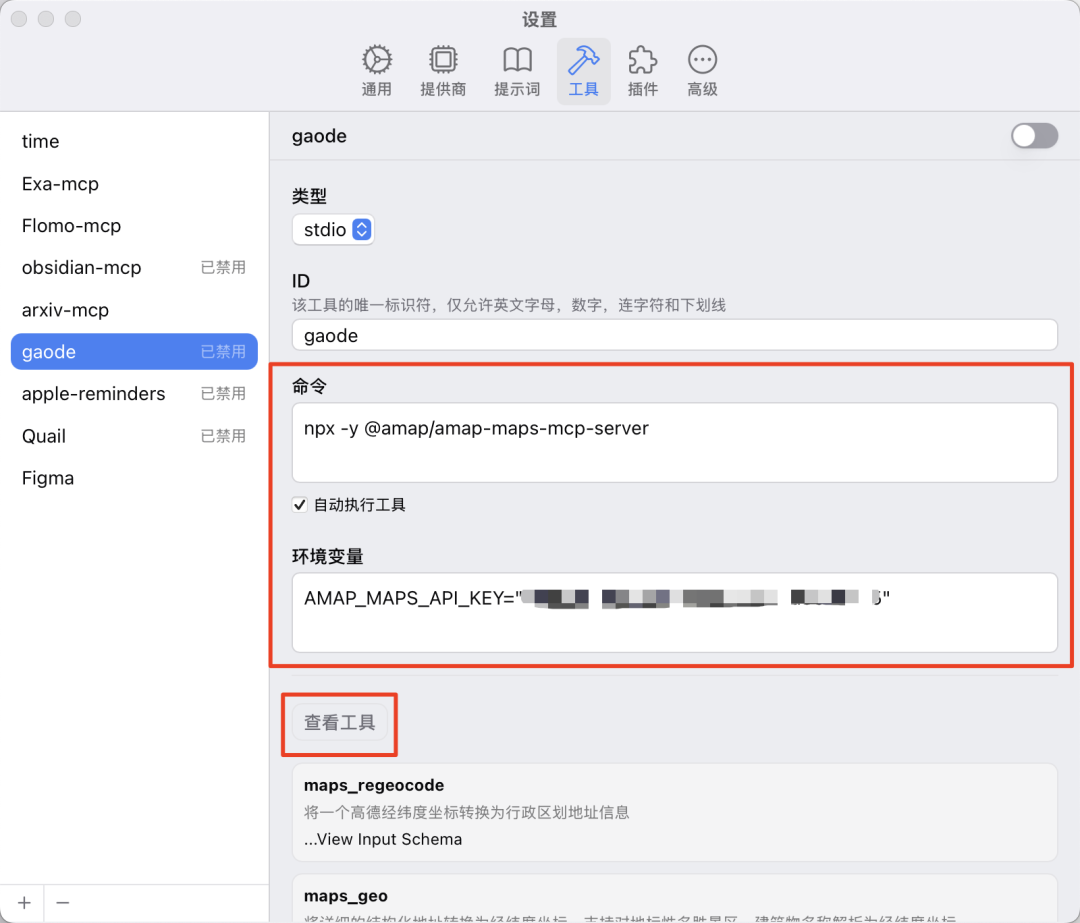

À ce stade, les informations clés suivantes sont généralement requises :

- TypeSélection générale

Stdioà moins qu'il ne soit clairement établi qu'il s'agitSSEet obtient l'URL correspondante. Si la source de configuration est le serviceJSONqui correspond généralement au formatStdioMode. - IDLe Comité de l'environnement et du développement durable (CEDD) : pour ce faire

MCPLe service porte un nom unique et facilement reconnaissable (par exemple, le serviceFigma,ExaSearch). - CommandementC'est le démarrage.

MCPLes instructions complètes de la ligne de commande nécessaires à l'exécution du processus. - Variables d'environnement: Certains

MCPLe service doit être transmis via une variable d'environnementAPIou d'autres paramètres de configuration.

Obtenir des commandes et des variables d'environnement :

Si seulement JSON Code de configuration, comment le convertir en Chatwise Quel est le format requis pour les "commandes" et les "variables d'environnement" ? Un moyen efficace d'y parvenir est d'utiliser le modèle d'IA lui-même. Pour ce faire, il suffit de combiner les JSON Le code de configuration est fourni au LLM (par exemple Claude peut-être Deepseek) et lui donne l'instruction suivante : "Veuillez envoyer cette MCP entretenu JSON La configuration est convertie en une configuration qui s'applique à la Chatwise Ajouter manuellement la chaîne de commande de l'outil et la liste des variables d'environnement (au format KEY=VALUE, une par ligne)".

Par exemple, pour un gantelet MCP (utilisé comme expression nominale) JSON l'IA peut aider à isoler les informations suivantes :

- commande:

npx -y @amap/amap-maps-mcp-server - variable d'environnement:

AMAP_MAPS_API_KEY=YOUR_API_KEY(dontYOUR_API_KEYdemande à l'utilisateur de remplacer la clé par sa propre clé)

Complétez les commandes et les variables d'environnement fournies par l'IA dans le fichier Chatwise de la zone de saisie correspondante.

Test et habilitation :

Une fois la configuration terminée, un bouton "Test Tool" ou "Debug" est généralement disponible. Cliquez dessus pour vérifier que la configuration est correcte.

- succèsSi la configuration est correcte, le système affichera la liste des

MCPLes outils spécifiques fournis par le service (c'est-à-dire les fonctions qu'il peut exécuter). - échouer (par exemple, expériences)En cas de problème (tel qu'une erreur de commande), l'utilisateur est informé de l'existence d'une erreur de commande,

API(clé non valide, variable d'environnement manquante, etc.), le système affiche un message d'erreur. ), le système affichera un message d'erreur. Les utilisateurs peuvent résoudre le problème en fonction du message d'erreur ou soumettre à nouveau le message d'erreur à l'IA pour demander une solution.

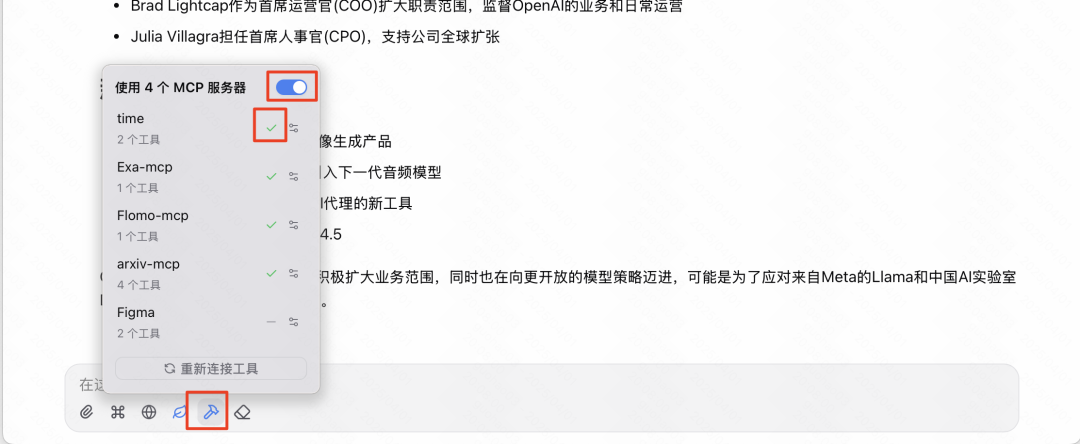

Une fois le débogage terminé, enregistrez la configuration. Enregistrez la configuration dans le fichier Chatwise de l'interface de discussion principale, qui peut généralement être gérée et activée via une icône d'outil (par exemple, une icône de marteau) à côté du champ de saisie. MCP Services.

commencer à utiliser MCP Une fois le service activé (remarque : il peut être nécessaire d'allumer l'interrupteur principal, puis de cocher individuellement le service à activer), l'utilisateur pourra interagir avec l'IA en langage naturel dans le cadre d'un chat. Lorsque la demande de l'utilisateur concerne un service MCP Lorsqu'un service fonctionne, l'IA invoque automatiquement l'outil approprié pour obtenir des informations ou effectuer une action.

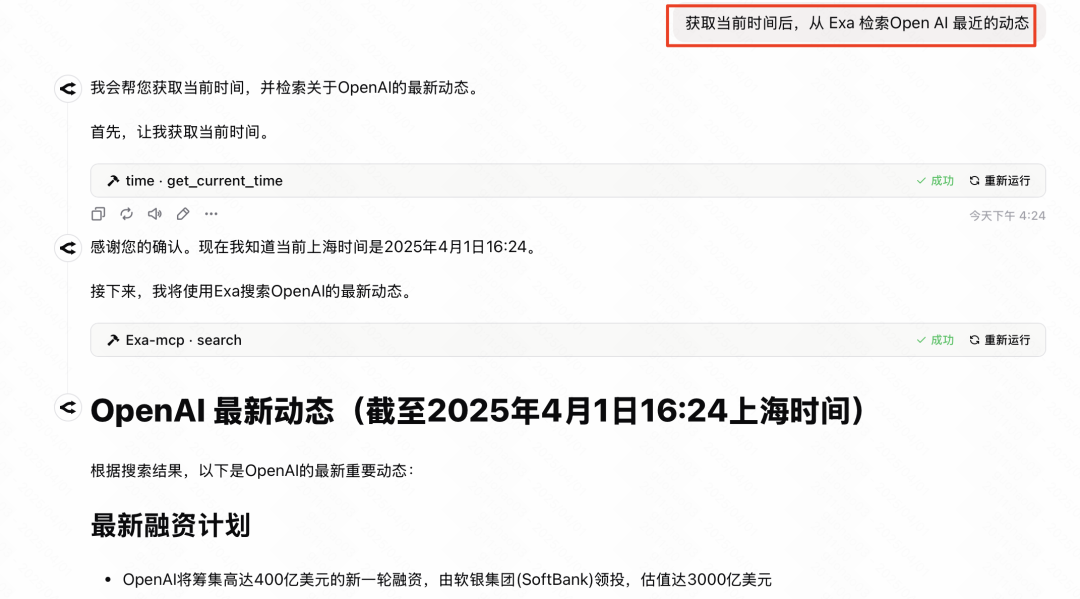

Par exemple, si vous posez une question qui demande l'heure actuelle et les dernières nouvelles, configurez l'application Time répondre en chantant Exa rechercher qqch. MCP pourrait d'abord appeler le modèle Time obtient la date du jour et appelle ensuite le service Exa Recherche de service pour les nouvelles connexes.

Sans risque potentiel MCP Pour les services, vous pouvez envisager de cocher l'option "Exécuter automatiquement les outils", de sorte que l'IA exécute directement les outils lorsqu'elle détermine qu'ils sont nécessaires, sans que l'utilisateur ait à les confirmer manuellement, ce qui améliore l'efficacité de l'interaction.

Cas d'application MCP et référence des paramètres

Ensuite, quelques conseils pratiques MCP les cas de service, y compris leurs origines, les profils fonctionnels et les Chatwise Configurez les paramètres requis dans la fenêtre de configuration. Ces configurations ont été testées et vérifiées.

Cas 1 : Génération de code Web à partir de conceptions Figma

- MCP Services:

Framelink Figma MCP Server(Source : https://mcp.so/server/Figma-Context-MCP/GLips) - Fonctionnalité: Permet à l'IA d'accéder à l'espace de travail spécifié

FigmaConcevoir un projet de contenu et générer un code web frontal (HTML/CSS/JS) sur la base du projet de conception. - Paramètres de Chatwise:

# 类型: Stdio # ID: FigmaMCP # 命令: npx -y figma-developer-mcp --stdio --figma-api-key=YOUR_FIGMA_API_KEY # 环境变量: (无,API Key直接在命令中提供)prendre note: : Will

YOUR_FIGMA_API_KEYRemplacer les données de l'utilisateurFigmaClé API. - Obtenir le jeton API Figma:

- s'inscrire

FigmaCliquez sur votre avatar dans le coin supérieur gauche et allez dans "Paramètres". - Trouvez la section "Jetons d'accès personnels" dans les paramètres.

- Crée un nouveau token, avec l'étendue de l'autorité (Scopes) conformément à la norme

MCPLa documentation du service exige ce paramètre, et il suffit généralement de sélectionner les autorisations en lecture seule (par ex.File content: read,Dev resources: read). - générant Jeton Veillez à le copier immédiatement après et à l'enregistrer correctement, car il ne sera affiché qu'une seule fois.

- s'inscrire

- Processus d'utilisation:

- existent

FigmaOuvrez votre dessin dans la section "Web Designer" et sélectionnez le cadre ou le composant que vous souhaitez convertir en page web. - Cliquez avec le bouton droit de la souris sur l'élément sélectionné et sélectionnez "Copier/Coller sous" > "Copier le lien vers la sélection".

- existent

ChatwisepermettreFigma MCPServices. - Placer la copie

FigmaLe lien est collé dans la boîte de dialogue et l'IA reçoit l'instruction suivante : "Veuillez générer un code web basé sur ce lien de conception Figma". Il est recommandé d'utiliser des modèles dotés de fortes capacités de génération de code, tels queGoogle(utilisé comme expression nominale)Gemini 1.5 Propeut-êtreAnthropic(utilisé comme expression nominale)Claude 3Modèles de la série.

- existent

Cas 2 : Création d'une fonction de recherche IA personnalisée (Exa + temps)

- FonctionnalitéUtilisation combinée de deux

MCPqui donnent à l'IA la capacité de détecter l'heure actuelle et d'effectuer des recherches sur le web pour répondre à des questions urgentes ou faire des requêtes basées sur les informations les plus récentes. - Services MCP requis:

- Temps MCP: Permet d'obtenir la date et l'heure actuelles. Cette opération est généralement effectuée par le fournisseur du modèle (par exemple

Anthropicen raison deClaude) fournissent des réalisations officielles ou disposent d'une version communautaire. - Exa Search MCP: Utilisation

Exa(anciennement)Metaphor)APIEffectuer des recherches de qualité sur le web.

- Temps MCP: Permet d'obtenir la date et l'heure actuelles. Cette opération est généralement effectuée par le fournisseur du modèle (par exemple

- Paramètres Chatwise - Temps MCP:

# 类型: Stdio # ID: TimeMCP # 命令: uvx mcp-server-time --local-timezone Asia/Shanghai # 环境变量: (无)prendre note:

--local-timezoneLa valeur du paramètre doit être réglée sur le fuseau horaire de l'utilisateur, par exempleAsia/Shanghai,America/New_Yorketc. - Paramètres Chatwise - Exa Search MCP:

# 类型: Stdio # ID: ExaSearchMCP # 命令: npx -y exa-mcp-server # 环境变量: EXA_API_KEY=YOUR_EXA_API_KEYprendre note: : Will

YOUR_EXA_API_KEYRemplacer les données de l'utilisateurExaClé API. - Obtenir la clé API Exa: : Accès

ExaVous pouvez créer une clé API gratuitement en créant un compte sur la page de gestion des clés API du site officiel (https://dashboard.exa.ai/api-keys). - Processus d'utilisation:

- existent

Chatwiseen même temps que laTime MCPrépondre en chantantExa Search MCP. - Posez à l'IA des questions qui requièrent une combinaison de l'heure actuelle et de recherches sur le web, telles que "

OpenAIDes communiqués importants ont-ils été publiés récemment ?" - L'IA devrait pouvoir appeler automatiquement

Time MCPConfirmez la période "récente" et utilisez le boutonExa Search MCPRechercher des informations pertinentes, puis intégrer les informations pour répondre. Pour certains modèles, s'il ne parvient pas à acquérir activement l'heure, il peut être explicitement invité à le faire lorsqu'il pose une question, par exemple : "Veuillez rechercher... en relation avec la date d'aujourd'hui".

- existent

Cas 3 : Connecter la bibliothèque de prise de notes d'Obsidian à l'IA

- MCP Services:

Obsidian Model Context Protocol(Source : https://mcp.so/zh/server/mcp-obsidian/smithery-ai) - FonctionnalitéL'IA permet de récupérer et d'analyser les données locales de l'utilisateur.

ObsidianLe contenu de la bibliothèque de notes permet d'effectuer des questions-réponses, des résumés et d'autres fonctions basées sur la base de connaissances personnelle. - conditions préalables: Nécessaire à la mise en place d'un

ObsidianInstaller et activer leLocal REST APIPlugin communautaire.- spectacle (un billet)

ObsidianSettings > Third Party Plugins > Community Plugin Marketplace. - Recherche et installation

Local REST APIPlug-ins. - Après l'installation, assurez-vous que le plugin est activé dans la liste des "Plugins installés".

- spectacle (un billet)

- Obtention d'une clé d'API REST locale et d'une autorisation:

- existent

Local REST APIdans la page de paramétrage du plugin, trouver l'élément généréAPI KeyEt de la copie.

- Visitez la page de licence fournie avec le plugin : https://coddingtonbear.github.io/obsidian-local-rest-api/

- Cliquez sur le bouton "Autoriser" dans le coin inférieur droit de la page, et entrez le numéro de téléphone de la personne à contacter.

API KeyL'autorisation est complétée de manière à ce que leMCPLe service est accessible par l'intermédiaire de l'applicationAPIentretiensObsidian.

- existent

- Obtenir le chemin du dépôt Obsidian:

- existent

ObsidianCliquez sur le nom de l'entrepôt actuel dans le coin inférieur gauche et sélectionnez "Gérer l'entrepôt".

- Recherchez votre référentiel, cliquez sur l'option située à côté (généralement trois points ou une icône similaire) et sélectionnez "Afficher dans le gestionnaire de fichiers" (Windows) ou "Afficher le dossier du référentiel dans Access" (macOS).

- Copiez le chemin d'accès complet à ce dossier de dépôt. Sous macOS, vous pouvez maintenir enfoncée la touche

OptionCliquez avec le bouton droit de la souris sur le dossier et sélectionnez "Copier le nom du dossier dans le nom du chemin".

- existent

- Paramètres de Chatwise:

# 类型: Stdio # ID: ObsidianMCP # 命令: uv tool run mcp-obsidian --vault-path "YOUR_OBSIDIAN_VAULT_PATH" # 环境变量: OBSIDIAN_API_KEY=YOUR_OBSIDIAN_LOCAL_REST_API_KEYprendre note:

- commandant en chef (militaire)

"YOUR_OBSIDIAN_VAULT_PATH"Remplacez-la par celle que vous avez copiéeObsidianDossier de l'entrepôt duchemin completil est préférable de mettre des guillemets de part et d'autre du chemin, surtout si le chemin contient des espaces. - commandant en chef (militaire)

YOUR_OBSIDIAN_LOCAL_REST_API_KEYRemplacé par un changement deLocal REST APIDéfini dans les paramètres du pluginAPI Key. - La documentation originale suggère que la documentation de ce service n'est pas claire, et le processus de configuration peut nécessiter que l'utilisateur débogue en fonction de la situation réelle.

- commandant en chef (militaire)

- Processus d'utilisation:

- existent

ChatwisepermettreObsidian MCPServices. - Posez une question à l'IA et demandez-lui de faire de même lorsque vous lui posez une question.

ObsidianRecherchez, résumez ou analysez le contenu pertinent d'un dossier spécifique ou de l'ensemble de la bibliothèque de notes. Par exemple, "Veuillez consulter mon dossier "Notes de projet" pour trouver des informations sur laMCPL'article de l'accord et résume ses points clés".

- existent

Cas 4 : Récupération de lieux et génération de pages web d'affichage à l'aide de Goldmap MCP

- MCP ServicesGao De Maps MCP Service (

@amap/amap-maps-mcp-server) - Fonctionnalité: : Utilisation des cartes de Golder

APIEffectuer des requêtes de géolocalisation (par exemple, rechercher des points d'intérêt à proximité), obtenir des informations telles que la latitude et la longitude, et peut être combiné avec d'autres capacités (par exemple, la génération de code pour l'IA) pour créer des applications basées sur la géo-information. - conditions préalablesIl est nécessaire de s'inscrire à un compte de développeur High-Tech Open Platform et de créer une application pour bénéficier de l'aide.

API Key.- Visitez la Golder Open Platform (https://console.amap.com/dev/key/app).

- S'inscrire et passer la certification de développeur individuel.

- Créez une nouvelle application dans la console.

- Ajoutez une clé pour l'application et sélectionnez la plate-forme de service comme "Web Services".

- Copier le fichier généré

API Key.

- Paramètres de Chatwise:

# 类型: Stdio # ID: AmapMCP # 命令: npx -y @amap/amap-maps-mcp-server # 环境变量: AMAP_MAPS_API_KEY=YOUR_AMAP_API_KEYprendre note: : Will

YOUR_AMAP_API_KEYRemplacez-le par le service Golder Maps Web que vous avez demandé.API Key.

- Flux d'utilisation (exemple):

- existent

ChatwiseActiver les cartes AutoNavi dansMCP. - Tout d'abord, il peut être nécessaire de laisser l'IA obtenir la latitude et la longitude de votre position actuelle ou d'une position spécifiée (si l'option

MCP(Soutien). - Ensuite, demandez à l'IA d'utiliser Goldmap

MCPRecherche d'un type spécifique de lieu à proximité, par exemple "Aidez-moi à trouver les 5 cafés les mieux notés à proximité de mon lieu de résidence actuel et indiquez leur nom, leur adresse et leur note". - avancéUne fois les informations de la liste des cafés obtenues, elles peuvent être combinées avec les capacités de génération de code de l'IA (ce qui peut nécessiter d'autres ressources de l'IA).

MCPou des capacités natives du modèle), l'IA est invitée à rassembler ces informations dans une simple page HTML à présenter. Pour une visualisation plus esthétique, vous pouvez vous référer aux conseils d'ingénierie relatifs aux mots-clés.

- existent

Cas 5 : Récupération et téléchargement d'articles à partir d'Arxiv

- MCP Services:

arxiv-mcp-server - Fonctionnalité: : Permettre à l'IA d'effectuer des recherches directes sur les sites de prépublications universitaires

Arxivsur le papier, et peut suivre les instructions pour télécharger le papier spécifié.PDFlocalement. - Paramètres de Chatwise:

# 类型: Stdio # ID: ArxivMCP # 命令: uv tool run arxiv-mcp-server --storage-path "/path/to/your/paper/storage" # 环境变量: (无)prendre note:

- commandant en chef (militaire)

"/path/to/your/paper/storage"Remplacez-le par celui dans lequel vous souhaitez enregistrer le document téléchargéChemin d'accès au dossier localVeuillez vous assurer que le chemin d'accès existe et que le programme dispose des droits d'écriture. Assurez-vous que le chemin d'accès existe et que le programme dispose des droits d'écriture. WindowsLes utilisateurs sont tenus d'utiliser leWindowsdes chemins de style, tels que"C:\Users\YourUser\Documents\Papers".

- commandant en chef (militaire)

- Processus d'utilisation:

- existent

ChatwisepermettreArxiv MCPServices. - Envoyer des commandes à l'IA pour qu'elle récupère et télécharge des articles. Par exemple, "Veuillez récupérer l'article à partir de

ArxivTrouver 10 articles sur "Optimisation du modèle de transformateur" datant du mois dernier, lister les titres et les résumés, et les télécharger dans le répertoire spécifié."

- existent

Cas 6 : Création rapide de notes Flomo par le dialogue

- MCP Services:

@chatmcp/mcp-server-flomo(Contribution de développeurs communautaires tels que Tease) - FonctionnalitéLes chats : Permettre à l'IA de prendre le contenu, les résumés ou tout autre contenu généré dans les chats.

MCPLes informations obtenues par l'outil sont envoyées directement sur le site web de l'utilisateur.Flomoet peut attribuer des étiquettes. - conditions préalables: : Nécessaire à partir de

FlomogainAPILien d'accès (URL du Webhook).- entretiens

FlomoParamètres pour le Web ou l'App >Flomo API. - Reproduction des documents fournis

APILien d'accès.

- entretiens

- Paramètres de Chatwise:

# 类型: Stdio # ID: FlomoMCP # 命令: npx -y @chatmcp/mcp-server-flomo # 环境变量: FLOMO_API_URL=YOUR_FLOMO_API_URLprendre note: : Will

YOUR_FLOMO_API_URLRemplacez-la par celle que vous avez obtenue à partir de l'applicationFlomoacquisAPILien d'accès. - Processus d'utilisation:

- existent

ChatwisepermettreFlomo MCPServices. - Après un dialogue avec l'IA, si vous souhaitez sauvegarder un élément de contenu précieux, vous pouvez directement demander à l'IA : "Veuillez envoyer les informations que vous venez d'écrire à propos de la

MCPLes points configurés sont enregistrés dans monFlomoet étiqueté avec #AI #MCP". - Il peut également être combiné avec d'autres

MCPUtilisez, par exemple, "Veuillez rechercher les dernières nouvelles de l'industrie de l'IA et envoyer un résumé des résultats à mon bureau".Flomo."

- existent

Conclusion : perspectives et défis pour le GPE

MCP L'émergence du protocole symbolise le potentiel d'évolution de l'écosystème des outils d'IA vers plus d'ouverture et d'interconnectivité, comme ce fut le cas lors de la création de l'Institut de recherche sur les technologies de l'information et de la communication (IRIS). HTTP qui unifient les normes d'accès au Web.MCP Il devrait devenir un protocole clé pour unifier l'interaction de l'IA avec le monde extérieur. Cette normalisation n'est pas seulement une avancée technologique, elle peut aussi conduire à un changement de paradigme dans les applications de l'IA, transformant l'IA d'un rôle passif et réactif en un agent intelligent capable d'invoquer activement des outils et d'exécuter des tâches complexes.

faire passer (un projet de loi, une inspection, etc.) MCPEn théorie, les flux de travail complexes de l'IA, dont l'élaboration nécessiterait autrement de grandes équipes, deviennent progressivement personnalisables et assemblés par des utilisateurs individuels disposant d'un certain niveau de compréhension technique. Il s'agit sans aucun doute d'une étape importante dans la démocratisation des capacités de l'IA.

Cependant.MCP Il en est encore aux premiers stades de développement, et la complexité de sa configuration est l'un des principaux obstacles à son adoption à grande échelle. L'innovation technologique s'accompagne souvent de problèmes de facilité d'utilisation - il faut trouver un équilibre entre la recherche de l'ouverture et de la flexibilité et la recherche d'une expérience utilisateur simple et intuitive. Cette situation est fréquente aux premiers stades du développement d'une technologie émergente. Au fur et à mesure que l'écosystème mûrit, que la chaîne d'outils s'améliore et que davantage de solutions prêtes à l'emploi deviennent disponibles (par exemple, des "installations" en un clic seront possibles à l'avenir), il sera plus facile pour les utilisateurs de se servir de la technologie. MCP ), cette contradiction devrait s'atténuer progressivement.

Pour les utilisateurs désireux d'explorer les technologies de pointe, le moment est venu de commencer à expérimenter et à comprendre les technologies de l'information et de la communication (TIC). MCP Ce type de technologie, même si le processus peut connaître des hauts et des bas, constitue un investissement dans les compétences futures. À l'ère de la popularité croissante de l'IA, la maîtrise de l'utilisation des outils d'IA et la compréhension de leur fonctionnement sous-jacent seront essentielles pour améliorer l'efficacité individuelle et organisationnelle.

© déclaration de droits d'auteur

L'article est protégé par le droit d'auteur et ne doit pas être reproduit sans autorisation.

Articles connexes

Pas de commentaires...