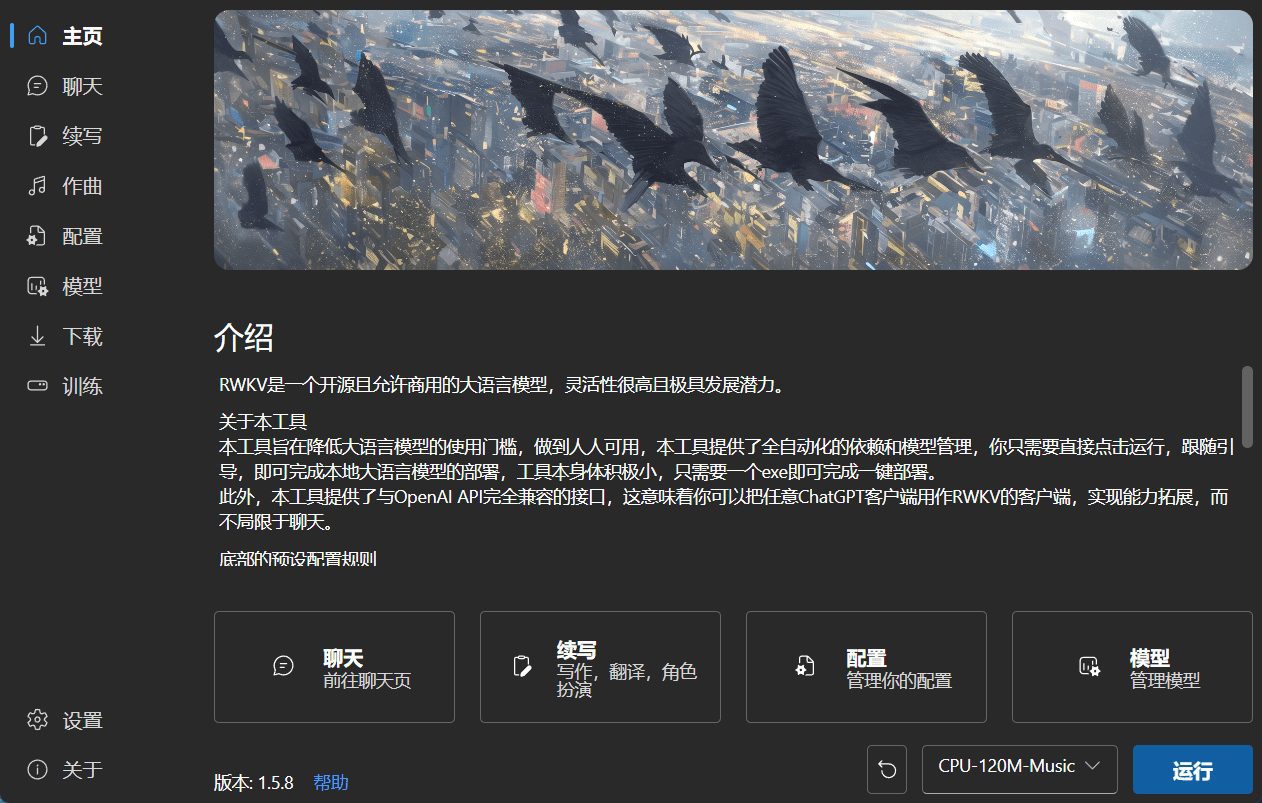

RWKV Runner : outil open source de gestion du modèle linguistique à grande échelle RWKV

Introduction générale

RWKV-Runner est un outil de gestion et de lancement conçu spécifiquement pour les modèles RWKV, visant à fournir un outil de gestion et de lancement RWKV facile à utiliser. Il est entièrement automatisé et compact, avec une taille de seulement 8 Mo, tout en fournissant une interface compatible avec l'API OpenAI.

Développé par josStorer, membre de la communauté open source RWKV. L'outil est conçu pour éliminer les obstacles à l'utilisation de grands modèles linguistiques et fournir une solution entièrement automatisée. rWKV-Runner est de petite taille, ne nécessitant que quelques Mo, et fournit une interface compatible avec l'API de l'OpenAI, ce qui permet à tous les utilisateurs de l'OpenAI d'accéder à des modèles linguistiques. ChatGPT RWKV est un grand modèle linguistique dont les performances sont comparables à celles de GPT, qui prend en charge l'apprentissage direct comme GPT Transformer, et qui est entièrement open source et disponible dans le commerce.

Liste des fonctions

- Gestion entièrement automatiséeLe système RWKV : Il gère automatiquement le démarrage et la gestion des modèles RWKV sans que l'utilisateur n'ait à les configurer manuellement.

- classe des poids légers (en athlétisme)La taille du programme n'est que de quelques Mo, ce qui le rend adapté à une large gamme d'appareils.

- Compatible avec l'API OpenAILe système de gestion de l'interface : fournit une interface compatible avec l'API OpenAI afin de faciliter l'intégration dans les systèmes existants.

- Prise en charge multilingueLe chinois simplifié, l'anglais et le japonais sont pris en charge.

- Support multiplateformeCompatible avec les systèmes Windows, MacOS et Linux.

- Accélération CUDA personnaliséeAccélération du noyau CUDA : Prise en charge de l'accélération du noyau CUDA personnalisé pour améliorer les performances et réduire l'utilisation de la mémoire.

- Déploiement du serveurLe système de gestion de l'information de l'Union européenne (UE) est le suivant : il prend en charge le déploiement de backend-python sur le serveur, et les clients peuvent l'utiliser en se connectant simplement au serveur.

Utiliser l'aide

Visitez le dépôt GitHub pour les instructions d'installation.

Regardez la vidéo du tutoriel d'installation pour des instructions pratiques.

Consultez la documentation sur le site officiel de RWKV

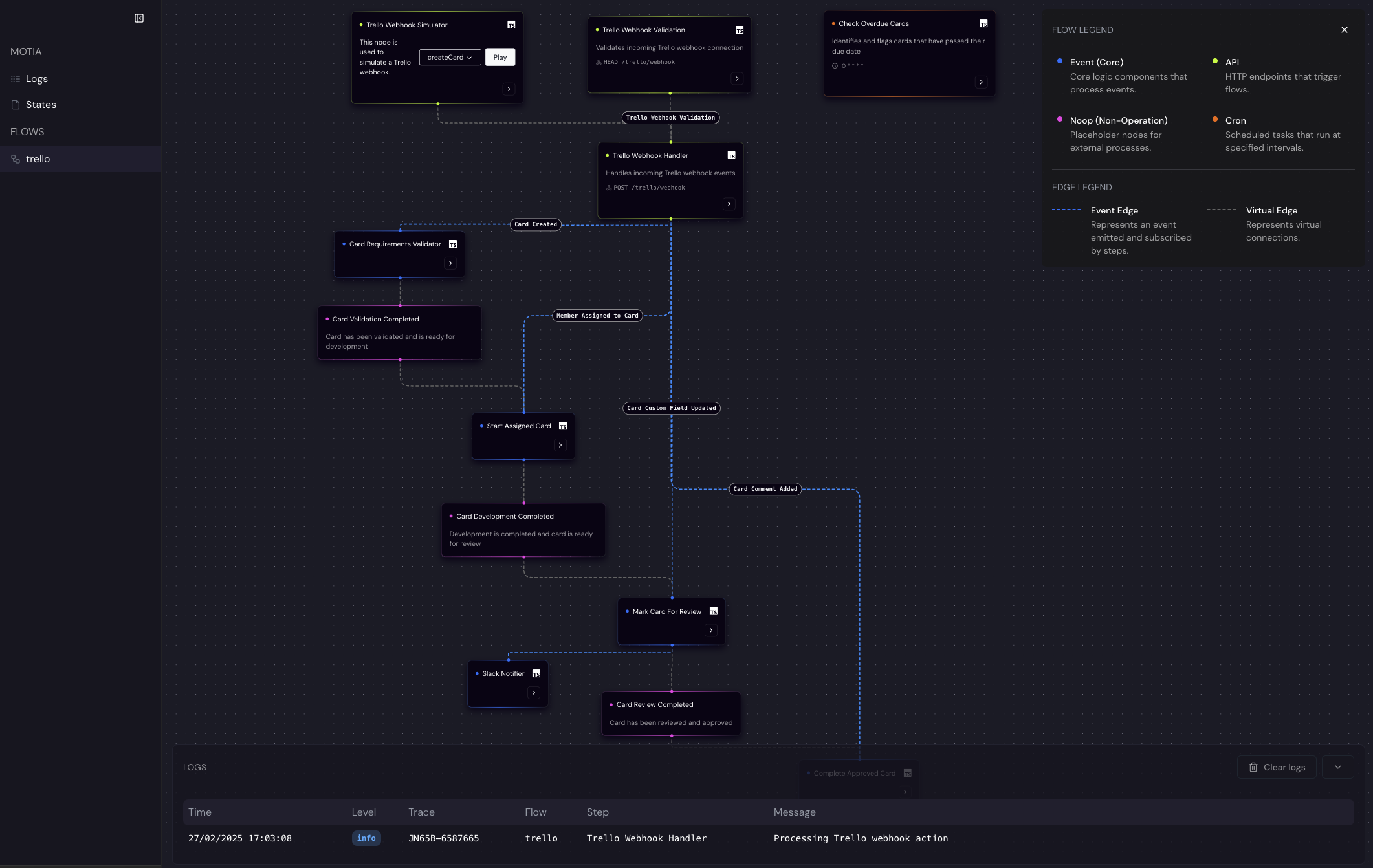

page d'accueil

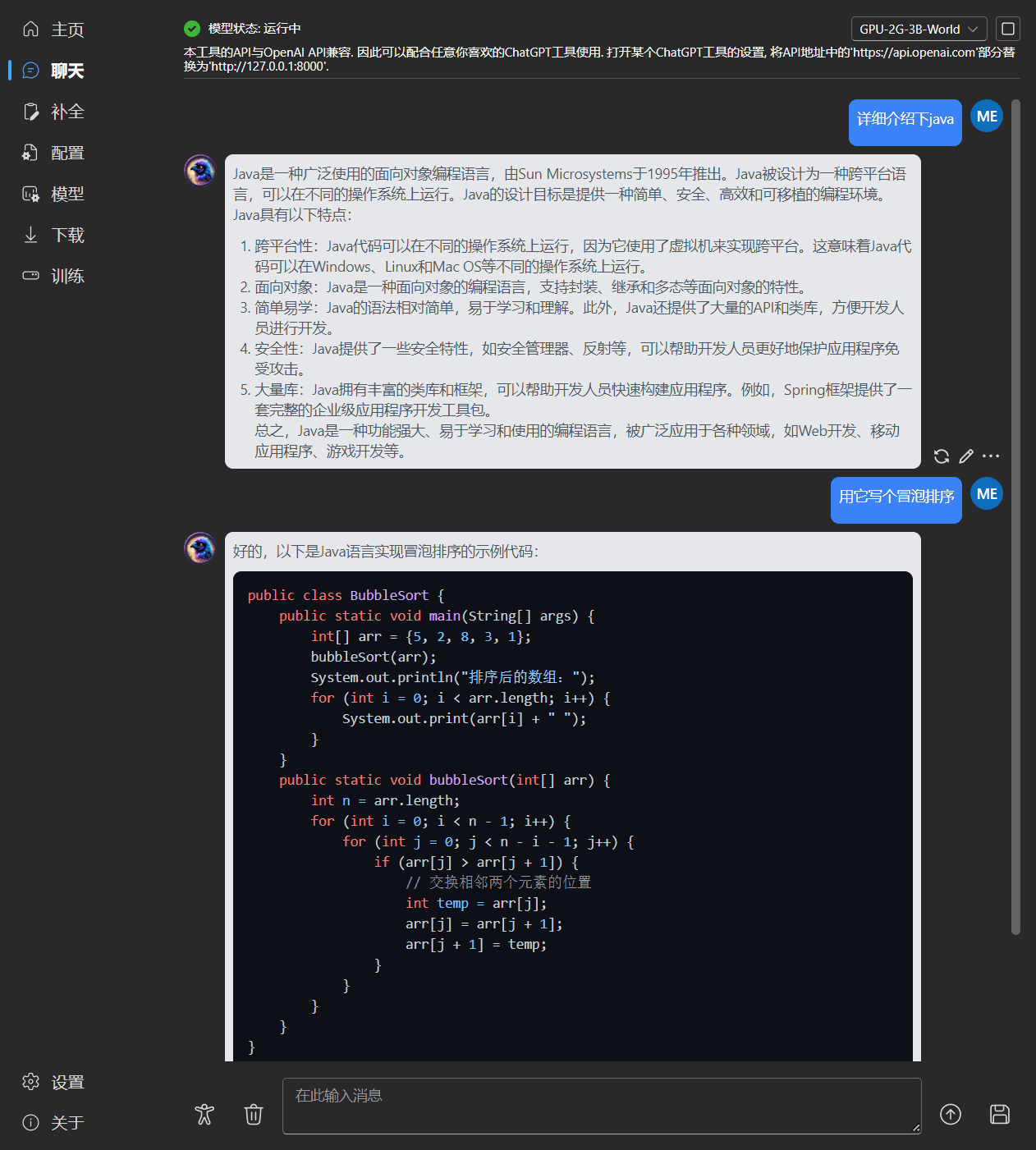

Interface de chat

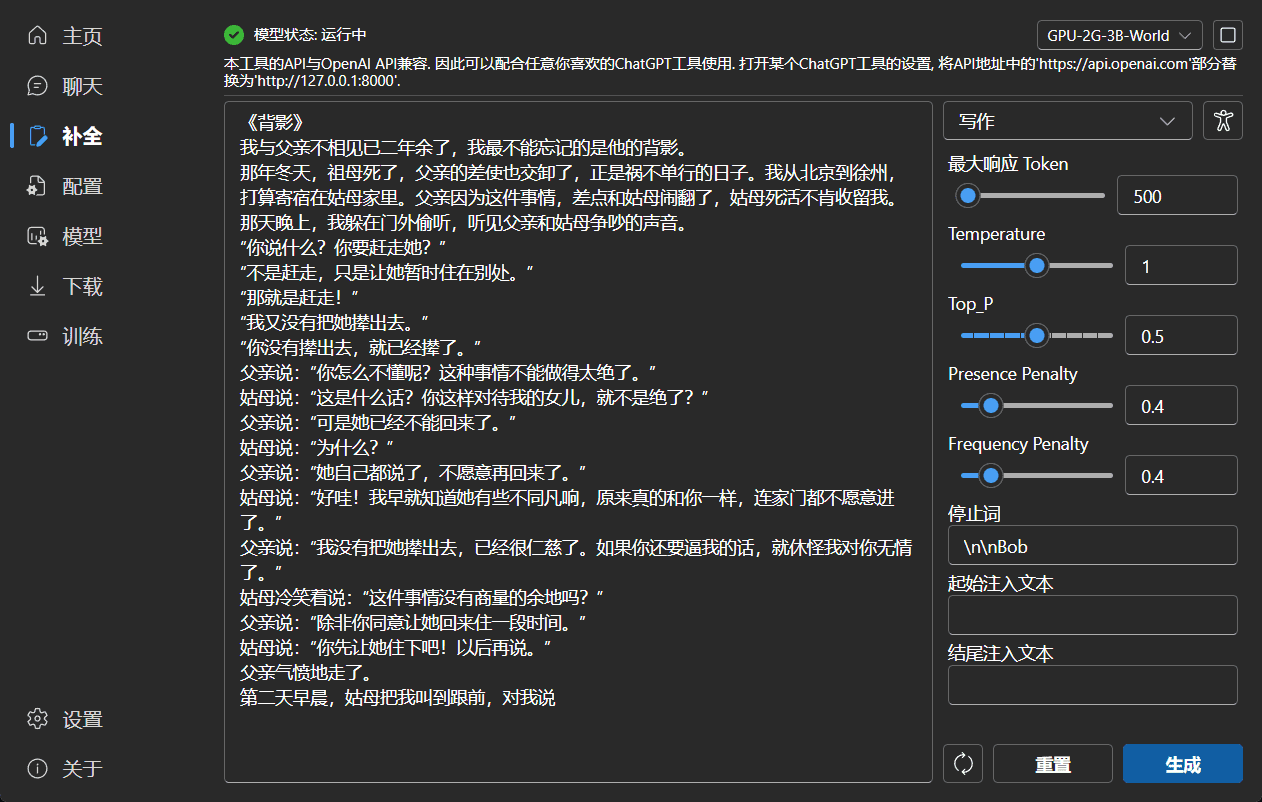

Achèvement de l'interface de continuation

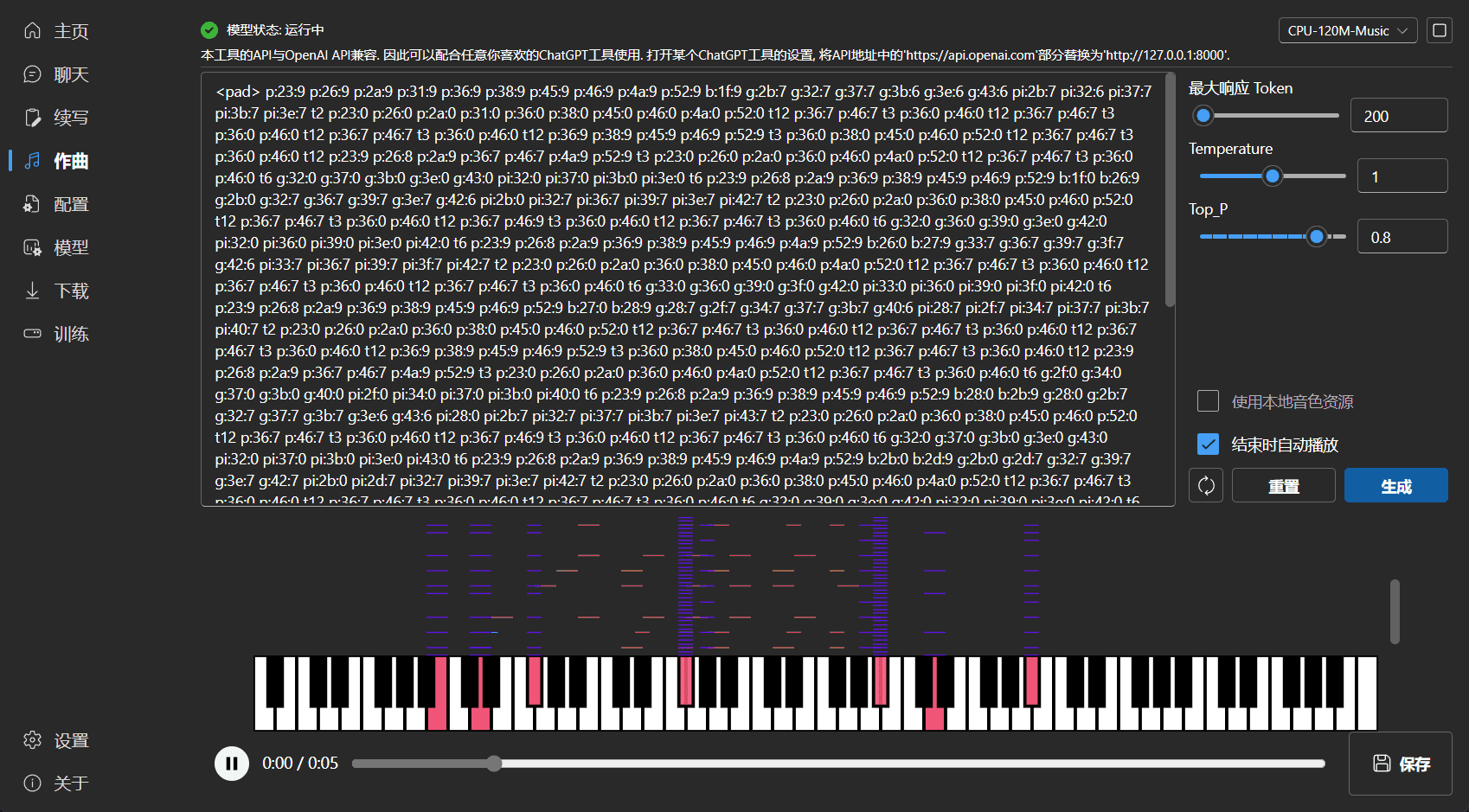

Écran de composition

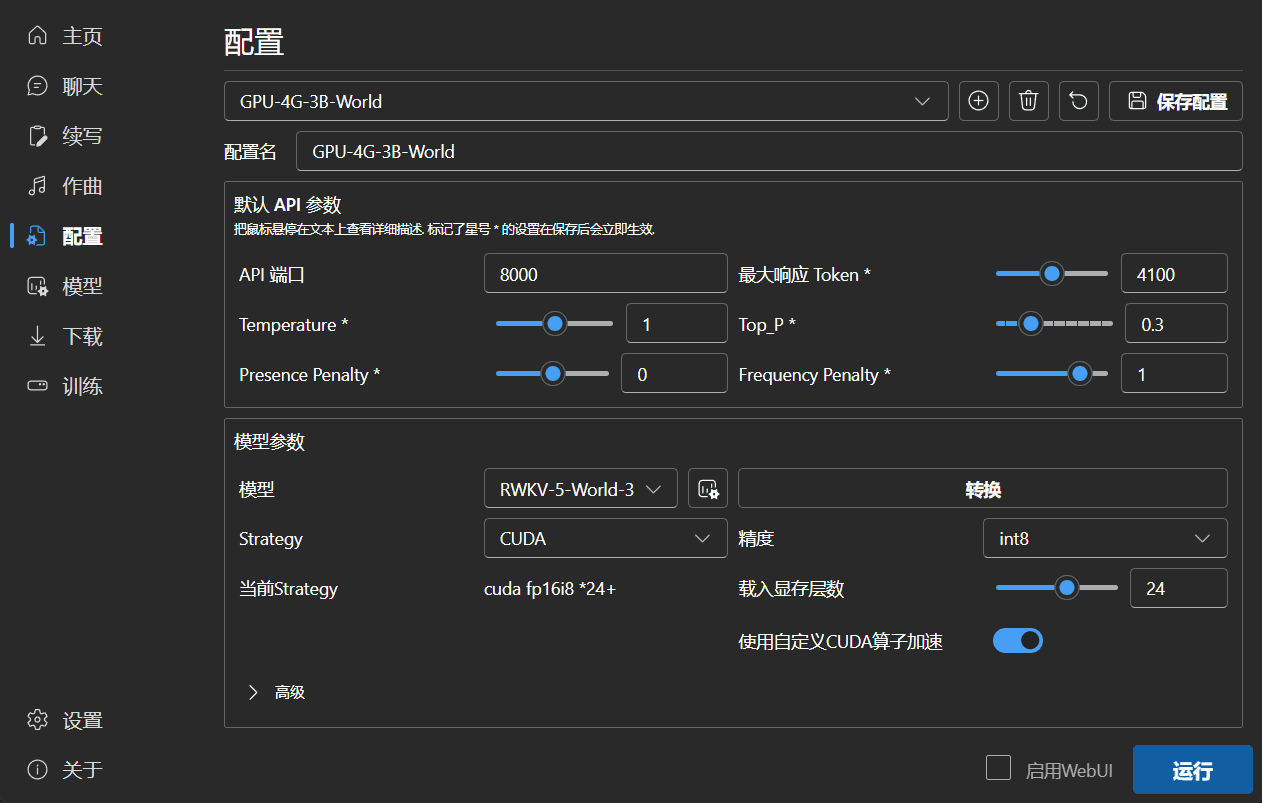

Interface de configuration

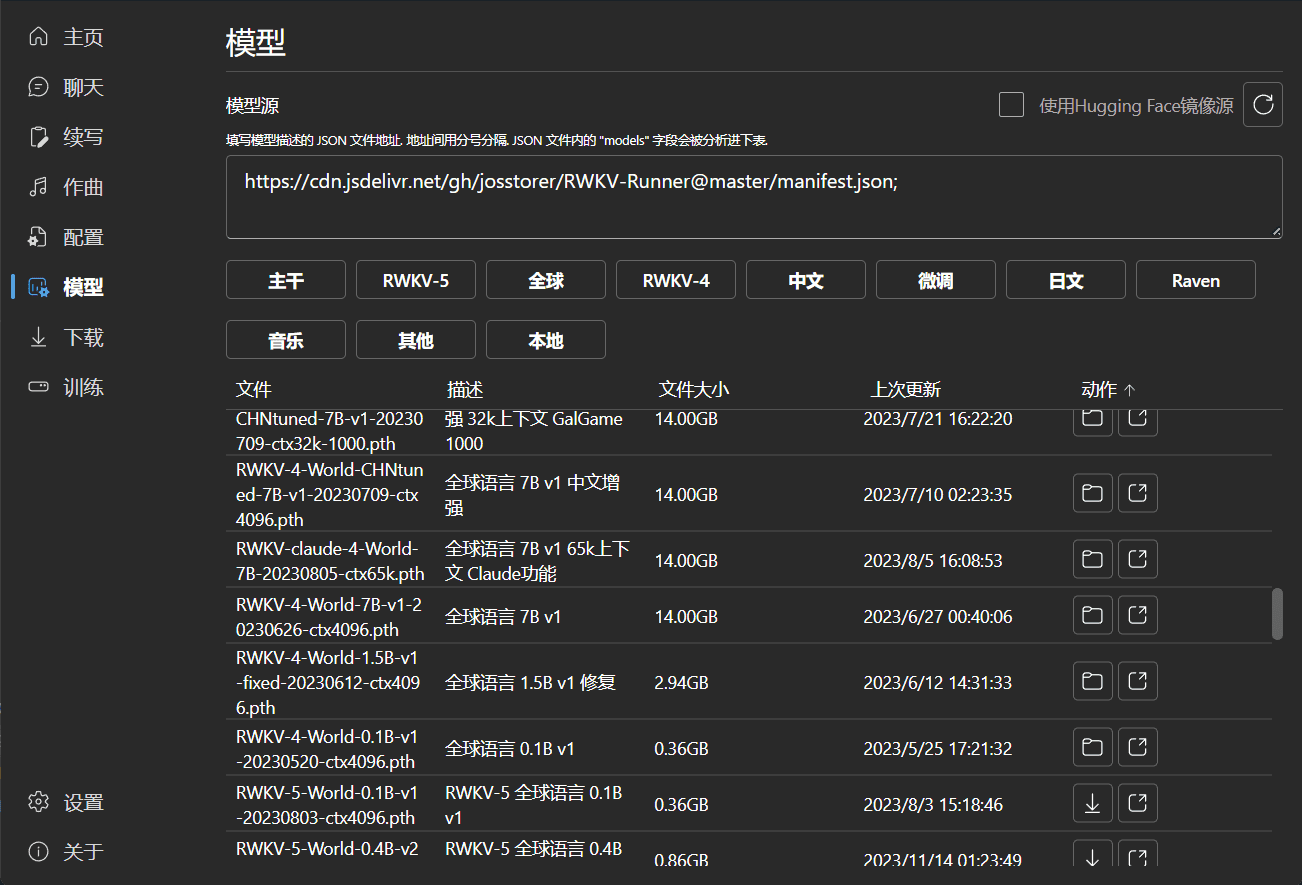

Interface de gestion des modèles

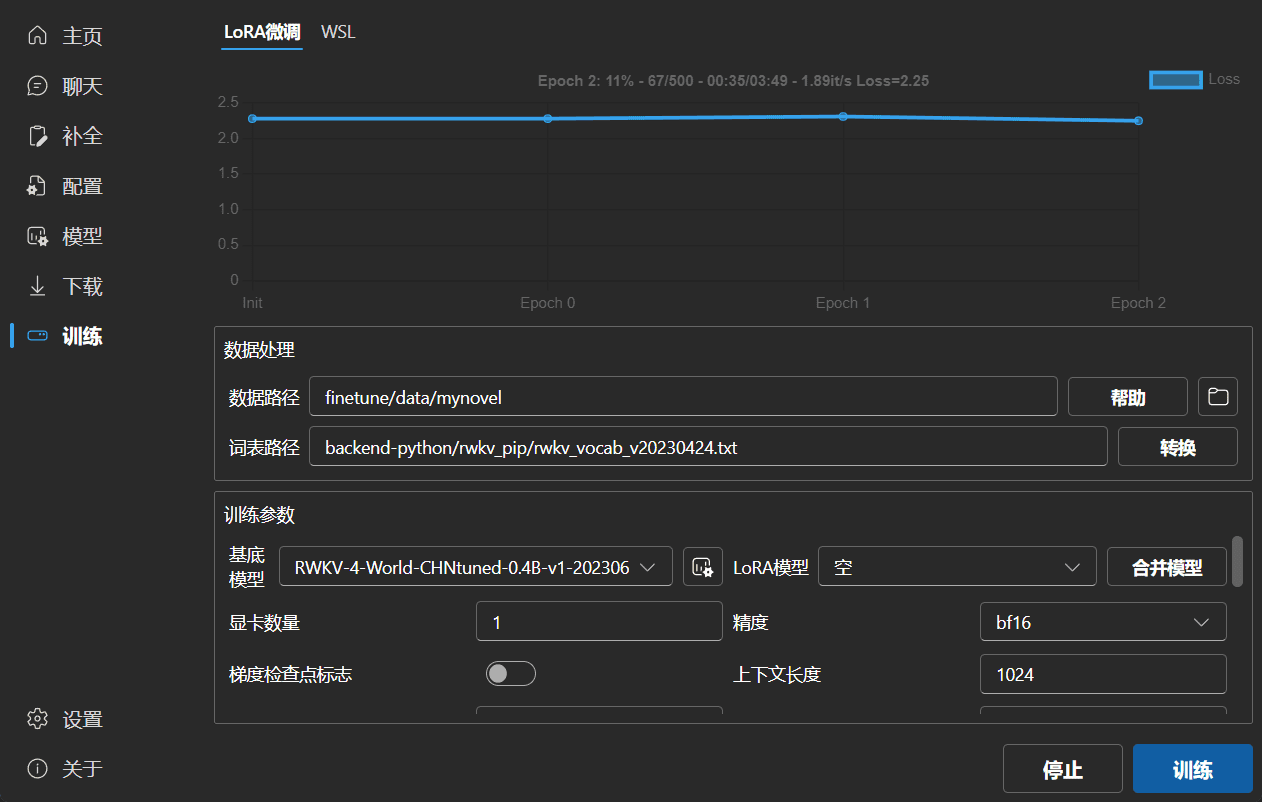

Affiner l'interface

Processus d'installation

- Télécharger RWKV-Runner: :

- entretiens Dépôts GitHub Télécharger la dernière version de RWKV-Runner.

- Sélectionnez le paquet d'installation correspondant au système d'exploitation (Windows, MacOS, Linux).

- Installer RWKV-Runner: :

- Utilisateurs Windows : Décompressez le fichier ZIP téléchargé, exécutez le programme

RWKV-Runner.exe. - Utilisateurs de MacOS : Décompressez le fichier ZIP téléchargé, exécutez le programme

RWKV-Runner.app. - Utilisateurs Linux : Décompressez le fichier TAR téléchargé, exécutez le programme

./RWKV-Runner.

- Utilisateurs Windows : Décompressez le fichier ZIP téléchargé, exécutez le programme

- Configuration du RWKV-Runner: :

- Ouvrez RWKV-Runner et allez à la page Paramètres.

- Si vous devez vous connecter au serveur, indiquez l'adresse du serveur dans la rubrique

API URLAu milieu.

Processus d'utilisation

- Démarrage de RWKV-Runner: :

- Double-cliquez pour lancer le programme et attendez la fin du chargement.

- Le programme détecte et charge automatiquement le modèle RWKV.

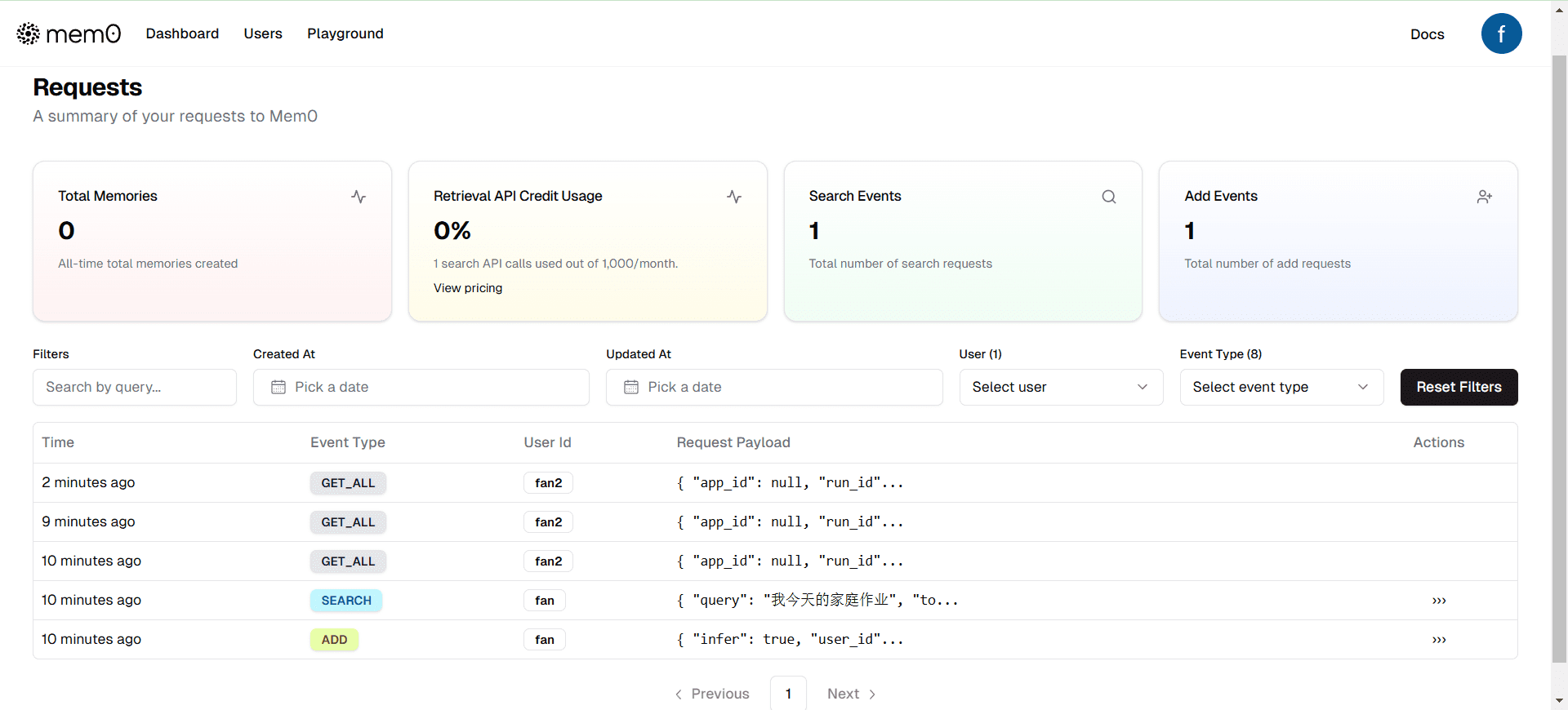

- Utiliser l'interface API de l'OpenAI: :

- La section Configuration de l'API se trouve sur la page Paramètres.

- Remplissez les paramètres pertinents de l'API OpenAI à la position correspondante et enregistrez les paramètres.

- Accélération CUDA personnalisée: :

- Allez à la page de configuration et trouvez l'option d'accélération CUDA.

- Activez ou désactivez l'accélération du noyau CUDA personnalisé selon vos besoins.

- Exécution des tâches: :

- Sélectionnez le type de tâche que vous souhaitez exécuter (par exemple, chatter, écrire, composer, etc.) dans l'écran principal.

- Ajuster les paramètres de l'API (par exemple, température, Top_P, etc.) en fonction des exigences de la tâche.

- Cliquez sur le bouton Démarrer et attendez que la tâche soit terminée.

- Déploiement du serveur: :

- Téléchargez et installez backend-python sur le serveur.

- Configurez l'adresse du serveur et les paramètres connexes.

- Remplissez l'adresse du serveur dans les paramètres du client pour vous connecter au serveur.

problèmes courants

- Le programme ne peut pas être lancé.Pour plus d'informations, veuillez vous référer à la page suivante : Vérifiez que vous avez téléchargé le bon paquet d'installation pour assurer la compatibilité de votre système.

- Exception d'accélération CUDASi vous n'êtes pas en mesure de le faire, essayez de désactiver l'accélération personnalisée du noyau CUDA ou de mettre à jour le pilote du GPU.

- Échec de la demande d'APIVérifier que l'API est correctement configurée et que la connexion réseau fonctionne.

RWKV Écriture automatique de romans Édition spéciale (25G)

Un véritable modèle d'écriture de romans dédiés avec des cycles multiples entièrement automatisés de romans continus.

Lien : https://pan.quark.cn/s/f078738521d5

Code de l'extrait : 42Us

© déclaration de droits d'auteur

L'article est protégé par le droit d'auteur et ne doit pas être reproduit sans autorisation.

Articles connexes

Pas de commentaires...