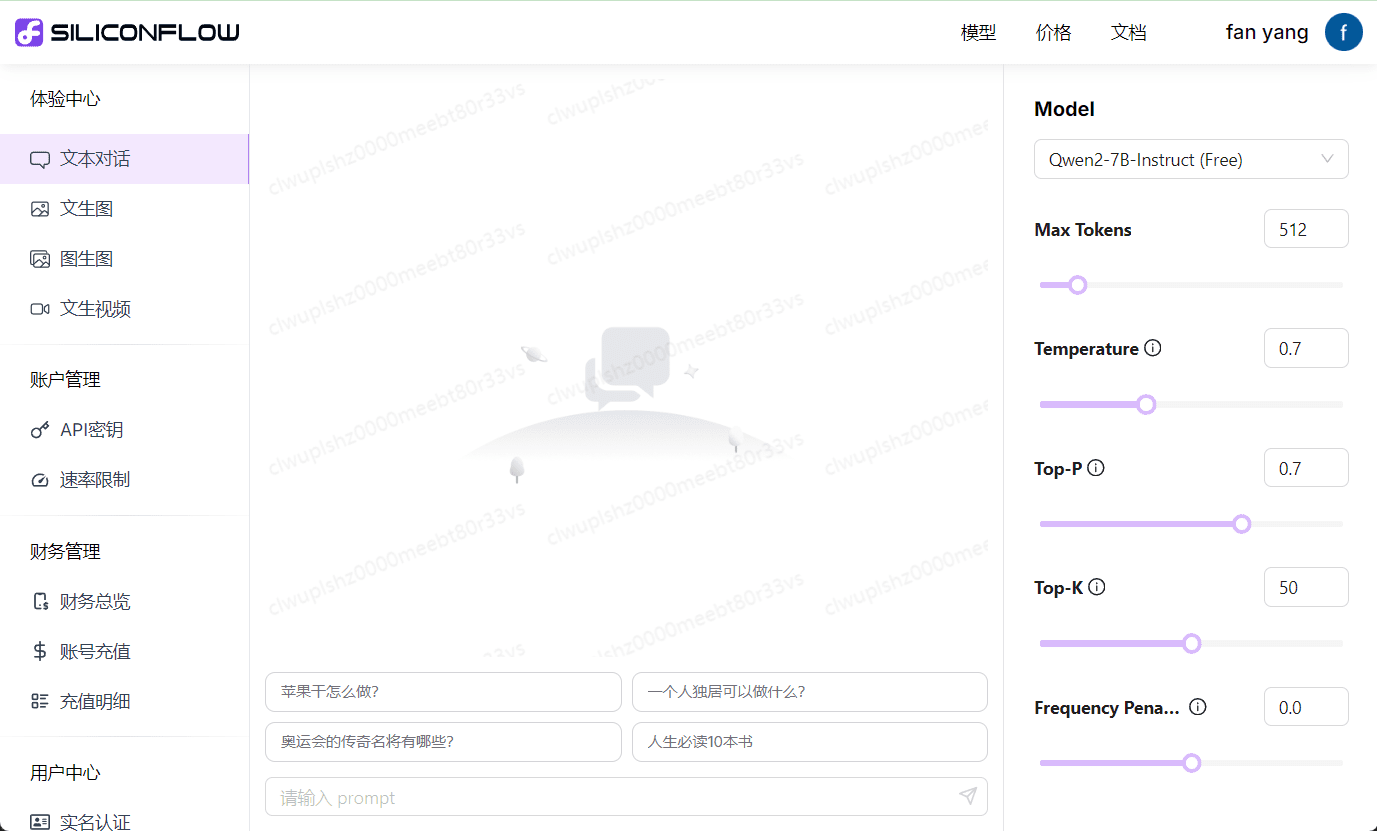

SILICONFLOW (Silicon Flow) : accélérer l'AGI pour l'humanité, en intégrant une interface libre pour les grands modèles.

Introduction générale

SiliconCloud 基于优秀的开源基础模型,提供高性价比的 GenAI 服务。

不同于多数大模型云服务平台只提供自家大模型 API,SiliconCloud上架了包括 Qwen、DeepSeek、GLM、Yi、Mistral、LLaMA 3、SDXL、InstantID 在内的多种开源大语言模型及图片生成模型,用户可自由切换适合不同应用场景的模型。

更重要的是,SiliconCloud 提供开箱即用的大模型推理加速服务,为您的 GenAI 应用带来更高效的用户体验。

对开发者来说,通过 SiliconCloud 即可一键接入顶级开源大模型。拥有更好应用开发速度和体验的同时,显著降低应用开发的试错成本。

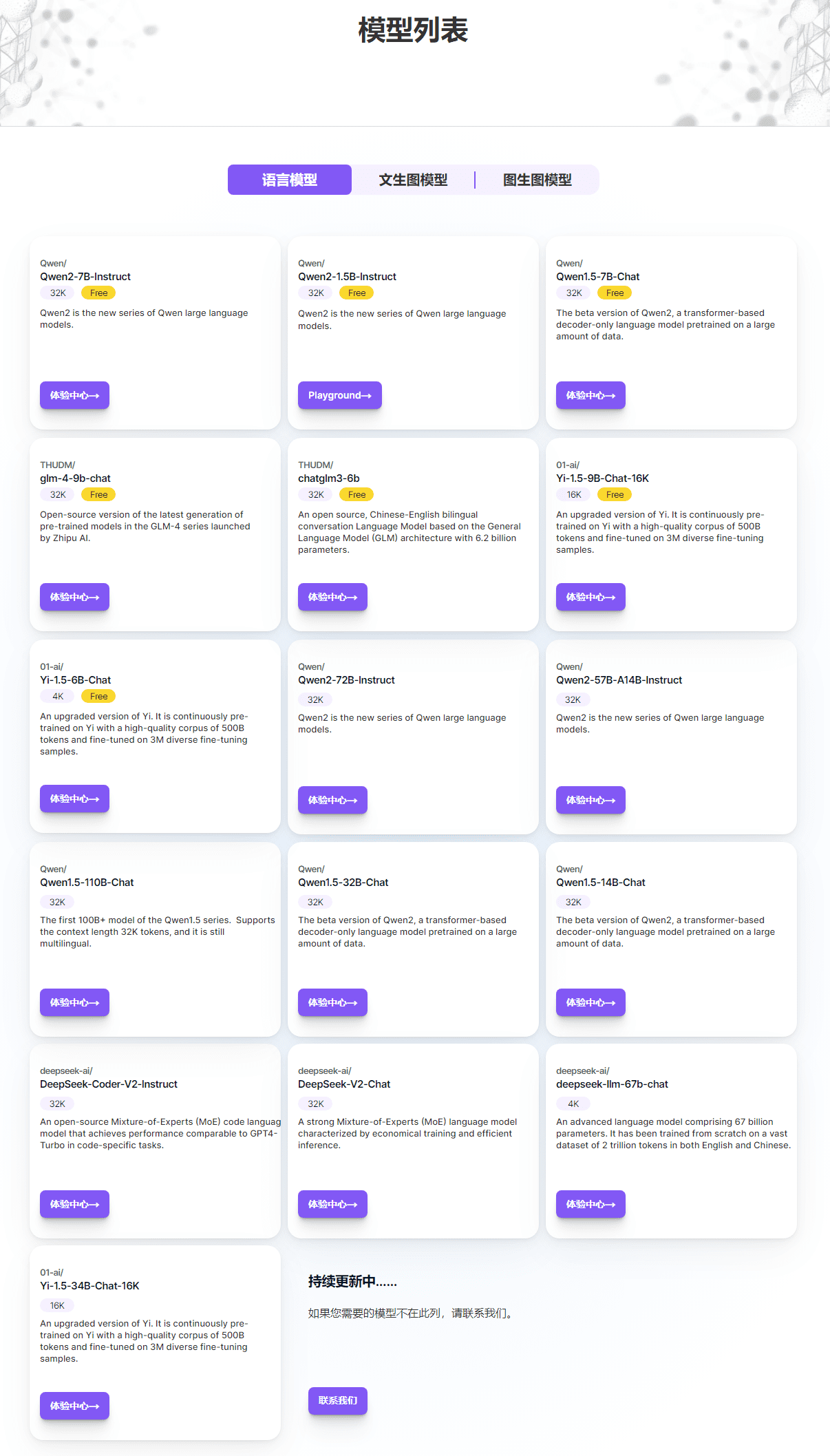

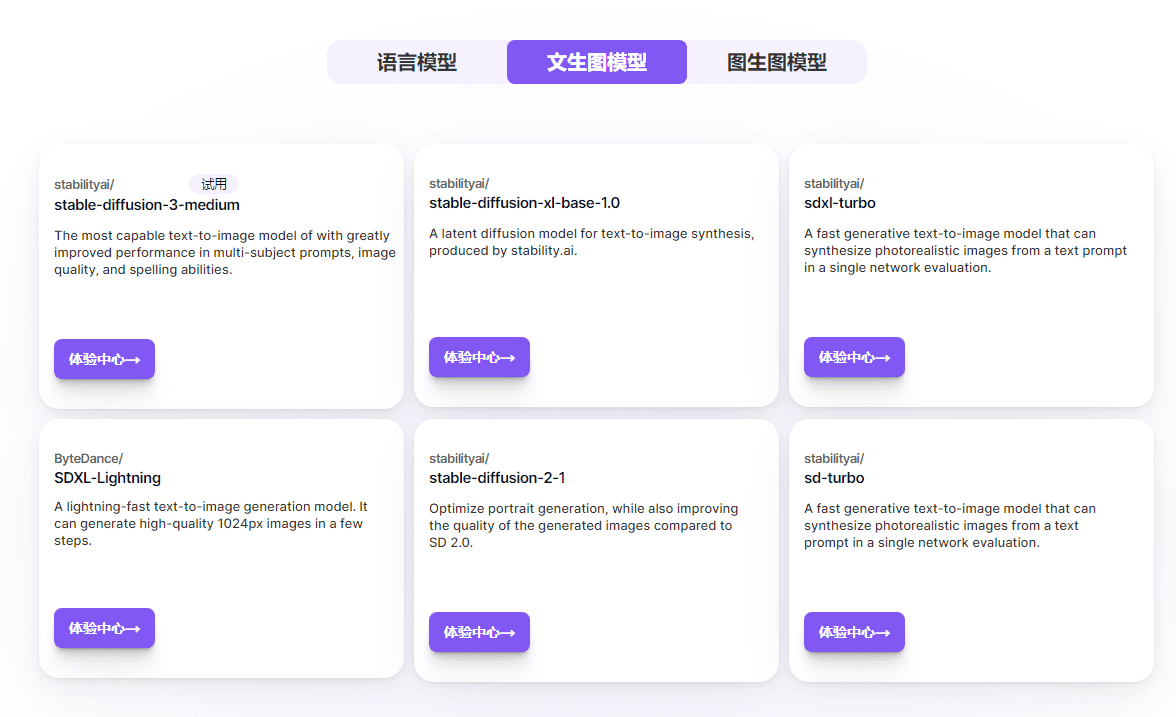

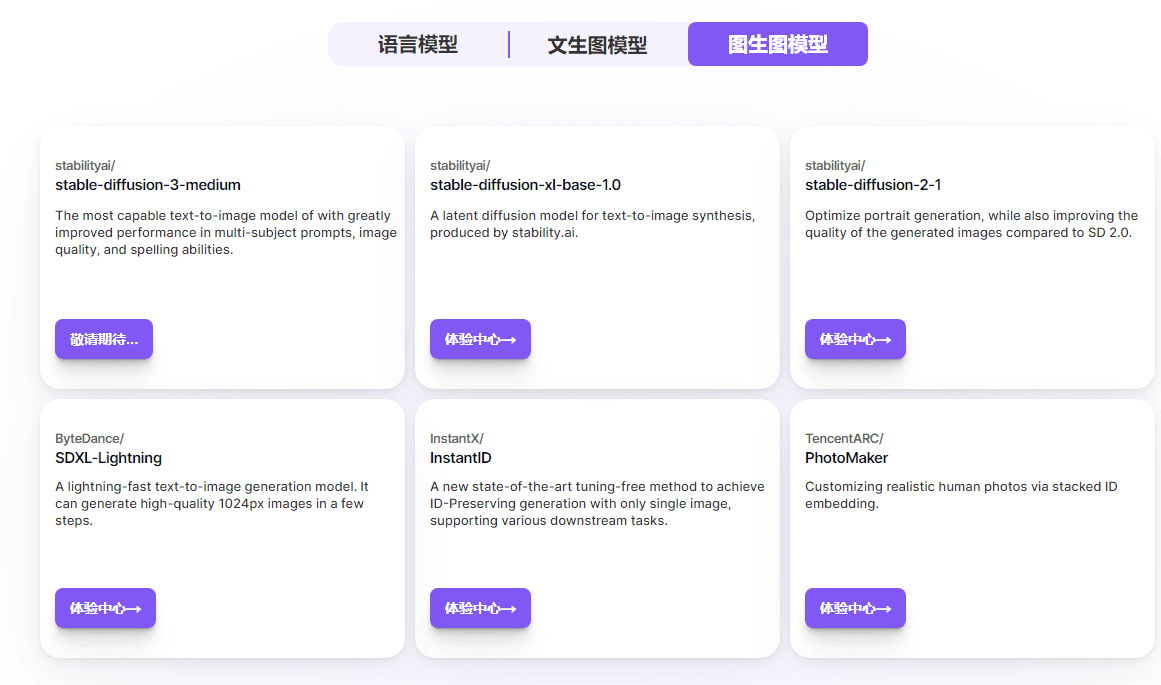

在 SiliconCloud模型 页面,您可以查看我们目前支持的语言模型、 文生图模型、图生图模型,并点击“体验中心”来实际测试使用该模型。

模型列表

免费模型列表

| Qwen/Qwen2-7B-Instruct | 32K |

|---|---|

| Qwen/Qwen2-1.5B-Instruct | 32K |

| Qwen/Qwen1.5-7B-Chat | 32K |

| THUDM/glm-4-9b-chat | 32K |

| THUDM/chatglm3-6b | 32K |

| 01-ai/Yi-1.5-9B-Chat-16K | 16K |

| 01-ai/Yi-1.5-6B-Chat | 4K |

| google/gemma-2-9b-it | 8K |

| internlm/internlm2_5-7b-chat | 32K |

| meta-llama/Meta-Llama-3-8B-Instruct | 8K |

| meta-llama/Meta-Llama-3.1-8B-Instruct | 8K |

| mistralai/Mistral-7B-Instruct-v0.2 | 32K |

使用 SiliconCloud API

基础URL: https://api.siliconflow.cn/v1

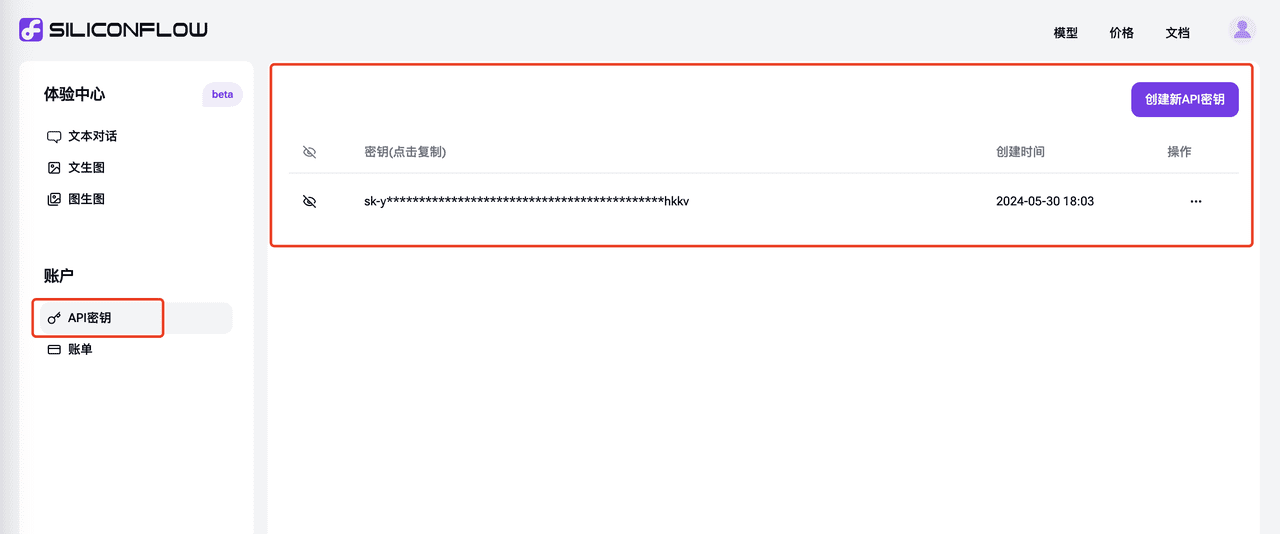

生成API密钥

在“API 密钥”页签 点击“创建新 API 密钥”,并点击复制,以在您的 API 场景中进行使用。

在沉浸式翻译中使用SiliconCloud API

在沉浸式翻译中,使用 SiliconCloud的API能力,达到快速跨语言翻译的目标

作为全网口碑炸裂的双语对照网页翻译插件,沉浸式翻译 结合大语言模型对于跨语言的理解能力,能够实时翻译外语内容,可应用于网页阅读,PDF 翻译,EPUB 电子书翻译,视频双语字幕翻译等场景,并支持各种浏览器插件和应用使用。自2023年上线以来,这款备受赞誉的 AI 双语对照网页翻译扩展,已帮助超过 100 万用户跨越语言障碍,自由汲取全球智慧。

硅基流动的 SiliconCloud近期第一时间提供了 GLM4、Qwen2、DeepSeek V2、Yi 等系列大模型,且模型速度非常快。如何将这二者结合起来,改善在沉浸式翻译场景的能力呢?

先看疗效

拿熟悉的中英互译进行说明。用杜甫经典的《登高》进行“中译英”测试,相比谷歌翻译和微软翻译,硅基流动提供的QWen 72B 模型对中文的理解更地道,译文也更贴近原文风格。

而同样基于同一段文本的“英译中”翻译,硅基流动提供的 模型也有更好的效果,译文更通顺流畅。

想要尝试其他场景,大家可以直接使用翻译文档多模型对比 进行测试,其中 SiliconCloud相关模型的配置详见“配置过程”部分。

配置过程:默认配置

- 在“沉浸式翻译”官网 选择“安装浏览器插件”,根据提示进行后续操作。如您已安装对应插件,请跳过本步骤。

- 在沉浸式翻译的图标中将“翻译服务”设置为“SiliconCloud”即可使用SiliconCloud 的翻译服务。

以上就完成了默认设置。

在默认设置外选择SiliconCloud的其他免费模型:

- 上述设置中默认模型是SiliconCloud 的“Qwen/Qwen2-7B-Instruct”,如果需要切换到其他SiliconCloud的模型,点击上述图标中的“设置”,即可进行 SiliconCloud相关设置。

在默认设置外选择SiliconCloud的其他尺寸模型:

- 如果需要使用上述 8 个模型之外的其他SiliconCloud 模型,点击沉浸式翻译的扩展图标,找到对应“设置”选项,如下图所示,选择“更多翻译服务”。

- 在其中添加 SiliconCloud模型的相关信息

- 自定义翻译服务名称:按照自己的实际情况填写即可,此处我们填写为"Qwen/Qwen2-72B-Instruct"

- 自定义API 接口地址:

APIKEY:从API 密钥 中点击复制过来。

- 模型名称:模型在siliconcloud中的名称,此处为“Qwen/Qwen2-72B-Instruct”,可使用平台模型列表获得当前所有支持的模型名称。

- 点击右上角的测试,验证测试成功。

- 至此已经完成相关模型配置项,就可以在沉浸式翻译插件中使用SiliconCloud 提供的大语言模型来提供翻译了。

在dify中使用 SiliconCloud API

utiliser dify 中内置的 SiliconCloud模型的API

作为一个经常使用 dify 工作流的用户,SiliconCloud在第一时间提供了 GLM4 、Qwen2、DeepSeek V2、Yi等最新模型,且模型速度非常快,那必须第一时间对接起来!

- 在进行设置,设置 SiliconCloud 平台账户的模型和 API Key 来设置大模型。

- 填入 SiliconCloud 平台的相关模型和 API Key 信息,并点击保存进行校验。使用SiliconCloud APIKey获得当前用户的 API Key,并复制到上述环境中。

- 接下来就可以在模型提供商的顶部区域看到SiliconFlow的相关模型了。

- 在应用中使用 SiliconCloud 对应的模型

经过上述步骤,您就可以在 Dify 开发应用过程中使用SiliconFlow所提供的丰富且快速的 LLM 模型了。

目前不在 dify 源代码中的 SiliconCloud 模型

目前 SiliconCloud 中还在源源不断引入新模型,因为双方迭代节奏的原因,部分模型不能第一时间在 Dify 中呈现,此处按照如下流程进行设置。

- 打开dify 的 settings 进行设置。

- 设置中选择 Model Provider 并设置“openai兼容 API”

- 在其中设置对应的 SiliconCloud 对应的Model Name、API Key, API 端点 API

Model Name: 从https://docs.siliconflow.cn/reference/chat-completions-1 文档中查找。

API Key: 从https://cloud.siliconflow.cn/account/ak 中获取,请注意,如果您使用海外模型,请遵守https://docs.siliconflow.cn/docs/use-international-outstanding-models 文档规则进行实名认证。

API 端点 URL:https://api.siliconflow.cn/v1

- 设置完成后,就可以在模型列表中看到上述新增的模型了。

© déclaration de droits d'auteur

L'article est protégé par le droit d'auteur et ne doit pas être reproduit sans autorisation.

Postes connexes

Pas de commentaires...