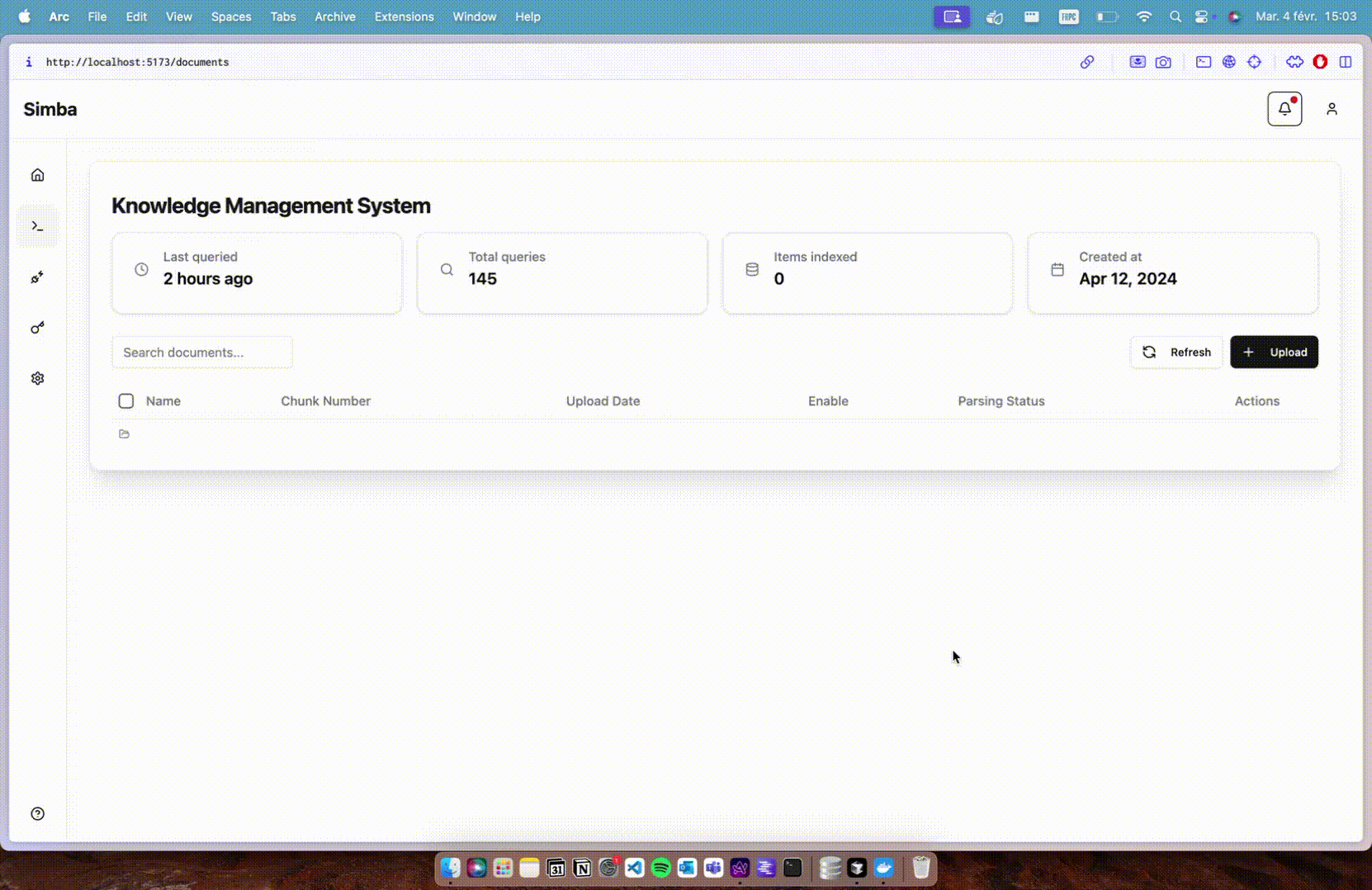

Simba : un système de gestion des connaissances pour l'organisation des documents, intégré de manière transparente dans tout système RAG.

Introduction générale

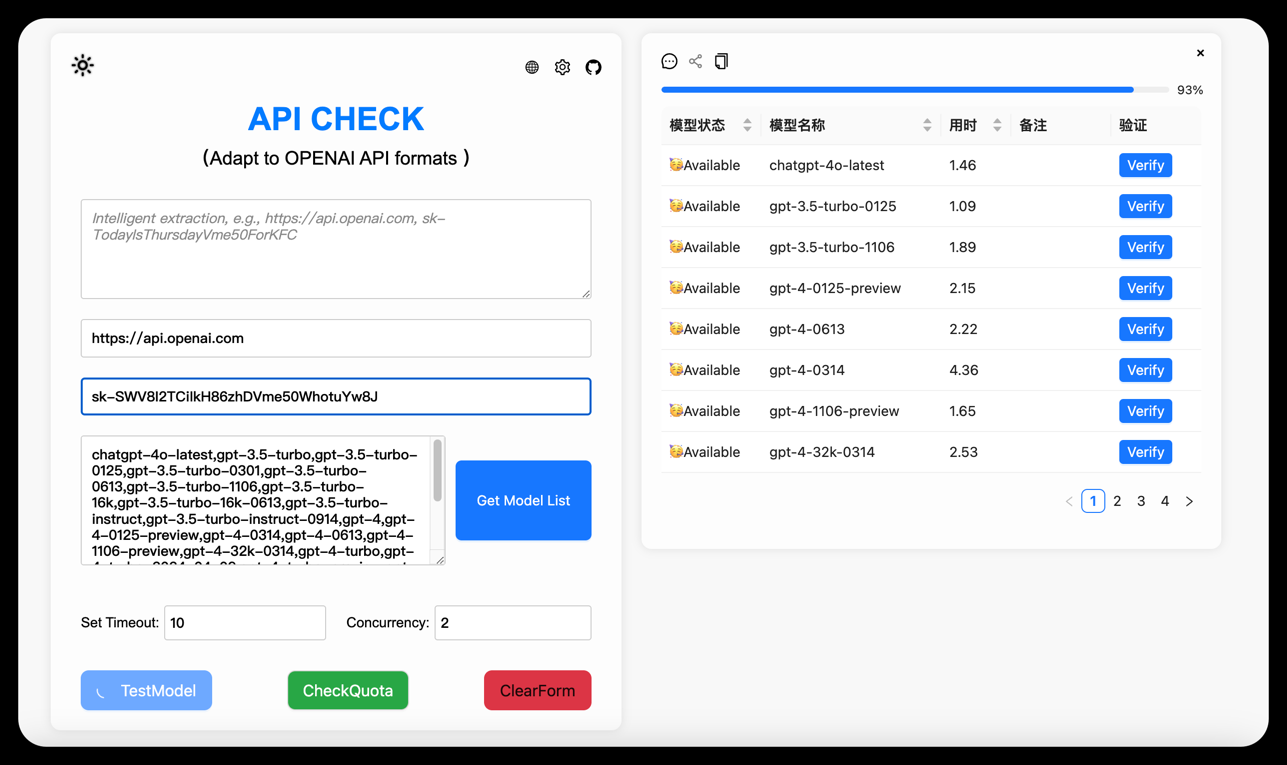

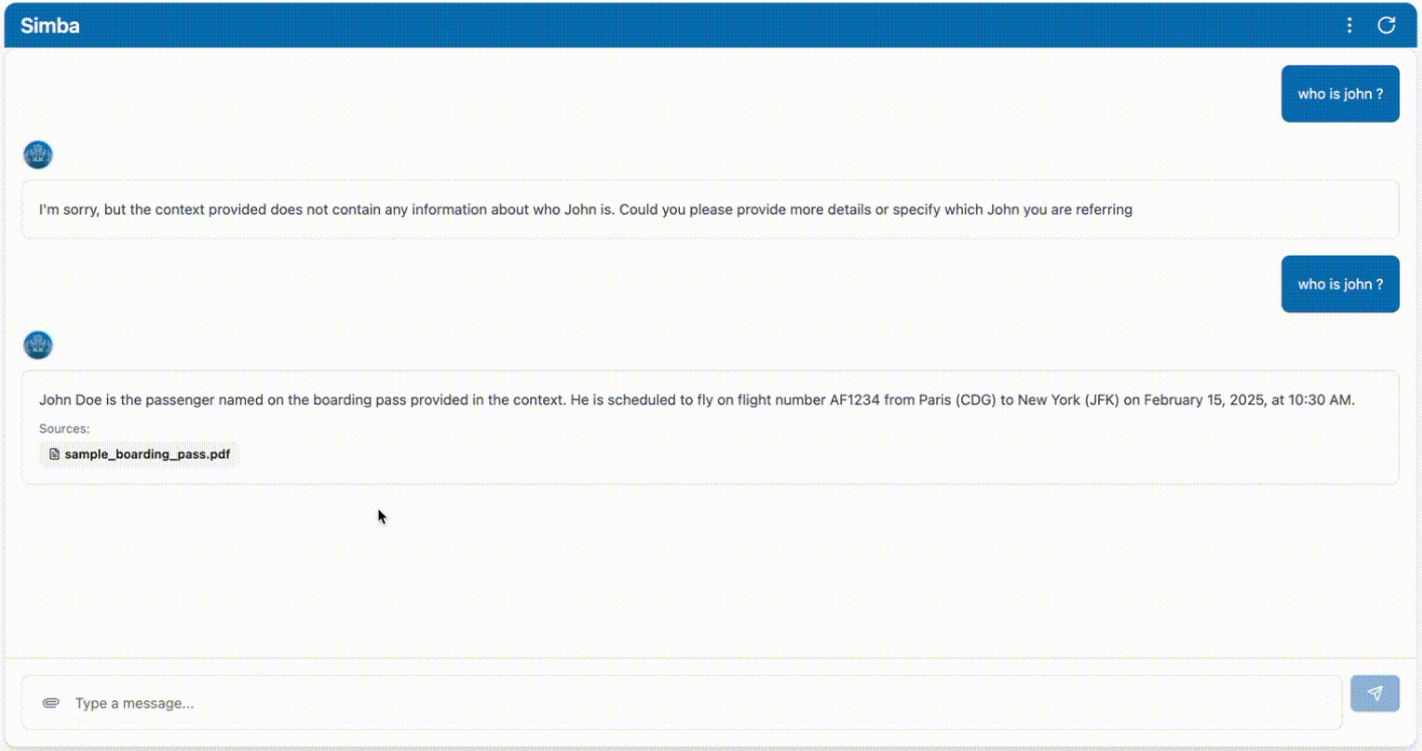

Simba est un système portable de gestion des connaissances (KMS) conçu pour s'intégrer de manière transparente à n'importe quel système RAG (Retrieval Augmented Generation). Créé par l'utilisateur GitHamza0206 de GitHub, le projet fournit une solution efficace de gestion des connaissances pour une variété de scénarios d'application.Simba est conçu dans le but de simplifier le processus de gestion des connaissances et d'améliorer la précision et l'efficacité de la recherche et de la génération d'informations. En s'intégrant au système RAG, Simba est en mesure de fournir un soutien puissant dans le traitement de données complexes et la génération de contenu.

Liste des fonctions

- la gestion des connaissancesLes services de gestion des connaissances : ils offrent une fonctionnalité complète de gestion des connaissances pour le stockage, la catégorisation et l'extraction des connaissances.

- Intégration des systèmes RAGLe système de génération d'informations : intégration transparente avec le système de génération d'informations pour améliorer la précision de la génération d'informations.

- portabilitéLe système est conçu comme un système portable, facile à déployer et à utiliser.

- projet open sourceLe projet : En tant que projet open source, les utilisateurs peuvent accéder librement au code source et le personnaliser.

- Recherche efficaceLe site web de la Commission européenne : Recherche d'informations optimisée pour trouver rapidement les connaissances dont vous avez besoin.

- interface convivialeLe système de gestion de l'information : Il offre une interface utilisateur intuitive qui simplifie le processus d'utilisation.

Utiliser l'aide

Processus d'installation

- entrepôt de clonesPour cela, il faut d'abord cloner le dépôt GitHub du projet Simba à l'aide de la commande Git.

git clone https://github.com/GitHamza0206/simba.git

- Installation des dépendancesPour cela, il faut se rendre dans le répertoire du projet et installer les paquets de dépendances nécessaires.

cd simba

développement local

- Paramètres du back-end: :

- Allez dans le répertoire du back-end :

cd backend- Assurez-vous que Redis est installé dans votre système d'exploitation :

redis-server- Définition des variables d'environnement :

cp .env.example .envEditez ensuite le fichier .env et indiquez vos valeurs :

OPENAI_API_KEY="" LANGCHAIN_TRACING_V2= #(optional - for langsmith tracing) LANGCHAIN_API_KEY="" #(optional - for langsmith tracing) REDIS_HOST=redis CELERY_BROKER_URL=redis://redis:6379/0 CELERY_RESULT_BACKEND=redis://redis:6379/1- Installer la dépendance :

poetry install poetry shellOu sur Mac/Linux :

source .venv/bin/activateSous Windows :

.venv\Scripts\activate- Exécuter le service back-end :

python main.pyOu utiliser le chargement automatique :

uvicorn main:app --reloadNaviguez ensuite jusqu'à

http://0.0.0.0:8000/docsAccès à l'interface utilisateur Swagger (facultatif).- Exécutez l'analyseur à l'aide de Celery :

celery -A tasks.parsing_tasks worker --loglevel=info- Modifier si nécessaire

config.yamlDocumentation :

project: name: "Simba" version: "1.0.0" api_version: "/api/v1" paths: base_dir: null # Will be set programmatically markdown_dir: "markdown" faiss_index_dir: "vector_stores/faiss_index" vector_store_dir: "vector_stores" llm: provider: "openai" #or ollama (vllm coming soon) model_name: "gpt-4o" #or ollama model name temperature: 0.0 max_tokens: null streaming: true additional_params: {} embedding: provider: "huggingface" #or openai model_name: "BAAI/bge-base-en-v1.5" #or any HF model name device: "cpu" # mps,cuda,cpu additional_params: {} vector_store: provider: "faiss" collection_name: "migi_collection" additional_params: {} chunking: chunk_size: 512 chunk_overlap: 200 retrieval: k: 5 #number of chunks to retrieve features: enable_parsers: true # Set to false to disable parsing celery: broker_url: ${CELERY_BROKER_URL:-redis://redis:6379/0} result_backend: ${CELERY_RESULT_BACKEND:-redis://redis:6379/1} - Paramètres frontaux: :

- Assurez-vous qu'il se trouve dans le répertoire racine de Simba :

bash

cd frontend - Installer la dépendance :

bash

npm install - Exécuter le service frontal :

bashNaviguez ensuite jusqu'à

npm run devhttp://localhost:5173Accéder à l'interface frontale.

- Assurez-vous qu'il se trouve dans le répertoire racine de Simba :

Démarrage avec Docker (recommandé)

- Naviguez jusqu'au répertoire racine de Simba :

export OPENAI_API_KEY="" #(optional)

docker-compose up --build

Structure du projet

simba/

├── backend/ # 核心处理引擎

│ ├── api/ # FastAPI端点

│ ├── services/ # 文档处理逻辑

│ ├── tasks/ # Celery任务定义

│ └── models/ # Pydantic数据模型

├── frontend/ # 基于React的UI

│ ├── public/ # 静态资源

│ └── src/ # React组件

├── docker-compose.yml # 开发环境

└── docker-compose.prod.yml # 生产环境设置

configurer

config.yamlest utilisé pour configurer l'application back-end. Vous pouvez modifier les éléments suivants :

- Intégration de modèles

- stockage vectoriel

- morceau

- récupérer (données)

- Fonctionnalité

- résolveur

Pour plus d'informations, veuillez consulterbackend/README.md.

© déclaration de droits d'auteur

L'article est protégé par le droit d'auteur et ne doit pas être reproduit sans autorisation.

Articles connexes

Pas de commentaires...