TANGO : un outil pour la réalisation de portraits vidéo de gestes coordonnés générés par la voix d'une personne numérique au corps entier

Introduction générale

TANGO (Co-Speech Gesture Video Reenactment with Hierarchical Audio-Motion Embedding and Diffusion Interpolation) est un logiciel libre développé conjointement par l'Université de Tokyo et CyberAgent AI Labs. pour la génération collaborative de vidéos vocales et gestuelles. Le projet utilise l'espace d'intégration audio-moteur hiérarchique et l'interpolation par diffusion pour générer automatiquement des vidéos de gestes de personnages naturels, fluides et synchronisés sur la base de la parole d'entrée. TANGO parvient à générer des gestes et des actions de haute qualité grâce à une méthode innovante de récupération du graphe d'action, qui récupère tout d'abord le clip vidéo de référence qui correspond le mieux à la parole cible dans un espace d'intégration audio-moteur implicitement hiérarchique, puis utilise un modèle de diffusion pour l'interpolation des actions. génération d'actions. Ce projet ne fait pas seulement progresser la recherche sur l'interaction homme-machine pilotée par l'IA, mais fournit également un soutien technique important pour des applications telles que les ancres virtuelles et les humains numériques.

Le logiciel libre actuel TANGO ne prend en charge que l'audio jusqu'à 8 secondes, avant de l'utiliser, vous devez segmenter le fichier audio !

Travaillez avec l'outil Voice Lip Sync pour un projet complet de personne numérique : Sync ,Wav2Lip Ultralight Digital Human. Le flux de travail complet est le suivant : Ultralight Digital Human pour le contrepoint, TANGO pour générer les mouvements du corps, FaceFusion pour changer les visages, parfait !

Expérience en ligne : https://huggingface.co/spaces/H-Liu1997/TANGO

Liste des fonctions

- Synchronisation très précise des gestes : synchronisation précise de l'audio avec les gestes de la vidéo.

- Prise en charge multilingue : fonctionne avec une grande variété de langues et de sons, y compris des visages CGI et des sons synthétiques.

- Open source et gratuit : le code est entièrement public, et les utilisateurs sont libres de l'utiliser et de le modifier.

- Démonstration interactive : fournit une démonstration en ligne où les utilisateurs peuvent télécharger des fichiers vidéo et audio pour en faire l'expérience.

- Modèles de pré-entraînement : les modèles de pré-entraînement sont nombreux et les utilisateurs peuvent les utiliser directement ou les utiliser pour l'entraînement secondaire.

- Code d'entraînement complet : comprend le code d'entraînement pour le discriminateur de synchronisation des gestes et le modèle TANGO.

Utiliser l'aide

1. configuration de l'environnement

1.1 Exigences de base :

- Version de Python : 3.9.20

- Version CUDA : 11.8

- Espace disque : au moins 35 Go (pour le stockage des modèles et des diagrammes précalculés)

1.2 Étapes de l'installation :

# 克隆项目仓库

git clone https://github.com/CyberAgentAILab/TANGO.git

cd TANGO

git clone https://github.com/justinjohn0306/Wav2Lip.git

git clone https://github.com/dajes/frame-interpolation-pytorch.git

# 创建虚拟环境(可选)

conda create -n tango python==3.9.20

conda activate tango

# 安装依赖

pip install -r ./pre-requirements.txt

pip install -r ./requirements.txt

2. flux d'utilisation

2.1 Démarrage rapide :

- Exécutez le script de raisonnement :

python app.py

Lors de la première exécution, le système télécharge automatiquement les fichiers de points de contrôle nécessaires et les diagrammes précalculés. La génération d'environ 8 secondes de vidéo prend environ 3 minutes de temps de traitement.

2.2 Création de rôles personnalisés :

- Si vous devez créer une figurine pour un nouveau personnage :

python create_graph.py

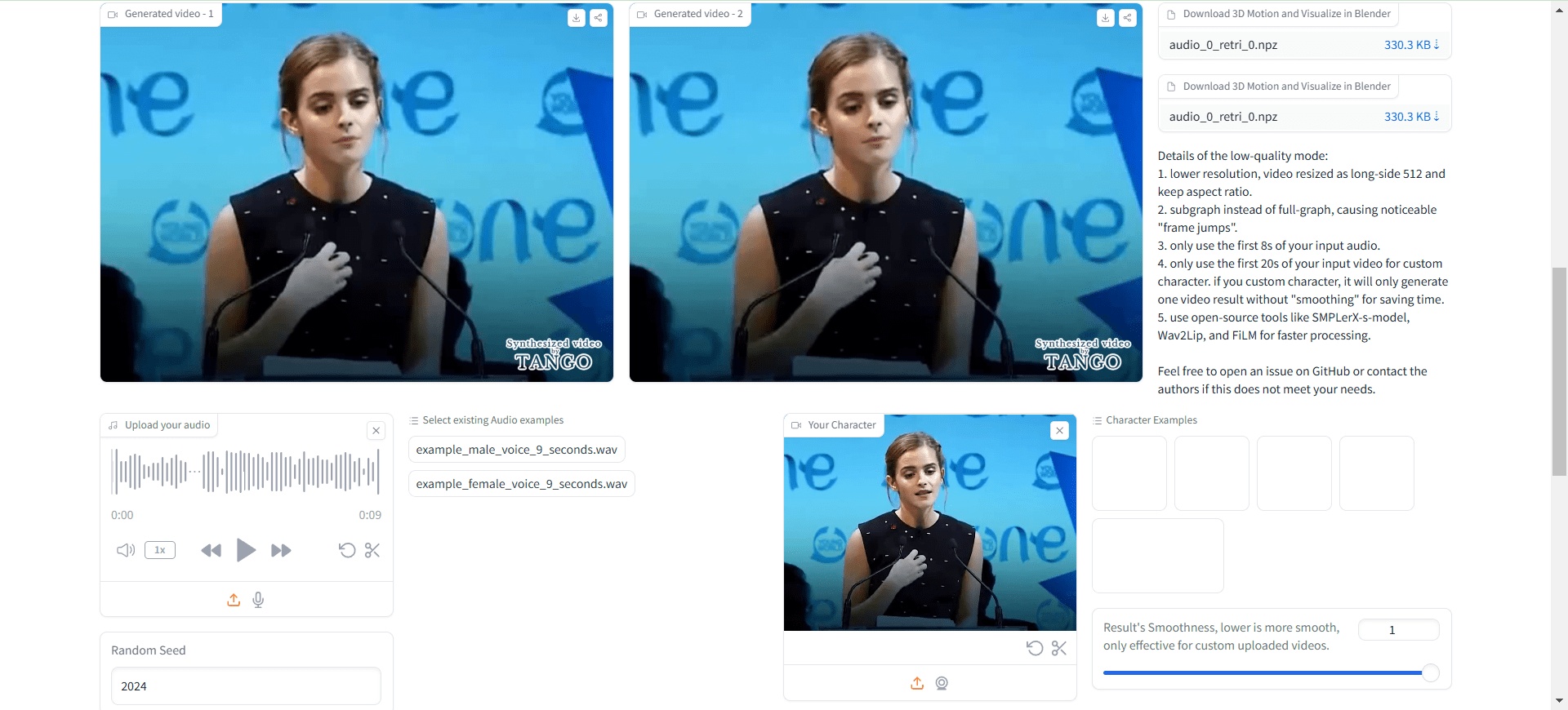

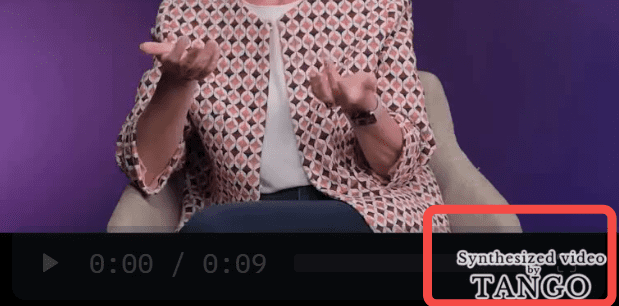

Entre autres choses, le projet génère par défaut des vidéos avec des filigranes TANGO, comme dans l'exemple ci-dessous :

Il s'agit essentiellement d'un appel à un ffmpeg local qui compose la vidéo originale et l'image filigranée en une nouvelle vidéo.

Si vous ne souhaitez pas de filigrane, vous pouvez modifier les paramètres suivantsapp.pyAu milieu :

gr.Video(value="./datasets/cached_audio/demo1.mp4", label="Demo 0", , watermark="./datasets/watermark.png") # 修改为 gr.Video(value="./datasets/cached_audio/demo1.mp4", label="Demo 0")

Accès non local, modifications requises :

demo.launch(server_name="0.0.0.0", server_port=7860)

Ouvrez-la à nouveau pour constater qu'il n'y a pas de filigrane dans la vidéo chargée.

La vidéo finale générée n'a pas de son, vous devez donc synthétiser manuellement le son dans la vidéo.

/usr/bin/ffmpeg -i outputs/gradio/test_0/xxx.mp4 -i gen_audio.wav -c:v libx264 -c:a aac result_wav.mp4

On peut remarquer qu'il n'y a rien d'anormal dans les mouvements du corps, mais que la forme de la bouche est complètement erronée.

Ce n'est pas le cas. Humain numérique ultraléger Et c'est devenu utile ?

Processus d'utilisation

- Accès au serveur local : Ouvrir dans le navigateur

http://localhost:3000. - Télécharger la vidéo et l'audio : téléchargez les fichiers audio et vidéo que vous souhaitez synchroniser dans la zone de saisie.

- Effectuer la synchronisation des gestes : Appuyez sur le bouton "Sync", le système effectuera automatiquement le processus de synchronisation des gestes.

- Visualisation et téléchargement des résultats : une fois la synchronisation terminée, vous pouvez prévisualiser les résultats et télécharger les fichiers vidéo synchronisés.

- Utiliser la démo interactive : téléchargez des fichiers vidéo et audio sur la page de démo pour découvrir l'effet de synchronisation gestuelle en temps réel.

- Gérer les projets : afficher et gérer tous les projets téléchargés sur la page Mes projets, avec prise en charge du contrôle des versions et de la collaboration.

Fonctionnalités avancées

- Synchronisation gestuelle intelligente : améliorez la présentation de votre contenu vidéo grâce à la synchronisation gestuelle intelligente assurée par l'IA.

- Prise en charge multilingue : sélectionnez différentes langues et voix en fonction des besoins de votre projet.

- Développement personnalisé : TANGO étant un logiciel libre, les utilisateurs peuvent le développer en fonction de leurs besoins.

© déclaration de droits d'auteur

L'article est protégé par le droit d'auteur et ne doit pas être reproduit sans autorisation.

Articles connexes

Pas de commentaires...