Xorbits Inference : déploiement en un clic de plusieurs modèles d'IA, un cadre d'inférence distribué

Introduction générale

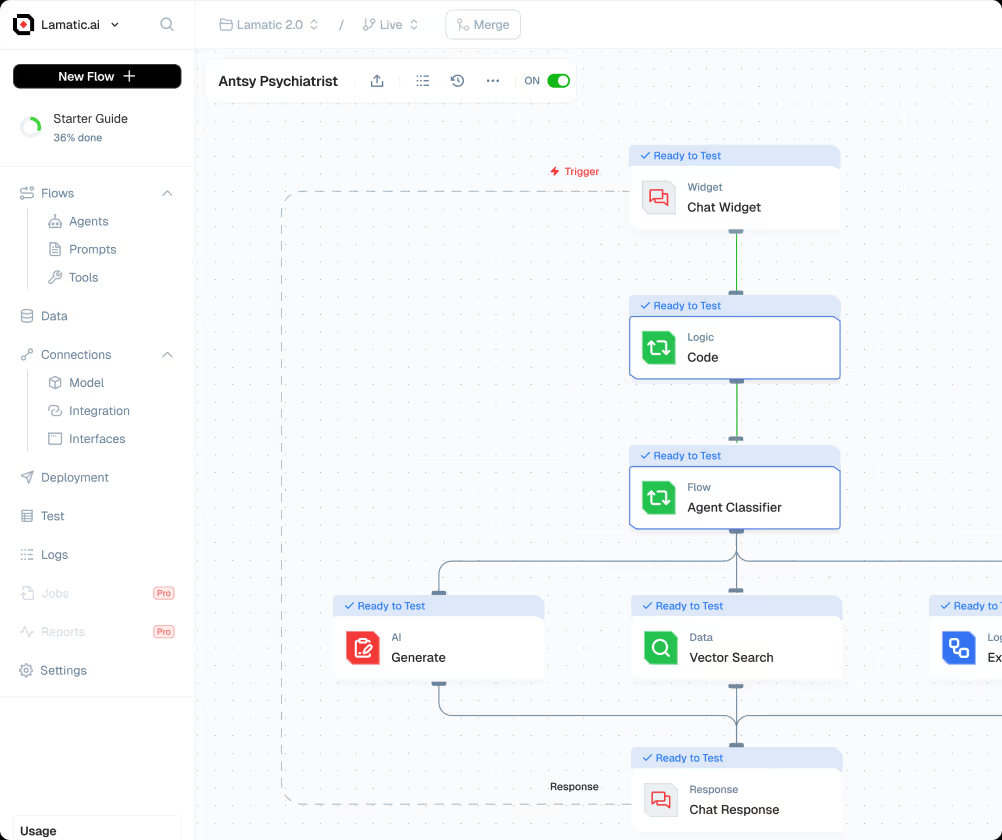

Xorbits Inference (Xinference) est un cadre d'inférence distribué puissant et complet qui prend en charge l'inférence d'une large gamme de modèles d'intelligence artificielle tels que les grands modèles de langage (LLM), les modèles de reconnaissance vocale et les modèles multimodaux. Avec Xorbits Inference, les utilisateurs peuvent facilement déployer leurs propres modèles en un seul clic ou utiliser les modèles open-source de pointe intégrés, qu'ils fonctionnent dans le nuage, sur un serveur local ou sur un PC.

Liste des fonctions

- Prise en charge du raisonnement avec de multiples modèles d'IA, y compris des modèles de langage étendu, des modèles de reconnaissance vocale et des modèles multimodaux.

- Déploiement en un clic et modèles de service pour simplifier la mise en place d'environnements expérimentaux et de production

- Prise en charge de l'exécution dans le nuage, sur des serveurs locaux et sur des PC

- Intégration d'une variété de modèles open-source de pointe pour le confort direct de l'utilisateur

- Fournir une documentation riche et un soutien à la communauté

Utiliser l'aide

Processus d'installation

- Préparation de l'environnementPython : Assurez-vous que Python 3.7 ou supérieur est installé.

- Installation de Xorbits Inference: :

pip install xorbits-inference - Environnement de configuration:根据需要配置环境变量和依赖项。

Processus d'utilisation

- Modèles de chargement: :

from xinference import InferenceEngine engine = InferenceEngine(model_name="gpt-3") - raisonnement en cours d'exécution: :

result = engine.infer("你好,世界!") print(result) - modèle de déploiement: :

xinference deploy --model gpt-3 --host 0.0.0.0 --port 8080

Fonctionnement détaillé

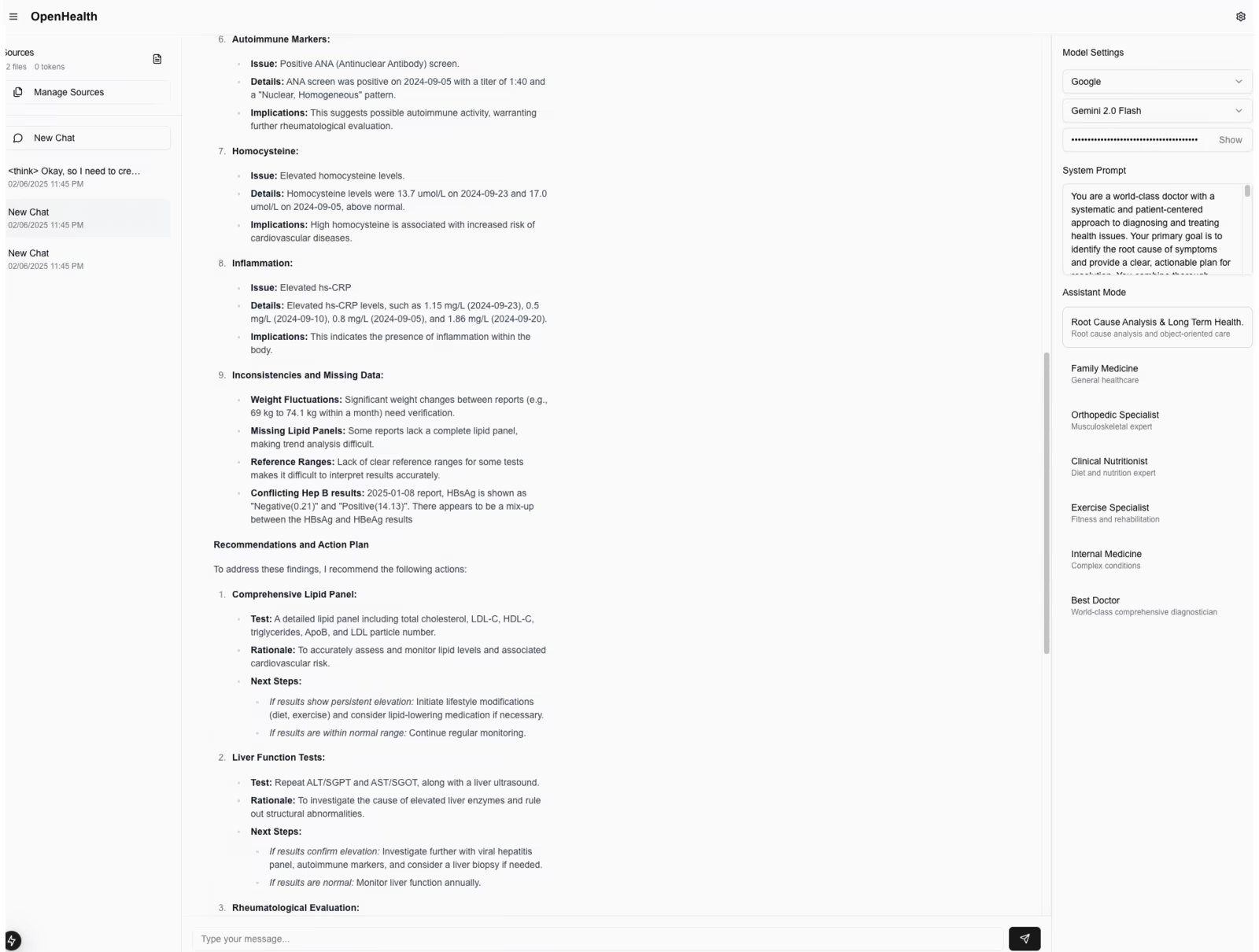

- Sélection du modèleLes utilisateurs peuvent choisir parmi une large gamme de modèles open-source intégrés, tels que GPT-3, BERT, etc., ou télécharger leurs propres modèles pour l'inférence.

- Configuration des paramètresLes paramètres du modèle : Lors du déploiement d'un modèle, vous pouvez configurer les paramètres du modèle, tels que la taille du lot, l'utilisation du GPU, etc. en fonction de vos besoins.

- Suivi et gestionLes utilisateurs peuvent, grâce à l'interface de gestion fournie, contrôler en temps réel l'état de fonctionnement du modèle et les indicateurs de performance, ce qui facilite l'optimisation et l'ajustement.

- Soutien communautaireLes utilisateurs de Xorbits Inference sont invités à rejoindre la communauté Slack pour partager leurs expériences et leurs questions avec d'autres utilisateurs et obtenir de l'aide et du soutien en temps voulu.

© déclaration de droits d'auteur

L'article est protégé par le droit d'auteur et ne doit pas être reproduit sans autorisation.

Articles connexes

Pas de commentaires...