GLM-4.5 - 智谱开源的面向推理、代码与智能体的SOTA模型

GLM-4.5是什么

GLM-4.5 是智谱推出的开源 SOTA 模型,专为智能体应用设计,融合推理、代码生成和智能体能力。模型基于混合专家(MoE)架构,包含两个版本,3550 亿参数的 GLM-4.5 和 1060 亿参数的 GLM-4.5-Air,激活参数分别为 320 亿和 120 亿。模型在推理、代码生成等任务中表现出色,支持多模态输入输出,提供“思考模式”和“非思考模式”适应复杂任务和即时响应需求。模型参数效率高,API 调用成本低,生成速度快,适用全栈开发、编程辅助、内容创作等多种场景,是目前开源模型中的佼佼者。

GLM-4.5的主要功能

- 推理能力:GLM-4.5 能处理复杂的推理任务,例如逻辑推理、数学问题求解等,推理能力在多个基准测试中表现卓越,达到开源模型的顶尖水平。

- 代码生成:模型能生成高质量的代码片段,支持多种编程语言,帮助开发者快速生成代码框架、修复代码错误、优化代码结构等,胜任全栈开发任务。

- 智能体应用:支持工具调用、网页浏览等功能,支持接入代码智能体框架,如 Claude Code 和 Roo Code,适用智能体任务,满足复杂智能体应用的需求。

- 内容生成:能生成各种类型的内容,如文章、新闻报道、创意文案等,适用内容创作、文案撰写等场景,为用户提供丰富的文本生成支持。

GLM-4.5的官网地址

- GitHub仓库:https://github.com/zai-org/GLM-4.5

- HuggingFace仓库: https://huggingface.co/collections/zai-org/glm-45-687c621d34bda8c9e4bf503b

- ModelScope仓库:https://modelscope.cn/collections/GLM-45-b8693e2a08984f

- 在线体验Demo:

- HuggingFace: https://huggingface.co/spaces/zai-org/GLM-4.5-Space

- ModelScope:https://modelscope.cn/studios/ZhipuAI/GLM-4.5-Demo

如何使用GLM-4.5

- 在线平台体验:

- API 调用:智谱 AI 提供 API 接口,用户通过 BigModel.cn 平台进行 API 调用。API 支持多种功能,包括文本生成、代码生成和推理任务等。

- 通过开源代码部署:

- GitHub 仓库:访问 GLM-4.5 的 GitHub 仓库,获取模型代码和相关资源,自行部署和使用。

- HuggingFace 仓库:访问 GLM-4.5 的 HuggingFace 仓库,用 HuggingFace 提供的工具和环境进行部署和测试。

- ModelScope 仓库:访问 GLM-4.5 的 ModelScope 仓库,用 ModelScope 的平台功能进行模型部署和应用开发。

- HuggingFace 体验空间:访问 HuggingFace 的 GLM-4.5 体验空间,快速试用模型的各种功能。

- ModelScope 体验空间:访问 ModelScope 的 GLM-4.5 体验空间,进行在线体验和测试。

GLM-4.5的技术指标

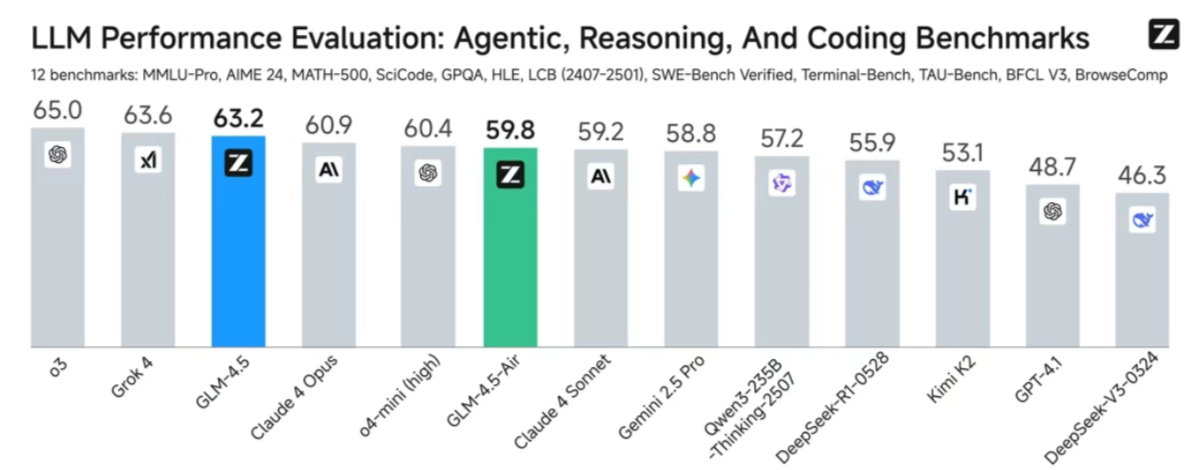

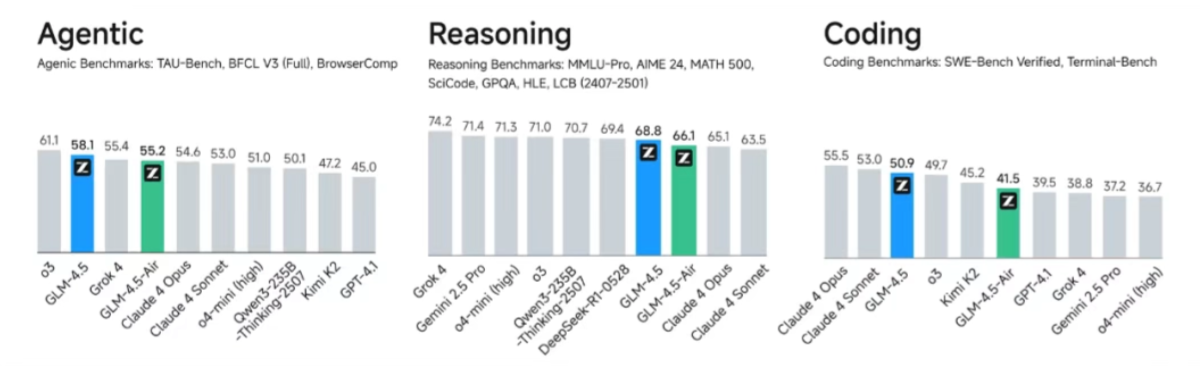

- 综合性能SOTA:在12个具有代表性的评测基准中,GLM-4.5取得全球模型第三、国产模型第一、开源模型第一的成绩。评测基准包括MMLU Pro、AIME 24、MATH 500、SciCode、GPQA、HLE、LiveCodeBench、SWE-Bench Verified、Terminal-Bench、TAU-Bench、BFCL v3和BrowseComp,充分证明GLM-4.5在推理、代码生成和智能体应用等多场景下的卓越表现。

- 更高的参数效率:GLM-4.5的参数量仅为DeepSeek-R1的1/2、Kimi-K2的1/3,在多项标准基准测试中表现更为出色。在衡量模型代码能力的SWE-bench Verified榜单上,GLM-4.5系列位于性能/参数比帕累托前沿,表明在相同规模下,GLM-4.5系列实现最佳性能。

- 低成本、高速度:在性能优化的同时,GLM-4.5系列在成本和效率上实现突破。API调用价格低至输入0.8元/百万tokens,输出2元/百万tokens,远低于主流模型定价。高速版本实测生成速度最高可达100tokens/秒,支持低延迟、高并发的实际部署需求,兼顾成本效益与交互体验。

GLM-4.5的核心优势

- 多能力融合:GLM-4.5 是首个原生融合推理、代码生成和智能体能力的模型,能同时满足复杂推理、代码开发和智能体任务的多样化需求。

- 推理性能卓越:在多个推理评测基准中,GLM-4.5 的表现达到开源模型的顶尖水平,能处理复杂的推理任务,如逻辑推理、数学问题求解等,推理能力非常强大。

- 高效的混合推理模式:模型提供“思考模式”和“非思考模式”两种推理模式。思考模式适用需要深入分析的复杂任务,非思考模式能快速响应,满足即时需求,兼顾效率和性能。

- 参数效率高:GLM-4.5 的参数量小,但在多项标准基准测试中表现更为出色。例如,在代码生成能力的测试中,GLM-4.5 的性能/参数比处于领先水平。

- 低成本与高速度:GLM-4.5 的 API 调用价格非常实惠,输入成本低至 0.8 元/百万 tokens,输出成本为 2 元/百万 tokens。生成速度最高可达 100 tokens/秒,支持低延迟和高并发的实际部署需求。

- 多模态支持:GLM-4.5 支持多模态输入和输出,能处理文本、图像等多种数据类型,在处理复杂的智能体任务时更加得心应手,例如在网页浏览、工具调用等多模态交互场景中表现出色。

GLM-4.5的适用人群

- 开发者和程序员:借助代码生成和编程辅助功能,快速生成代码框架、修复错误、优化结构,提升开发效率。

- 内容创作者:快速生成文章、新闻、创意文案等初稿,提供创意灵感,帮助突破创作瓶颈。

- 学术研究人员:作为研究工具,助力探索自然语言处理和人工智能前沿问题,进行模型对比和改进。

- 企业用户:用在构建智能客服、生成数据分析报告、开发自动化工具,提高企业运营效率。

- 教育工作者和学生:教师生成教学材料,学生借助其学习辅助功能,如生成笔记、解释概念等。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...