FastDeploy - Baiduの高性能大規模モデル推論・展開ツール

FastDeploy とは何ですか?

FastDeployは、大規模言語モデル(LLM)や視覚言語モデル(VLM)向けに設計された、百度の高性能推論・デプロイツールです。FastDeployは、PaddlePaddleフレームワークをベースに開発され、複数のハードウェアプラットフォーム(NVIDIA GPU、Kunlun XPUなど)をサポートし、負荷分散、定量的最適化、分散推論などの機能を備えています、FastDeploy は、OpenAI API および ブイエルエルエム インターフェースにより、ローカル推論とサービス推論をサポートし、大規模モデルの展開プロセスを簡素化します。最新バージョンであるFastDeploy 2.0では、パフォーマンスをさらに最適化し、大規模モデルの効率的なデプロイメントをサポートするために、2ビット量子化技術が導入されています。

FastDeploy の主な機能

- 効率的な推論展開NVIDIA GPUやKunlun Core XPUなど様々なハードウェアプラットフォームをサポートし、大規模モデルの推論展開プロセスを簡素化するワンクリック展開機能を提供します。

- パフォーマンス最適化量子化技術(例:2ビット量子化)、CUDAグラフ最適化、投機的デコーディングにより、モデル推論速度を大幅に改善。

- 分散推論大規模分散推論をサポートし、通信効率を最適化し、大規模モデルの推論効率を向上させます。

- ロードバランシングとスケジューリングRedisをベースとしたリアルタイムのロードセンシングと分散ロードバランシングスケジューリングにより、クラスタパフォーマンスを最適化し、高負荷下でも安定したシステム運用を実現。

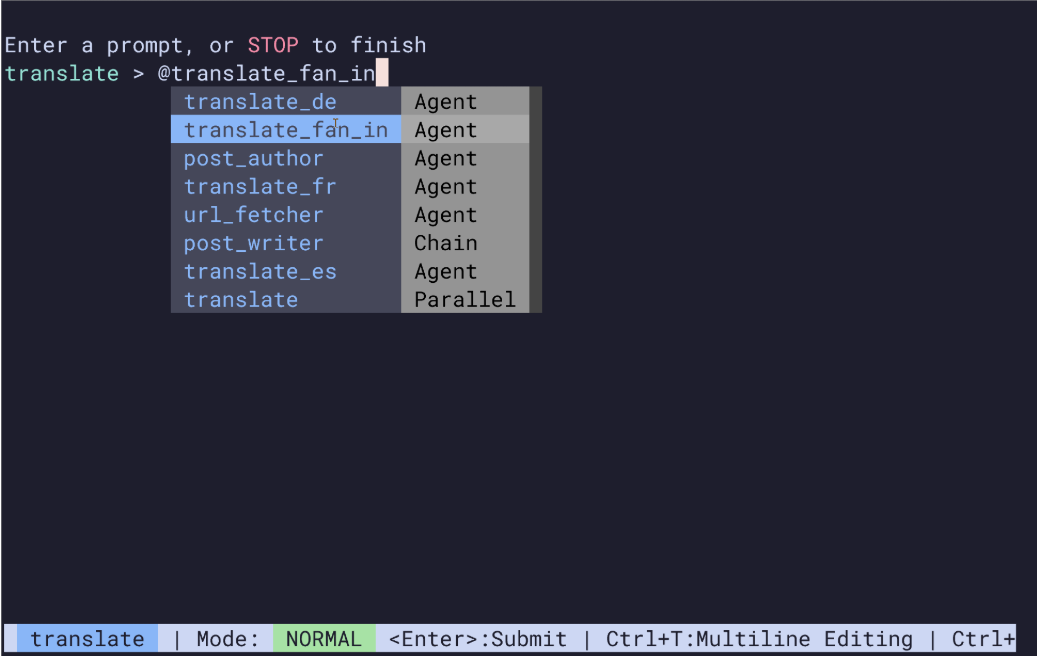

- ユーザビリティクリーンなPythonインターフェースと詳細なドキュメントを提供することで、ユーザがすぐに使い始められるようにします。

- 2ビット量子化技術2ビット量子化の導入により、メモリフットプリントとハードウェアリソース要件が劇的に削減され、1枚のカードで数千億のパラメータレベルモデルの展開がサポートされる。

- 互換性OpenAI APIとvLLMインターフェースと互換性があり、ローカル推論とサービス推論の両方をサポートしています。4行のコードでローカル推論を完了し、1行のコマンドでサービスを開始します。

FastDeployの公式ウェブサイトアドレス

- プロジェクトのウェブサイト:: https://paddlepaddle.github.io/FastDeploy/

- GitHubリポジトリ:: https://github.com/PaddlePaddle/FastDeploy

FastDeploy の使用方法

- 依存関係のインストールフライング・パドル・フレームを取り付け、FastDeployする:

pip install paddlepaddle fastdeploy- モデルを準備する:モデルファイル(学習済みモデルや変換済みモデルなど)をダウンロードして準備する。

- 局所推論Pythonインターフェースによる局所推論:

from fastdeploy import inference

# 加载模型

model = inference.Model("path/to/model")

# 准备输入数据

input_data = {"input_ids": [1, 2, 3], "attention_mask": [[1, 1, 1]]}

# 进行推理

result = model.predict(input_data)

print(result)- サービス指向の展開推論サービスを開始します:

fastdeploy serve --model path/to/model --port 8080- パフォーマンス最適化定量的手法によるモデルの最適化

from fastdeploy import quantization

quantized_model = quantization.quantize_model("path/to/model", "path/to/quantized_model", quantization_type="2-bit")FastDeploy の主な利点

- ハイパフォーマンス推論同社の技術は、量子化、CUDAグラフ、その他の技術に基づき、推論速度を大幅に向上させるとともに、複数のハードウェア・プラットフォームをサポートし、ハードウェアの性能をフルに発揮させる。

- 効率的な配備クリーンなPythonインターフェースとコマンドラインツールを提供し、ローカルおよびサービス推論をサポートし、デプロイメントプロセスを簡素化します。

- リソースの最適化システムに新たに追加された2ビット量子化技術は、グラフィックス・メモリのフットプリントを劇的に削減し、ハイパースケールモデルのシングルカード展開をサポートし、ロードバランシングによりクラスタリソースの利用を最適化する。

- ユーザビリティインターフェイスはシンプルで文書化されており、OpenAIのAPIやvLLMのインターフェイスと互換性があり、サービスの迅速な立ち上げをサポートする。

- マルチシナリオ・アプリケーション自然言語処理、マルチモーダル・アプリケーション、産業グレードの展開、学術研究、企業アプリケーションなど、多様なニーズに幅広く対応。

FastDeploy の対象者

- エンタープライズ・デベロッパーエンタープライズ・デベロッパーは、大規模なモデルを迅速に展開し、リソースを最適化してコストを削減し、エンタープライズ・サービスの効率化を支援します。

- データサイエンティストと研究者研究者による高性能な推論実験とマルチモーダル研究により、効率的なモデルの最適化と実験をサポートします。

- システムアーキテクトアーキテクトは、大規模な分散型推論システムの設計と、システムの安定稼働を保証するための負荷分散の最適化を担当します。

- AIアプリケーション開発者開発者は、アプリケーションのパフォーマンスを向上させ、ユーザー体験を最適化するために、自然言語処理およびマルチモーダル・アプリケーションを開発します。

- 学術研究者学者たちは、効率的な実験を促進し、学術研究を発展させるために、モデルの最適化とマルチモーダル技術を研究している。

© 著作権表示

この記事は著作権で保護されており、許可なく複製することは禁じられている。

関連記事

コメントはありません