ゲムマ3 キーメッセージ要約

主要指標

| パラメトリック | しょうさい |

|---|---|

| モデルサイズ | 1億から270億のパラメータ、4つのバージョン:1B、4B、12B、27B |

| ビルド | に基づいている。 変圧器 Gemma 2から受け継がれたデコーダー固有のアーキテクチャに、いくつかの改良が加えられている。 |

| マルチモーダル機能 | テキストと画像の入力をサポートし、カスタマイズされたSigLIPビジュアル・エンコーダを使用して、画像を256のソフトタグにエンコードします。 |

| コンテキストの長さ | 1Bモデルは32Kタグをサポートし、それ以外のモデルは128Kタグをサポートする。 |

| アテンション・メカニズム | 5:1ローカル/グローバル・アテンション・レイヤ・インターリーブ・パターン(ローカル・レイヤは1024トークンに及ぶ |

| トレーニング方法 | 知識の蒸留を用いた事前トレーニングと、改善された事後トレーニング方法を用いた微調整の指示 |

| 事前学習データ | 事前学習データ量:1Bモデル2Tトークン、4Bモデル4Tトークン、12Bモデル12Tトークン、27Bモデル14Tトークン |

| 多言語主義 | の使用比較 ジェミニ 2.0 同じSentencePiece分類器で、語彙に262kの項目があり、多言語をサポートする。 |

| 定量的サポート | チャンネルごとのint4、ブロックごとのint4、トグルfp8など、さまざまな標準フォーマットの定量化バージョンが利用できる。 |

| トレーニング・インフラ | TPUv4、TPUv5e、TPUv5pとZeRO-3オプティマイザの状態シャーディングおよびデータ複製戦略によるトレーニング |

| カーボンフットプリント | 事前にトレーニングされた二酸化炭素排出量は1497.13トンで、グーグルのデータセンターはカーボンニュートラルです! |

利点

- 優れたマルチモーダル理解

- ジェンマ3は、テキストと画像の入力を処理できるビジュアルエンコーダーを統合しており、マルチモーダルなタスクで優れた性能を発揮する。

- DocVQA、InfoVQA、TextVQAなどのビジュアルクイズベンチマークで、特に文書理解や画像内のテキストを読むタスクで高いパフォーマンスを発揮。

- PaliGemma 2と比較すると、Gemma 3はDocVQAやInfoVQAのような文書理解タスクで優れたパフォーマンスを発揮する。

- パン&スキャン(P&S)技術の採用により、ジェンマ3はネイティブに近い解像度で画像を処理することができ、視覚言語タスクにおける性能がさらに向上した。

- ジェンマ3は、テキストと画像の入力を処理できるビジュアルエンコーダーを統合しており、マルチモーダルなタスクで優れた性能を発揮する。

- 強力なロングコンテクスト処理

- 128Kトークン(1Bモデルでは32K)のコンテキスト長をサポートすることは、長いテキストを扱う場合に有利である。

- RULERやMRCRのような長いコンテキストのベンチマークで良好なパフォーマンスを示す。

- ローカル/グローバル・アテンション・レイヤのインターリーブ・パターンとローカル・レイヤの短いスパン設計は、ロング・コンテキスト処理能力を維持しながら、KVキャッシュのメモリ消費を効果的に抑制する。

- 128Kトークン(1Bモデルでは32K)のコンテキスト長をサポートすることは、長いテキストを扱う場合に有利である。

- 多言語主義の強化

- よりバランスの取れた非英語辞書の使用と、多言語データに対する学習量の増加。

- MGSM、Global-MMLU-Lite、WMT24++などの多言語ベンチマークで優れたパフォーマンスを発揮。

- XQuADやIndicGenBenchなどの言語横断クイズやインド語生成タスクで優れたパフォーマンスを発揮。

- よりバランスの取れた非英語辞書の使用と、多言語データに対する学習量の増加。

- 数学、推論、コーディングスキルの向上

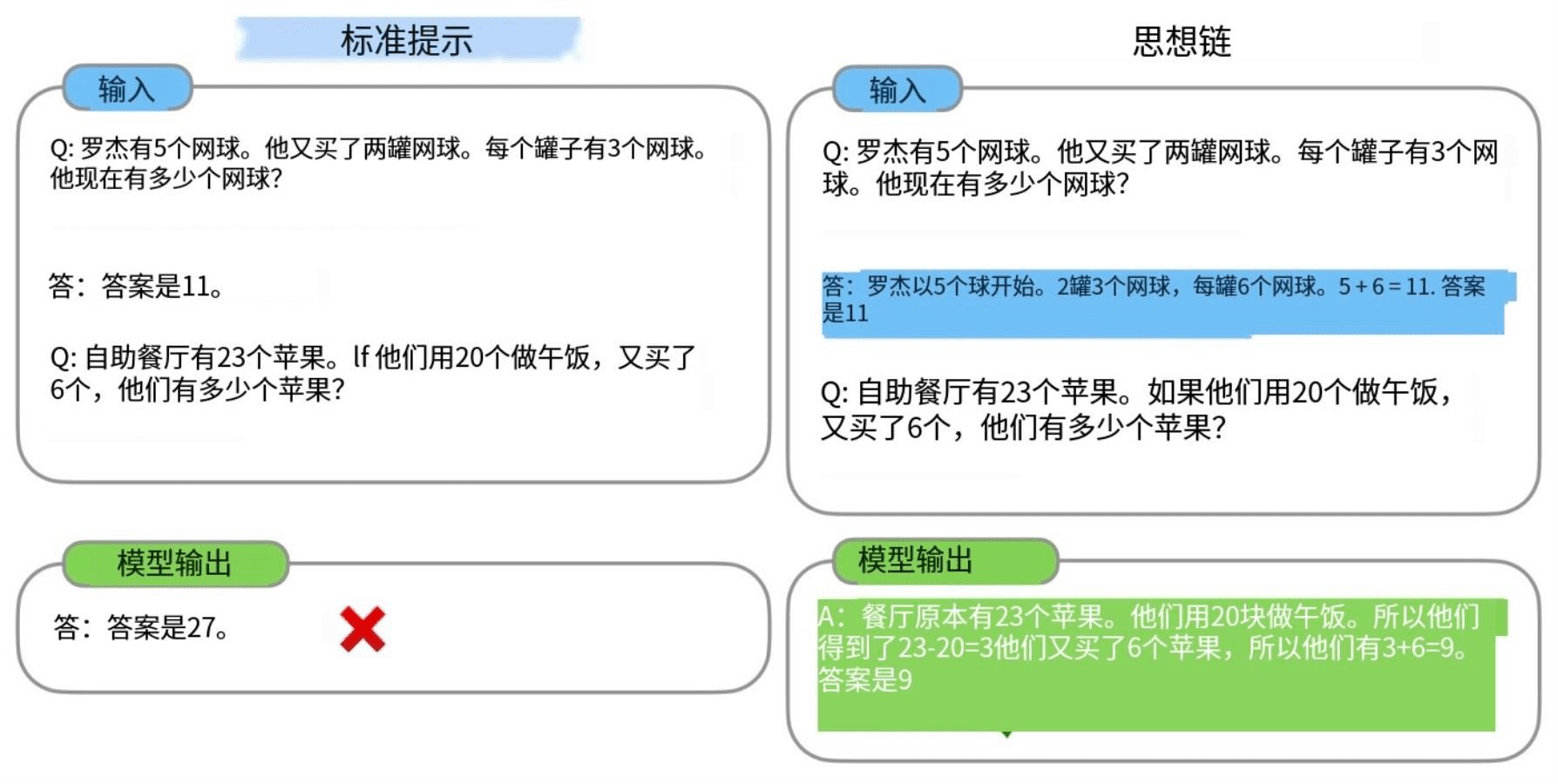

- 事後トレーニングの方法は、数学、推論、コーディングのスキルに最適化されている。

- MATH、GSM8K、HumanEval、その他の数学およびコードベンチマークで優れたパフォーマンスを発揮。

- MMLU、MMLU-Pro、AGIEvalなどのマルチタスク言語理解ベンチマークで優れたパフォーマンスを発揮。

- 事後トレーニングの方法は、数学、推論、コーディングのスキルに最適化されている。

- 高いモデリング効率

- 1Bと4Bのモデルはパラメータサイズが小さく、リソースに制約のあるデバイスへの展開に適している。

- 平均プーリング技術では、PaliGemma 2の9Bと27Bに比べて、Gemma 3の4Bと12Bのモデルは、同じ解像度のビジュアルエンコーダー入力に対して、移行コストが約10倍低い。

デメリット

- 化学、生物、放射線、核(CBRN)に関する限られた知識

- ジェマ3は、事前トレーニングのデータにCBRN関連の内容がなかったため、CBRN知識評価で低い結果となった。

- つまり、CBRN領域を含む応用シナリオでは、Gemma 3は正確で信頼できる情報を提供できない可能性がある。

- 高解像度画像を処理する際に起こりうるパフォーマンスのボトルネック

- P&S技術は、非正方形アスペクト比や高解像度画像に関連する問題を軽減することができるが、画像の頻繁な切り抜きや拡大縮小は推論速度に影響を与える可能性がある。

- Gemma 3は、超高解像度の画像処理やリアルタイムのビジョン・タスクを必要とするアプリケーションにおいて、性能上の問題に直面する可能性がある。

- 特定の分野に対する理解が不十分である可能性がある。

- ジェマ3は多くの分野に秀でているが、特定の高度に専門化された分野(法律、医療など)については理解力に限界があるかもしれない。

- このため、特定のアプリケーションシナリオに基づいて、さらなる微調整やドメイン適応を行う必要がある。

- メモリとプライバシーのリスクがある

- 大規模な言語モデルは、学習データに現れるテキストを生成する危険性があり、ジェンマ3も例外ではない。

- ゲムマ3のメモリ使用率は以前のモデルよりも低くなっているが、それでもユーザーのプライバシーを損なわないよう、機密情報の取り扱いには注意が必要だ。

- 複雑な因果関係を推論する能力の向上が必要

- ジェンマ3は、複雑な因果関係の推論を含む課題では、期待されたほどの成績を上げられないかもしれない。

- このため、因果推論タスクでの性能を向上させるためのさらなる研究とモデルの改良が必要である。

ジェマ3 評価

Gemma 3シリーズのモデルは4つのバージョンから構成されており、各バージョンは、プレトレーニングベースバージョン(pt suffix version、プレトレーニングを表す)とインストラクションファインチューニングバージョン(it suffix version、インストラクションファインチューニングを表す)をオープンソース化しており、合計8つのバージョンの大きなモデルがオープンソース化されていることになる。

Gemma 3-27B ITの最大パラメータサイズはfp16の精度で54.8GB、4090を2つ使用可能なINT8量子化後で27GB、INT4量子化では14GBのビデオメモリを必要とするが、4090を1つ使用する分には全く問題ない。

そして、このモデルのこのバージョンは非常によくレビューされ、ビッグモデル・アノニマス・アリーナ(チャットボット・アリーナ)で1,338ポイント(2025年3月8日現在)を獲得し、o1-2024-12-17モデルに次ぐ世界第9位、Qwen 2.5-MaxやDeepSeek V3などを抑えての世界第1位となった。

グーグルの公式声明によると、このジェンマ3シリーズは大幅なアップグレードで、ジェンマ3-4Bバージョンはジェンマ2-27Bに近いレベルでモデリングし、ジェンマ3-27Bはジェミニ1.5-Proに近いレベルだという!

ジェンマ3体験ロケーション

https://aistudio.google.com/prompts/new_chat?model=gemma-3-27b-it

https://ollama.com/library/gemma3

概要

Gemma 3は、マルチモーダル理解、長い文脈処理、多言語能力、数学、推論、コードに秀でた強力なマルチモーダル・マクロ言語モデルである。しかし、CBRNの知識、高解像度の画像処理、ドメイン固有の理解、記憶とプライバシーのリスク、複雑な因果推論においては、まだ改善の余地がある。

テクニカルレポート全文:https://storage.googleapis.com/deepmind-media/gemma/Gemma3Report.pdf

Gemma 3は、1億から270億までのパラメータサイズを持つ、軽量オープンソースモデルGemmaファミリーのマルチモーダル拡張版である。このバージョンでは、視覚的理解機能、より多くの言語のサポート、より長いコンテキスト長(少なくとも128Kトークンをサポート)が導入されました。また、コンテキスト長が長くなるにつれて劇的に増大するKVキャッシュメモリを削減するために、モデルアーキテクチャに改良を加えました。これは、局所的注意層と大域的注意層の比率を高め、局所的注意のスパンを短く保つことによって達成される。Gemma3モデルは知識蒸留によって学習され、学習済みバージョンと命令微調整バージョンの両方でGemma2を上回る。特に、我々の新しい事後学習アプローチは、数学、チャット、命令の順守、多言語能力を大幅に向上させ、Gemma3-4B-ITはGemma2-27B-ITに匹敵し、Gemma3-27B-ITはGemini-1.5-Proに匹敵します。すべてのモデルをコミュニティに公開しています。

1.はじめに

フロンティアモデルのGeminiファミリー(Gemini Team, 2023)と共同設計されたオープンソース言語モデルGemmaの最新バージョン(Gemma Team, 2024a)を発表する。この新バージョンは、Gemma 2 (Gemma Team, 2024b)と同等のサイズで、10億パラメータモデルが追加されている。これらのモデルは、携帯電話、ラップトップ、ハイエンドGPUなどの標準的なコンシューマーグレードのハードウェアで実行することを意図している。このリリースでは、マルチモーダリティ、ロングコンテクスト、多言語といったGemmaファミリーにいくつかの新機能が追加された。

マルチモダリティという点では、Gemma 3モデルのほとんどは、カスタムSigLIP視覚コーダー(Zhai et al, 2023)と互換性がある。言語モデルは画像をSigLIPによって符号化されたソフトトークンのシーケンスとして扱う。視覚的埋め込みを固定サイズの256個のベクトルに圧縮することで、画像処理の推論コストを削減する。エンコーダは固定解像度で動作するが、LLaVA(Liu et al.

2つ目の主要なアーキテクチャ改良点は、性能に影響を与えることなくコンテキストサイズを128Kトークンに拡張することである。長いコンテキストの1つの課題は、推論中にKVキャッシュでメモリが爆発することである。この問題を軽減するために、各グローバル・レイヤーの間に複数のローカル・レイヤーをインターリーブし、ローカル・レイヤーのスパンを1024トークンのみに設定する。したがって、長いコンテキストに関係するのはグローバル・レイヤーだけであり、5つのローカル・レイヤーに対して1つのグローバル・レイヤーを持つことになる。

事前学習の最適化アプローチはGemma 2と同様であるが、アーキテクチャ設計に若干の変更が加えられている。Gemini 2.0と同じ曖昧性解消器を使用し、モデルの多言語能力を向上させるためにデータ混合戦略も再検討し、画像理解も導入した。すべてのGemma 3モデルは、知識蒸留(Hinton et al.)

事後トレーニングでは、数学、推論、チャットスキルの向上に加え、ジェンマ3の新機能、長い文脈、画像入力を統合することに重点を置いています。数学、コーディング、チャット、コマンドフォロー、多言語のすべての能力を向上させるために、新しいポストトレーニングアプローチを使用します。その結果、Gemma 3インストラクション微調整モデルは、強力かつ汎用的であり、ベンチマークにおいて前モデルを劇的に上回る。

以下のセクションでは、事前学習と事後学習の方法だけでなく、アーキテクチャを含む我々のモデルの簡単な概要を提供します。また、様々な定量的・定性的ベンチマークテストに関する詳細な評価も行う。また、安全な責任ある配備のためのアプローチについて議論し、Gemma 3の広範な意味合い、その限界、および利点について概説する。

これはレシートに基づくコストとチップ計算の内訳である:

1.スライス肉の値段を確認する:レシートには "1x Zurcher Geschnetzeltes + Rosti "で36.50スイスフランと記載されている。 これはスライスした肉にフライドポテト(Rosti)を添えたもの。 2.これは肉のスライスにフライドポテト(ロスティ)を添えたものです。18%のチップを計算する:チップの金額 = 36.5 スイスフラン * 0.18 = 6.57 スイスフラン 3.総額を計算する:合計=36.50スイスフラン+6.57スイスフラン=43.07スイスフラン

2.モデル・アーキテクチャ

Gemma 3モデルは、前世代のモデル(Vaswani et al, 2017)と同じ一般的なデコーダ固有のTransformerアーキテクチャに従っており、ほとんどのアーキテクチャ要素は最初の2つのGemmaバージョンと同様である。我々は、Grouped Query Attention (GQA) (Ainslie et al., 2023)と、Post-NormalisationとPre-Normalisation with RMSNorm (Zhang and Sennrich, 2019)を使用する。Dehghaniら(2023)、Wortsmanら(2023)、Chameleonのチーム(2024)に触発されて、我々はGemma 2のソフトキャップをQK正規化に置き換える。このセクションでは、前世代のモデルとの主な違いをいくつか強調する。

5:1 ローカル/グローバル・レイヤ・インターリーブ。 局所的なスライディング・ウィンドウ自己注意(Beltagy et al., 2020)と大域的な自己注意(Luong et al., 2015)を交互に行い、5つの局所層ごとに1つの大域層という交互パターンで、局所層をモデルの第1層として開始した。

| モデリング | ビジュアルエンコーダー | 埋め込みパラメータ | 非エンベデッドパラメーター |

|---|---|---|---|

| 1B | 0 | 302M | 698M |

| 4B | 417M | 675M | 3,209M |

| 12B | 417M | 1,012M | 10,759M |

| 27B | 417M | 1,416M | 25,600M |

長い文脈だ。 ゲムマ3のモデルは、コンテキスト長が32Kの1Bモデルを除いて、128Kのコンテキ スト長をサポートしている。グローバル自己注 意層のRoPEベース周波数を10Kから1Mに増やし、ローカル層の周波数は10Kのま まにした。

2.1 視覚モダリティ

ビジュアル・エンコーダ。 Gemma視覚エンコーダは、896x896にリサイズされた正方形の画像を入力とした。Gemma視覚エンコーダは、896x896にリサイズされた正方形の画像を入力とし、Visual Assistantタスクデータで微調整された。単純化のため、視覚コーダーは4B、12B、27Bのモデル間で共有し、訓練中はフリーズさせた。

パン&スキャン(P&S)。 Gemmaビジュアルエンコーダーは896x896の固定解像度で動作します。正方形以外のアスペクト比や高解像度の画像を扱う場合、画像の歪みが生じ、その結果、テキストが読めなくなったり、小さなオブジェクトが消えてしまったりすることがある。我々は推論時に適応的ウィンドウアルゴリズムを使うことでこの問題に対処する。このアルゴリズムは画像を、画像全体をカバーする等しいサイズの重ならない切り抜きブロックに分割し、896x896ピクセルにリサイズしてエンコーダに渡す。このウィンドウ処理は必要な場合にのみ適用され、最大クロップ数を制御する。これは推論のみの最適化で、推論を高速化するために無効にすることができます。

| 破片 | ||||

|---|---|---|---|---|

| モデリング | 類型論 | チップ数 | データシリーズ | コピー |

| 1B | TPUv5e | 512 | 16 16 | 2 |

| 4B | TPUv5e | 2048 | 16 16 | 8 |

| 12B | TPUv4 | 6144 | 16 16 | 24 |

| 27B | TPUv5p | 6144 | 24 8 | 32 |

2.2 事前トレーニング

ゲムマ2と同様の事前トレーニングのレシピに従い、知識蒸留を行った。

トレーニングデータ。 すなわち、Gemma 3 27Bの訓練には14Tタグ、12Bバージョンの訓練には12Tタグ、4Bの訓練には4Tタグ、1Bの訓練には2Tタグを使用した。タグの増加は、事前訓練で使用した画像とテキストの混在を考慮したものである。また、言語カバレッジを向上させるために、多言語データの量を増やしました。単言語データと並列データを追加し、Chungら(2023)にインスパイアされた戦略を用いて、言語表現の不均衡に対処した。

スプリッター。 我々は、Gemini 2.0と同じ語彙を使用する。SentencePiece語彙は、桁分割、空白保持、バイトレベルエンコーディングが施されている(Kudo and Richardson, 2018)。その結果、語彙は262kエントリになった。この辞書は英語以外の言語に対してよりバランスが取れている。

フィルタリング。 フィルタリング技術を使用して、不要または安全でない談話を生成するリスクを低減し、特定の個人情報やその他の機密データを削除します。事前学習データ混合における評価セットを汚染除去し、センシティブな出力の拡散を最小限に抑えることで、復唱のリスクを低減する。また、Sachdevaら(2024)に触発された品質再重み付けステップを適用し、低品質データの発生を低減する。

知識の蒸留。 トークンごとに256個のロジットをサンプリングし、教師確率に従って重み付けをする。生徒はクロスエントロピー損失を通して、これらのサンプル間の教師の分布を学習する。教師のターゲット分布は、サンプリングされていないロジットの確率をゼロに設定し、再正規化します。

| オリジナル (GB) | クオンツ (GB) | |||

|---|---|---|---|---|

| モデル1B | bf16 2.0 | 0.5 | 0.7 1.0 | |

| +KV | 2.9 | 1.4 | 1.6 1.9 | |

| 4B | 8.0 | 2.6 | 2.9 4.4 | |

| +KV | 12.7 | 7.3 | 7.6 9.1 | |

| 12B | 24.0 | 6.6 | 7.1 12.4 | |

| +KV | 38.9 | 21.5 | 22.0 27.3 | |

| 27B | 54.0 | 14.1 | 15.3 27.4 | |

| +KV | 72.7 | 32.8 | 34.0 46.1 |

2.3 定量的知覚トレーニング

オリジナルのチェックポイントに加えて、モデルの定量化バージョンを異なる標準フォーマットで提供する。これらのバージョンは、定量的認識トレーニング(QAT)(Jacob et al.定量化されていないチェックポイントの確率をターゲットとして使用し、トレーニング前とトレーニング後の分布が一致するようにデータを調整する。最も一般的なオープンソースの定量推論エンジン(例:llama.cpp)に基づき、我々は3つの重み表現に注目する:チャンネル毎のint4、ブロック毎のint4、トグルfp8。 表3では、異なる重み表現、32kトークンシーケンス長に対するKVキャッシュの有無について、オリジナルモデルと定量化モデルのメモリフットプリントを報告する。

2.4 コンピューティング・インフラ

表2に示すように、TPUv4、TPUv5e、TPUv5pを使ってモデルを訓練する。各モデル構成は、学習ステップ時間を最小化するように最適化されている。視覚コーダーについては、各画像の埋め込みを事前に計算し、言語モデルの学習コストを増加させることなく、埋め込みを用いて直接学習する。

オプティマイザーの状態は、ZeRO-3(Ren et al.マルチポッドトレーニングでは、データセンターネットワーク上でデータの複製を行う。

| (ぶんみゃく | フォーマッティング |

|---|---|

| ユーザーラウンド | ユーザー |

| モデルターン | モデル |

| ラウンド終了 | |

| ディスカッションの例 | |

| ユーザー:あなたは誰ですか? モデル:私の名前はジェマよ! ユーザー:2+2って何? モデル: 2+2=4 です。 | |

| モデル入力: | |

| [BOS]user Whoareyou? model 私の名前はジェマです! user | |

| 2+2とは? | |

| 2+2=4. | モデル出力: |

2.5 カーボンフットプリント

これは、TPUデータセンターから報告された1時間ごとのエネルギー消費量に基づいて見積もられ、データセンターの作成と維持に消費される追加エネルギーを考慮して拡張されています。グーグルのデータセンターは、エネルギー効率、再生可能エネルギーの購入、カーボンオフセットを組み合わせることでカーボンニュートラルを実現しています。このカーボンニュートラルは、Googleのトレーニングとそれを実行するマシンにも適用されます。

3.コマンドの微調整

事前訓練されたモデルは、改良された事後訓練法によってコマンド微調整モデルに変換された(表6参照)。

技術

我々のポストトレーニングアプローチは、大規模IT学部からのKnowledge Distillation(Agarwalら、2024年;Anilら、2018年;Hintonら、2015年)の改良版と、RL微調整段階におけるBOND(Sessaら、2024年)、WARM(Ramら、2024b)、WARP(Ramら、2024a)の改良版に基づくRL微調整段階に依存している。2024a)に基づくRL微調整段階である。

強化された学習目標

我々は、モデルの害を最小限に抑えながら、有用性、数学、コーディング、推論、命令追従、多言語性を向上させるために、様々な報酬関数を使用する。これには、人間のフィードバックデータを使用して訓練された加重集約報酬モデルからの学習(Ramら、2024b)、コード実行フィードバック(Gehringら、2024)、および数学的問題を解くための実際の報酬(DeepSeek-AI、2025; Lambertら、2024)が含まれる。

データのフィルタリング

モデルのパフォーマンスを最大化するために、ポストトレーニングで使用するデータを慎重に最適化します。私たちは、特定の個人情報を表示するモデル出力、安全でない、または有害なモデル出力、不正確に自己識別されたデータ、および重複する例をフィルタリングします。また、より良いコンテキストの帰属を促すデータのサブセットを含めることで、錯覚を最小化するためのモデレーションとリジェクトを行い、他のメトリクスのモデル性能を低下させることなく、ファクトメトリクスの性能を向上させます。

[BOS] マーキング

テキストが[BOS]タグで始まるPTおよびITモデルの場合、"[BOS]"というテキストは[BOS]タグにマッピングされないため、明示的に追加する必要があります。たとえば、Flax には add_bos = True というオプションがあり、単語分割の際にこのトークンを自動的に追加します。表4に、ITモデルのフォーマット例を示す。

PTおよびITフォーマット

すべてのモデルは同じ曖昧性解消器を共有し、いくつかの制御トークンはITフォーマット専用である。主な違いは、PTモデルは生成の最後にトークンを出力するのに対し、ITモデルは表4のITに示されているように、生成の最後にトークンを出力することである。したがって、どちらのモデル・タイプを微調整する場合も、それぞれのターン終了タグを追加する必要がある。

| ランキング | モデリング | エロ | 95% CI | 自由化 | 類型論 | #パラメータ/#活性化 |

|---|---|---|---|---|---|---|

| 1 | Grok-3-Preview-02-24 | 1412 | +8/-10 | |||

| 1 | GPT-4.5-プレビュー | 1411 | +11/-11 | |||

| 3 | Gemini-2.0-Flash-Thinking-Exp-01-21 | 1384 | +6/-5 | |||

| 3 | Gemini-2.0-Pro-Exp-02-05 | 1380 | + 5/-6 | |||

| 3 | ChatGPT-4o-最新版 (2025-01-29) | 1377 | + 5/-4 | |||

| 6 | ディープシーク-R1 | 1363 | +8/-6 | であります | MoE | 671B/37B |

| 6 | ジェミニ-2.0-フラッシュ-001 | 1357 | +6/-5 | |||

| 8 | 01-2024-12-17 | 1352 | + 4/-6 | |||

| 9 | ジェンマ-3-27B-IT | 1338 | +8/-9 | であります | 圧縮 | 27B |

| 9 | クウェン2.5-マックス | 1336 | + 7/-5 | |||

| 9 | 01-プレビュー | 1335 | +4/-3 | |||

| 9 | 03-ミニハイ | 1329 | +8/-6 | |||

| 13 | ディープシーク-V3 | 1318 | +8/-6 | であります | MoE | 671B/37B |

| 14 | GLM-4-Plus-0111 | 1311 | +8/-8 | |||

| 14 | クウェンプラス-0125 | 1310 | +7/-5 | |||

| 14 | クロード 3.7 ソネット | 1309 | + 9/-11 | |||

| 14 | ジェミニ-2.0-フラッシュライト | 1308 | +5/-5 | |||

| 18 | ステップ2-16K-Exp | 1305 | + 7/-6 | |||

| 18 | 03-ミニ | 1304 | + 5/-4 | |||

| 18 | 0Lミニ | 1304 | +4/-3 | |||

| 18 | ジェミニ-1.5-Pro-002 | 1302 | +3/-3 | |||

| 28 | Meta-Llama-3.1-405B-Instruct-bf16 | 1269 | +4/-3 | であります | 圧縮 | 405B |

| 38 | Llama-3.3-70B-Instruct | 1257 | +5/-3 | であります | 圧縮 | 70B |

| 39 | Qwen2.5-72B-インストラクター | 1257 | +3/-3 | であります | 圧縮 | 72B |

| 59 | ジェンマ-2-27B-イット | 1220 | +3/-2 | であります | 圧縮 | 27B |

表5|チャットボット・アリーナにおけるGemma 3 27B ITモデルの評価(Chiang et al.)すべてのモデルは、人間の評価者によってブラインドで並べて評価された。Gemma-3-27B-ITの数値は、2025年3月8日に受領した予備的な結果である。Gemma-3-27B-ITモデルは、人間の評価者によってチャットボット・アリーナ(Chiang et al.

4.最終モデルの評価

このセクションでは、MMLUのような静的ベンチマークだけでなく、一連の自動ベンチマークと人間による評価を通じてITモデルを評価する。

4.1 LMSYSチャットボットアリーナ

このセクションでは、我々のIT 27Bモデルが、どの程度のパフォーマンスを示したかを報告する。 LMSys チャットボット・アリーナ(Chiang et al.)Gemma 3 27B IT (1338)はトップ 10 の中で最も優れたモデルであり、DeepSeek-V3 (1318)、LLaMA 3 405B (1257)、Qwen2.5-70B (1257)などの他の非思考オープンモデルよりも高いスコアを出しています。最後に、ゲムマ3はゲムマ2よりもEloがかなり高く、1220である。Eloスコアは視覚的能力を考慮していないことに注意。

4.2 標準化されたベンチマーキング

表6に、我々の最終モデルの性能を、我々の以前のモデル反復およびGemini 1.5と比較した、異なるベンチマークにおける性能を示す。しばしば独自の評価セットアップを報告する外部モデルとの直接比較は行っていない。読者の皆様には、異なるモデルの公平な比較のために、サードパーティの静的リーダーボードをフォローすることをお勧めします。付録として、他のベンチマークにおける我々のモデルの追加評価を掲載する。

| ジェミニ 1.5 | ジェミニ2.0 | ジェマ2 | ジェマ3 | ||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| フラッシュ | プロ | フラッシュ | プロ | 2B | 9B | 27B | 1B | 4B | 12B | 27B | |||

| MMLUプロ | 67.3 | 75.8 | 77.6 | 79.1 | 15.6 | 46.8 | 56.9 | 14.7 | 43.6 | 60.6 | 67.5 | ||

| LiveCodeBench | 30.7 | 34.2 | 34.5 | 36.0 | 1.2 | 10.8 | 20.4 | 1.9 | 12.6 | 24.6 | 29.7 | ||

| バードSQL(開発) | 45.6 | 54.4 | 58.7 | 59.3 | 12.2 | 33.8 | 46.7 | 6.4 | 36.3 | 47.9 | 54.4 | ||

| GPQAダイヤモンド | 51.0 | 59.1 | 60.1 | 64.7 | 24.7 | 28.8 | 34.3 | 19.2 | 30.8 | 40.9 | 42.4 | ||

| シンプルQA | 8.6 | 24.9 | 29.9 | 44.3 | 2.8 | 5.3 | 9.2 | 2.2 | 4.0 | 6.3 | 10.0 | ||

| FACTSアース | 82.9 | 80.0 | 84.6 | 82.8 | 43.8 | 62.0 | 62.4 | 36.4 | 70.1 | 75.8 | 74.9 | ||

| 数学 | 77.9 | 86.5 | 90.9 | 91.8 | 27.2 | 49.4 | 55.6 | 48.0 | 75.6 | 83.8 | 89.0 | ||

| ヒドゥン数学 | 47.2 | 52.0 | 63.5 | 65.2 | 1.8 | 10.4 | 14.8 | 15.8 | 43.0 | 54.5 | 60.3 | ||

| MMMU(バルブ) | 62.3 | 65.9 | 71.7 | 72.7 | 48.8 | 59.6 | 64.9 |

表6|ゼロサンプルベンチマークにおけるGemini 1.5、Gemini 2.0、Gemma 2の命令トリミング(IT)モデルとの性能比較。

5.アブレーション研究

このセクションでは、アーキテクチャーの変更と、いくつかの新モデルの新しいビジュアル機能の影響に焦点を当てる。

5.1 事前トレーニング能力の検出

我々のモデルが一般的な能力を捉えていることを確認するため、事前学習時にいくつかの標準的なベンチマークをプローブとして使用する。図2では、これらの一般的な能力、すなわち科学、コード、事実性、多言語性、推論、視覚に関するGemma 2と3の事前学習済みモデルの品質を比較している。これらのグラフで使用されたさまざまな公開ベンチマークのパフォーマンス詳細は、付録にまとめられている。全体として、ビジョンが追加されたにもかかわらず、新バージョンはほとんどのカテゴリーで向上していることがわかる。我々は特に、モデルの品質に直接影響する、このバージョンの多言語性について懸念している。しかし、汚染除去技術を使用しているにもかかわらず、これらのプローブには常に汚染のリスクがあり(Mirzadeh et al.

5.2 ローカル:グローバル・アテンション層

局所的自己注意層と全体的自己注意層の変化が、推論中のパフォーマンスとメモリ消費に与える影響を測定した。

ローカル:グローバルレート。 図3では、ローカル・アテンション層とグローバル・アテンション層の比率を変えて比較している。ジェンマ2モデルは1:1、ジェンマ3モデルは5:1を使用している。

スライディングウィンドウのサイズ。 図4では、局所的注意層のグローバル:ローカル比率の異なる構成について、異なるスライディングウィンドウサイズの当惑度を比較している。スライディングウィンドウは、当惑度に影響を与えることなく、大幅に小さくすることができる。

KVキャッシュメモリへの影響。 図5では、32kタグを使用した場合のモデルとKVキャッシュメモリのバランスを示している。ローカル対グローバルの比率とスライディング・ウィンドウ・サイズ(sw)が異なる2Bモデルを検討する。Gemma 1とLlamaで使用されている標準的な構成である、グローバルに一意な構成と比較する。グローバルに一意な "構成では、60%のメモリオーバーヘッ ドが発生するが、1:3のスライディングウィンドウと1024(sw=1024図6では、2Bアーキテクチャ(**L:G=5:1, sw=1024**)と「グローバルユニーク」2Bモデルを用いて、KVキャッシュのメモリ使用量をコンテキスト長の関数として計算している。

5.3 ロングコンテキストの有効化

128kシーケンスをゼロからトレーニングするのではなく、32kシーケンスを使用するようにモデルを事前トレーニングし、事前トレーニングの最後にRoPEを再スケーリングしながら4B、12B、27Bモデルを128kトークンにスケーリングした(Chen et al.)スケーリング係数8は実際にうまく機能することがわかった。図7では、文脈の長さが異なる場合の当惑度の効果を示す。我々のモデルは128kまで一般化するが、規模を拡大し続けると、当惑度は急速に減少する。

5.4 大小の教師

共通の発見は、小さなモデルを訓練するには、小さな教師から抽出するのが最善であるということである。

これは、これらの研究が一般的に、より良い教師を使うことの利点を上回るような設定で、より劣った教師を使っているためだと思われる。大小2つの異なる大きさの教師を使って、異なるトレーニング時間で生徒をトレーニングします。図8を見ると、トレーニング時間が短い場合は、小さい教師の方が優れているが、トレーニング時間が長くなるとその傾向は逆転する。

5.5 ビジュアル・エンコーダ

画像解像度の効果。 SigLIP(Zhaiら、2023)に基づく視覚コーダーを使用する。視覚コーダーは凍結され、言語モデルのみが学習される。このマルチモーダルデータの各画像は、対応する視覚コーダーの256個の画像トークンで表現される。そのため、高解像度エンコーダは平均プーリングを使用して、出力を256トークンに削減する。例えば、896 解像度エンコーダの出力には 4x4 の平均プーリングがあります。表7に示すように、解像度の高いエンコーダは解像度の低いエンコーダよりも優れています。

パン&スキャン(P&S)。 P&Sは、本来のアスペクト比と画像解像度に近い状態で画像を取り込むことを可能にする。表8では、27BのITモデルをP&Sの有無で比較している。予想通り、ネイティブに近い解像度で画像を処理できる能力は、画像上のテキストを何らかの形で読み取る必要があるタスクに大いに役立つ。

6.メモリーとプライバシー

大規模な言語モデルは、訓練に使用されたテキストの一部のほぼ複製を生成する可能性がある(Bidermanら 2023; Carliniら 2021, 2022; Ippolitoら 2022; Nasrら 2023)。記憶率を測定することで、このリスクを定量化した監査報告が過去に多数発表されている(Anilら 2023; Chowdheryら 2022; Geminiチーム 2023, 2024; Gemmaチーム 2024a,b; LLaMaチーム 2024)。この「記憶率」1は、以下の設定を用いて、すべてのモデル生成に対する訓練データと一致するモデル生成の比率として定義される。Gemmaチーム(2024b)に記述されている方法に従って測定する。具体的には、訓練データの一様に分布した大きな部分からサブサンプルを作成し、長さ50の接頭辞と長さ50の接尾辞を使用して、このコンテンツの発見可能な抽出についてテストする(Nasr et al.)テキストは、継続中のすべてのトークンがソース接尾辞と一致する場合は「完全記憶」として、10%の編集距離内で一致する場合は「近記憶」として表現された。

図9は、GemmaモデルとGeminiモデルの記憶率を比較したものである。モデルは、最新のGemma 3モデルを左に、時系列を逆に並べてある。ジェンマ3モデルは、以前のモデルよりもはるかに低い割合で長文を記憶していることがわかる(Y軸の対数に注目)。4B、12B、27Bの各モデル間の記憶率にはわずかな差しかなく、1Bは他の大きなモデルよりも記憶率が低い。さらに、テキストのより大きな割合が近似記憶として特徴付けられ、完全記憶と比較して近似記憶の相対的な増加は約24倍であることがわかった。

SDPは、個人情報を含む可能性のあるテキストを特定するために、広範な検出ルールを使用する。SDPは高い想起率を意図しており、情報が表示されるコンテキストを考慮しないため、多くの誤検出が発生する。SDPには、低、中、高という幅広い重大度レベルもある。SDPはまた、低、中、高という幅広い重大度レベルを提供する。SDPがテキストをいずれかの重大度レベルに分類した場合、そのテキストを個人情報として分類する。すべてのGemma 3モデルの出力には個人情報が含まれていない。これは、記憶として分類された出力中の個人情報の割合が、我々の検出しきい値以下であることを示している。

7.責任、安全、セキュリティ

ジェンマモデル開発において、責任、安全、セキュリティは非常に重要である。Gemma 3ユーザーへの影響を最小限に抑えるため、私たちは、最近のGoogle AIモデル(Gemini Team, 2024)に合わせて、開発ワークフローを通じて実行される強化された内部セキュリティプロセスを統合し続けています。これは、トレーニング中のセキュリティ緩和と、新しい画像からテキストへの機能の強固で透明性のあるモデル評価に重点を置いています。

7.1 ガバナンスと評価

ジェンマの便益とリスクを評価する我々のアプローチは、ジェンマ1(ジェンマ・チーム、2024a)で概説したものを反映し、支援モデルの変化を考慮している。私たちは、AIのオープン化によって、こうした技術の恩恵を社会全体に広げることができると引き続き考えているが、個人レベルでも制度レベルでも、危害をもたらす可能性のあるリスクの観点から評価する必要がある(Weidinger et al.、2021)。Gemmaの最初のリリース以来、私たちはこれらのモデルがいくつかの社会的に有益なアプリケーションを駆動するのを見てきました。例えば、私たち自身のShieldGemma 2は、Gemma 3を使用して構築された4B画像安全性分類器であり、危険なコンテンツ、性的搾取、および暴力カテゴリに対する安全性ラベルを出力する画像安全性のための既製のソリューションを提供します。

Gemma 3モデルのリリースには、モデル機能の変更に特別な注意を払い、既存のマルチモーダルLLM(Lin et al.Gemmaが悪意を持って使用されているという報告はまだ受けていませんが、私たちはそのような報告があれば調査し、学界や開発者コミュニティと協力するとともに、そのようなケースにフラグを立てるために独自の監視を行うことに引き続き全力を尽くします。

機能が改善されたとはいえ、より堅牢なオープン・モデルが利用可能であることから、今回のリリースが全体的なリスク状況に与える影響はごくわずかであると考えている。

7.2 トレーニング中のセキュリティ方針と緩和策

Gemmaのセキュリティアプローチの重要な柱の1つは、Geminiモデル(Gemini Team, 2023)に沿ったGoogleセキュリティポリシーに合わせることです。これらは、我々のモデルが有害なコンテンツを生成しないようにするためのものである:

- 児童の性的虐待と搾取

- 危害につながる可能性のある個人を特定できる情報の開示(社会保障番号など)

- ヘイトスピーチとハラスメント

- 危険または悪質なコンテンツ(自傷行為の助長や有害行為の指導を含む)

- ポルノ

- 科学的または医学的コンセンサスに反する医療アドバイス

事前学習と微調整のチェックポイントで有害なコンテンツが生成される可能性を低減するため、事前学習データの広範なセキュリティ・フィルタリングを行います。また、モデルの微調整には、SFTとRLHFを使用し、望ましくない動作からモデルを遠ざけています。

7.3 セーフガード評価

私たちはまた、私たちのモデルが引き起こしうる潜在的な危害を理解するために、私たちのITモデルを一連のベースライン保証アセスメントにかけた。オープン・モデルを推進する私たちは、ウェイト・リリースの不可逆性から、厳格なリスク評価が必要であることも認識しています。私たちの内部セキュリティ・プロセスはそれに応じて設計されており、過去のGemmaモデルについても、極端なリスクに関連する能力の評価を実施しました(Phuong et al., 2024; Shevlane et al., 2023)。オープンモデルの開発と共有を継続する中で、より頑健なモデルが、通常、能力の低いモデルに対して十分なカバレッジを提供することを徹底的に評価することで、このヒューリスティックに従っていく。そのため、Gemma 3では簡略化された評価セットを優先し、特定のモデルが潜在的に高いリスクを持つ可能性がある状況(CBRN評価については後述)のために、詳細なハザード能力評価を保留した。私たちは、フロンティア・セーフティ・フレームワークで概説されている私たちのコミットメントを遵守しつつ、集中的かつ効率的な評価を行うために、開発のスピードとターゲットを絞った安全性試験のバランスを取りました。

ベースライン評価

ベースライン保証では、多数の敵対的なユーザークエリを合成し、人間の評価者がポリシー違反の有無についてフラグを立てることで、モデルがセキュリティポリシーに違反する割合を把握する。全体として、Gemma 3はこれらのセキュリティ・ポリシーに対する違反率が非常に低い。

化学、生物、放射線、核(CBRN)の知識

STEM関連課題の成績が向上したため、生物学的、放射線学的、核リスクに関する知識を、内部データセットの知識ベースの多肢選択問題(closed-ended knowledge-based multiple choice questions)を用いて評価した。化学的知識の評価については、Macknightらによって開発された閉鎖回答型の知識ベースのアプローチを用いて化学物質の危険性を評価した。我々の評価では、ジェンマ3モデルはこれらの領域において知識が低いことが示された。

7.4 責任あるオープン・モデリング・アプローチ

安全でセキュアで責任あるアプリケーションを設計するには、それぞれの特定のユースケースや環境に関連するリスクを軽減するよう努力するシステムレベルのアプローチが必要です。私たちは、私たちのモデルの潜在的なリスクに比例した評価とセキュリティの緩和を採用し続け、その利益が予見可能なリスクを明らかに上回ると確信した場合にのみ、コミュニティと共有します。

8.考察と結論

本研究では、テキスト、画像、コードのためのオープンソース言語モデルGemmaファミリーの最新メンバーであるGemma 3を紹介する。このリリースでは、多言語機能とSTEM関連の能力を向上させながら、画像理解と長いコンテキストの追加に焦点を当てている。私たちのモデルのサイズとアーキテクチャは、標準的なハードウェアとの互換性を意図しており、アーキテクチャの改良のほとんどは、パフォーマンスを維持しながらこのハードウェアに対応するように設計されています。

© 著作権表示

この記事は著作権で保護されており、許可なく複製することは禁じられている。

関連記事

コメントはありません