はじめに

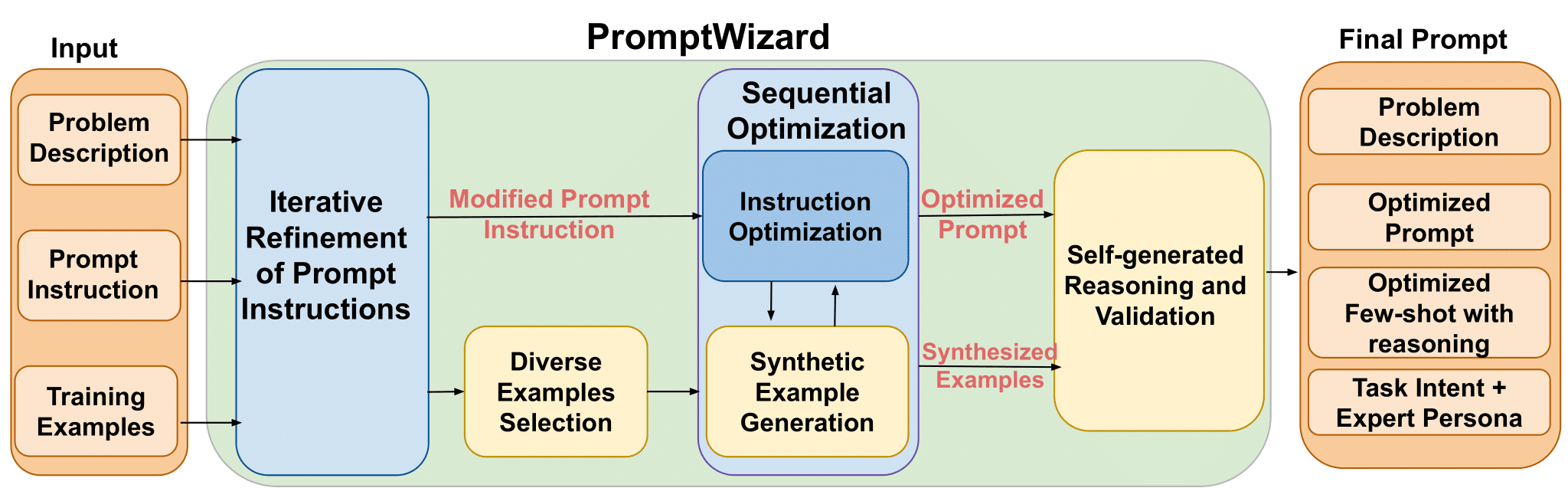

StreamingT2Vは、Picsart AI研究チームによって開発された公開プロジェクトであり、テキスト記述に基づく、首尾一貫した、ダイナミックでスケーラブルな長尺動画の生成に焦点を当てている。この技術は、説明テキストに密接に対応し、高フレーム品質の画像を維持する時間的に一貫性のあるビデオを保証する高度な自己回帰的アプローチを使用しています。最大1200fps、長さ2分までの動画を生成することが可能で、より長時間に拡張できる可能性がある。この手法の有効性は、特定のText2Videoモデルによって制限されることはありません。つまり、モデルを改善することで、ビデオの品質がさらに向上します。

機能一覧

最大1200fps、長さ2分までのビデオ生成に対応。

ビデオと高フレーム品質の画像の時間的一貫性を維持

テキスト説明に密接に対応したダイナミックなビデオ生成

複数のベースモデルアプリケーションをサポートし、生成されるビデオの品質を向上させる。

テキストからビデオ、画像からビデオへの変換をサポートする

グラディオ・オンライン・デモの提供

ヘルプの使用

プロジェクトのリポジトリをクローンし、必要な環境をインストールする。

ウエイトをダウンロードし、正しいカタログに配置する。

テキストからビデオ、または画像からビデオへの変換のサンプルコードを実行する

詳細な結果やデモについては、プロジェクトのページをご覧ください。

推論時間

ベースモデルとしてのModelscopeT2V

| フレームレート | プレビュー推論時間の短縮(256×256) | 最終結果の推理時間(720×720) |

|---|---|---|

| 24フレーム | 40秒。 | 165秒 |

| 56フレーム | 75秒 | 360秒 |

| 80フレーム | 110秒。 | 525秒 |

| 240フレーム | 340秒 | 1610秒(約27分) |

| 600フレーム | 860秒。 | 5128秒(約85分) |

| 1200フレーム。 | 1710秒(約28分) | 10225秒(約170分) |

アニメイトディフベースモデルとして

| フレームレート | プレビュー推論時間の短縮(256×256) | 最終結果の推理時間(720×720) |

|---|---|---|

| 24フレーム | 50秒 | 180秒。 |

| 56フレーム | 85秒。 | 370秒 |

| 80フレーム | 120秒。 | 535秒 |

| 240フレーム | 350秒。 | 1620秒(約27分) |

| 600フレーム | 870秒。 | 5138秒(~85分) |

| 1200フレーム。 | 1720秒(約28分) | 10235秒(約170分) |

副ボリューム記述子基本モデルとして

| フレームレート | プレビュー推論時間の短縮(256×256) | 最終結果の推理時間(720×720) |

|---|---|---|

| 24フレーム | 80秒 | 210秒。 |

| 56フレーム | 115秒 | 400秒。 |

| 80フレーム | 150秒。 | 565秒 |

| 240フレーム | 380秒。 | 1650秒(約27分) |

| 600フレーム | 900秒。 | 5168秒(~86分) |

| 1200フレーム。 | 1750秒(約29分) | 10265秒(~171分) |

すべての測定は、NVIDIA A100(80 GB)GPUを使用して行われた。フレーム数が80を超える場合は、ランダム混合を使用した。ランダム混合ではchunk_sizeそしてoverlap_sizeはそれぞれ112と32に設定されている。

© 著作権表示

この記事は著作権で保護されており、許可なく複製することは禁じられている。

関連記事

コメントはありません