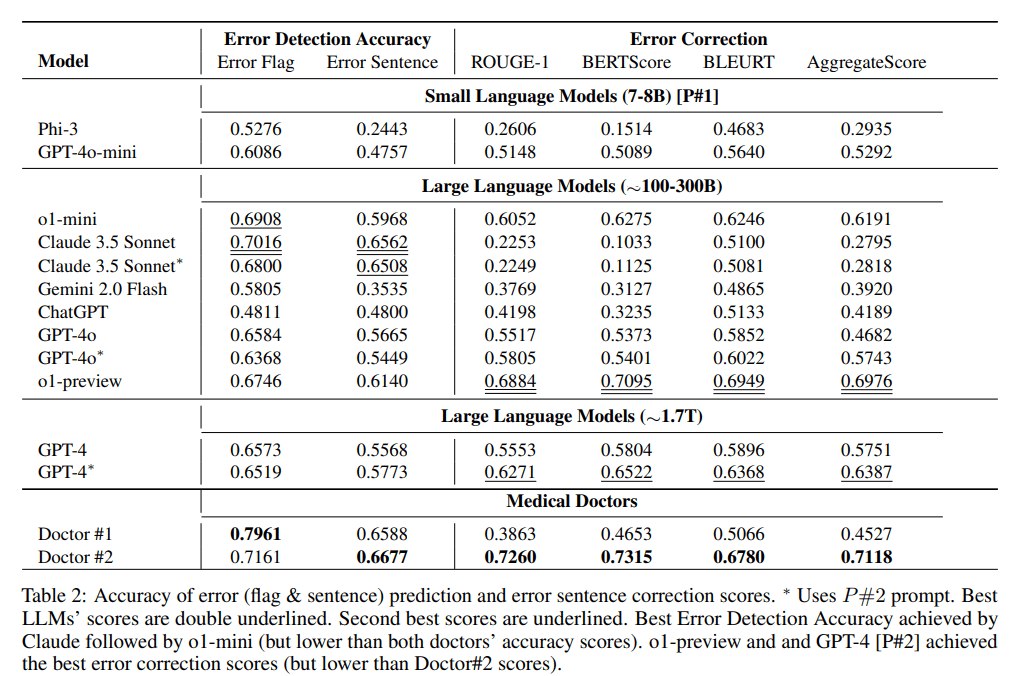

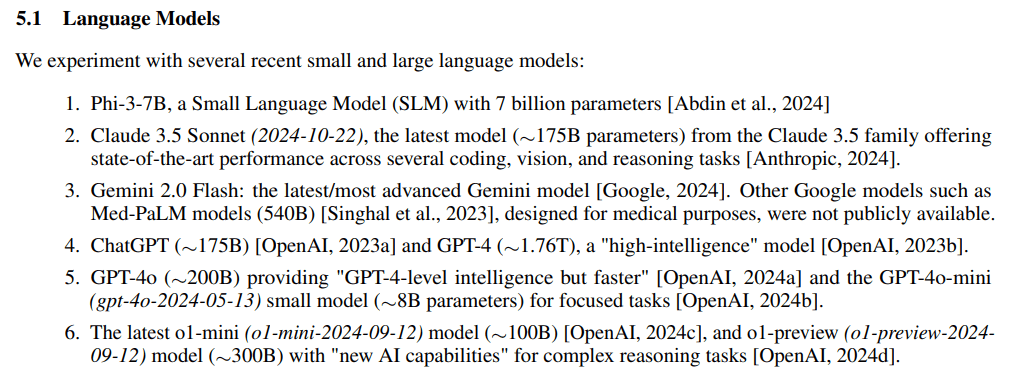

主流のクローズドソースLLMのパラメータサイズに関する議論が続いているが、2024年の最後の2日間に、マイクロソフトから、LLMのパラメータサイズに関する記事が発表された。臨床記録における医療ミスの発見と修正推測実験参照基準MEDECの研究は、偶然に、そして直接的にそのパラメーターの規模を見落とした:o1-preview、GPT-4。GPT-4oとクロード3.5ソネット

論文アドレス:https://arxiv.org/pdf/2412.19260v1

実験部分もまた、モデル・パラメーターのスケールが大きい3つのブロックに分けられている:7~8b、~100~300b、~1.7tでもGPT-4o-ミニわずか8Bで1位というのはちょっと信じられない。

概要

- クロード 3.5ソネット(2024-10-22)、~175B

- ChatGPT、~175B

- GPT-4、約1.76T

- GPT-4o、~200B

- GPT-4o-mini(gpt-4o-2024-05-13)のみ 8B

- 最新のo1-mini (o1-mini-2024-09-12)のみ 100B

- o1プレビュー (o1-preview-2024-09-12) ~ 300B

© 著作権表示

この記事は著作権で保護されており、許可なく複製することは禁じられている。

関連記事

コメントはありません