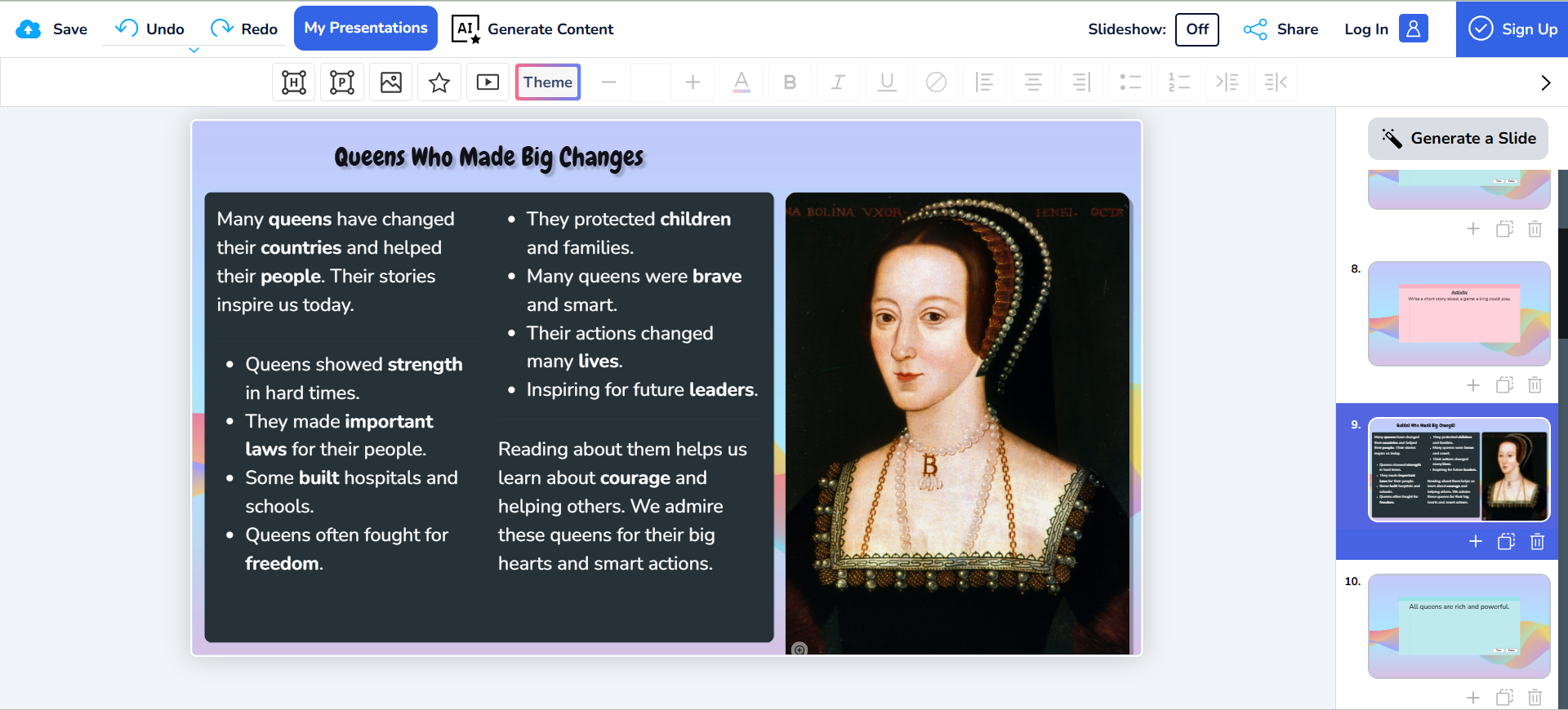

딥클라우드: 딥시크 R1 체인 추론과 클로드 크리에이티브를 융합한 채팅 인터페이스

일반 소개

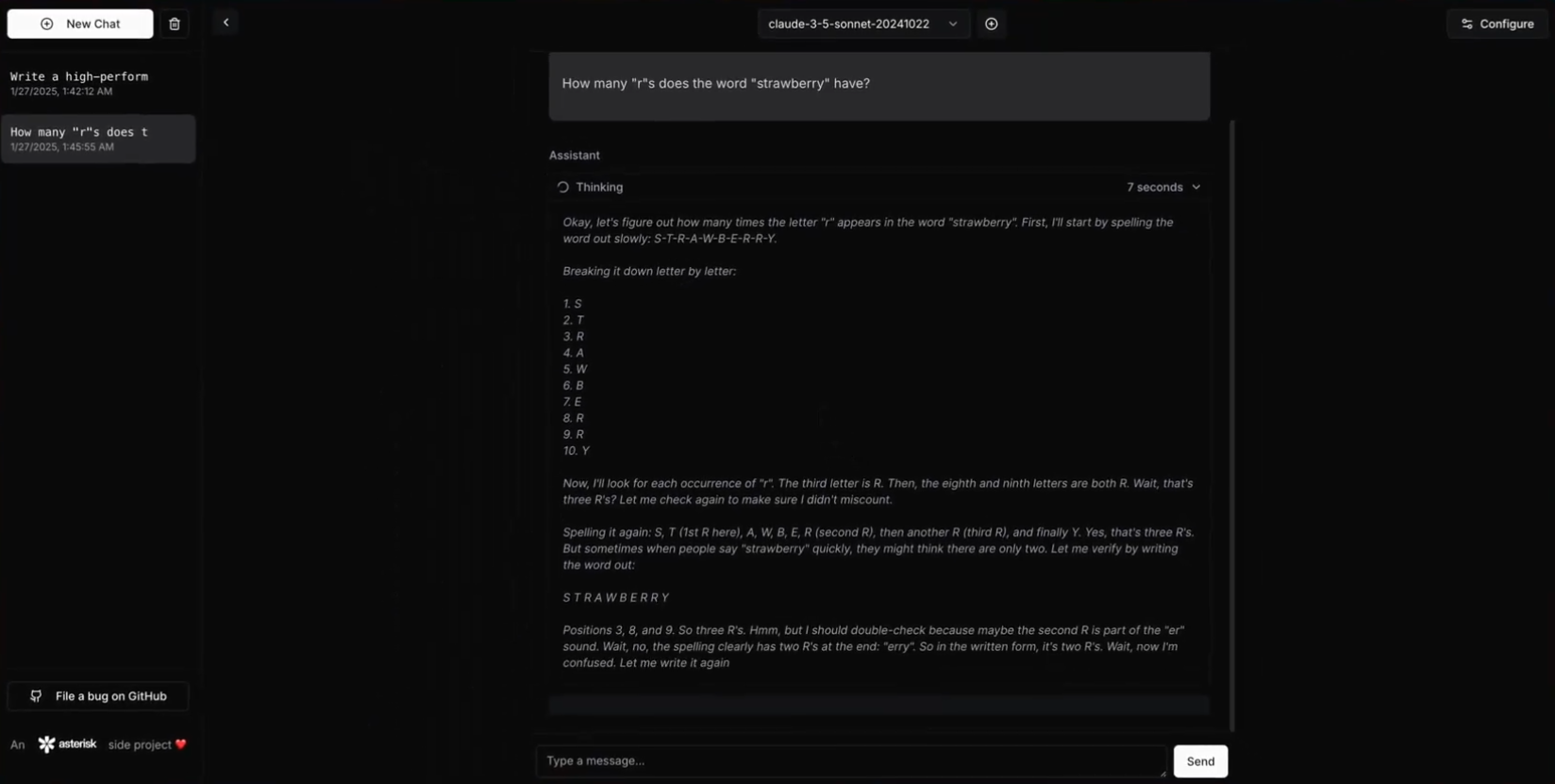

DeepClaude 是一个高性能的大语言模型(LLM)推理API和聊天界面,集成了DeepSeek R1的链式推理(CoT)能力和 인류학Claude 模型的创造力与代码生成能力。这个项目显著优于OpenAI o1、 DeepSeek R1 和 Claude Sonnet 3.5 ,提供了一个统一的接口,利用这两种模型的优势,同时保持对API密钥和数据的完全控制。 DeepClaude 的特点包括零延迟响应、端到端的安全性、高度可配置性以及开源代码库。用户可以使用自己的API密钥进行管理,确保数据的私密性和安全性。最重要的是,DeepClaude完全免费且开源。

DeepClaude使用R1进行推理,然后让Claude输出结果

DeepClaude 同时提供高性能LLM推理API

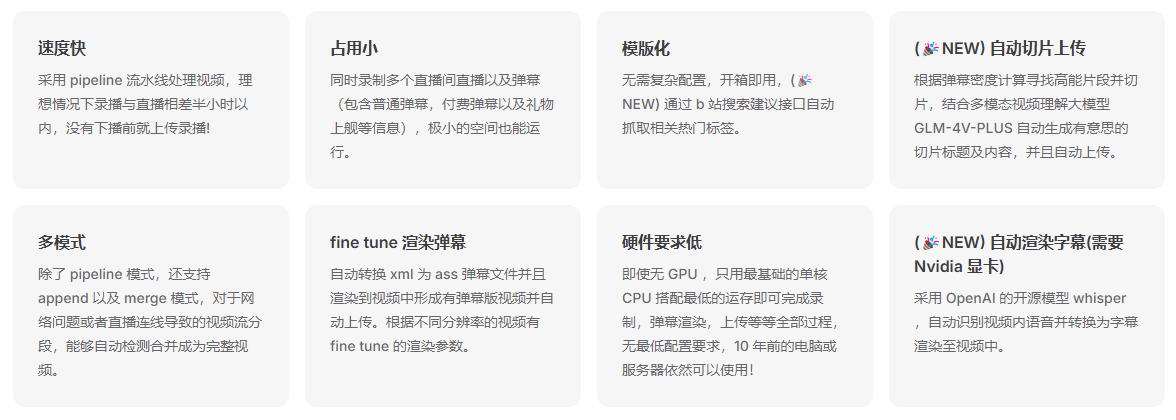

기능 목록

- 零延迟响应:通过高性能的Rust API实现即时响应。

- 私密安全:本地API密钥管理,确保数据的私密性。

- 高度可配置:用户可以根据需求自定义API和界面的各个方面。

- 오픈 소스:免费且开源的代码库,用户可以自由贡献、修改和部署。

- 双AI能力:结合Claude Sonnet 3.5的创造力与代码生成能力和DeepSeek R1的推理能力。

- 托管BYOK API:使用用户自己的API密钥进行管理,确保完全控制。

도움말 사용

설치 프로세스

- 前提条件::

- Rust 1.75或更高版本

- DeepSeek API密钥

- Anthropic API密钥

- 클론 창고::

git clone https://github.com/getAsterisk/deepclaude.git

cd deepclaude

- 프로젝트 빌드::

cargo build --release

- 구성 파일: 在项目根目录创建

config.toml문서화:

[server]

host = "127.0.0.1"

port = 3000

[pricing]

# 配置定价选项

- 运行服务::

cargo run --release

사용 가이드라인

- API使用::

- 基本示例::

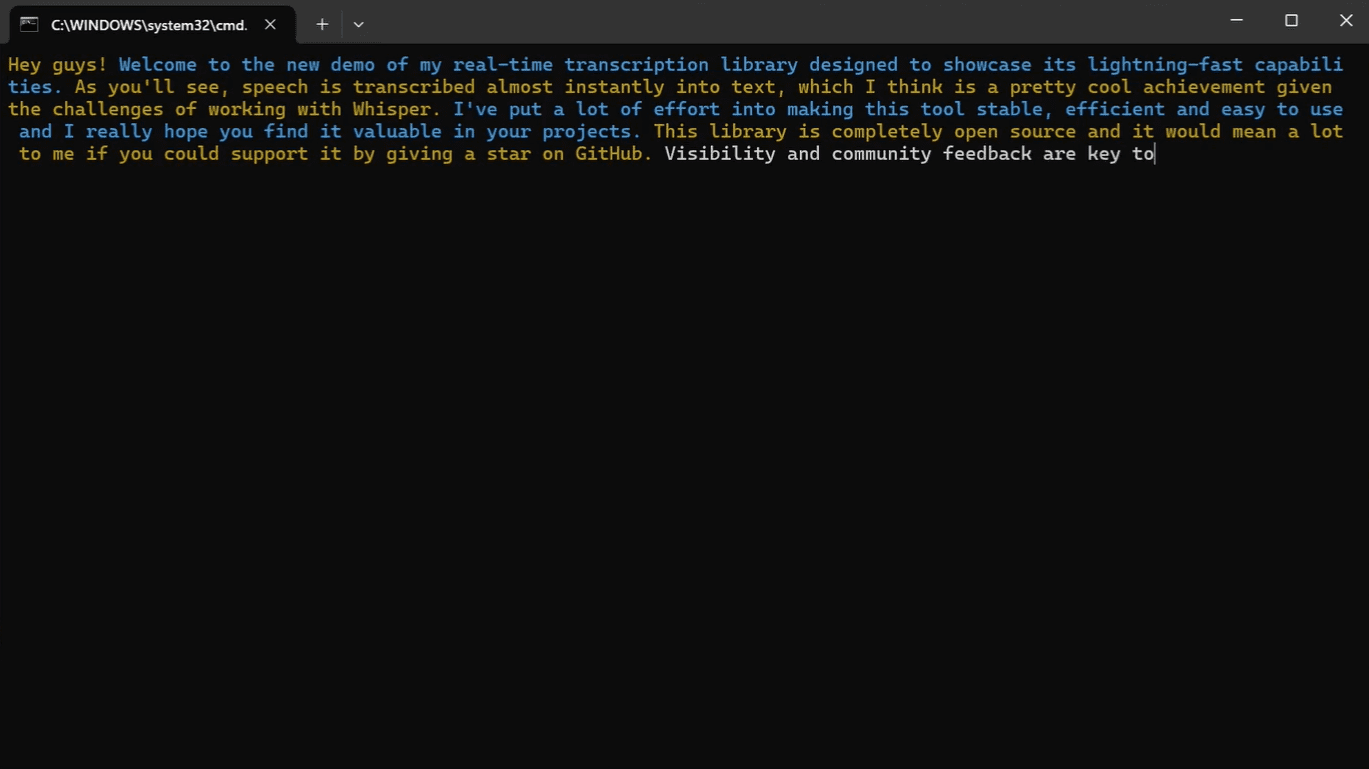

import requests url = "http://127.0.0.1:3000/api" payload = { "model": "claude", "prompt": "Hello, how can I help you today?" } response = requests.post(url, json=payload) print(response.json())- 流式响应示例::

import requests url = "http://127.0.0.1:3000/api/stream" payload = { "model": "claude", "prompt": "Tell me a story." } response = requests.post(url, json=payload, stream=True) for line in response.iter_lines(): if line: print(line.decode('utf-8')) - 自托管::

- 配置选项: 用户可以通过修改

config.toml文件中的配置选项,定制API和界面的各个方面。

- 配置选项: 用户可以通过修改

- 안전::

- 本地API密钥管理:确保API密钥和数据的私密性。

- 端到端加密:保护数据传输的安全性。

- 贡献::

- 기여 가이드라인:用户可以通过提交Pull Request或报告问题来贡献代码和改进项目。

© 저작권 정책

이 글은 저작권이 있으며 무단으로 복제해서는 안 됩니다.

관련 문서

댓글 없음...