FastDeploy란 무엇인가요?

FastDeploy는 대규모 언어 모델(LLM) 및 시각 언어 모델(VLM)을 위해 설계된 Baidu의 고성능 추론 및 배포 도구로, PaddlePaddle 프레임워크를 기반으로 개발되었으며 여러 하드웨어 플랫폼(예: NVIDIA GPU, Kunlun XPU 등)을 지원하고 부하 분산, 정량적 최적화, 분산 추론 등의 기능을 탑재하고 있습니다, FastDeploy는 OpenAI API 및 vLLM 인터페이스를 통해 로컬 및 서비스 추론을 지원하여 대규모 모델의 배포 프로세스를 간소화합니다. 최신 버전인 FastDeploy 2.0은 2비트 양자화 기술을 도입하여 성능을 더욱 최적화하고 대규모 모델의 효율적인 배포를 지원합니다.

FastDeploy의 주요 기능

- 효율적인 추론 배포엔비디아 GPU, 쿤룬 코어 XPU 등 다양한 하드웨어 플랫폼을 지원하며, 원클릭 배포 기능을 제공하여 대규모 모델의 추론 배포 프로세스를 간소화할 수 있습니다.

- 성능 최적화양자화 기술(예: 2비트 양자화), CUDA 그래프 최적화 및 추측 디코딩으로 모델 추론 속도를 크게 향상시킵니다.

- 분산 추론대규모 분산 추론을 지원하고, 커뮤니케이션 효율성을 최적화하며, 대규모 모델의 추론 효율성을 개선합니다.

- 로드 밸런싱 및 스케줄링Redis를 기반으로 실시간 부하 감지 및 분산 부하 분산 스케줄링을 통해 클러스터 성능을 최적화하고 높은 부하에서도 안정적인 시스템 운영을 보장합니다.

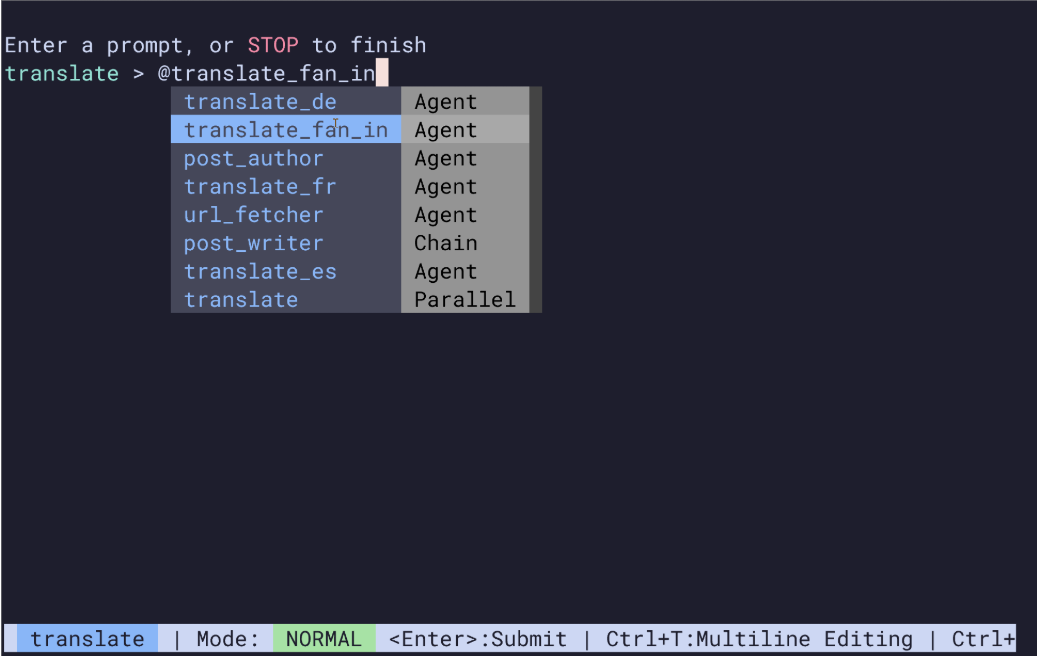

- 사용성깔끔한 Python 인터페이스와 자세한 설명서를 제공하여 사용자가 쉽게 시작하고 빠르게 실행할 수 있도록 합니다.

- 2비트 양자화 기술2비트 양자화를 도입하면 메모리 공간과 하드웨어 리소스 요구 사항이 획기적으로 줄어들어 단일 카드에 수천억 개의 파라미터 수준 모델을 배포할 수 있습니다.

- 호환성OpenAI API 및 vLLM 인터페이스와 호환되며 로컬 추론과 서비스 추론을 모두 지원하며, 로컬 추론을 완료하는 코드 4줄과 서비스 시작 명령어 1줄로 구성됩니다.

FastDeploy의 공식 웹사이트 주소

- 프로젝트 웹사이트:: https://paddlepaddle.github.io/FastDeploy/

- GitHub 리포지토리:: https://github.com/PaddlePaddle/FastDeploy

FastDeploy 사용 방법

- 종속성 설치플라잉 패들 프레임과 FastDeploy를 설치합니다:

pip install paddlepaddle fastdeploy- 모델을 준비합니다:모델 파일(예: 사전 학습된 모델 또는 변환된 모델)을 다운로드하여 준비합니다.

- 로컬 추론파이썬 인터페이스를 사용한 로컬 추론:

from fastdeploy import inference

# 加载模型

model = inference.Model("path/to/model")

# 准备输入数据

input_data = {"input_ids": [1, 2, 3], "attention_mask": [[1, 1, 1]]}

# 进行推理

result = model.predict(input_data)

print(result)- 서비스 지향 배포: 추론 서비스를 시작합니다:

fastdeploy serve --model path/to/model --port 8080- 성능 최적화정량적 기법을 사용한 모델 최적화:

from fastdeploy import quantization

quantized_model = quantization.quantize_model("path/to/model", "path/to/quantized_model", quantization_type="2-bit")FastDeploy의 핵심 이점

- 고성능 추론이 회사의 기술은 양자화, CUDA 그래프 및 기타 기술을 기반으로 추론 속도를 크게 향상시키는 동시에 여러 하드웨어 플랫폼을 지원하여 하드웨어 성능을 최대한 활용할 수 있습니다.

- 효율적인 배포로컬 및 서비스 추론을 지원하고 배포 프로세스를 간소화하기 위한 깔끔한 Python 인터페이스와 명령줄 도구를 제공합니다.

- 리소스 최적화이 시스템에 새로 추가된 2비트 양자화 기술은 그래픽 메모리 공간을 획기적으로 줄이고, 하이퍼스케일 모델의 단일 카드 배포를 지원하며, 로드 밸런싱을 통해 클러스터 리소스 활용도를 최적화하는 기술입니다.

- 사용성인터페이스는 간단하고 잘 문서화되어 있어 빠르게 시작할 수 있고, OpenAI API 및 vLLM 인터페이스와 호환되며, 빠른 서비스 시작을 지원합니다.

- 멀티 시나리오자연어 처리, 멀티모달 애플리케이션, 산업 등급 배포, 학술 연구 및 엔터프라이즈 애플리케이션에 광범위하게 적용 가능하여 다양한 요구 사항을 충족합니다.

FastDeploy의 대상

- 엔터프라이즈 개발자엔터프라이즈 개발자는 대규모 모델을 신속하게 배포하고 리소스를 최적화하여 비용을 절감하며 엔터프라이즈 서비스의 효율성을 개선할 수 있습니다.

- 데이터 과학자 및 연구원효율적인 모델 최적화 및 실험을 지원하기 위한 연구자의 고성능 추론 실험 및 멀티모달 연구.

- 시스템 설계자아키텍트는 대규모 분산 추론 시스템을 설계하고 안정적인 시스템 운영을 위해 로드 밸런싱을 최적화하는 업무를 담당합니다.

- AI 애플리케이션 개발자개발자는 애플리케이션 성능을 개선하고 사용자 경험을 최적화하기 위해 자연어 처리 및 멀티모달 애플리케이션을 개발합니다.

- 학술 연구자학자들은 효율적인 실험을 촉진하고 학술 연구를 발전시키기 위해 모델 최적화와 멀티모달 기술을 연구합니다.

© 저작권 정책

이 글은 저작권이 있으며 무단으로 복제해서는 안 됩니다.

관련 게시물

댓글 없음...