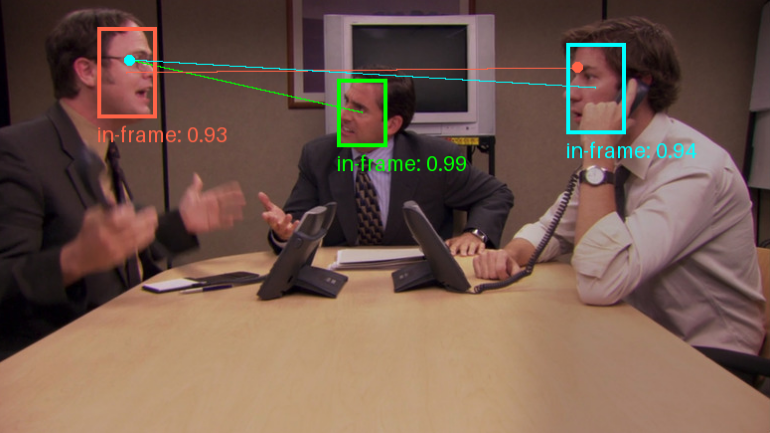

Gaze-LLE: 비디오 속 인물 시선에 대한 타겟 예측 도구

일반 소개

Gaze-LLE는 대규모 학습 인코더를 기반으로 하는 시선 표적 예측 툴입니다. 피오나 라이언, 아제이 바티, 이상민, 다니엘 볼야, 주디 호프만, 제임스 레그가 개발한 이 프로젝트는 DINOv2와 같은 사전 훈련된 시각적 기반 모델을 통해 효율적인 시선 표적 예측을 가능하게 하는 것을 목표로 하며, Gaze-LLE의 아키텍처는 깔끔하고 단순하며, 사전 훈련된 경량 시선 디코더를 학습하기 때문에 이전 작업에 비해 파라미터의 양이 1~2배 정도 줄어들고 깊이 및 포즈 정보와 같은 추가 입력 양식이 필요하지 않습니다.

기능 목록

- 목표 예측에 집중사전 학습된 비주얼 코더를 기반으로 시선 타겟을 효율적으로 예측합니다.

- 다중 시선 예측: 단일 이미지에서 여러 사람의 시선 예측을 지원합니다.

- 사전 교육 모델다양한 백본 네트워크와 학습 데이터를 지원하기 위해 사전 학습된 다양한 모델을 제공합니다.

- 경량 아키텍처경량 시선 디코더 학습은 사전 훈련된 시각 코더만 학습합니다.

- 추가 입력 모드 없음추가 깊이 및 자세 정보 입력이 필요하지 않습니다.

도움말 사용

설치 프로세스

- 복제 창고:

git clone https://github.com/fkryan/gazelle.git

cd gazelle

- 가상 환경을 만들고 종속 요소를 설치합니다:

conda env create -f environment.yml

conda activate gazelle

pip install -e .

- 선택 사항: 관심도 계산을 가속화하기 위해 x포머를 설치합니다(시스템에서 지원하는 경우):

pip3 install -U xformers --index-url https://download.pytorch.org/whl/cu118

사전 학습된 모델 사용

Gaze-LLE는 사용자가 필요에 따라 다운로드하여 사용할 수 있는 사전 학습된 다양한 모델을 제공합니다:

- 가젤dinov2vitb14GazeFollow의 학습 데이터가 포함된 DINOv2 ViT-B 기반 모델입니다.

- 가젤dinov2vitl14GazeFollow의 학습 데이터가 포함된 DINOv2 ViT-L 기반 모델입니다.

- 가젤dinov2vitb14_inoutGazeFollow 및 VideoAttentionTarget에 대한 학습 데이터가 포함된 DINOv2 ViT-B 기반 모델입니다.

- 가젤largevitl14_inout시선추적 및 비디오어텐션타겟에 대한 학습 데이터가 포함된 DINOv2 ViT-L 기반 모델입니다.

사용 예

- 파이토치 허브에서 모델을 로드합니다:

import torch

model, transform = torch.hub.load('fkryan/gazelle', 'gazelle_dinov2_vitb14')

- 이미지에서 모든 사람의 시선 대상을 감지하는 방법을 알아보려면 Google Colab의 데모 노트북을 확인하세요.

예측 보기

Gaze-LLE는 여러 사람에 대한 시선 예측을 지원합니다. 즉, 하나의 이미지를 한 번 인코딩한 다음 특징을 사용하여 이미지에 있는 여러 사람의 시선 대상을 예측하는 방식입니다. 이 모델은 장면에서 시선 대상의 위치 확률을 나타내는 공간 히트 맵을 [0,1] 범위의 값으로 출력하며, 여기서 1은 시선 대상 위치의 확률이 가장 높음을 나타냅니다.

© 저작권 정책

이 글은 저작권이 있으며 무단으로 복제해서는 안 됩니다.

관련 문서

댓글 없음...