GLM Edge: 스마트 스펙트럼, 모바일, 자동차 및 PC 플랫폼을 위한 엔드-사이드 빅 언어 모델과 멀티모달 이해 모델 출시

일반 소개

GLM-Edge는 칭화대학교의 단말기용으로 설계된 일련의 대형 언어 모델 및 다중 모드 이해 모델(스마트 스펙트럼 라이트 언어)입니다. 이 모델에는 각각 휴대폰, 자동차 및 PC 플랫폼용 GLM-Edge-1.5B-Chat, GLM-Edge-4B-Chat, GLM-Edge-V-2B 및 GLM-Edge-V-5B가 있으며, GLM-Edge 시리즈 모델은 고성능을 유지하면서 실제 배포의 용이성과 추론 속도에 중점을 두며 특히 퀄컴 스냅드래곤 및 인텔 플랫폼에서 뛰어난 성능을 발휘합니다. GLM-Edge 시리즈 모델은 효율적인 성능을 유지하면서 배포의 용이성과 추론 속도에 중점을 두었으며, 특히 Qualcomm Snapdragon 및 Intel 플랫폼에서 뛰어난 성능을 발휘합니다. 사용자는 허깅페이스, 모델스코프 등을 통해 이러한 모델을 다운로드하여 사용할 수 있으며, 다양한 추론 백엔드(예: 트랜스포머, OpenVINO, vLLM)를 통해 모델 추론을 수행할 수 있습니다.

GLM Edge 끝면 텍스트 모델

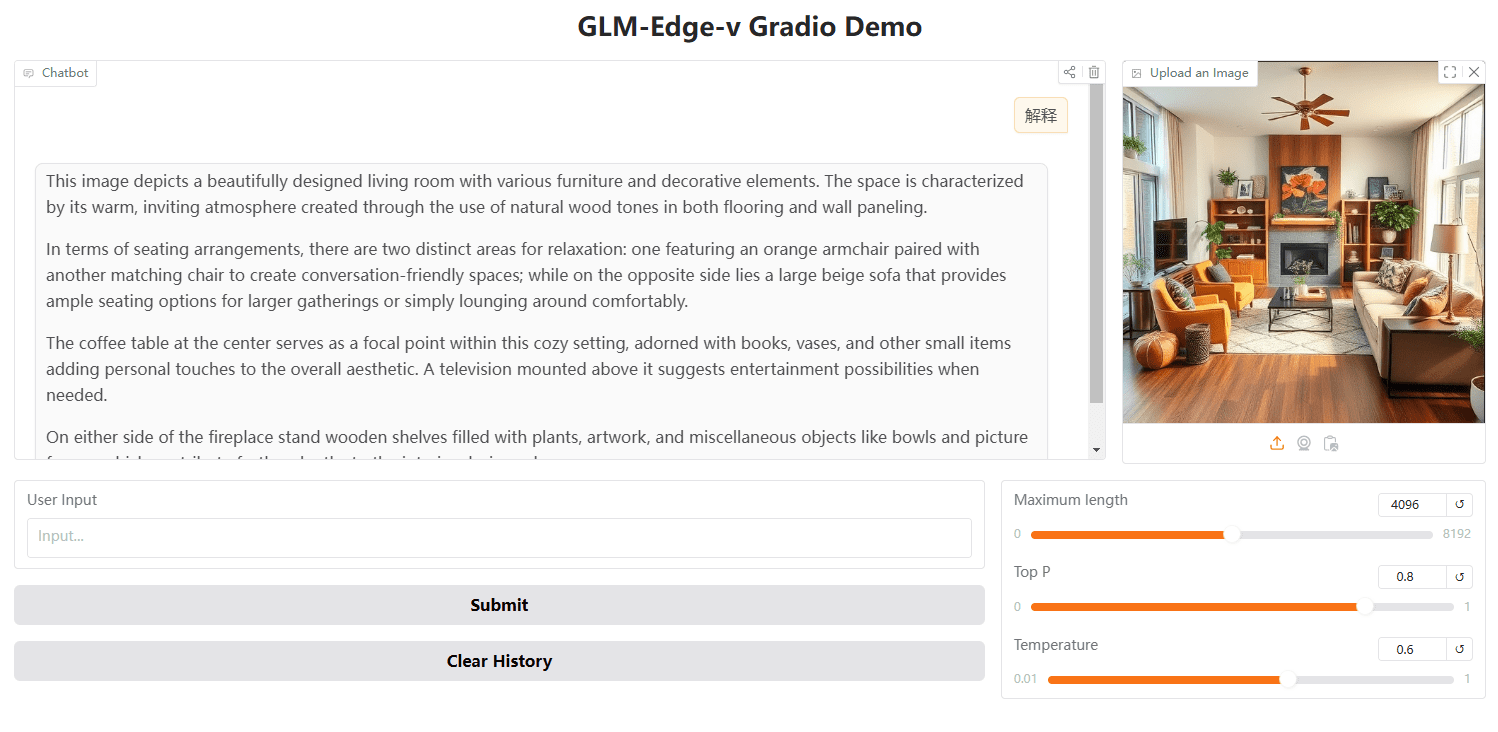

GLM Edge 엔드 사이드 시각적 모델

기능 목록

- 여러 모델 옵션다양한 엔드사이드 디바이스를 위한 다양한 파라미터 스케일의 대화 모델과 멀티모달 이해 모델을 제공합니다.

- 효율적인 추론하이브리드 양자화 체계를 지원하여 퀄컴 스냅드래곤 및 인텔 플랫폼에서 효율적인 추론 속도를 달성하세요.

- 멀티 플랫폼 지원모델은 허깅페이스, 모델스코프 및 기타 플랫폼에서 다운로드할 수 있으며, 다양한 추론 백엔드를 지원합니다.

- 간편한 배포사용자가 빠르게 시작할 수 있도록 자세한 설치 및 사용 가이드를 제공합니다.

- 미세 조정 지원미세 조정 튜토리얼 및 구성 파일을 제공하여 사용자가 특정 요구 사항에 따라 모델을 미세 조정할 수 있도록 지원합니다.

도움말 사용

종속성 설치

사용 중인 Python 버전이 3.10 이상인지 확인합니다. 그리고 다음과 같이 종속 요소를 설치합니다:

pip install -r requirements.txt

모델링된 추론

당사는 백엔드 추론을 위해 vLLM, OpenVINO 및 트랜스포머를 제공하며, 다음 명령을 실행하여 모델을 실행할 수 있습니다:

python cli_demo.py --backend transformers --model_path THUDM/glm-edge-1.5b-chat --precision bfloat16

python cli_demo.py --backend vllm --model_path THUDM/glm-edge-1.5b-chat --precision bfloat16

python cli_demo.py --backend ov --model_path THUDM/glm-edge-1.5b-chat-ov --precision int4

참고: OpenVINO 버전 모델은 변환이 필요하므로 관련 페이지로 이동하여 변환 코드를 실행하세요:

python convert_chat.py --model_path THUDM/glm-edge-1.5b-chat --precision int4

python convert.py --model_path THUDM/glm-edge-v-2b --precision int4

모델 미세 조정

모델을 미세 조정할 수 있는 코드를 제공하며, 미세 조정 튜토리얼을 참조하세요. 다음은 미세 조정을 위한 기본 단계입니다:

- 데이터 세트를 준비하고 학습 매개변수를 구성합니다.

- 미세 조정 스크립트를 실행합니다:

OMP_NUM_THREADS=1 torchrun --standalone --nnodes=1 --nproc_per_node=8 finetune.py data/AdvertiseGen/ THUDM/glm-edge-4b-chat configs/lora.yaml

- 저장 지점에서 계속 미세 조정해야 하는 경우 네 번째 매개변수를 추가할 수 있습니다:

python finetune.py data/AdvertiseGen/ THUDM/glm-edge-4b-chat configs/lora.yaml yes

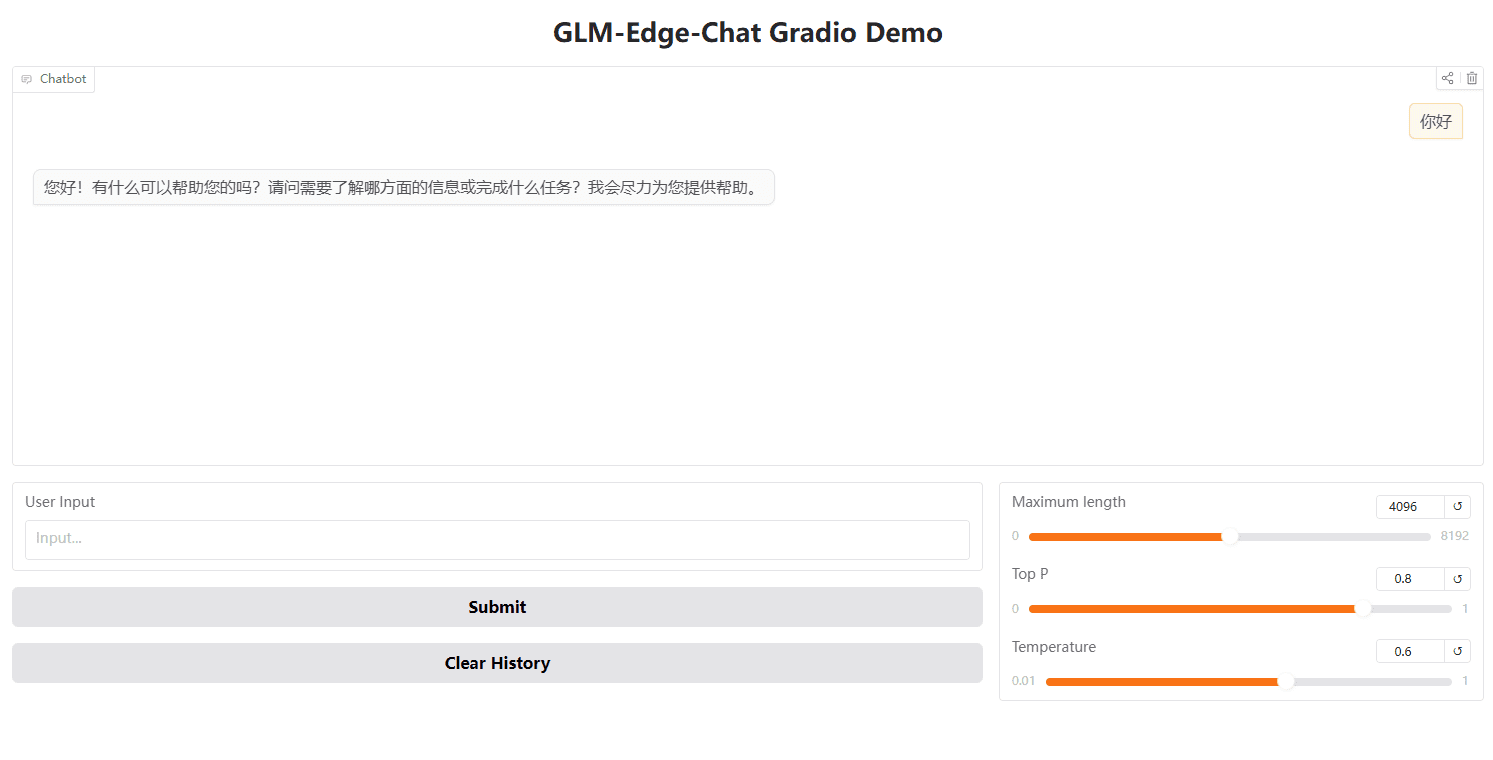

Gradio로 웹UI 시작하기

Gradio를 사용하여 WebUI를 시작할 수도 있습니다:

python cli_demo.py --backend transformers --model_path THUDM/glm-edge-1.5b-chat --precision bfloat16

OpenAI API로 추론하기

import openai

client = openai.Client(api_key="your_api_key", base_url="http://<XINFERENCE_HOST>:<XINFERENCE_PORT>/v1")

output = client.chat.completions.create(

model="glm-edge-v",

messages=[

{"role": "user", "content": "describe this image"},

{"role": "image_url", "image_url": {"url": "img.png"}}

],

max_tokens=512,

temperature=0.7

)

print(output)© 저작권 정책

이 글은 저작권이 있으며 무단으로 복제해서는 안 됩니다.

관련 문서

댓글 없음...