HiOllama:与本地Ollama模型交互的简洁聊天界面

일반 소개

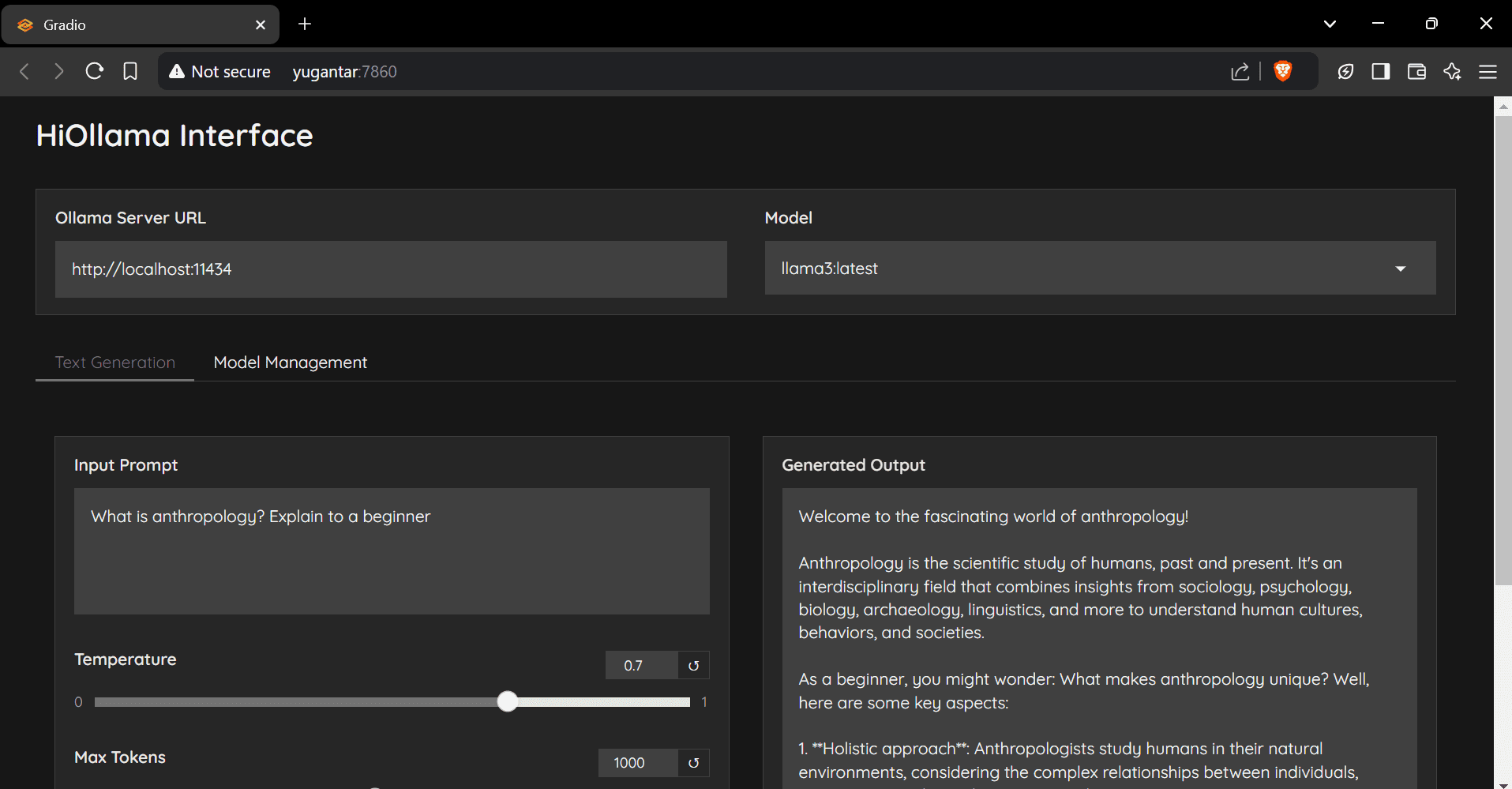

HiOllama是一个基于Python和Gradio构建的用户友好界面,旨在与Ollama模型进行交互。它提供了简单直观的网页界面,支持实时文本生成和模型管理功能。用户可以调整参数如温度和最大令牌数,并支持多个Ollama模型的管理和自定义服务器URL配置。

推荐:Ollama 与 WebUI 열기 集成较为友好,但部署成本稍高。

기능 목록

- 简单直观的网页界面

- 实时文本生成

- 可调节参数(温度、最大令牌数)

- 模型管理功能

- 支持多个Ollama模型

- 自定义服务器URL配置

도움말 사용

설치 단계

- 복제 창고:

git clone https://github.com/smaranjitghose/HiOllama.git cd HiOllama - 创建并激活虚拟环境:

- Windows:

python -m venv env .\env\Scripts\activate - Linux/Mac:

python3 -m venv env source env/bin/activate

- Windows:

- 安装所需的包:

pip install -r requirements.txt - 安装Ollama(如果尚未安装):

- Linux/Mac:

curl -fsSL https://ollama.ai/install.sh | sh - Windows:

先安装WSL2,然后运行上述命令。

- Linux/Mac:

사용 단계

- 启动Ollama服务:

ollama serve - 运行HiOllama:

python main.py - 打开浏览器并导航到:

http://localhost:7860

快速开始指南

- 从下拉菜单中选择一个模型。

- 在文本区域输入提示。

- 根据需要调整温度和最大令牌数。

- 点击“生成”以获取响应。

- 使用“模型管理”选项卡拉取新模型。

구성

默认设置可以在main.py中修改:

DEFAULT_OLLAMA_URL = "http://localhost:11434"

DEFAULT_MODEL_NAME = "llama3"

일반적인 문제

- 连接错误:确保Ollama正在运行(

ollama serve),检查服务器URL是否正确,确保端口11434可访问。 - 模型未找到:先拉取模型:

ollama pull model_name,检查可用模型:ollama list. - 端口冲突: in

main.py中更改端口:app.launch(server_port=7860) # 更改为其他端口

© 저작권 정책

이 글은 저작권이 있으며 무단으로 복제해서는 안 됩니다.

관련 문서

댓글 없음...