LHM: 단일 이미지에서 모션이 가능한 3D 인체 모델 생성

일반 소개

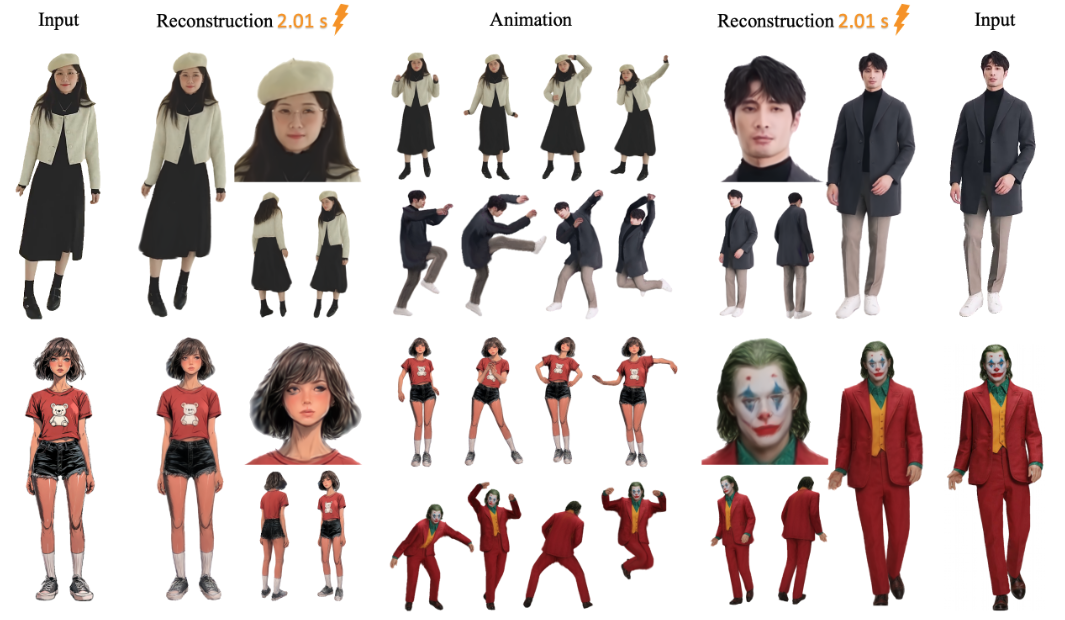

LHM(대형 애니메이션 가능한 인체 재구성 모델)은 오픈 소스 프로젝트로, aigc3d 팀이 개발했으며 단일 이미지에서 동작을 지원하는 3D 인체 모델을 빠르게 생성할 수 있습니다. 핵심 기능은 AI 기술을 사용하여 2D 이미지를 몇 초 만에 3D 모델로 변환하고 실시간 미리보기 및 포즈 조정을 지원하는 것입니다. LHM은 3D 가우시안 스플래팅 기술을 사용하여 인체를 표현하고 의류 질감과 기하학적 디테일을 보존하는 멀티모달 트랜스포머 아키텍처를 결합합니다. 2025년 3월 13일에 처음 공개된 이 프로젝트는 3D 디지털 인간 관련 애플리케이션의 연구 또는 개발에 적합한 사전 훈련된 모델과 코드를 제공합니다.

기능 목록

- 단 몇 초 만에 단일 이미지로 3D 마네킹을 생성합니다.

- 실시간 렌더링이 지원되며 생성된 모델을 바로 확인할 수 있습니다.

- 인체 자세를 조정하여 역동적인 영상을 생성하는 액션 기능을 제공합니다.

- 후속 편집을 위해 3D 메시 파일(예: OBJ 형식)을 출력합니다.

- 사전 학습된 모델(예: LHM-0.5B 및 LHM-1B)이 포함되어 있으므로 직접 학습할 필요가 없습니다.

- 로컬 시각화를 지원하는 통합 Gradio 인터페이스.

- 비디오에서 액션을 추출하여 모델에 적용할 수 있는 비디오 처리 파이프라인을 제공합니다.

도움말 사용

LHM의 사용은 설치와 운영의 두 부분으로 나뉩니다. 다음은 빠르게 시작하는 데 도움이 되는 자세한 단계입니다.

설치 프로세스

- 환경 준비하기

시스템에는 Python 3.10 및 CUDA(버전 11.8 또는 12.1 지원)가 필요합니다. 최소 16GB의 비디오 메모리를 갖춘 A100 또는 4090과 같은 NVIDIA 그래픽 카드가 권장됩니다.- Python 버전을 확인하세요:

python --version - CUDA 버전을 확인하세요:

nvcc --version

- Python 버전을 확인하세요:

- 클론 창고

터미널에 다음 명령을 입력하여 LHM 코드를 다운로드합니다:git clone https://github.com/aigc3d/LHM.git cd LHM

- 종속성 설치

사용 중인 CUDA 버전에 따라 해당 스크립트를 실행합니다:- CUDA 11.8:

sh ./install_cu118.sh - CUDA 12.1:

sh ./install_cu121.sh

스크립트가 실패하면 종속성을 수동으로 설치하세요:

pip install -r requirements.txt - CUDA 11.8:

- 모델 다운로드

모델이 자동으로 다운로드됩니다. 수동으로 다운로드하려면 다음 명령을 사용하세요:- LHM-0.5B 모델:

wget https://virutalbuy-public.oss-cn-hangzhou.aliyuncs.com/share/aigc3d/data/for_lingteng/LHM/LHM-0.5B.tar tar -xvf LHM-0.5B.tar - LHM-1B 모델:

wget https://virutalbuy-public.oss-cn-hangzhou.aliyuncs.com/share/aigc3d/data/for_lingteng/LHM/LHM-1B.tar tar -xvf LHM-1B.tar

다운로드하여 프로젝트 루트 디렉터리에 압축을 풉니다.

- LHM-0.5B 모델:

- 설치 확인

테스트 명령을 실행하여 환경이 정상인지 확인합니다:python app.py성공하면 Gradio 인터페이스가 시작됩니다.

워크플로

3D 모델 생성

- 사진 준비

인체 전신이 포함된 선명한 이미지를 준비하여 로컬에 저장합니다.<path_to_image>/person.jpg. - 추론 스크립트 실행

터미널에 입력합니다:bash ./inference.sh ./configs/inference/human-lrm-1B.yaml LHM-1B <path_to_image>/ ./output/<path_to_image>는 이미지의 경로입니다../output/는 생성된 결과가 저장되는 출력 폴더입니다.

- 결과 보기

생성 후<output>이 폴더에는 3D 모델 파일과 렌더링된 동영상이 있습니다. 3D 소프트웨어(예: Blender)로 메시 파일을 열거나 동영상을 직접 재생할 수 있습니다.

작업 추가

- 준비 동작 순서

이 프로젝트는 샘플 작업 파일을 제공하며, 이 파일은<LHM根目录>/train_data/motion_video/mimo1/smplx_params. 자체 SMPL-X 매개변수 파일을 사용할 수도 있습니다. - 액션 스크립트 실행

다음 명령을 입력합니다:bash ./inference.sh ./configs/inference/human-lrm-1B.yaml LHM-1B <path_to_image>/ <path_to_motion>/smplx_params<path_to_motion>는 작업 파일 경로입니다.

- 액션 비디오 미리보기

출력 폴더에서 바로 재생할 수 있는 액션 동영상을 생성합니다.

라디오 인터페이스 사용

- 실행 인터페이스

터미널에서 실행됩니다:python app.py브라우저가 열립니다.

http://0.0.0.0:7860. - 사진 업로드

인터페이스에서 신체 사진을 업로드하고 '제출'을 클릭합니다. - 결과 얻기

몇 초 후 인터페이스에 렌더링된 이미지와 액션 비디오가 표시되며, 이를 다운로드하여 볼 수 있습니다.

3D 메시 익스포트

- 내보내기 스크립트 실행

입력:bash ./inference_mesh.sh ./configs/inference/human-lrm-1B.yaml LHM-1B - 파일을 찾습니다.

출력 폴더에는 3D 소프트웨어로 편집할 수 있는 OBJ 형식의 메시 파일이 있습니다.

주의

- 사진은 선명해야 하고 배경은 단순한 것이 더 효과적입니다.

- 액션 효과는 입력 액션의 품질에 따라 달라집니다.

- 비디오 메모리가 충분하지 않다면 LHM-0.5B 모델을 사용해 보세요.

애플리케이션 시나리오

- 게임 개발

개발자는 LHM을 사용하여 사진에서 3D 캐릭터 모델을 빠르게 생성하고 포즈를 조정한 후 게임 엔진으로 임포트하여 모델링 시간을 절약할 수 있습니다. - 영화 및 텔레비전 제작

영화 및 TV 팀은 LHM을 사용하여 디지털 스탠드인을 제작하고 특수 효과 장면에 사용할 액션 비디오를 생성하여 수동 모델링 비용을 절감할 수 있습니다. - 가상 앵커(TV)

호스트는 자신의 사진을 업로드하여 3D 이미지를 생성한 다음 작업을 추가하여 개인화된 가상 이미지를 만들 수 있습니다. - 교육 연구

연구원들은 강의실에서 LHM으로 3D 재구성 알고리즘을 테스트하거나 사진에서 모형으로 변환하는 과정을 시연할 수 있었습니다.

QA

- LHM은 어떤 이미지 형식을 지원하나요?

JPG, PNG와 같은 일반적인 형식이 지원되며, 파일 크기는 10MB를 초과하지 않는 JPG를 권장합니다. - 모델을 생성하는 데 시간이 얼마나 걸리나요?

A100 카드의 경우 약 0.2초, 4090 카드의 경우 1~2초로 하드웨어에 따라 약간씩 차이가 있습니다. - 모델을 직접 트레이닝할 수 있나요?

가능하지만 공식적으로 제공되는 교육 스크립트는 없습니다. 숙련된 사용자에게 적합한 데이터 세트 준비 및 코드 튜닝이 필요합니다. - 출력된 3D 모델을 편집할 수 있나요?

할 수 있습니다. OBJ 파일을 내보낸 후 Blender 또는 Maya로 지오메트리와 텍스처를 편집합니다.

© 저작권 정책

이 글은 저작권이 있으며 무단으로 복제해서는 안 됩니다.

관련 문서

댓글 없음...