llama.cpp: 효율적인 추론 도구, 여러 하드웨어 지원, 손쉬운 LLM 추론 구현

일반 소개

llama.cpp는 대규모 언어 모델(LLM)의 추론 프로세스를 간소화하도록 설계된 순수 C/C++로 구현된 라이브러리입니다. 이 라이브러리는 Apple Silicon, NVIDIA GPU, AMD GPU를 비롯한 다양한 하드웨어 플랫폼을 지원하며 추론 속도를 높이고 메모리 사용량을 줄이기 위한 여러 가지 양자화 옵션을 제공합니다. 이 프로젝트의 목표는 로컬 및 클라우드 환경 모두에서 최소한의 설정으로 고성능 LLM 추론을 달성하는 것입니다.

기능 목록

- Apple 실리콘, NVIDIA GPU 및 AMD GPU를 포함한 여러 하드웨어 플랫폼 지원

- 1.5비트~8비트 정수 양자화 옵션 제공

- LLaMA, 미스트랄, 팔콘 등 여러 LLM 모델을 지원합니다.

- 손쉬운 통합을 위한 REST API 인터페이스 제공

- CPU+GPU 혼합 추론 지원

- Python, Go, Node.js 등 여러 프로그래밍 언어 바인딩을 제공합니다.

- 모델 변환 도구, 로드 밸런서 등 다양한 도구와 인프라 지원을 제공합니다.

도움말 사용

설치 프로세스

- 복제 창고:

git clone https://github.com/ggerganov/llama.cpp.git

cd llama.cpp

- 프로젝트를 컴파일합니다:

make

사용 가이드라인

모델 변환

llama.cpp는 다양한 하드웨어에서 효율적으로 실행할 수 있도록 모델을 변환하고 정량화할 수 있는 다양한 도구를 제공합니다. 예를 들어, 포옹하는 얼굴 모델은 다음 명령을 사용하여 GGML 형식으로 변환할 수 있습니다:

python3 convert_hf_to_gguf.py --model <model_name>

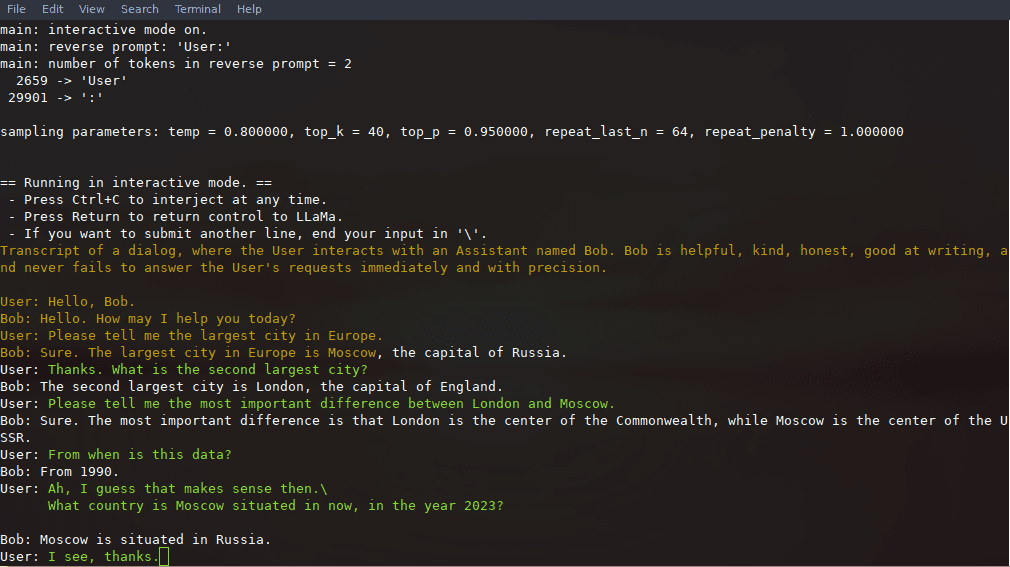

추론의 예

컴파일 후 다음 명령을 사용하여 추론할 수 있습니다:

./llama-cli -m models/llama-13b-v2/ggml-model-q4_0.gguf -p "你好,世界!"

REST API 사용

llama.cpp는 로컬 모델 추론 서비스에 사용할 수 있는 OpenAI API 호환 HTTP 서버도 제공합니다. 서버를 시작합니다:

./llama-server -m models/llama-13b-v2/ggml-model-q4_0.gguf --port 8080

그런 다음 브라우저를 통해 또는 추론 요청을 위한 API를 사용하여 기본 웹 UI에 액세스할 수 있습니다:

curl -X POST http://localhost:8080/v1/chat -d '{"prompt": "你好,世界!"}'

세부 기능 작동 흐름

- 모델 로드먼저 모델 파일을 다운로드하여 지정된 디렉터리에 배치한 다음 명령줄 도구를 사용하여 모델을 로드해야 합니다.

- 추론 구성컨텍스트 길이, 배치 크기 등 추론과 관련된 파라미터는 구성 파일이나 명령줄 파라미터를 통해 설정할 수 있습니다.

- API 통합레스트 API 인터페이스를 통해 llama.cpp를 기존 애플리케이션에 통합하여 자동화된 추론 서비스를 사용할 수 있습니다.

- 성능 최적화정량화 옵션과 하드웨어 가속 기능을 활용하면 추론 속도와 효율성을 크게 향상시킬 수 있습니다.

© 저작권 정책

이 글은 저작권이 있으며 무단으로 복제해서는 안 됩니다.

관련 문서

댓글 없음...