MiniMax-M1是什么

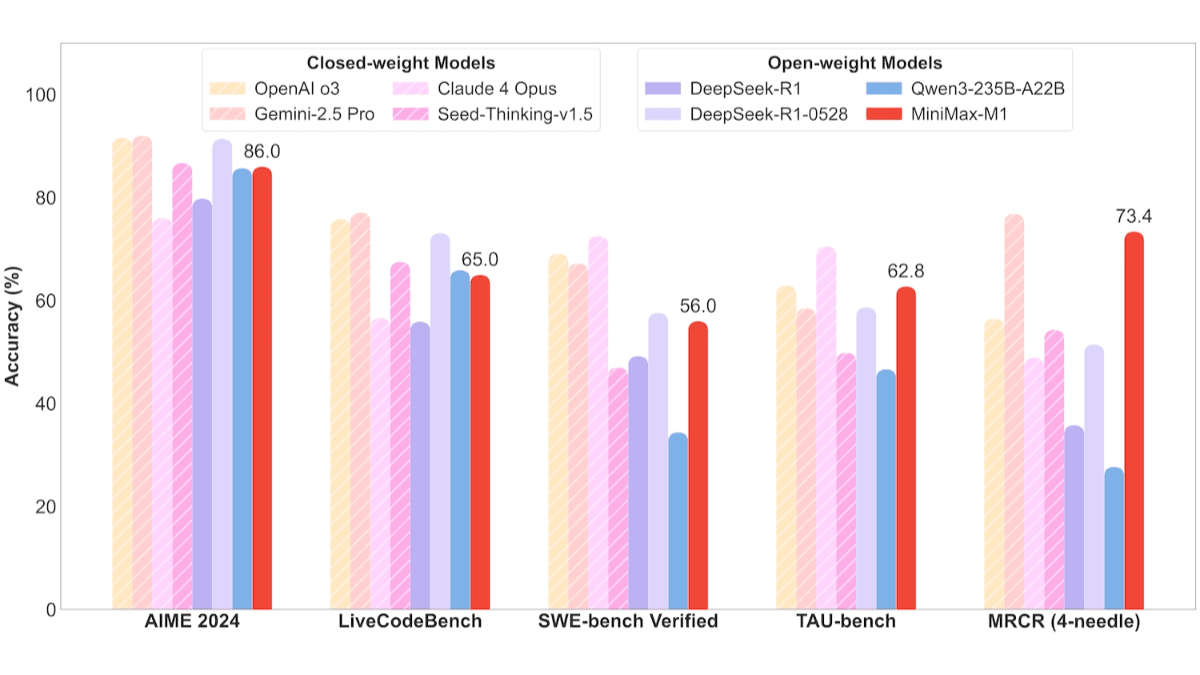

MiniMax-M1 是 MiniMax 团队推出的开源推理模型,基于混合专家架构(MoE)与闪电注意力机制(Lightning Attention)相结合,总参数量达 4560 亿。模型支持 100 万 토큰 的长上下文输入和 8 万 token 的输出,适合处理长文档和复杂推理任务。模型提供 40K 和 80K 两种推理预算版本,优化计算资源,降低推理成本。MiniMax-M1在软件工程、长上下文理解和工具使用等任务中表现出色,超越多个开源模型。模型高效的计算能力和强大的推理能力使其成为下一代语言模型代理的强大基础。

MiniMax-M1的主要功能

- 긴 컨텍스트 처리:支持长达100万token的输入和8万token的输出,能高效处理长文档、长篇报告、学术论文等长文本内容,适合复杂的推理任务。

- 효율적인 추론:提供40K和80K两种推理预算版本,优化计算资源分配,降低推理成本,保持高性能。

- 多领域任务优化:在数学推理、软件工程、长上下文理解和工具使用等任务中表现出色。

- 함수 호출:支持结构化功能调用,能识别、输出外部函数调用参数,便于与外部工具进行交互,提升自动化和工作效率。

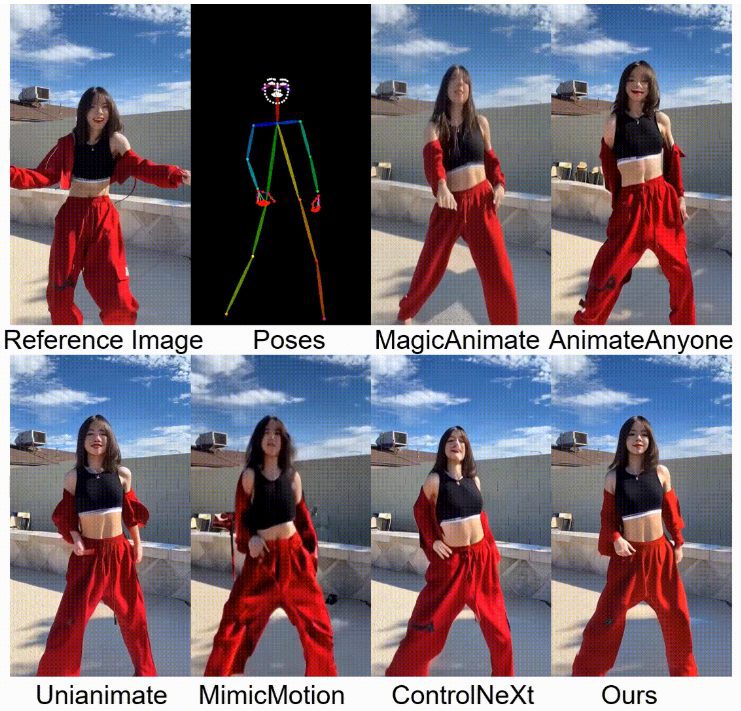

MiniMax-M1的性能表现

- 软件工程任务:在SWE-bench基准测试中,MiniMax-M1-40k和MiniMax-M1-80k分别取得55.6%和56.0%的成绩,略逊于DeepSeek-R1-0528的57.6%,显著超越其他开源模型。

- 长上下文理解任务:依托百万级上下文窗口,MiniMax-M1在长上下文理解任务中表现卓越,全面超越所有开源模型,甚至超越OpenAI o3和Claude 4 Opus,全球排名第二,仅次于Gemini 2.5 Pro。

- 工具使用场景:在TAU-bench测试中,MiniMax-M1-40k领跑所有开源模型,战胜Gemini-2.5 Pro。

MiniMax-M1的官网地址

- GitHub 리포지토리::https://github.com/MiniMax-AI/MiniMax-M1

- 허깅페이스 모델 라이브러리::https://huggingface.co/collections/MiniMaxAI/minimax-m1

- 기술 문서::https://github.com/MiniMax-AI/MiniMax-M1/blob/main/MiniMax_M1_tech_report.pdf

如何使用MiniMax-M1

- API 호출::

- 공식 웹사이트 방문하기:访问 MiniMax 공식 웹사이트,注册并登录账号。

- API 키 가져오기:在个人中心或开发者页面中申请 API 密钥。

- 使用 API:根据官方提供的 API 文档,基于 HTTP 请求调用模型。例如,用 Python 的 requests 库发送请求:

import requests

url = "https://api.minimax.cn/v1/chat/completions"

headers = {

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

}

data = {

"model": "MiniMax-M1",

"messages": [

{"role": "user", "content": "请生成一段关于人工智能的介绍。"}

]

}

response = requests.post(url, headers=headers, json=data)

print(response.json())- Hugging Face 使用::

- 安装 Hugging Face 库:确保已安装 transformers 和 torch 等依赖库。

pip install transformers torch- 모델 로드:从 Hugging Face Hub 加载 MiniMax-M1 模型。

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "MiniMaxAI/MiniMax-M1"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

input_text = "请生成一段关于人工智能的介绍。"

inputs = tokenizer(input_text, return_tensors="pt")

output = model.generate(**inputs, max_length=100)

print(tokenizer.decode(output[0], skip_special_tokens=True))- MiniMax APP 或 Web 端使用::

- 访问 Web 端:登录 MiniMax Web 端,在页面上输入问题或任务,模型直接生成回答。

- 下载 APP:在手机上下载 MiniMax APP,用类似的操作进行交互。

MiniMax-M1的产品定价

- API 调用推理成本定价::

- 0-32k 输入长度::

- 输入成本:0.8元/百万 token。

- 输出成本:8元/百万 token。

- 32k-128k 输入长度::

- 输入成本:1.2元/百万 token。

- 输出成本:16元/百万 token。

- 128k-1M 输入长度::

- 输入成本:2.4元/百万 token。

- 输出成本:24元/百万 token。

- 0-32k 输入长度::

- APP 和 Web 端::

- 무료 사용:MiniMax APP 和 Web 端提供不限量免费使用,适合普通用户和非技术背景的用户。

MiniMax-M1的核心优势

- 긴 컨텍스트 처리 기능:支持长达100万token的输入和8万token的输出,适合处理长文档和复杂推理任务。

- 高效推理性能:提供40K和80K两种推理预算版本,结合闪电注意力机制,优化计算资源,降低推理成本。

- 多领域任务优化:在软件工程、长上下文理解、数学推理和工具使用等任务中表现出色,适应多样化应用场景。

- 先进技术架构:基于混合专家架构(MoE)和大规模强化学习(RL)训练,提升计算效率和模型性能。

- 高性价比:性能接近国际领先模型,同时提供灵活的定价策略,APP和Web端免费使用,降低使用门槛。

MiniMax-M1的适用人群

- 개발자:软件开发者高效生成代码、优化代码结构、调试程序或自动生成代码文档。

- 研究人员和学者:处理长篇学术论文、进行文献综述或复杂数据分析,用模型快速整理思路、生成报告和总结研究成果。

- 콘텐츠 크리에이터:需要创作长篇内容的人,用MiniMax-M1协助生成创意、撰写故事大纲、润色文本或生成长篇小说等。

- 학생:为提供清晰的解题思路和写作支持。

- 비즈니스 사용자:企业将其集成到自动化解决方案中,例如智能客服、数据分析工具或业务流程自动化。

© 저작권 정책

이 글은 저작권이 있으며 무단으로 복제해서는 안 됩니다.

관련 게시물

댓글 없음...