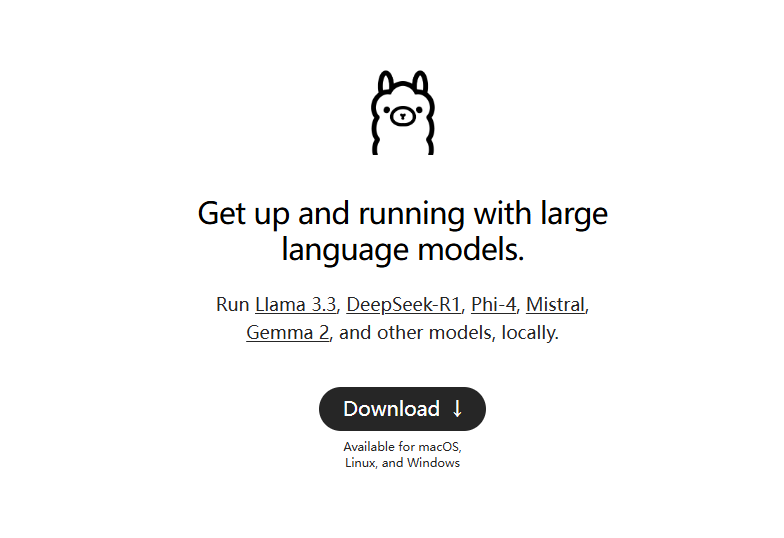

Ollama: 오픈 소스 빅 언어 모델의 원클릭 네이티브 배포

올라마 일반 소개

ollama는 모국어 모델을 실행하기 위한 경량 프레임워크로, 사용자가 대규모 언어 모델을 쉽게 구축하고 실행할 수 있습니다. 여러 가지 빠른 시작 및 설치 옵션을 제공하고, Docker를 지원하며, 사용자가 선택할 수 있는 다양한 라이브러리 세트를 포함하고 있습니다. 사용하기 쉽고 REST API를 제공하며 커뮤니티와 통합되는 다양한 플러그인 및 확장 기능을 제공합니다.

ollama는 개인용 컴퓨터용 순수 명령줄 도구로, 다음과 같은 로컬 채팅 인터페이스를 배포하는 데 권장됩니다: Open WebUI, Lobe Chat, NextChat.

기본 설치 디렉터리 수정: https://github.com/ollama/ollama/issues/2859

올라마 기능 목록

대규모 언어 모델을 빠르게 설정하고 실행하기

macOS, Windows, Linux 시스템 지원

ollama-python, ollama-js 등의 라이브러리를 제공합니다.

라마 2 포함. 미스트랄, Gemma 등 사전 구축된 모델

로컬 및 Docker 설치 모두 지원

맞춤형 모델 기능 제공

GGUF 및 PyTorch에서 모델 변환 지원

CLI 작동 가이드 제공

REST API 지원 제공

일반적으로 사용되는 올라마 명령어

풀 모델: 올라마 풀 라마3.1

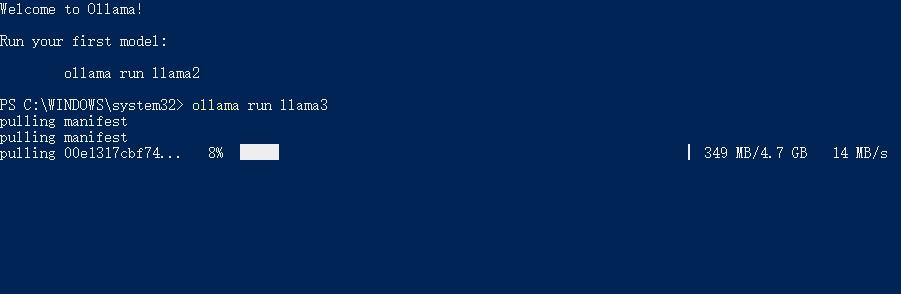

실행 모델: 라마 런 라마3.1

모델 삭제: llama rm llama3.1

사용 가능한 모든 모델 목록: 올라마 목록

쿼리 API 서비스 주소: ollama serve(기본값 http://localhost:11434/)

올라마 도움말

설치 스크립트 및 가이드는 ollama 웹사이트 및 GitHub 페이지에서 제공됩니다.

제공된 Docker 이미지를 사용하여 설치

CLI 작업을 통한 모델 생성, 풀링, 제거 및 복사

로컬 빌드 초기화 및 실행

모델을 실행하고 모델과 상호 작용

Ollama에서 지원하는 일부 모델

| 모델 | 매개변수 | 크기 | 다운로드 |

|---|---|---|---|

| 라마 2 | 7B | 3.8GB | ollama run llama2 |

| 미스트랄 | 7B | 4.1GB | ollama run mistral |

| 돌핀 파이 | 2.7B | 1.6GB | ollama run dolphin-phi |

| Phi-2 | 2.7B | 1.7GB | ollama run phi |

| 뉴럴 채팅 | 7B | 4.1GB | ollama run neural-chat |

| 스탈링 | 7B | 4.1GB | ollama run starling-lm |

| 코드 라마 | 7B | 3.8GB | ollama run codellama |

| 라마 2 무수정 | 7B | 3.8GB | ollama run llama2-uncensored |

| 라마 2 13B | 13B | 7.3GB | ollama run llama2:13b |

| 라마 2 70B | 70B | 39GB | ollama run llama2:70b |

| Orca Mini | 3B | 1.9GB | ollama run orca-mini |

| 비쿠나 | 7B | 3.8GB | ollama run vicuna |

| LLaVA | 7B | 4.5GB | ollama run llava |

| Gemma | 2B | 1.4GB | ollama run gemma:2b |

| Gemma | 7B | 4.8GB | ollama run gemma:7b |

올라마 다운로드

© 저작권 정책

이 글은 저작권이 있으며 무단으로 복제해서는 안 됩니다.

관련 문서

댓글 없음...