RLAMA: 명령줄에서 작동하는 로컬 문서의 지능형 퀴즈를 위한 RAG 시스템

일반 소개

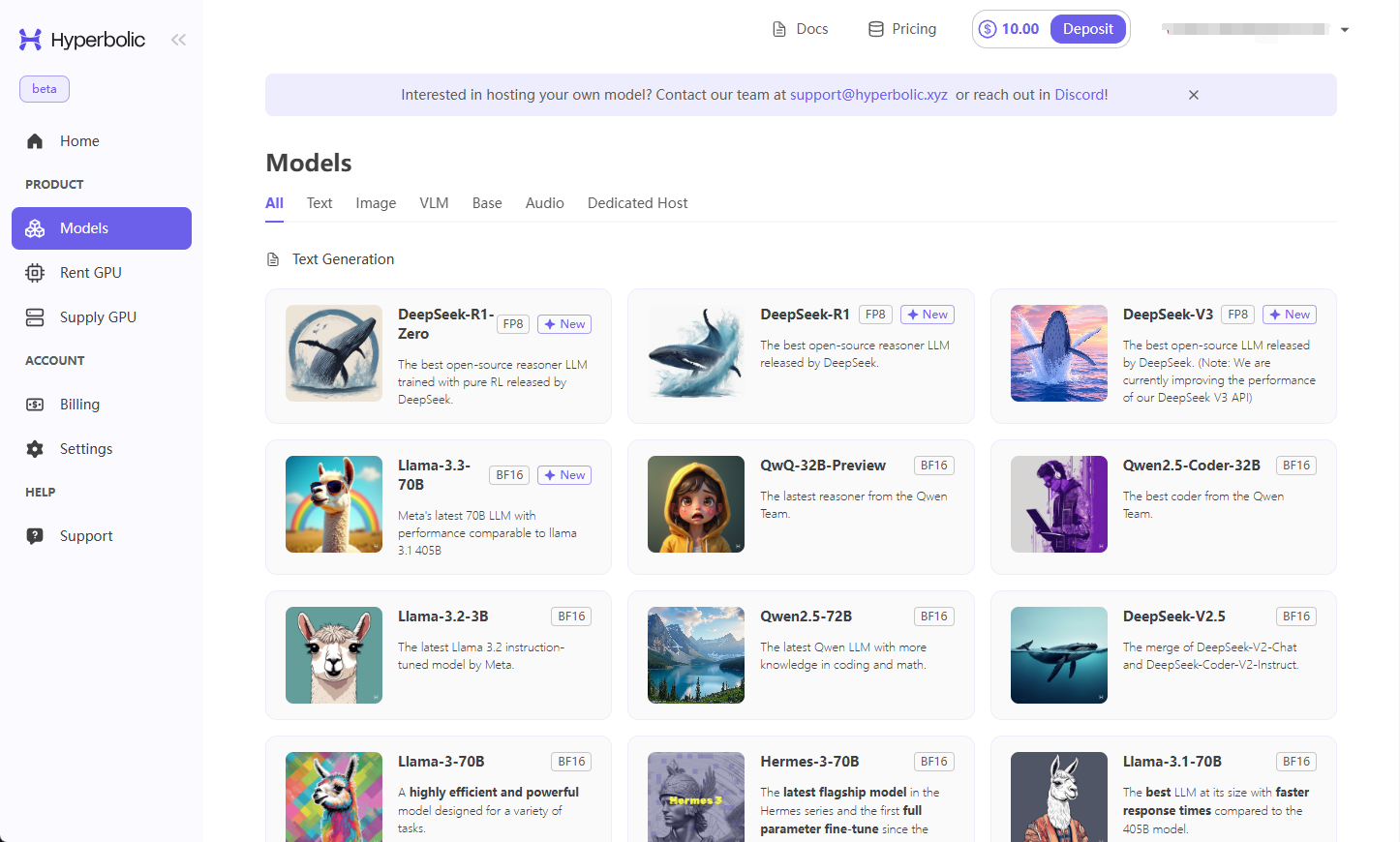

RLAMA는 DonTizi에서 개발하여 GitHub에서 호스팅하는 문서 인텔리전스를 위한 RAG(검색 증강 생성) 시스템으로, 명령줄 작업을 통한 기능이 핵심 기능입니다. 사용자는 로컬 Ollama 지능형 Q&A를 통해 폴더에 있는 문서를 대화형 지식 베이스로 빠르게 색인하는 모델입니다. 코드 파일, 기술 문서, 사무용 문서 등 어떤 종류의 문서든 RLAMA는 완벽하게 로컬에서 실행되므로 클라우드 서비스가 필요 없고 데이터 프라이버시를 보호할 수 있습니다. 다양한 파일 형식을 지원하고 설치가 간편한 RLAMA는 특히 명령줄 작업에 익숙한 개발자와 기술 애호가에게 현지화된 문서 관리를 위한 강력한 선택입니다.

기능 목록

- 명령줄에서 RAG 시스템 만들기명령을 사용하여 폴더 문서를 색인화하여 스마트 퀴즈의 지식창고를 생성하세요.

- 명령줄 상호 작용 Q&A터미널 세션을 사용하여 기존 RAG 시스템 내 문서의 내용입니다.

- RAG 시스템 관리명령을 사용하여 RAG 시스템을 나열하고 삭제하여 지식창고를 쉽게 유지 관리할 수 있습니다.

- 로컬 모델 통합현지 Ollama 모델에 원활하게 연결하여 완전한 현지화를 유지합니다.

- 버전 및 업데이트 관리명령을 사용하여 버전을 확인하거나 시스템을 최신 상태로 업데이트합니다.

- 멀티 포맷 지원텍스트, 코드, 오피스 문서 등 다양한 형식과 호환 가능.

- 명령줄 제거명령 정리 도구 및 데이터를 제공합니다.

도움말 사용

설치 프로세스

RLAMA는 macOS, Linux 및 Windows용 문서 인텔리전스 퀴즈를 명령줄로 구현한 것으로, macOS, Linux 및 Windows용으로 설치되며, 단계는 다음과 같습니다:

1. 전제 조건

- 올라마 설치Ollama 모델은 로컬에서 실행해야 합니다. Ollama 웹사이트를 방문하여 다운로드 및 설치한 후 실행하세요.

ollama run llama3(또는 다른 모델)을 클릭하여 사용 가능 여부, 기본 주소를 확인합니다.http://localhost:11434. - 네트워크 연결설치하려면 스크립트 또는 종속성을 다운로드하기 위해 인터넷 연결이 필요합니다.

- 선택적 종속성더 많은 형식(예: .pdf, .docx)을 지원하려면 다음을 실행하는 것이 좋습니다.

install_deps.sh설치 도구(예pdftotext).

2. 명령줄 스크립트를 통한 설치(권장)

터미널에 입력합니다:

curl -fsSL https://raw.githubusercontent.com/dontizi/rlama/main/install.sh | sh

- 스크립트가 자동으로 다운로드 및 구성을 완료하고 완료되면 다음을 실행합니다.

rlama --version버전 확인(예v0.1.0) 성공 확인.

3. 수동 소스 코드 설치(선택 사항)

사용자 지정이 필요한 경우:

- 복제 창고:

git clone https://github.com/DonTizi/rlama.git cd rlama - 컴파일 및 설치(Go 환경 필요):

go build go install - 실행 파일을 경로로 이동합니다(예

/usr/local/bin), 실행rlama --help유효성 검사.

4. 설치 확인

실행 중입니다:

rlama --help

명령 목록을 표시하면 성공한 것으로 간주합니다.

주요 기능

명령줄에서 RAG 시스템 만들기

문서를 스마트 퀴즈 지식창고로 변환합니다. 예를 들어 폴더 ./docs 통합 readme.md 노래로 응답 guide.pdf::

- Ollama 모델이 실행되는지 확인합니다(예

ollama run llama3). - 명령을 입력합니다:

rlama rag llama3 mydocs ./docsllama3: 모델 이름.mydocs: RAG 시스템 이름../docs문서 경로.

- 출력 예시:

Indexing documents in ./docs... Processed: readme.md Processed: guide.pdf RAG system "mydocs" created successfully!

명령줄을 통한 대화형 Q&A

기존 RAG 시스템에 대해 문의하세요:

- 세션을 시작합니다:

rlama run mydocs - 질문을 입력합니다:

如何安装 rlama? - 답변 받기:

可通过终端运行 `curl -fsSL https://raw.githubusercontent.com/dontizi/rlama/main/install.sh | sh` 安装。 - 가져오기

exit종료합니다.

RAG 시스템 관리

- 리스팅 시스템::

rlama list샘플 출력:

Available RAG systems: - mydocs - 시스템 삭제하기::

rlama delete mydocs를 클릭하거나 확인을 건너뛰세요:

rlama delete mydocs --force

버전 및 업데이트

- 버전 확인::

rlama --version어쩌면

rlama -v디스플레이는 다음과 같습니다.v0.1.0. - 시스템 업데이트하기::

rlama update(식물학) 코카(외래어)

--force필수 업데이트.

시스템 제거

- 제거 도구::

rlama uninstall - 데이터 정리데이터는

~/.rlama실행 중입니다:rm -rf ~/.rlama

주요 기능

1. 명령줄 작업

rlama의 모든 기능은 명령줄을 통해 구현되므로 간단하고 효율적입니다. 예를 들어, 명령줄 rlama rag mistral docs ./project 명령줄에 능숙한 사용자에게 적합한 전체 폴더를 즉시 색인화합니다.

2. 다중 형식 문서 지원

여러 파일 유형이 지원됩니다:

- 텍스트:

.txt및.md및.html및.json및.csv등 - Code:

.go및.py및.js및.java및.cpp등 - 문서화:

.pdf및.docx및.pptx및.xlsx등

움직여야 합니다../scripts/install_deps.sh향상된 지원. 예시:

rlama rag gemma code-docs ./src

3. 현지화된 운영

데이터는 전체적으로 로컬에서 처리되므로 클라우드가 필요 없어 민감한 문서에 적합합니다. 예를 들어, 회사 기밀 문서 색인화:

rlama rag llama3 contracts ./legal

팁 및 문제 해결

- 정밀 명령: 전체 매개 변수를 입력합니다(예

rlama run mydocs를 사용하여 정확성을 보장합니다. - 올라마 문제연결에 실패하면

http://localhost:11434실행 중ollama ps상태 보기. - 포맷 지원추출이 실패하면 다음을 실행합니다.

install_deps.sh종속성을 설치합니다. - 잘못된 답변문서가 색인되었는지 확인하고 문제에 대해 더 구체적으로 설명하세요.

- 이의 제기(도움 요청)이슈는 명령어 및 버전과 함께 GitHub 이슈에 제출할 수 있습니다.

위의 명령어를 통해 사용자는 rlama를 빠르게 마스터하고 로컬 문서를 관리하며 지능형 Q&A를 구현할 수 있습니다.

© 저작권 정책

이 글은 저작권이 있으며 무단으로 복제해서는 안 됩니다.

관련 문서

댓글 없음...