如果本地部署deepseek模型,最低硬件要求是什么?

DeepSeek模型本地部署硬件需求分析

- 核心硬件要素解析

模型部署的硬件需求主要取决于三个维度:

- 参数量级:7B/67B等不同规模模型对显存要求差异极大,最大的 DeepSeek R1 671B 本地部署教程:基于 Ollama 和动态量化

- 추론 모드:FP16/INT8量化可降低40-60%显存占用

- 사용 시나리오:对话式推理与批量推理的资源消耗差异可达5-10倍

2. 典型配置示例(以FP16精度为例)

对于不理解FP16的可以阅读:모델 정량화란 무엇인가: FP32, FP16, INT8, INT4 데이터 유형 설명,因此相对有很多更优化的版本,比如:로컬에서 DeepSeek-Coder V3/R1(Q4_K_M 정량화)을 실행하려면 14GB의 RAM만 필요합니다.

| 模型规模 | 最低显存需求 | 推荐显卡 | CPU替代方案 |

|---|---|---|---|

| 7B | 14GB | RTX3090 | 64GB DDR4 + AVX512指令集 |

| 20B | 40GB | A100-40G | 需分布式推理框架 |

| 67B | 134GB | 8×A100 | 不推荐纯CPU方案 |

💡 显存计算公式:参数量 × 2字节(FP16) × 1.2(安全系数)

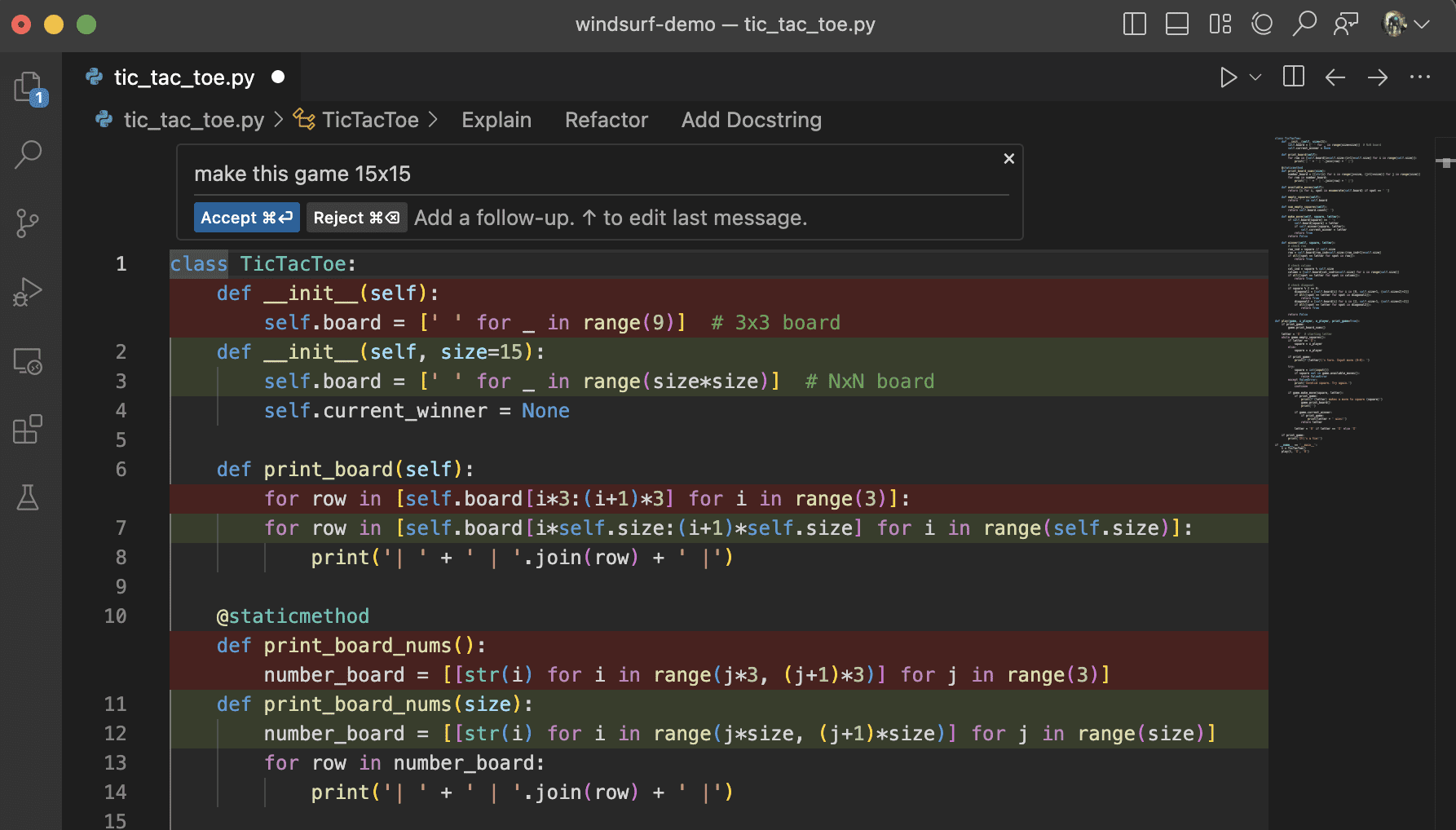

3. 关键优化技术

# 量化技术示例(伪代码)

model = load_model("deepseek-7b")

quantized_model = apply_quantization(model, precision='int8') # 显存降低40%

- 显存压缩技术::

- vLLM框架:通过PageAttention机制提升20%吞吐量

- FlashAttention-2:降低30%显存占用

- AWQ量化:保持97%精度的同时减少50%显存

4. 真实部署案例对比

| 项目 | RTX3060(12G) | RTX4090(24G) | A100(80G) |

|---|---|---|---|

| DeepSeek-7B | 需量化部署 | 原生支持 | 支持多实例 |

| 推理速度 | 8 tokens/s | 24 tokens/s | 50+ tokens/s |

| 最大上下文 | 2K 토큰 | 8K tokens | 32K tokens |

5. 存储与系统要求

- 磁盘空间::

- 基础模型:参数量 × 2(如7B需14GB)

- 完整部署包:建议预留50GB空间

- 운영 체제::

- Ubuntu 20.04+(推荐)

- Windows需WSL2支持

- 소프트웨어 종속성::

- CUDA 11.7+

- PyTorch 2.0+

推荐阅读

无需本地GPU即可私有化部署 DeepSeek-R1 32B

함정 피하기 가이드: 타오바오 딥시크릿 R1 설치 패키지 유료 상향 판매? 로컬 배포를 무료로 알려드립니다(원클릭 설치 프로그램 포함).

实践建议:对于个人开发者,RTX3090+64GB内存配置可满足7B模型流畅运行。企业级部署建议采用A100/H100集群,配合vLLM等优化框架实现高效推理。量化部署时需注意精度损失对业务的影响,建议进行严格的测试验证。

© 저작권 정책

이 글은 저작권이 있으며 무단으로 복제해서는 안 됩니다.

관련 문서

댓글 없음...