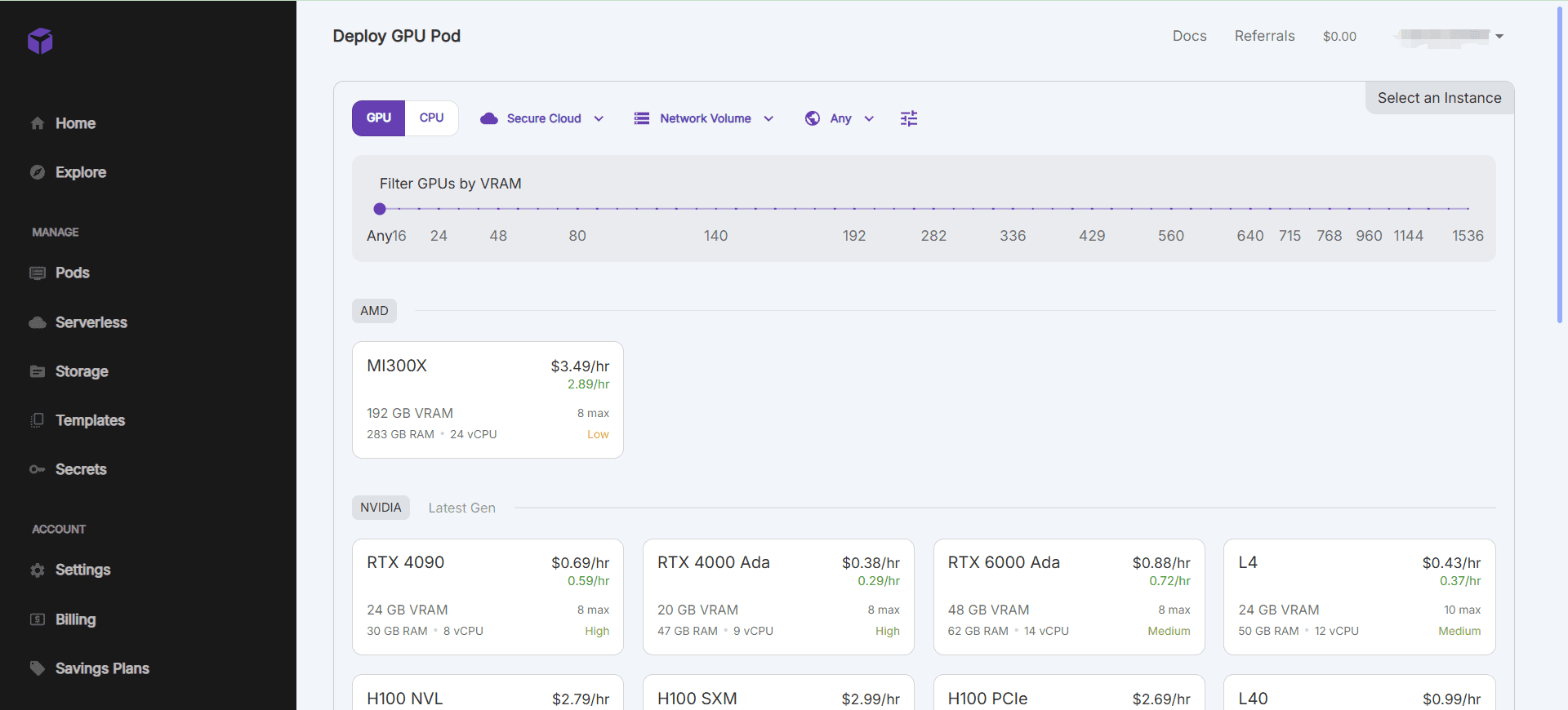

RunPod: 빠른 콜드 스타트 SD 및 초당 과금 기능을 갖춘 AI용으로 설계된 GPU 클라우드 서비스

일반 소개

RunPod는 개발자, 연구자, 기업에게 AI 모델 개발, 훈련, 확장을 위한 원스톱 솔루션을 제공하는 것을 목표로 AI를 위해 특별히 설계된 클라우드 컴퓨팅 플랫폼입니다. 이 플랫폼은 온디맨드 GPU 리소스, 서버리스 추론, 자동 확장 등을 통합하여 AI 프로젝트의 모든 단계를 강력하게 지원하며, RunPod의 핵심 철학은 사용자가 인프라 문제에 대해 크게 걱정할 필요 없이 모델 혁신에 집중할 수 있도록 AI 개발 프로세스를 간소화하는 것입니다.

요청 시에만 지불하고 콜드 스타트 속도가 빨라 사용 빈도가 낮은 서비스에 적합하며 고품질 운영이 필요합니다. 한편, 대규모 언어 모델의 자연어 처리 클래스는 토큰당 지불을 지원합니다.

기능 목록

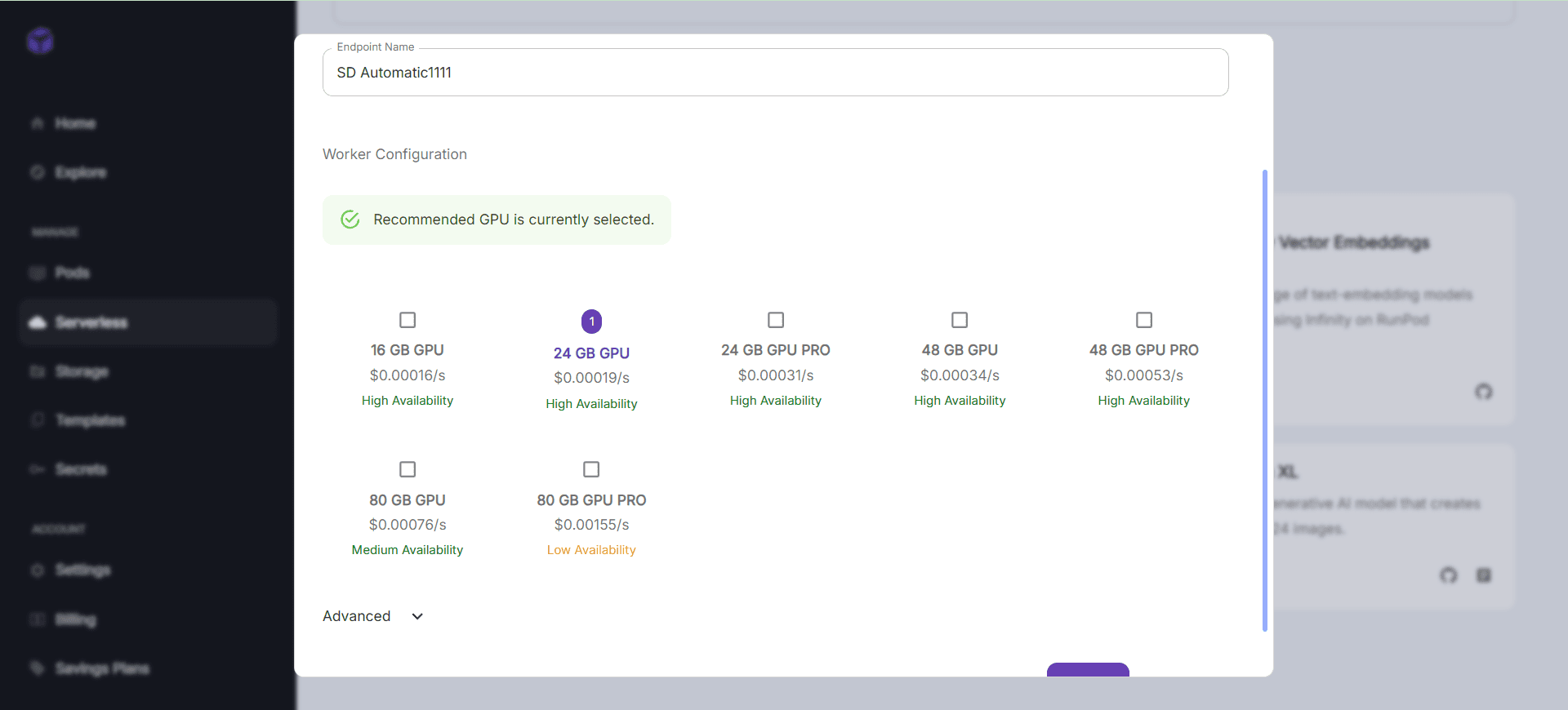

- 온디맨드 GPU 리소스GPU 인스턴스의 빠른 시작 및 다양한 연산 요구 사항을 충족하기 위한 여러 GPU 모델 지원.

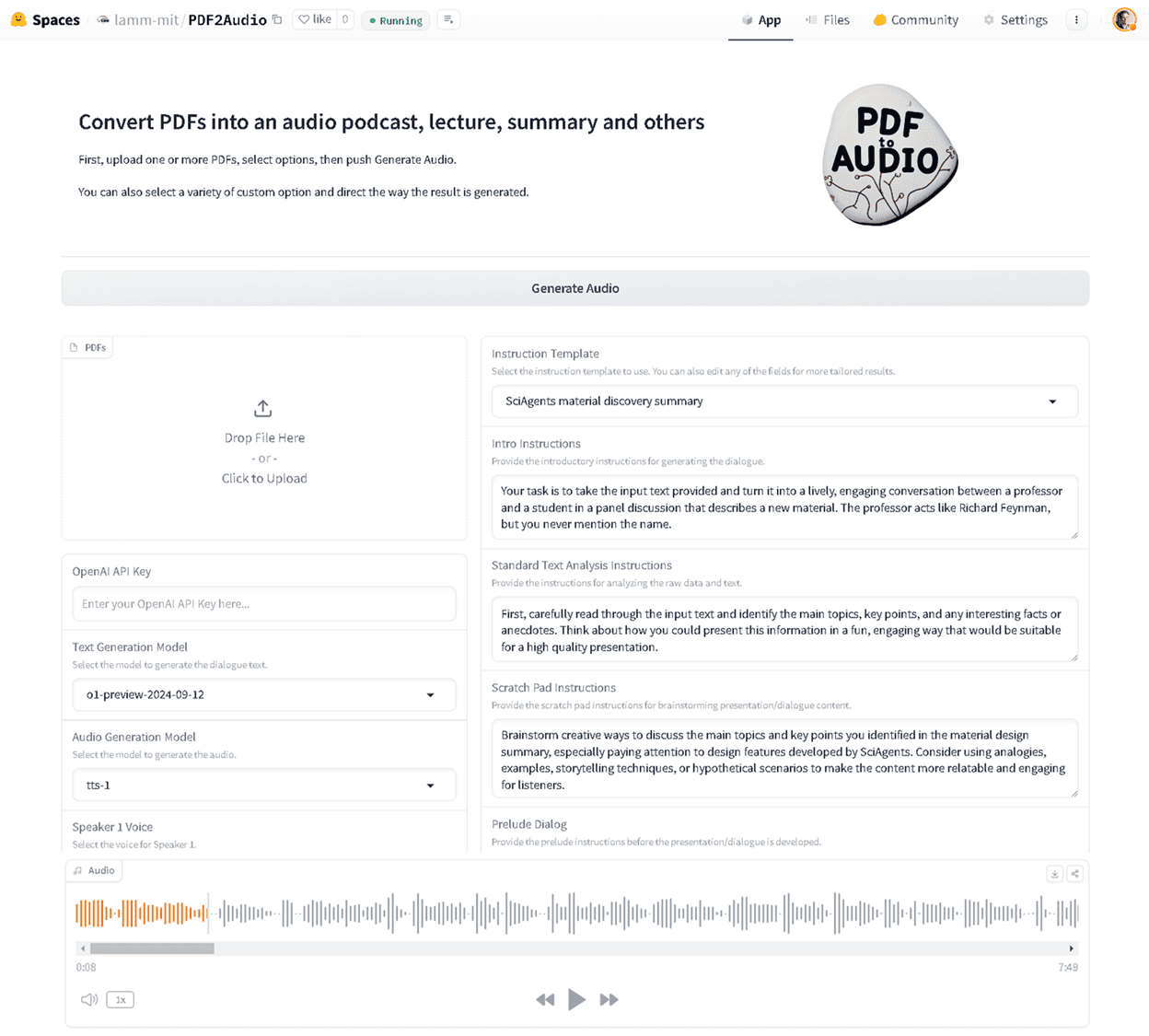

- 서버리스 추론추론 기능을 자동으로 확장하여 변화하는 워크로드를 효율적으로 처리합니다.

- 개발 환경 통합일반적으로 사용되는 딥 러닝 프레임워크 및 도구를 지원하는 사전 구성된 AI 개발 환경입니다.

- 데이터 관리 및 저장효율적인 데이터 전송 및 액세스 메커니즘을 갖춘 통합 데이터 스토리지 솔루션입니다.

- 협업 및 버전 관리팀 공동 개발을 지원하고 모델 버전 관리 기능을 제공합니다.

도움말 사용

설치 및 사용

- GPU 인스턴스 생성::

- 로그인한 후 콘솔 페이지로 이동하여 "파드 만들기"를 클릭합니다.

- 원하는 GPU 모델과 구성을 선택하고 "생성"을 클릭하여 인스턴스를 시작합니다.

- 인스턴스가 시작되면 SSH 또는 웹 터미널 연결을 통해 작동할 수 있습니다.

- 사전 구성된 환경 사용::

- RunPod는 PyTorch, TensorFlow 등과 같이 사전 구성된 다양한 AI 개발 환경을 제공합니다.

- 인스턴스를 생성할 때 원하는 환경 템플릿을 선택하고 빠르게 프로젝트 개발을 시작할 수 있습니다.

- 데이터 관리::

- RunPod는 콘솔에서 데이터 세트를 관리할 수 있는 통합 데이터 스토리지 솔루션을 제공합니다.

- 데이터 보안 및 개인정보 보호를 위해 데이터 업로드, 다운로드 및 공유를 지원합니다.

- 협업 및 버전 관리::

- 협업 팀 개발을 지원하며, 팀원들을 초대하여 함께 프로젝트를 진행할 수 있습니다.

- 다양한 버전의 모델을 쉽게 추적하고 관리할 수 있는 모델 버전 관리 기능을 제공합니다.

- 서버리스 추론::

- 런팟은 서버리스 아키텍처를 지원하며 추론 기능을 자동으로 확장합니다.

- 콘솔에서 API 엔드포인트를 구성하여 모델에 대한 온라인 추론 서비스를 활성화할 수 있습니다.

워크플로

- 빠른 시작 GPU 예제::

- 콘솔에 로그인하고 "파드 생성"을 선택합니다.

- 원하는 GPU 모델과 구성을 선택하고 "생성"을 클릭합니다.

- 인스턴스가 시작되면 SSH 또는 웹 터미널 연결을 통해 작동합니다.

- 사전 구성된 환경 사용::

- 인스턴스를 만들 때 원하는 환경 템플릿을 선택합니다.

- 인스턴스를 연결한 후에는 미리 구성된 개발 환경을 프로젝트 개발에 바로 사용할 수 있습니다.

- 데이터 관리::

- 콘솔에서 데이터 집합을 관리하여 데이터 업로드, 다운로드 및 공유를 지원합니다.

- 데이터 보안 및 개인정보 보호를 보장합니다.

- 협업 및 버전 관리::

- 팀원을 초대하여 프로젝트에서 함께 작업하고 버전 관리 기능을 사용하여 모델 버전을 추적하고 관리하세요.

- 서버리스 추론::

- 콘솔에서 API 엔드포인트를 구성하여 모델에 대한 온라인 추론 서비스를 사용하도록 설정합니다.

- 추론 기능을 자동으로 확장하여 변화하는 워크로드를 효율적으로 처리하세요.

© 저작권 정책

이 글은 저작권이 있으며 무단으로 복제해서는 안 됩니다.

관련 문서

댓글 없음...