XDOllama: MacOS에서 Ollama\Dify\Xinference를 빠르게 호출할 수 있는 AI 모델 인터페이스입니다.

일반 소개

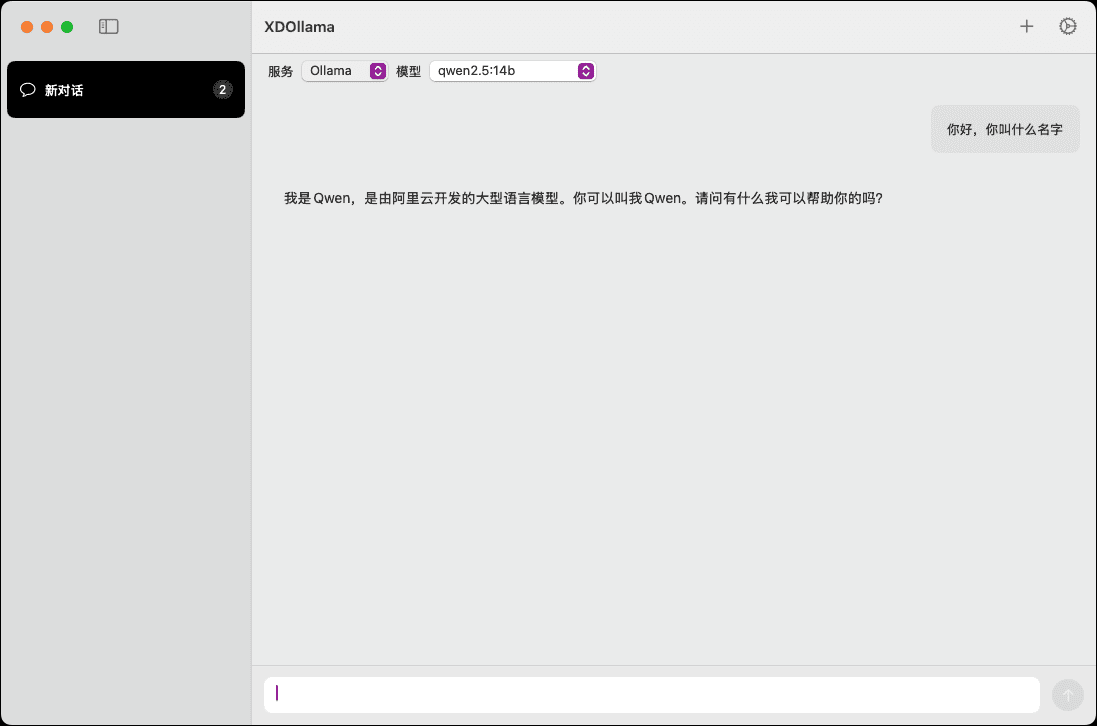

XDOllama 是一款专为 MacOS 用户设计的桌面应用程序,旨在快速调用 Ollama、Dify 和 Xinference 等 AI 模型。该应用程序通过简化的界面和操作流程,使用户能够轻松调用本地或在线的 AI 模型,提升工作效率和使用体验。

기능 목록

- 调用本地 Ollama 모델링

- 调用在线 Ollama 模型

- 调用本地 Xinference 模型

- 调用在线 Xinference 模型

- 调用本地 Dify 어플라이언스

- 调用在线 Dify 应用

- 支持多种 AI 框架

- 简单易用的界面设计

- 高效的模型调用速度

도움말 사용

설치 프로세스

- 下载 DMG 文件。

- 双击打开下载的 DMG 文件。

- 将 XDOllama.app 拖入应用程序文件夹。

- 安装完成后,打开应用程序即可使用。

사용 가이드라인

- 打开 XDOllama 应用程序。

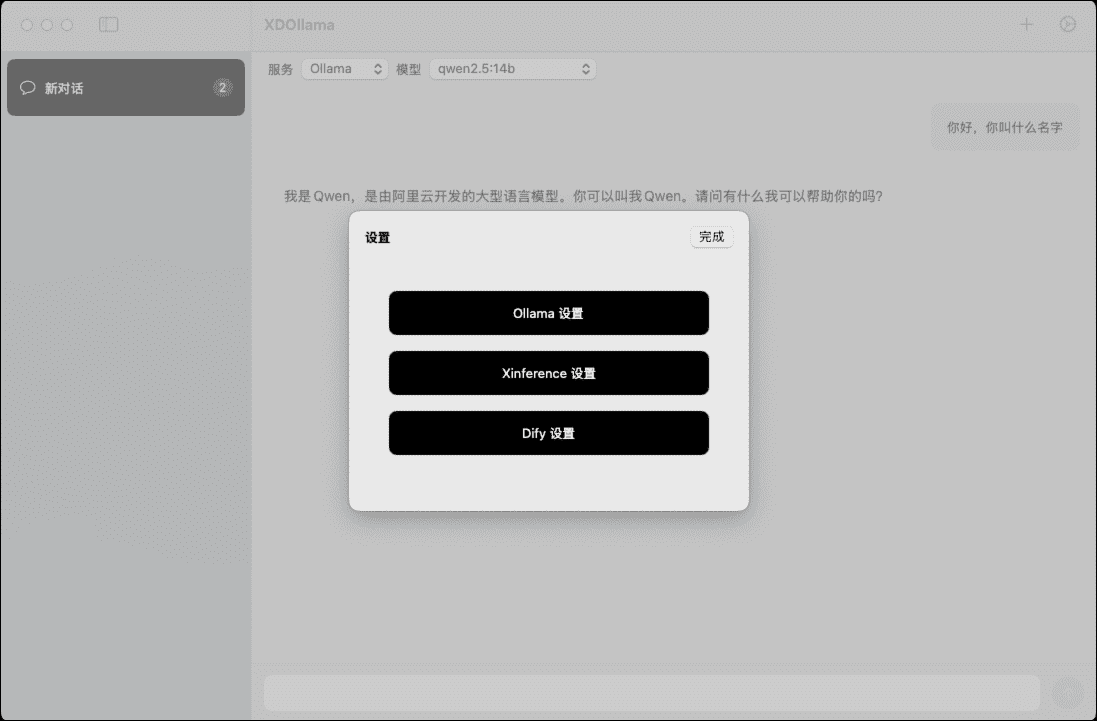

- 选择要调用的 AI 模型(Ollama、Dify 或 Xinference)。

- 选择调用方式(本地或在线)。

- 根据提示输入相关参数和设置。

- 点击“调用”按钮,等待模型加载和运行。

- 查看和使用模型输出结果。

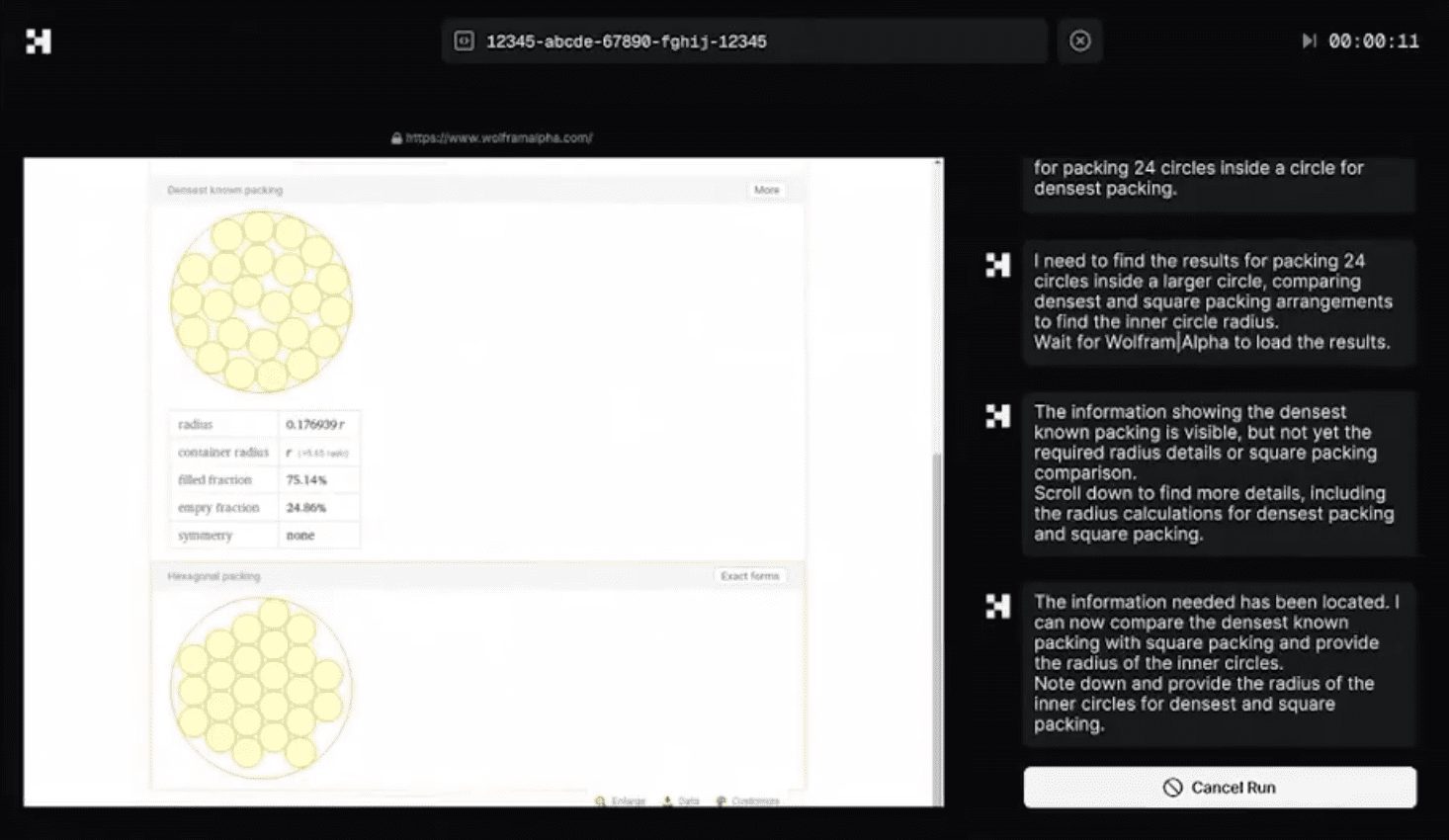

세부 기능 작동 흐름

调用本地 Ollama 模型

- 在主界面选择“Ollama”。

- 选择“本地”调用方式。

- 输入模型路径和参数。

- 点击“调用”按钮,等待模型加载。

- 查看模型输出结果。

调用在线 Ollama 模型

- 在主界面选择“Ollama”。

- 选择“在线”调用方式。

- 输入在线模型的 URL 和参数。

- 点击“调用”按钮,等待模型加载。

- 查看模型输出结果。

调用本地 Xinference 模型

- 在主界面选择“Xinference”。

- 选择“本地”调用方式。

- 输入模型路径和参数。

- 点击“调用”按钮,等待模型加载。

- 查看模型输出结果。

调用在线 Xinference 模型

- 在主界面选择“Xinference”。

- 选择“在线”调用方式。

- 输入在线模型的 URL 和参数。

- 点击“调用”按钮,等待模型加载。

- 查看模型输出结果。

调用本地 Dify 应用

- 在主界面选择“Dify”。

- 选择“本地”调用方式。

- 输入应用路径和参数。

- 点击“调用”按钮,等待应用加载。

- 查看应用输出结果。

调用在线 Dify 应用

- 在主界面选择“Dify”。

- 选择“在线”调用方式。

- 输入在线应用的 URL 和参数。

- 点击“调用”按钮,等待应用加载。

- 查看应用输出结果。

© 저작권 정책

이 글은 저작권이 있으며 무단으로 복제해서는 안 됩니다.

관련 문서

댓글 없음...