Xorbits Inference:一键部署多种AI模型,分布式推理框架

일반 소개

Xorbits Inference(Xinference)是一个功能强大且全面的分布式推理框架,支持大语言模型(LLM)、语音识别模型和多模态模型等多种AI模型的推理。通过Xorbits Inference,用户可以轻松地一键部署自己的模型或使用内置的前沿开源模型,无论是在云端、本地服务器还是个人电脑上运行。

기능 목록

- 支持多种AI模型的推理,包括大语言模型、语音识别模型和多模态模型

- 一键部署和服务模型,简化实验和生产环境的设置

- 支持在云端、本地服务器和个人电脑上运行

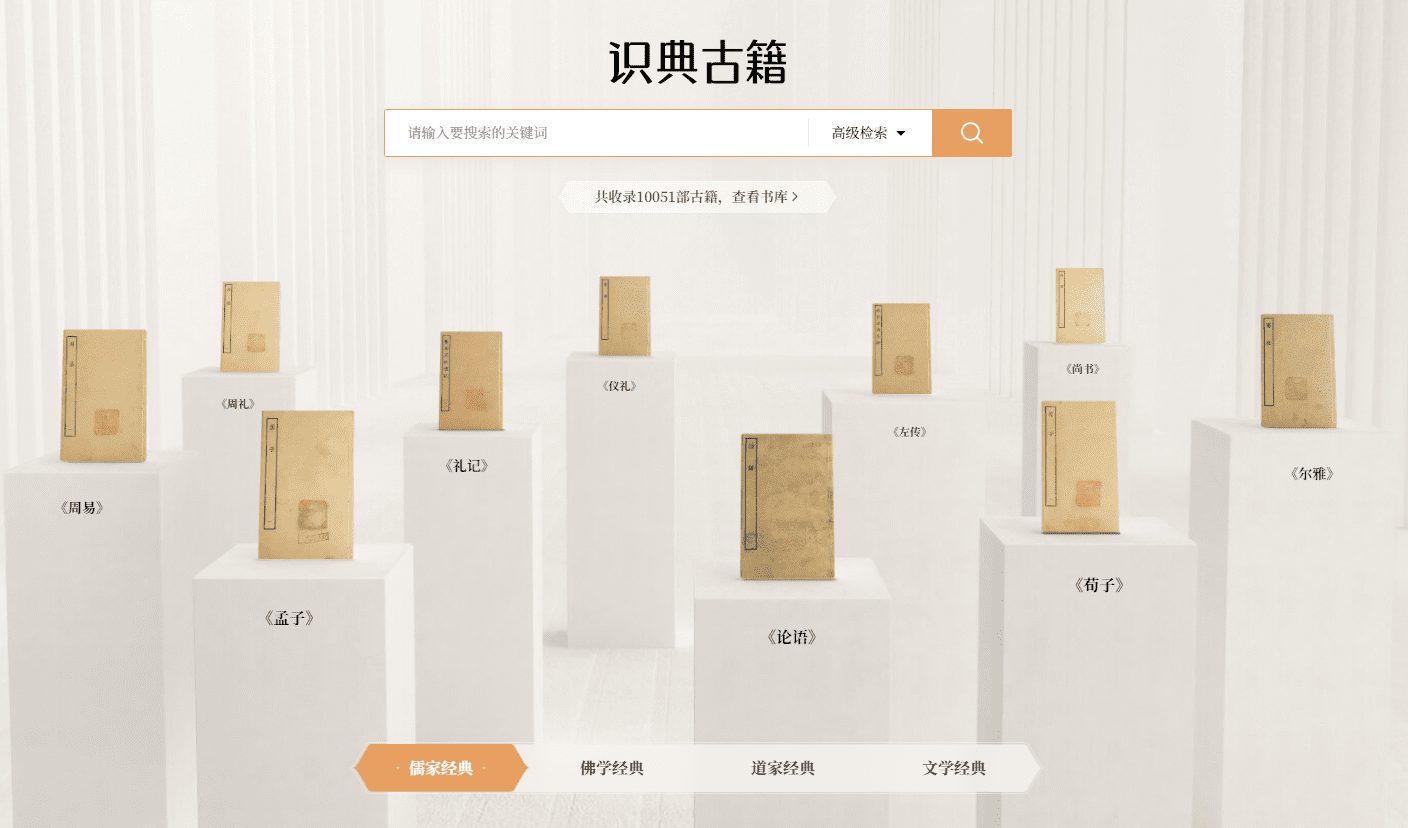

- 内置多种前沿开源模型,方便用户直接使用

- 提供丰富的文档和社区支持

도움말 사용

설치 프로세스

- 환경 준비:确保已安装Python 3.7或以上版本。

- 安装Xorbits Inference::

pip install xorbits-inference - 구성 환경:根据需要配置环境变量和依赖项。

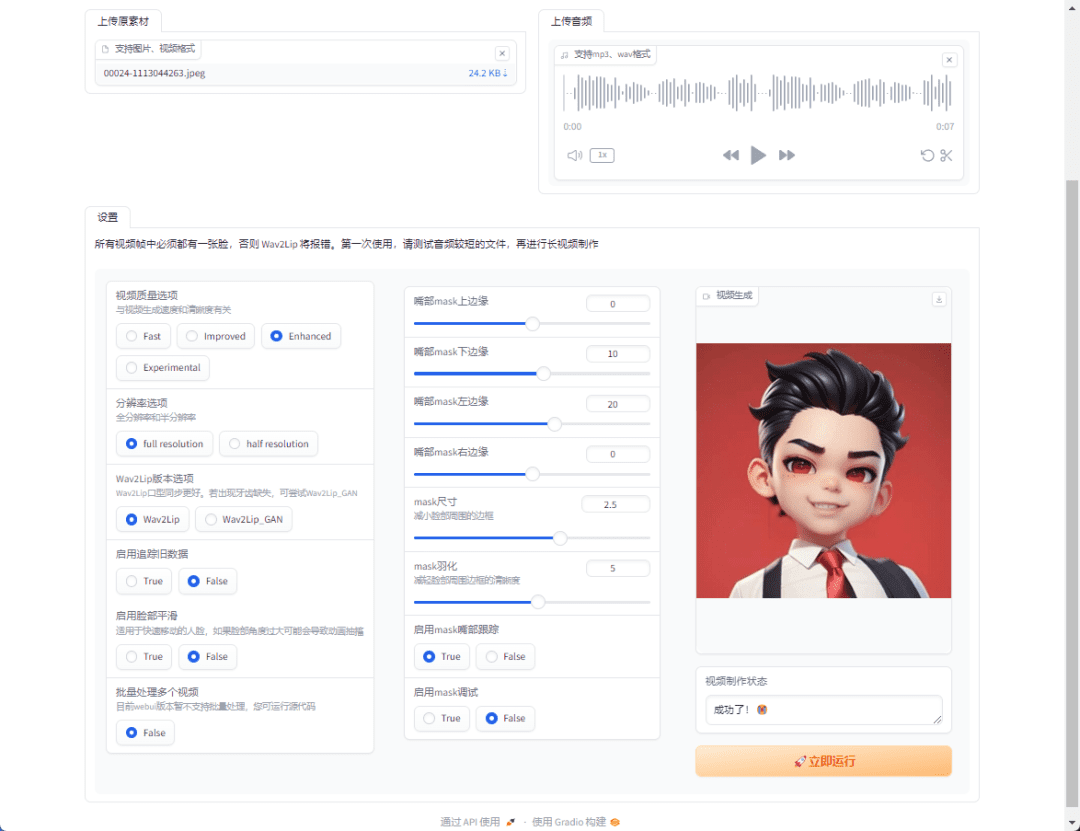

사용 프로세스

- 모델 로드::

from xinference import InferenceEngine engine = InferenceEngine(model_name="gpt-3") - 运行推理::

result = engine.infer("你好,世界!") print(result) - 部署模型::

xinference deploy --model gpt-3 --host 0.0.0.0 --port 8080

세부 기능 작동

- 모델 선택:用户可以选择内置的多种前沿开源模型,如GPT-3、BERT等,或上传自己的模型进行推理。

- 参数配置:在部署模型时,可以根据需求配置模型的参数,如批处理大小、GPU使用等。

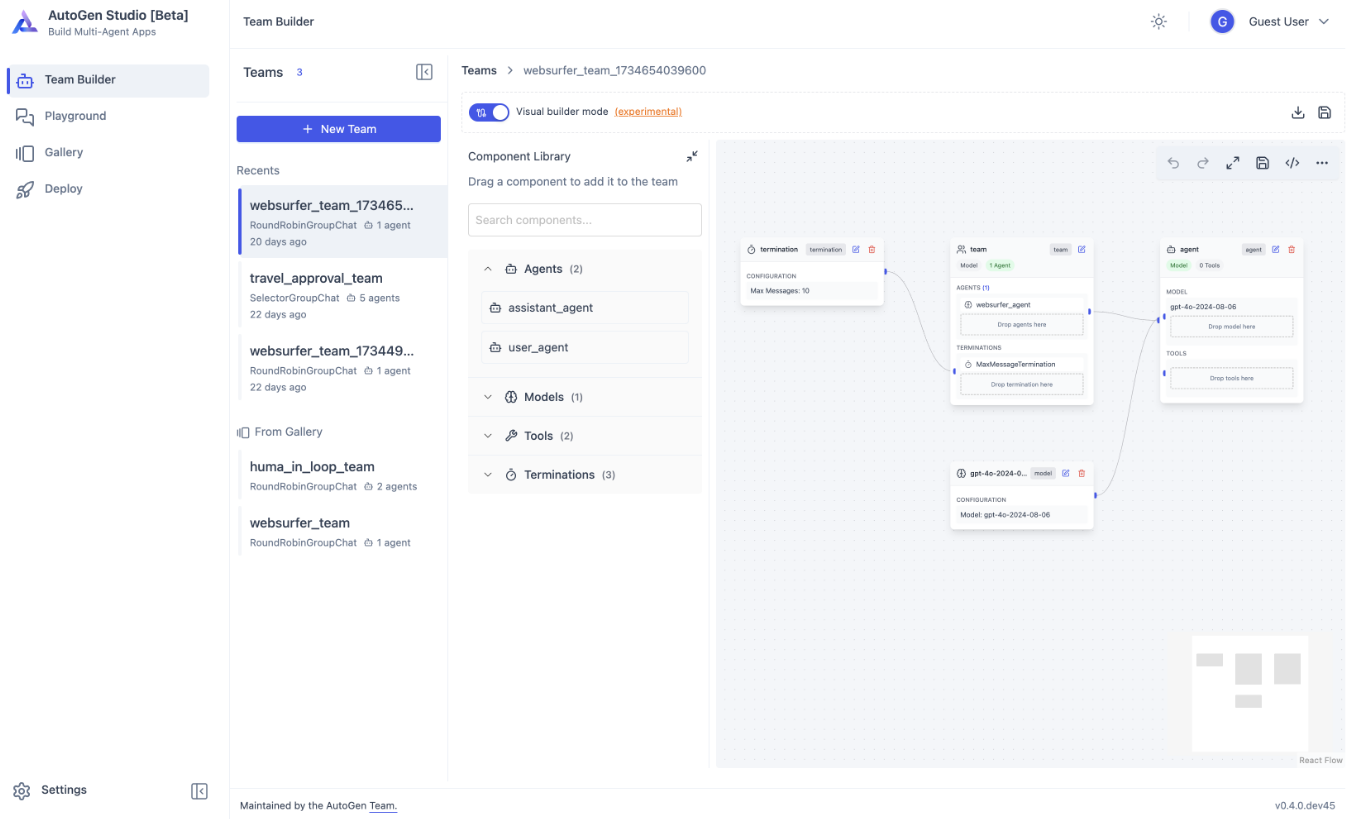

- 监控与管理:通过提供的管理界面,用户可以实时监控模型的运行状态和性能指标,方便进行优化和调整。

- 커뮤니티 지원:加入Xorbits Inference的Slack社区,与其他用户交流经验和问题,获取及时的帮助和支持。

© 저작권 정책

이 글은 저작권이 있으며 무단으로 복제해서는 안 됩니다.

관련 문서

댓글 없음...