Benchmarking multimodal de IA generativa entre dispositivos com Nexa Compressed Inference

Resumo executivo

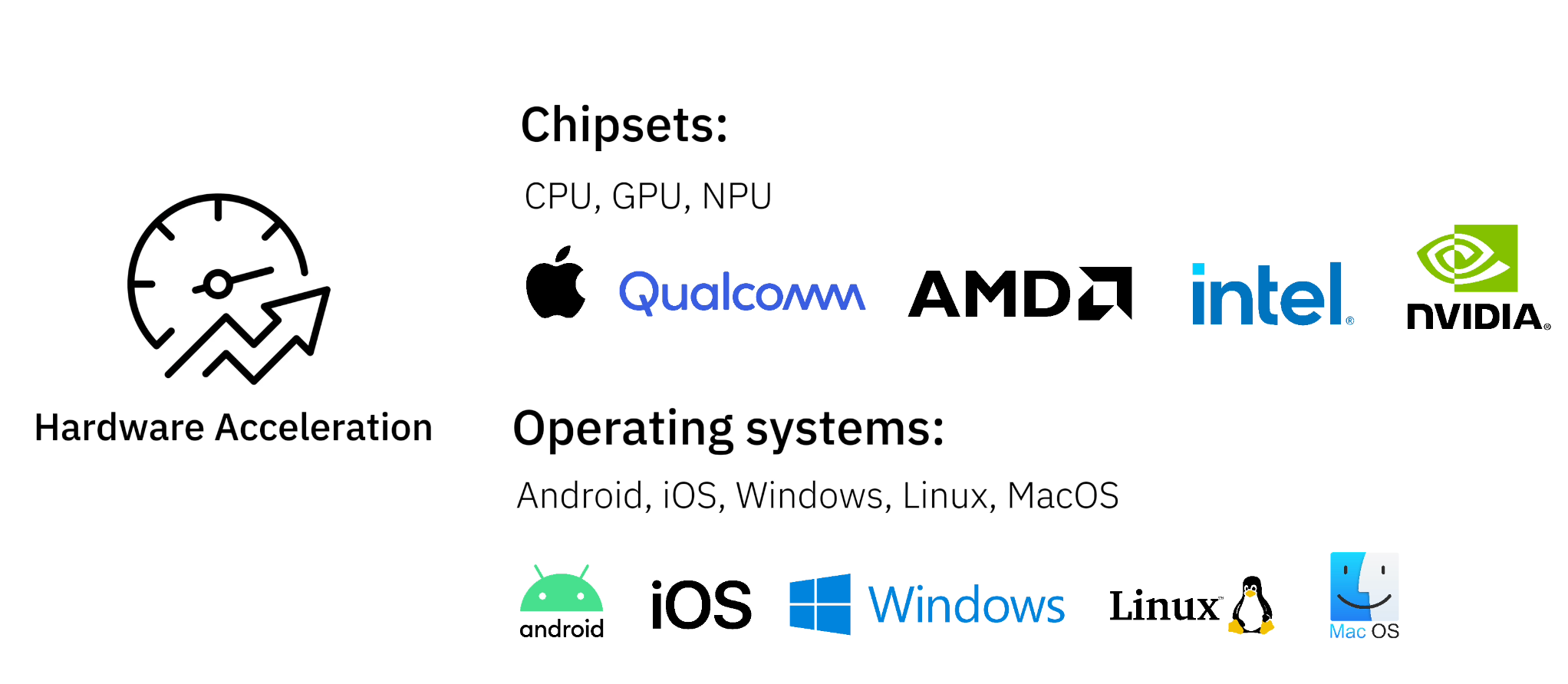

Nexa O Native Inference Framework torna a implantação de modelos de IA generativa no lado do dispositivo perfeita e eficiente. A tecnologia é compatível com uma ampla gama de chipsets, incluindo AMD, Qualcomm, Intel, NVIDIA e chips desenvolvidos internamente, e é compatível com todos os principais sistemas operacionais. Fornecemos dados de benchmark para modelos de IA generativa em uma variedade de tarefas comuns, cada uma testada no nível de desempenho TOPS em diferentes tipos de dispositivos.

Principais pontos fortes:

- capacidade multimodal - apoioTexto, áudio, vídeo e recursos visuaisTarefas generativas do tipo IA

- Ampla gama de compatibilidade de hardware - Executa modelos de IA em PCs, laptops, dispositivos móveis e sistemas incorporados

- desempenho líder - Com nossa estrutura de inferência de ponta, NexaQuant, os modelos são executados 2,5 vezes mais rápido e têm requisitos de armazenamento e memória 4 vezes menores, mantendo a alta precisão

Por que IA no lado final?

A implantação de modelos de IA diretamente no dispositivo tem várias vantagens em relação à dependência de APIs na nuvem:

- Privacidade e segurança - A retenção de dados no lado do dispositivo garante a confidencialidade

- reduzir custos - Não há necessidade de pagar por um raciocínio caro baseado em nuvem

- Velocidade e resposta - Inferência de baixa latência sem depender da rede

- capacidade off-line - Os aplicativos de IA ainda podem ser usados em áreas de baixa conectividade

Com a tecnologia de inferência de borda da Nexa, os desenvolvedores podem executar com eficiência modelos de IA generativos em uma ampla variedade de dispositivos com consumo mínimo de recursos.

Novas tendências em aplicativos de IA multimodal

Nexa AI Suporte à implementação no lado finalIA multimodalpermitindo que os aplicativos manipulem e integrem vários tipos de dados:

- IA de texto - Chatbots, resumos de documentos, assistentes de programação

- IA de voz para voz - Tradução de voz em tempo real, assistente de voz com IA

- Visão de IA - Detecção de alvos, descrição de imagens, processamento de OCR de documentos

Isso é obtido por meio do uso deNexaQuantNossos modelos multimodais alcançam excelente compactação e aceleração, mantendo o melhor desempenho.

Benchmarks de desempenho de tarefas de IA generativa entre dispositivos

Fornecemos dados de benchmarking para modelos de IA generativa em uma variedade de tarefas comuns, cada uma testada no nível de desempenho TOPS em diferentes tipos de dispositivos. Se você tiver um dispositivo e um caso de uso específico, poderá consultar dispositivos com desempenho semelhante para estimar a capacidade de processamento:

Tarefas de IA generativa cobertas:

- Voz para voz

- Texto para texto

- Visual para texto

Abrange o tipo de equipamento:

- Chips para notebooks modernos - Otimizado para processamento de IA nativo em desktops e laptops

- chip móvel carro-chefe - Modelos de IA executados em smartphones e tablets

- sistema incorporado (~4 TOPS) - Dispositivos de baixa potência para aplicativos de computação de borda

Avaliação comparativa de fala para fala

Avaliação dos recursos de interação de fala em tempo real com modelos de linguagem - ProcessamentoA entrada de áudio gera saída de áudio

| Tipo de equipamento | Chips e dispositivos | Atraso (TTFT) | velocidade de decodificação | Memória de pico média |

|---|---|---|---|---|

| Chips de notebooks modernos (GPU) | GPU Apple M3 Pro | 0,67 segundos | 20,46 tokens/segundo | ~990MB |

| Chips de notebook modernos (iGPU) | iGPU AMD Ryzen AI 9 HX 370 (Radeon 890M) | 1,01 segundos | 19,28 tokens/segundo | ~990MB |

| Chips de notebook modernos (CPU) | Intel Core Ultra 7 268V | 1,89 segundos | 11,88 tokens/segundo | ~990MB |

| CPU com chip móvel de ponta | Qualcomm Snapdragon 8 Gen 3 (Samsung S24) | 1,45 segundos | 9,13 token/segundo | ~990MB |

| CPU do sistema de IoT incorporado | Raspberry Pi 4 Modelo B | 6,9 segundos. | 4,5 tokens/segundo | ~990MB |

Avaliação comparativa de fala para fala usando Moshi com NexaQuant

Avaliação comparativa de texto para texto

avaliaçãoGerar texto com base na entrada de textoDesempenho do modelo de IA

| Tipo de equipamento | Chips e dispositivos | Atraso inicial (TTFT) | velocidade de decodificação | Memória de pico média |

|---|---|---|---|---|

| Chips de notebooks modernos (GPU) | GPU Apple M3 Pro | 0,12 segundos | 49,01 token/segundo | ~2580MB |

| Chips de notebook modernos (iGPU) | iGPU AMD Ryzen AI 9 HX 370 (Radeon 890M) | 0,19 segundos | 30,54 tokens/segundo | ~2580MB |

| Chips de notebook modernos (CPU) | Intel Core Ultra 7 268V | 0,63 segundos | 14,35 tokens/segundo | ~2580MB |

| CPU com chip móvel de ponta | Qualcomm Snapdragon 8 Gen 3 (Samsung S24) | 0,27 segundos | 10,89 tokens/segundo | ~2580MB |

| CPU do sistema de IoT incorporado | Raspberry Pi 4 Modelo B | 1,27 segundos | 5,31 tokens/segundo | ~2580MB |

Avaliação comparativa de texto para texto usando o llama-3.2 com o NexaQuant

Benchmarking de visual para texto

Avaliação da IA Analisar entradas visuaisA capacidade de gerar respostas, extrair informações visuais importantes e orientar a ferramenta de forma dinâmica.Entrada visual, saída de texto

| Tipo de equipamento | Chips e dispositivos | Atraso inicial (TTFT) | velocidade de decodificação | Memória de pico média |

|---|---|---|---|---|

| Chips de notebooks modernos (GPU) | GPU Apple M3 Pro | 2,62 segundos | 86,77 tokens/segundo | ~1093MB |

| Chips de notebook modernos (iGPU) | iGPU AMD Ryzen AI 9 HX 370 (Radeon 890M) | 2,14 segundos | 83,41 tokens/segundo | ~1093MB |

| Chips de notebook modernos (CPU) | Intel Core Ultra 7 268V | 9,43 segundos | 45,65 tokens/segundo | ~1093MB |

| CPU com chip móvel de ponta | Qualcomm Snapdragon 8 Gen 3 (Samsung S24) | 7,26 segundos. | 27,66 tokens/segundo | ~1093MB |

| CPU do sistema de IoT incorporado | Raspberry Pi 4 Modelo B | 22,32 segundos | 6,15 tokens/segundo | ~1093MB |

Avaliação comparativa de visual para texto usando OmniVLM com NexaQuant

© declaração de direitos autorais

O artigo é protegido por direitos autorais e não deve ser reproduzido sem permissão.

Artigos relacionados

Nenhum comentário...